張鈸直指人工智能行業當前問題:沒有理論只有模型算法

8月1日,中國科學院院士、清華大學人工智能研究院名譽院長張鈸在ISC.AI 2024第十二屆互聯網安全大會的演講上表示,當前人工智能還沒有理論,只有發展出來針對的模型和算法,它們都是針對特定領域的,軟件或硬件也都是專用的,市場很小,因此到現在為止還沒有發展出一個大型的人工智能產業,問題就出在這裏。

張鈸現年已經89歲高齡,過去幾十年里,他在清華大學培養了一批人工智能人才,是中國人工智能學科的奠基人之一。當前不少火熱的「清華系」大模型企業如生數科技、智譜AI、面壁智能、Kimi等,均受益於在清華打下的技術基礎,核心技術人才或直接或間接師承於張鈸。

本次演講,張鈸不僅指出了當前人工智能技術存在的缺陷和問題,也給出了未來改進的方向。

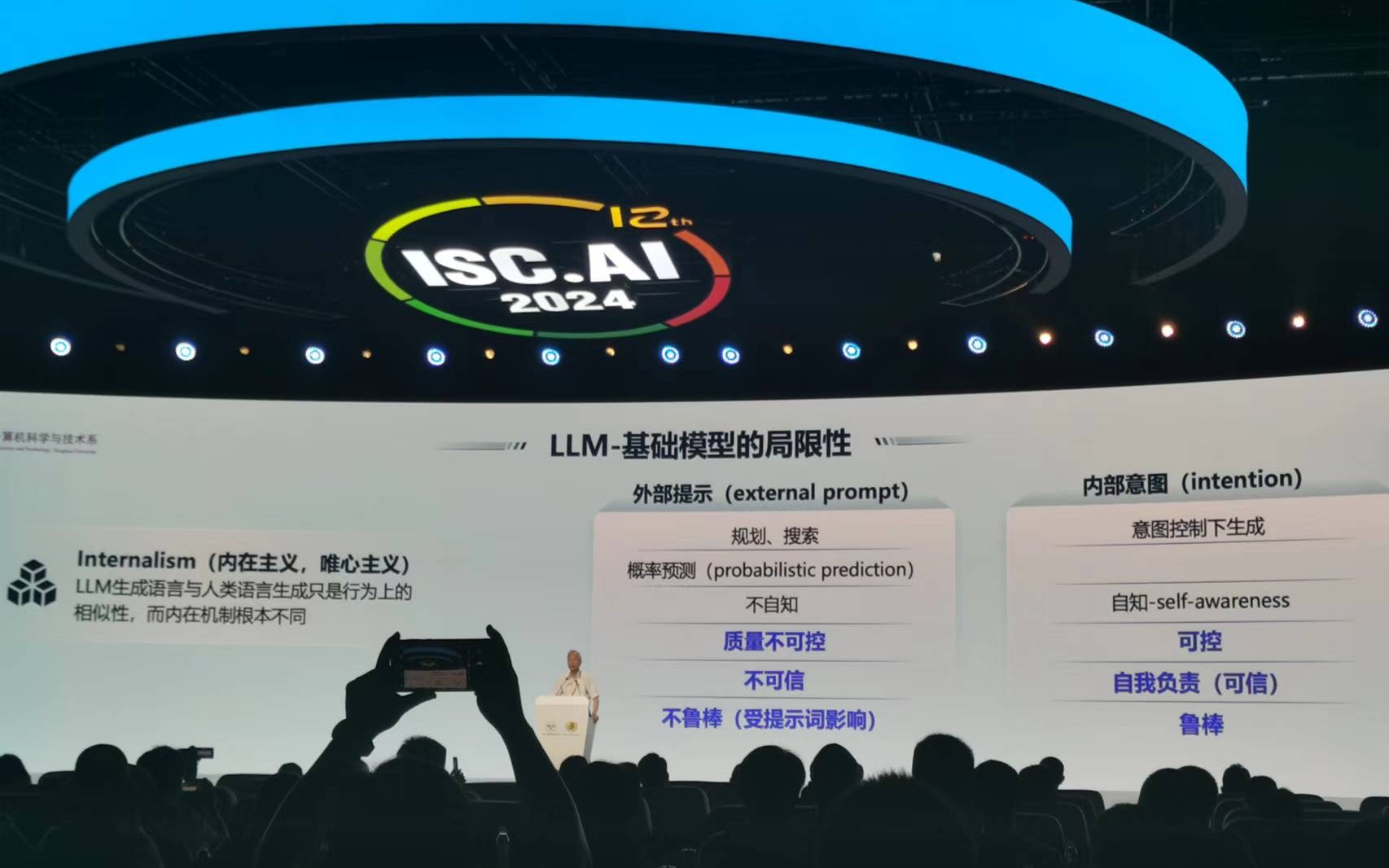

張鈸演講時現場觀眾拍攝其演講PPT 新京報貝殼財經記者羅亦丹/攝

張鈸演講時現場觀眾拍攝其演講PPT 新京報貝殼財經記者羅亦丹/攝當考慮基礎模型時,要考慮3大能力與1大缺陷

在張鈸看來,因為理論的限制,人工智能產業的前一階段必須要結合具體的應用領域來發展,因此這一階段發展出的人工智能屬於專用人工智能,即「弱」人工智能。不過,他也指出,目前基礎模型在語言問題上做到了通用,「我們考慮基礎模型的時候需要考慮3大能力與1大缺陷,這點是非常重要,是我們考慮今後產業發展的出發點。」

他解釋稱,大語言模型的強大之處體現在強大的語言生成能力、強大的人機自然交互能力和強大的舉一反三能力,「大語言模型的語言生成屬於開放領域,能夠生成多樣化的結果,所有輸出人類都可以理解,即便是‘胡說八道’我們也可以理解在胡說什麼,這一點非常重要。人類跟機器在開放領域進行自然語言對話,我們之前以為要通過幾代人的努力才能達到這個目標,但大家沒想到的是2020年這個目標已經達到了。」

張鈸表示,大模型的缺陷就是「幻覺」,「因為我們要求它有多樣性的輸出,必然它會產生錯誤。這個錯誤跟機器都會產生錯誤非常不一樣,機器產生的錯誤往往是我們可以控制的,這個錯誤是本身的錯誤,是一定會發生的,而且我們不可控,所以,這點也是我們後面考慮它應用需要考慮的問題。」

結合3大能力與1大缺陷,張鈸總結出了大模型當前適合應用的場景:對錯誤的容忍程度要高。他表示從產業情況來看,大模型的應用呈現「U」字形——前部的規劃、設計要求內容多樣性,後部的服務、推薦也要求多樣性,同時對錯誤的容忍程度較高,但中間部分就需要根據情況來考慮使用。

儘管存在問題,張鈸還是表示不論怎樣「模型是一定要用的」,「因為有了模型底座以後,應用的效率和質量一定會提高。過去的應用場景我們是在空的計算機上開發軟件提供服務,空的計算機相當於文盲,而現在有了大模型,平台至少是個高中生,開發效率一定會提高,以後的方向一定是這樣。」

張鈸重點分析了幻覺出現的根本原因,他認為模型的根本限制在於目前所有的機器所做的工作都是外部驅動,人類教它怎麼做,而不是自己主動做。同時,它生成的結果受提示詞的影響非常大,與人類是在內部意圖的控制下完成工作有明顯的區別。

大模型未來的4個發展方向:對齊、多模態、智能體、具身智能

張鈸介紹,未來大模型有4個發展方向,對如何改進大模型非常重要。

其一是與人類對齊,「大模型沒有判斷對錯的能力,自己不能自我更新,都是人類驅動下去更新的,不突破這一點,機器就不能自我進化。大模型需要外部的提示,所以在人類的驅動下改正大模型的錯誤是我們做的第一件工作。」

其二是多模態生成,「多模態生成將來對產業的發展非常重要,因為大家看到大模型主要是生成文本,但是我們用同樣的辦法生成圖像、聲音、影片、代碼之後,生成的水平是跟人類的水平接近的。我們現在為什麼圖像能生成的那麼好,主要是把圖像跟文本掛鉤。所以,最本質的是文本處理的突破。」

其三是AI Agent(智能體)的概念,「要把大模型和周圍的虛擬環境結合起來,讓環境提示它的錯誤,因為一件事做了之後才知道對和錯,因此智能體的概念非常重要,讓環境提示智能體,讓它有反思的機會,去改正錯誤。」

其四是具身智能,「通過加上機器人,讓大模型在物理世界也能夠工作。將來如何發展通用機器人?我認為要‘軟件通用,硬件多樣化’,馬斯克宣傳人形機器人,但我認為將來不止限於人形機器人。」

在張鈸看來,發展第三代人工智能,首先必須建立理論,大模型的存在沒有理論可以解釋,所以才會引起各種困惑和誤解,機器發展規模越來越大,理論不能解釋就會引起恐慌,得到安全、可控、可信、可靠、可擴展的人工智能技術,在這一領域沒有發展完善之前,人工智能始終是存在安全問題的。

新京報貝殼財經記者 羅亦丹

編輯 嶽彩周

校對 柳寶慶