OpenAI新模型達到博士水平?我找清北博士品鑒了一下。

說實話,有點受不了這些公司,老是半夜丟個大的了。。。

尤其點名 OpenAI ,這回又毫無預告地發佈了那個大家惦記了很久的新模型。

之前說什麼草莓不草莓的,一張草莓的照片遛了大家好幾天

結果,這回新模型根本跟草莓毛關係沒有,而是起了一個全新的名字Oepn AI o1 模型。

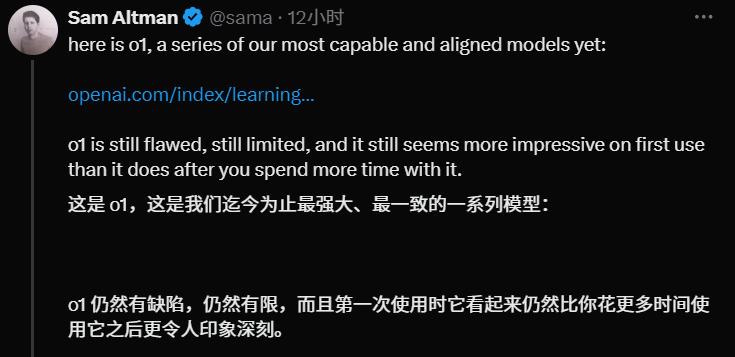

而且這玩意已經號稱 openAI 的天頂星科技,奧特曼直接發帖明說了,這就是他們到現在為止最強、最一致的模型。

跟往次不同的是,這玩意到底多牛 OpenAI 實際也沒多吹,但是輕飄飄甩出了幾張圖,就有點讓人頭皮微麻。

像下面的圖里,三個測試項目的結果就能說明了,分別是國際數學奧林匹克競賽、編程競賽還有博士級別的科學問題。

這裡面最左邊為 GPT-4o ,中間是目前已經開放了的預覽版 o1 ,最右邊高高的紅色柱子為滿血 o1 。你瞅瞅,基本每一項, o1 比起自己的前輩來說,都是接近 8 倍的提升。。。

要是把這些測試結果拆開來,這新 o1 也幾乎是在各種學科、各種領域,都全量、全面、全方位地超越 4o 。

而真正讓差評君覺得可怕的是, OpenAI 說自己專門請了博士專家一起答題。

結果在博士級別的測試結果上,我們看到 o1 答題分數均超過了博士專家。o1 得分 78 ,人類得分 69.7 。。。

連博士都輸了,那我和它比算什麼?

01

敏感的網民們,直接就炸了呀。又開始喊著,新的神已經出現。

隨便一翻,都是帶著【 最 】字的超高評價,什麼「 簡直太棒了! 」 、 「 最接近人類推理的東西 」。

甚至有不少差友跑到咱們後台,感慨 o1 你小子確實有點東西啊。

聽起來是不是很牛逼?OpenAI 他們自己很顯然也是這麼覺著的。

具體 OpenAI 在它上面花了多少錢還沒公佈,但從用戶使用上,就能明顯看到這玩意多耗錢了。

o1 預覽版每百萬輸入 15 美元,每百萬輸出 60 美元

這次對用戶開放的甚至不是滿血版本,就是一個早期的預覽版和一個小型閹割版。

哪怕只是搶先嚐鮮,不僅不免費,哪怕你掏錢開了會員,也卡你問答次數。預覽版每週只有 30 條, mini 每週只有 50 條。。。

雖然有點貴,但我們肯定不可能讓 OpenAI 吹什麼就是什麼。

他們不是說超過博士了嗎?差評君就衝了幾個帳號,去找了幾個博士來親測了一下。

02

為了保證專業性和客觀性,我們專門邀請了理綜三科的博士參與測評,有生物學、固體物理學、材料化學等等。

其中,南京大學在讀的固體物理學崔博士給出的評價,算是幾個人里最高的。他覺得 o1 已經達到了 60 – 80 分( 滿分 100 )的水平。

甚至,部分回答也可以給到 90 分。

崔博士給的第一個問題:遠距離糾纏光子分發,有什麼克服白噪聲的辦法?

大概 9 秒鍾左右, o1 就給出了 10 點可行的措施。

當然了,沒一個點是我看得明白的。不過,崔博士的評價還可以:答案列舉全面,符合現有的最新研究進展,屬於科普級別的答案。

其中,提到的自適應光學的方向甚至是今年最新的 science 成果。

和老版 4o 一比,馬上高下立判了。

就別說新方向提沒提到,光是給出的措施數量上,就差了不少。

於是後面,我們就專門對自適應光學這個船新方向進行了追問:利用了量子糾纏的什麼原理來提高信噪比?能否拓展到量子自適應光學?

幾輪答案之後,崔博士給出了 80 – 90 分的高分,還大方地和我承認,部分思考是他的薄弱點,對他的方向有提示作用。

不過,後續我們再深入追問之後,它問題就暴露出來了。當追問到更難的實驗細節部分, o1 的回答效果就會降低。

但總體來說,在物理方面, o1 的表現算是不錯的。和老版比下來,提升基本在 20 分左右。

不過,在 OpenAI 的測試里,物理本來就是分數最高的。所以我們又拉來一位北大在讀材料化學的 K 博士,想對它評分最低的化學,來幾個狠問題。

K 博士圍繞Fe-N4問了一系列的問題, o1 給了很長的一串回答,為了精簡篇幅我們這裏只展示了部分問題和結果。

整體測試之後, K 博士給出的評價也差不多:可能有研究生水平,但是深入的認知和給方案的能力,比較虛,主要還是針對已知內容作答。

比如問到如何調節 Fe-N4 , o1 可以說出基於電子態調節,但你要是問它那該咋調節,它就有點卡殼了。

雖然相比 gpt4o 沒那麼胡說八道,但具體的問題上他倆都給不了太多建議,老版是喪失細節亂說,新版能力有限就會詞窮。

除了這倆,理綜三科那肯定也少不了生物。

我們還諮詢了來自清華,在讀生物學的信博士,他的問題是: 「如何從質譜數據集中區分賴氨酸殘基的乳酰化和羧乙基修飾?」

雖然我聽不懂,但是 o1 也給了一段非常長的回答,跟論文綜述似的,後面還貼了參考文獻。

但出乎意料的是,當我們把這個回答交給信博士,人家看完就發現不對路了,而且是一眼丁真的問題。

倒不是這 AI 回答的全錯,而是 AI在參考文獻里亂編,這論文壓根不存在!

雖然編了,但也沒完全編,總體來說人家清華博士還是覺得比之前的 AI 能強不少,起碼理解能力是肉眼可見了,編也編的很像。。。

不過,不同方向的博士評價有所區別,這或許也跟 o1 自己擅長的領域有關。

拿官方給出的理綜分數來看,雖然 gpt4o 在生物學上的評分要比化學和物理高,但這回的 o1 就完全不一樣。

o1 在物理上的分數達到了 92.8 ,已經遠超其他兩門學科,這或許就是崔博士對它比較看好的原因。

03

總體而言,真要說到超越專業博士水平,博士們認為還得緩緩。

崔博士直言,在現實科研工作中,多數情況學者們都還得自己動手, AI 只能提供大致方向,因此花錢要這樣的細緻 AI 意義不大。

他更推薦本科生選擇這個 AI ,要是碩博階段,那這個 AI 的回答其實並不符合導師標準,組會上肯定要挨批。

清華的信博士也同樣持這種看法,且不說 AI 的幻覺編造文獻問題,就專業程度而言, AI 的回答也只能糊弄大同行,也就是同一大學科裡面方向不同的人群;而在小同行,專業研究這個方向的人眼裡, AI 的毛病還是非常明顯的。

北大 K 博士則談的更深入,他認為這個 AI 只能說在認知上有了碩士生的水平,但也只是作為一個縫補匠,談不上說出什麼創造性的成果。就創造性這一點來說, AI 是遠遠比不上碩博的水平的,這也是 AI 需要解決的重要問題。

在博士們的評價里,我們似乎能抓到一個重點:o1 模型之所以相對更強,是因為他有了更高維的認知和思考模式。

這,也是 o1 本次更新的要點。我們在 OpenAI 官網找到了 Learning to Reason with LLMs 這篇文章,他們在文中表示,主要是他們用上了長思維鏈 (CoT , Chain of thought) ,而不是傳統的提示鏈( Prompt chain )。

第一眼看上去有點懵,說人話就是,這個大模型改變了以往那種你問我答的思考方式。

在以前的模式下,大模型的問答就跟下意識出答案一樣,比如你問我天是什麼顏色,這問題我想都不想,秒答藍色。這實際上需要我本來就知道這個知識點,然後給你直接反應就完了。

但這個長思維鏈就相當於,我不僅要知道藍色是個什麼,還能自己推一遍為什麼是藍色,什麼大氣散射,光譜波長都要考慮進去。

這就需要 AI 得有實打實的構建邏輯,推理論證的能力,換句話說,他不僅要長腦子,還要動腦子。

儘管思維鏈這個概念是 2022 年Google提出來的,但 OpenAI 這次是第一個實現的。

實操過程中,現在你與 o1 模型對話,除了收穫答案,還可以看選擇展開看他解答問題時的思維邏輯,他的思考是具象化的而不是黑盒。

比如我們拿崔博士提問的 「 遠距離糾纏光子分發,有什麼克服白噪聲的辦法? 」 這一問題為例, o1 模型的思考過程如下:

不過,就像專業領域的問題它也會翻車一樣,有些日常場景的簡單題似乎也有可能難住它。

拿之前那個經典 9.11 和 9.8 比大小例子來說,小紅書網民 @ 小水剛醒 就發現這玩意 「 一上難度就崩潰……無限循環發瘋般推思維鏈( CoT ) 」

我們編輯部自己評測時也發現了這個問題,不過當詢問它為什麼的時候,它也會馬上反應過來自己推理出現了錯誤,然後再重新推導一番。

好好好,不愧是博士,善於發現錯誤是吧。

整輪測試下來,差評君不得不承認,它確實是大大提升了。士別三日,也的確應當刮目相看。

在效果上,也確實相比前代確實更好,而且長思維的應用,對未來 AI 發展都是好事。

但在幾位博士輪番鞭打完以後,它的問題也暴露得挺明顯的,在創造力等某些方面,還替代不了人類博士專家。

不過 OpenAI 的研究人員 Noam Brown 透露,未來版本的 o1 將會思考幾個小時、幾天甚至幾週,雖然這樣燒錢會更多,但像在研發抗癌藥這些任務上,這種花費也是值得的。

另外,差評君覺得 GPT o1 實現的思維鏈模式,也很有可能會像之前的 Transformer 架構、 DiT 架構那樣,又會引領全世界的大模型的方向。

所以說,通往 AGI 之路說近不近,但說遠也不遠,期待接下來各家的選手輪番登場了。

本文來自微信公眾號「差評X.PIN」,作者:差評君,36氪經授權發佈。