最受歡迎開源大模型,為什麼是通義?

開源一年,通義千問的血緣模型已經達到 5 萬多個。

作者丨張進

編輯丨陳彩嫻

開源與閉源之爭早已非新奇的話題,但毋庸置疑的是,開源極大地促進了大模型技術發展和生態繁榮。

大模型被認為是最燒錢的技術,訓練一個大模型往往需要大量的數據、計算資源,導致訓練成本巨大,眾所周知GPT-3的訓練費用據說超過 4600萬美元,在大模型開源之前,大模型一直是那些有大量資金加持的大廠和明星創業公司才有資格碰的事情。

隨著如 llama、Mistral、Falcon 這些開源先鋒攪動了整個大模型競爭浪潮,那些沒有AI積累的企業、大量中小公司團隊,今天個人開發者,都能基於開源底座模型,用很低的成本訓練、部署自己的專屬模型,llama 這樣的開源先鋒也因此擁有一眾擁躉。

回到國內,在 llama、Mistral 這樣的開源先鋒影響下,國產開源也經歷了百家爭鳴階段,如ChatGLM、Baichuan、DeepSeek、Qwen也曾掀起一陣陣開源浪潮。

「百模大戰」至今不過一年多,全球開源格局已幾經變換,最出人意料的一件事,莫過於國產開源大模型正選後至,有了比肩全球頂尖開源模型的影響力。通義千問開源模型,就是「國模開源」的代表角色。

據AI科技評論瞭解,根據 Hugging Face的數據,Qwen系列血緣模型已經高達5萬多個,也就是說,全世界的開發者,基於Qwen系列底座,已經二次訓練出5萬多個衍生模型,僅次於Llama系列的7萬左右。這個數據,是判斷一個模型生態影響力最有說服力的指標。

金沙江創投主管合夥人朱嘯虎就曾在多個場合表示,國內開源模型已經不比閉源模型差,尤其是阿里的通義千問,很多創業公司都拿通義開源模型來訓練自己的垂直模型。

據AI科技評論瞭解,Qwen系列的衍生模型中,不乏出自面壁等明星大模型公司的微調模型,根據GitHub的介紹,面壁的MiniCPM模型就是基於SigLip-400M和Qwen2-7B做的微調。

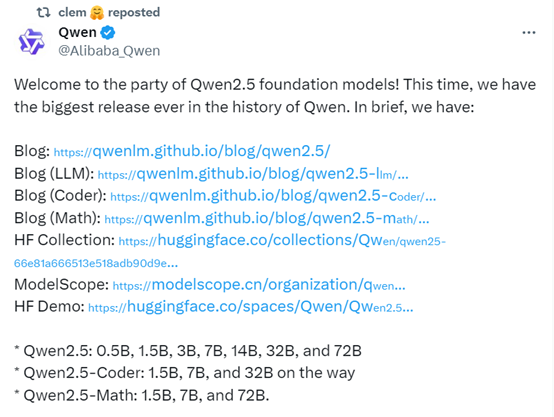

在今天於杭州舉辦的2024 雲棲大會上,通義大模型再推全新開源系列 Qwen2.5,旗艦模型又秀出了屠榜式的強勁性能。在這之前,海內外開發者和開源社區早已躍躍欲試、反復催更。

如此場景,距離通義去年首次開源不過一年多。通義是怎麼做到的?

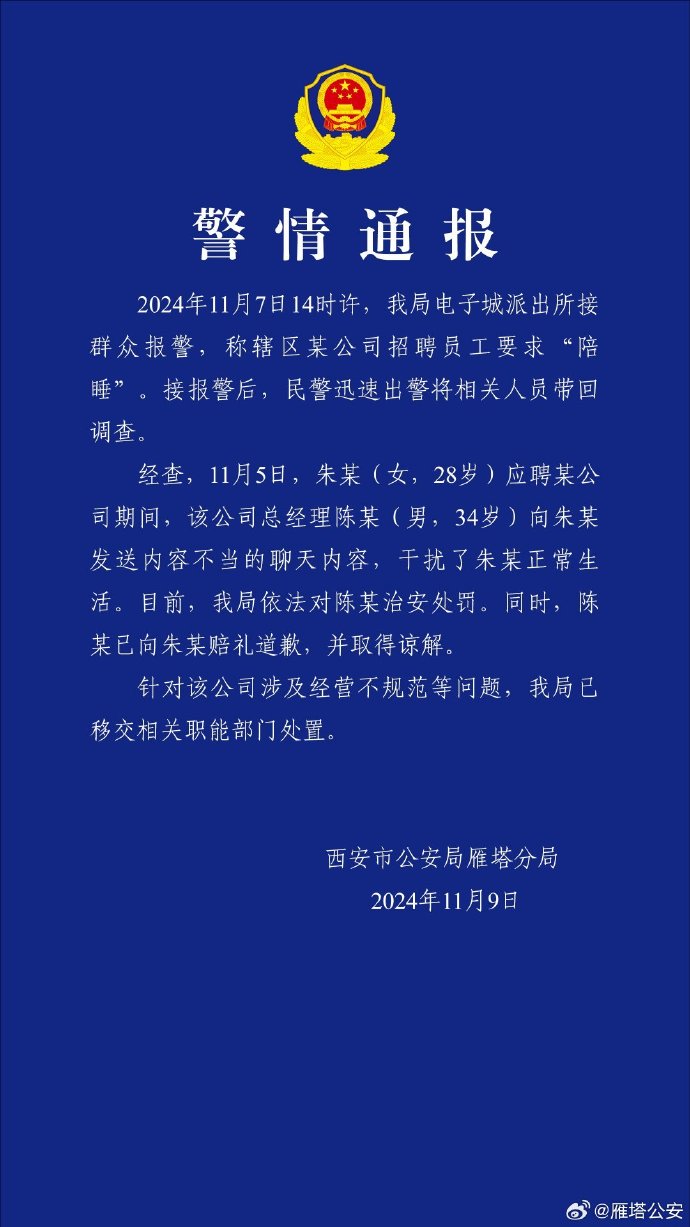

(Qwen2.5開源後,國內外開發者的反應👆)

(Qwen2.5開源後,國內外開發者的反應👆)1

Qwen2.5 全球開源第一

2023 年 3 月15 日,OpenAI 發佈了里程碑模型 GPT-4,同時智譜AI開源了ChatGLM模型,自此拉開了中國大模型開源序幕,緊跟著 6 月百川智能開源了Baichuan,8 月通義千問宣佈開源,「百模大戰」進入白熱化……23 年整個行業經歷了一場開源盛宴。

阿裡通義千問開源相對晚,但勝在後勁足。23年12月,通義千問第一款開源旗艦模型Qwen-72B 問世,成為當時性能最強的開源模型,一舉超越了開源標杆 llama 2-70B,在此之前,中國大模型市場還沒有出現一個足以對抗 llama 2-70B的開源模型。

自此,通義千問在「全尺寸、全模態」開源路上狂飆。2024年2月開源Qwen1.5系列、2024年6月開源Qwen2系列,三個月之後的今天又火速放出Qwen2.5系列,開源模型橫貫大語言、多模態、數學、代碼多個類別、模型尺寸包含0.5B到110B的完整譜系。幾乎可以說,只要開發者想要,Qwen都能提供。

這種開源力度在國產模型中前所未有,阿裡通義千問在大模型賽道的開源「人設」逐漸穩固,吸引了大波擁躉。

今天雲棲大會發佈的全新開源系列 Qwen2.5,模型性能一如既往火力全開。

Qwen2.5 有兩大特點,一是性能全球領先,穩居全球開源第一。根據阿里官方數據顯示,開源旗艦模型Qwen2.5-72B 在多個權威測評集中全面超越同尺寸開源模型,甚至「跨數量級」超越Llama3.1-405B 模型,以不到1/5的參數規模,創下超越Llama 4050 億參數的整體表現。

根據上圖,Qwen2.5-72B 在14 個關鍵基準測試中,8 項擊敗了 llama3.1-405B 指微調模型,11 項擊敗了Mistral最新開源的 Large-V2 指令微調模型,成為目前最強開源模型。

今年 7 月 Meta 發佈了最新開源模型 llama3.1-405B 後,llama3.1-405B 便一舉成為地表最強開源模型,甚至代表開源模型首次超越閉源模型。從基準測試結果來看,超大杯 Llama 3.1 405B 全方位碾壓了 GPT-3.5 Turbo、大部分基準測試得分超過了 GPT-4 0125,面對 OpenAI 此前最強閉源大模型GPT-4o和第一梯隊的 Claude 3.5 Sonnet,Llama 3.1 405B 依然有能力一戰。

只是,405B雖然強大,但模型參數實在太大、部署使用的硬件要求高出天際。對個人開發者和預算有限的中小企業來說,可望不可及。

Qwen2.5-72B 對 llama3.1-405B的超越,不僅是國產開源模型與美國最強開源模型的一次硬剛,也狠狠削平了「天花板性能」模型的使用成本。

Qwen2.5的第二個特點,開源模型數量史無前例,目的是為充分適配開發者和中小企業的需求。

Qwen2.5延續了「全尺寸、多模態」路線,同步開源了多個尺寸的大語言模型、多模態模型、數學模型和代碼模型,涵蓋基礎版本、指令跟隨版本、量化版本,總計上架超過 100 個開源模型,刷新業界新紀錄。

大語言模型共有 0.5B、1.5B、3B、7B、14B、32B、72B 七個尺寸,在等規模賽道全都創造了業界 SOTA,從這幾個型號尺寸,我們可以看到通義團隊應該是充分考慮了下遊應用的不同場景需求、從而做出上述開源策略,大致對應了當下最火的三個場景:端側模型、小模型、大模型。

比如,3B 是適配手機等端側設備的黃金尺寸,業界認為 3B-4B這個大小,意味著模型量化之後可以做到 2G 的體積,非常適合放在手機裡面。端側則也一直是英偉達、微軟和各類手機廠商都非常看重的領域。

32B是最受開發者期待的「性價比之王」,可在性能和功耗之間獲得最佳平衡。最讓開發者驚喜的,則是 140 億和320億兩種參數模型的重新回歸,14B 和 32B 是最適合本地單卡部署的模型大小。上一代Qwen2系列沒有這兩個尺寸,一直是開發者心中遺憾。

這還沒結束,下一個類別是多模態模型。上個月通義團隊開源了 2B 和 7B 版本的視覺理解模型Qwen2-VL,這次直接把720億參數的Qwen2-VL-72B 也開源了,Qwen2-VL 能識別不同解像度和長寬比的圖片,能夠理解20分鐘以上長影片,還具備自主操作手機和機器人的視覺智能體能力。

Qwen2-VL基於Qwen2打造,在多個視覺理解基準測試中取得了全球領先的表現,其中包括但不限於考察數學推理能力的MathVista、考察文檔圖像理解能力的DocVQA、考察真實世界空間理解能力的RealWorldQA、考察多語言理解能力的MTVQA。

通義千問從 6 個方面來評估 Qwen2-VL 分別在72B、7B、2B三種規模上的視覺能力,包括複雜的大學水平問題解決、數學能力、文檔和表格的理解、多語言文本圖像的理解、通用場景問答、影片理解、視覺智能代理(Visual AI Agent)能力。

整體來看,Qwen2-VL-72B在大部分指標上都達到了最優,甚至超過了GPT-4o和Claude 3.5 Sonnet等閉源模型。

最後是主攻數學和代碼賽道的兩組專項模型,數學開源模型Qwen2.5-Math包含1.5B、7B、72B,全部支持中文。Qwen2.5-Math在精心設計的數學語料庫上進行了預訓練,可以處理大學和競賽級別的數學問題。

代碼開源模型Qwen2.5-Coder 是為編程特別設計的模型,包含1.5B、7B兩個版本,通義團隊還預告了Qwen2.5-Coder -32B也在開源的路上。這組模型最多支持 128K tokens 上下文,支持 92 種編程語言, 7B 版本打敗了更大尺寸的 DeepSeek-Coder-V2-Lite 和 Codestral-20B,成為當前最強大的基礎代碼模型之一。

與此同時,一直免費對外提供服務的通義千問旗艦模型 Qwen-Max也實現了全面升級,整體性能比前代有明顯提升。通義千問官網和通義APP的後台模型均已切換為Qwen-Max,繼續免費為所有用戶提供服務。

2

模型、生態兩手抓

自 2023 年 8 月開源以來,通義千問不斷在基座模型上發力,並將所有模型能力全部開放出來供業界使用。這背後是阿里雲在 AI 大模型時代的開源開放策略在支撐。開源能夠推動大模型的研發和應用,最終,作為AI基礎設施的雲計算廠商將是整個行業算力需求的最重要承接方。

路徑純粹、目標清晰,輕裝上陣、方得致遠。

不過,開源概念雖然美好,行動卻毫無捷徑可言。在所有模型都免費可用、所有用戶都來去自如的開源社區,開發者的選擇太多了。模型好,開發者會駐足,模型不行,開發者可以毫不猶豫選用別家。

通義團隊總結了他們的開源經驗,道理之樸素,幾乎沒有任何驚喜:性能上日拱一卒,不斷訓練和迭代模型,不斷提升數據處理、模型訓練方面的技能,始終跑在模型技術第一線。生態上從零起步、開疆拓土,與海內外的開源社區、生態夥伴、開發者共建生態網絡,融入基模核心競技場。

生態建設方面,通義團隊做了幾方面的「細活」:

一,努力實現生態兼容。自Qwen1.5發佈以來,通義團隊就與Hugging Face合作,把模型代碼合併到HuggingFace transformers代碼庫,方便開發者直接使用 transformers原生代碼;通義團隊還積極溝通生態夥伴,獲得各類開源框架、開源工具對Qwen系列的兼容和支持,包括vLLM、SGLang、AutoAWQ、AutoGPTQ、Axolotl、LLaMA-Factory、llama.cpp、 Ollama 、LMStudio 等等。

二,做好開發者服務。模型開源並不是把模型放到社區就行,Qwen團隊注重從細節處提升開發者體驗。準備模型文檔(model card)時,除了主流的英文文檔,還會準備中文甚至其他語種的文檔;優化文檔質量,讓開發者一眼讀懂模型的亮點、效果、demo;準備代碼片段,幫助開發者快速部署和使用模型。Qwen團隊還非常重視與開發者的互動,積極處理開發者提交的問題和建議。

三、積極吸納研究界和開源社區的創意。比如為了回應開發者對 14B 和 32B 模型的需求,本次Qwen2.5增加了14B、32B 尺寸的開源模型。

今天我們可以看到通義大模型在開源屆已經成功躋身一流之列,比肩國際最強開源模型Llama,多次登頂Hugging Face全球大模型榜單。

通義千問開源模型Qwen的衍生模型數量已經超過5萬,僅次於Llama,數據來自全球最大的開源社區Hugging Face

通義千問開源模型Qwen的衍生模型數量已經超過5萬,僅次於Llama,數據來自全球最大的開源社區Hugging Face兩個數據最能體現通義作為中國開源大模型的影響力,一是模型下載量,根據通義官方數據,截至 2024 年 9 月初,通義千問開源模型累計下載量已經突破4000萬,這是開發者和中小企業用腳投票的結果;二是衍生模型數量,截至9月初,通義原生模型和衍生模型總數超過5萬個,成為僅次於Llama的世界級模型群。

除了開源模型,通義也提供 API 服務。據官方透露,通過阿里雲,通義大模型已經服務了30多萬客戶,他們涉及千行百業。儘管消費者市場的超級大模型應用還未出現,但在很多垂直領域,大模型正在人們看不見的地方,逐漸生根發芽。阿里巴巴最新季度業績報告顯示,阿里雲的AI相關產品收入實現三位數增長。

3

後記

從去年百模大戰中的普通一員,到如今擁有「萬模同源」的模型族群,通義大模型的開源之路,也是中國大模型追趕世界一線水平的縮影。

回顧世界技術史,在每一次技術浪潮中,開源對一項新技術的推動和創新早已經過多次驗證,開源的價值和意義毋庸置疑,站在大模型技術發展的角度可以說,在過去一年裡通義大模型極大地推動了中國大模型的生態繁榮。