OpenAI 淩晨發佈:Realtime 實時多模態 API,及其他

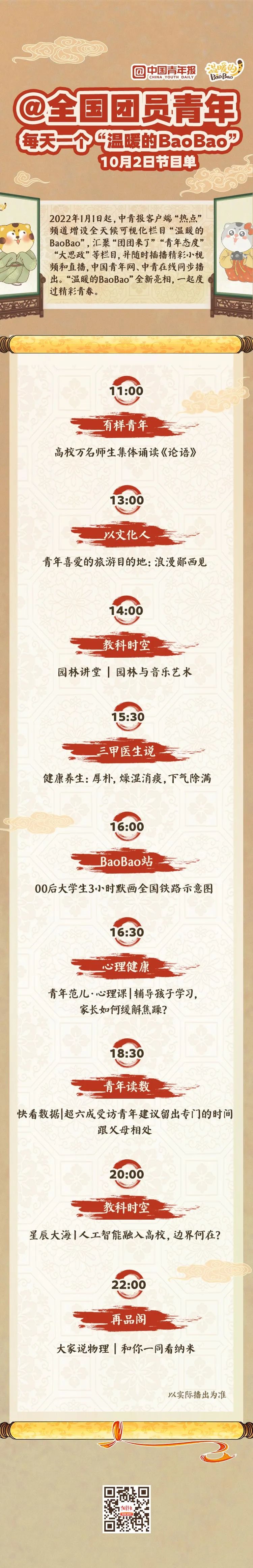

中國時間淩晨 1 點多,OpenAI 召開了本年的開發者大會(舊金山場)。順道說一下,今年開發者大會一共 3 場:10月1號舊金山;10月30號倫敦,以及11月21日新加坡

本次的發佈,大體是常規更新,包括:

-

【新東西】Realtime API

-

可以理解為就是 GPT-4o 帶 advanced voice 的那套,支持 API 了

-

可以在 playground 里先玩玩

-

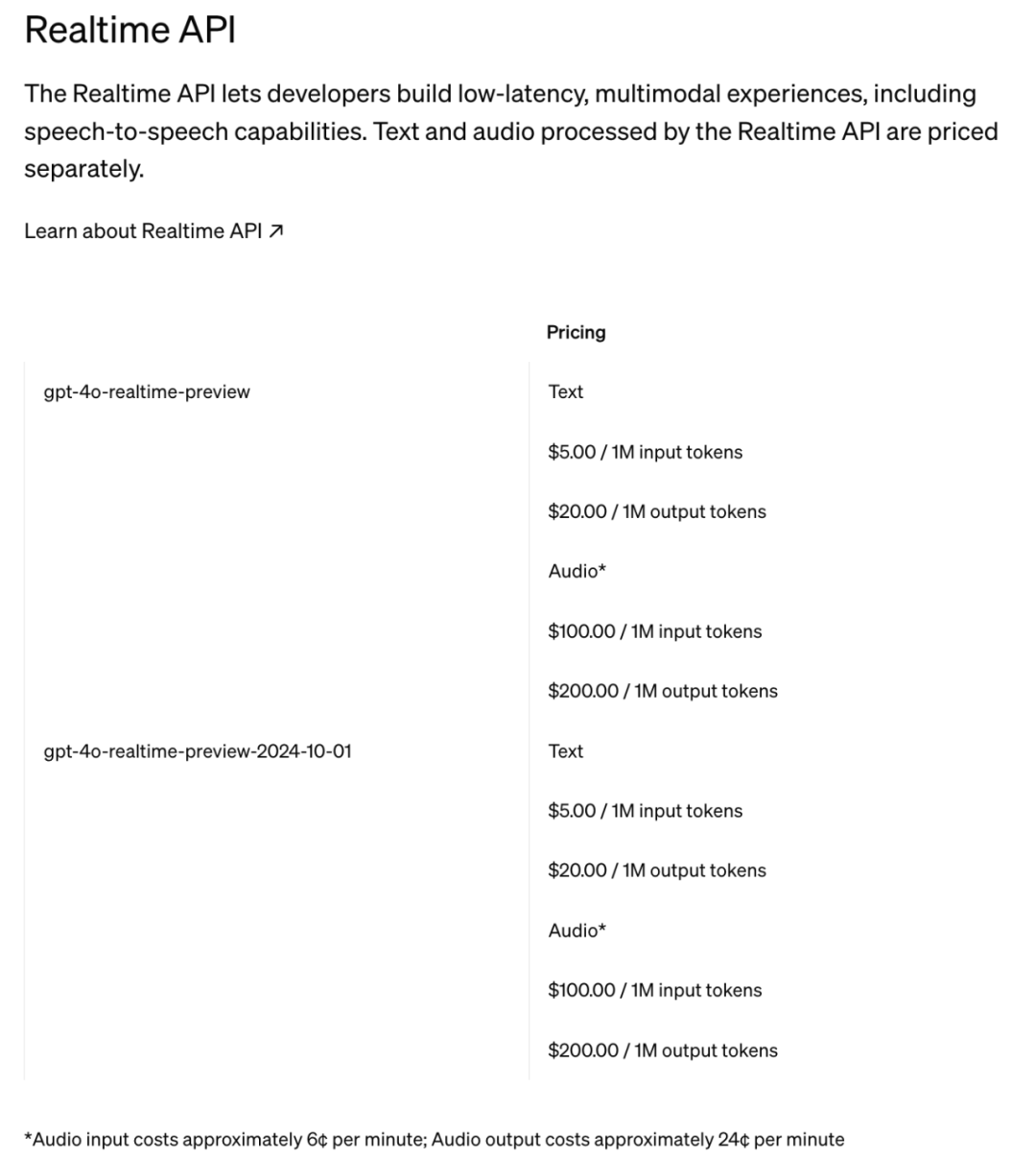

價格很貴很貴,音頻的話:

-

輸入價格:100刀 每百萬 token

-

輸出價格:200刀 每百萬 token

-

視覺模型微調

-

對於支持圖像的模型,比如 4o 或者 4o-mini,現在可以用圖片進行微調了

-

利好工業/醫療等場景

-

看了下文檔,方法挺友好的,價格也會貴一些:以 4o-0806 為例子,微調價格為 25 刀/百萬 token;之後調用是 $3.75 輸入,$15 輸出

-

緩存摺扣

-

如果命中緩存,5折,目前支持:gpt-4o,gpt-4o-mini,o1-preview 和 o1-mini 這四個模型

-

具體可以看這裏:https://platform.openai.com/docs/guides/prompt-caching

-

其他發佈

-

模型層面,帶來了蒸餾服務:這確實是獨一份的,用來生產高質量語料。不過這東西,對普通開發者,應該用處不大

-

調試方面,迭代了很多 playground 中的工具鏈和交互方式,比如 system prompt 的自動優化

-

在 api 層面,支持了如 zod,pydantic 這樣的工具,方便更好的結構化輸出(疑惑:之前不就支持了?我一直在用啊)

-

其他…

重點說說

Realtime API

這個東西,可以理解為是 4o 搭配了 advanced voice 的背後 api。

在以往,常規的帶語音的 AI 模型,在處理對話的時候,是遵循以下步驟:

-

將語音轉換成文字(比如使用 whisper 模型)

-

將文字傳輸給大模型,並獲得文字返回

-

用 tts 工具,將文字讀出來

在很多情況下,這麼做是沒問題的,但總會覺得彆扭,比如我給大模型說

-

wò caò

-

wò caǒ

-

wǒ caò

-

wǒ caǒ

-

…

很顯然,這幾個意思是不一樣的。如果我通過「語音 – 文字 – 語音」的方法,並不能準確識別,還可能被認為我手裡拿了個草「握草」。但如果是語音 end–end 的做法,則可以準確識別。

同時,也可以發現,這裏還有一個可行的項目方向:用語音 end – end 的方式,進行語言訓練,比如矯正口音。

另需要注意的是,這個模型…很貴。讓他說一分鐘的話,需要人民幣大概 1.7 元:

這個模型的調用方法,和 gpt 系列不太一樣,也不用 openai sdk。具體不展開了,有興趣的可以看這:

https://platform.openai.com/docs/guides/realtime

官方還配了個例子(我是第4個點讚的,ahhhhh):

https://github.com/openai/openai-realtime-api-beta

另一個(console):https://github.com/openai/openai-realtime-console

最後再「抽水」下…截止到成稿的時候,這個 api 都沒有真實上線。

再來談談

視覺模型微調

這個是有用的,尤其是在工業領域,比如:

-

醫療領域:拿 CT 影像數據來微調,獲得一個看片 bot

-

安防領域:代替部分的傳統 CV 方案,判定實時風險

-

工業領域:讓 AI 通過一定量的樣本學習,在流水線或者類似場景中,自動檢出殘次品/報警

微調的方法極其簡單,和聊天發圖片差不多。支持 url 或者 base64 傳遞圖片,看這就行了:https://platform.openai.com/docs/guides/fine-tuning/vision

這裏有些限制,兩個方面:

-

技術限制:最多 5 萬組訓練數據,每組最多 10 張圖,每張圖最大 10 M

-

合規限制:不允許用人像、人臉以及驗證碼(CAPTCHAs),以及其他可能違規的數據進行訓練

眾所周知,微調貴一截,這裏是價目表:

以及,這裏還有一個限時活動:

-

GPT-4o:每天前 1M 的微調免費,後續 $25.00/1M tokens.

-

GPT-4o-mini:每天前 2M 的微調免費,後續 $3.00/1M tokens.

至於…

緩存摺扣

說白了,就之前(幾分鐘~1小時)內問過的問題,再問一遍類似的,重覆部分半價。不過,優惠力度不夠大,畢竟 Gemini 是輸入 2 折;DeepSeek 是輸入 1折:《DeepSeek API 創新採用硬盤緩存,價格再降一個數量級》

至於原理和步驟,大概是這樣:

-

啟用緩存:如果 prompt 長度超過 1024 tokens,系統會自動啟用緩存,並檢查 prompt 前部分是否已存儲在緩存中

-

如命中:如找到匹配,則會使用緩存的結果,以降低延遲並減少成本

-

未命中:如沒找到,系統會正常處理,然後緩存當前請求,以便將來使用。

需注意:

-

緩存啟用:無需主動聲明,自動啟用

-

緩存時間:通常是 5~10 分鐘,高峰時段可能是 1 小時(不可控)

-

緩存管理:同一組織下,緩存共享,且無法主動清理

-

內容生成:緩存不會影響 API 生成的最終響應,每次生成是獨立的

-

折扣互斥:Batch API 不享受緩存摺扣

其他

今場發佈會的主要更新,還是傳統開發者 – 拿著 API 或者模型整活的。

Realtime API 等馬上(可能就是1天內)上線後,可以多試試,找找感覺,應該有不少場景。

另外的,11 月 21 號的新加坡場作為 OpenAI 的本年度最後一場活動,應該會有一些新東西。到時候我也會去現場,帶來第一手的實時報導。