蘇姿豐2小時激情演講,發佈AMD最強AI芯片,旗艦CPU單顆10萬,OpenAI微軟都來站台

猛,實在是猛!就在今日,老牌芯片巨頭AMD交出了一份令人印象深刻的AI答卷。

智東西美國舊金山10月10日現場報導,酷熱的天氣剛剛過去,舊金山正值秋意涼爽,今日舉行的AMD Advancing AI 2024盛會卻格外火熱。

AMD傾囊倒出了一系列AI殺手鐧,發佈全新旗艦AI芯片、服務器CPU、AI網卡、DPU和AI PC移動處理器,將AI計算的戰火燒得更旺。

這家芯片巨頭還大秀AI朋友圈,現場演講集齊了Google、OpenAI、微軟、Meta、xAI、Cohere、RekaAI等重量級AI生態夥伴。

備受期待的旗艦AI芯片AMD Instinct MI325X GPU首次啟用HBM3E高帶寬內存,8卡AI峰值算力達到21PFLOPS,並與去年發佈的、同樣採用HBM3E的英偉達H200 GPU用數據掰手腕:內存容量是H200的1.8倍,內存帶寬、FP16和FP8峰值理論算力都是H200的1.3倍。

AMD還披露了最新的AI芯片路線圖,採用CDNA 4架構的MI350系列明年上市,其中8卡MI355X的AI峰值算力達到74PFLOPS,MI400系列將採用更先進的CDNA架構。

更高的數據中心算力,離不開先進的網絡解決方案。對此,AMD發佈了業界首款支持UEC超以太網聯盟的AI網卡Pensando Pollara 400和性能翻倍提升的Pensando Salina 400 DPU。

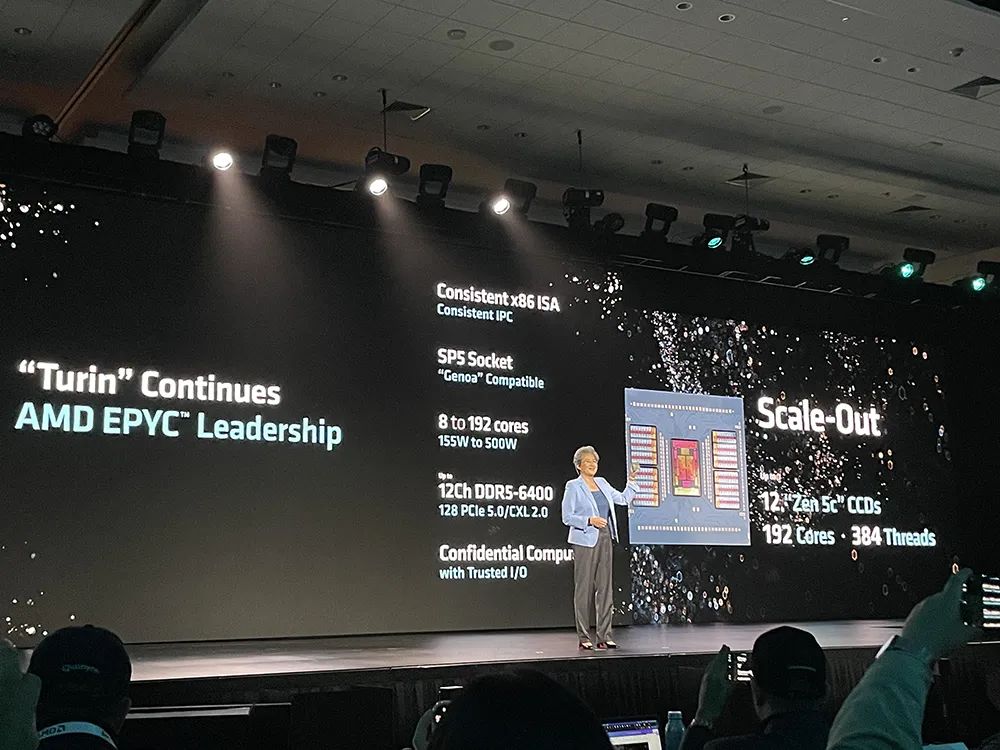

另一款重磅新品是第五代EPYC服務器CPU,被AMD稱為「面向雲計算、企業級和AI的全球最好CPU」,採用台積電3/4nm製程工藝,最多支持192核、384個線程。其中頂配EPYC 9965預設熱設計功耗500W,以1000顆起訂的單價為14813美元(約合人民幣10萬元)。

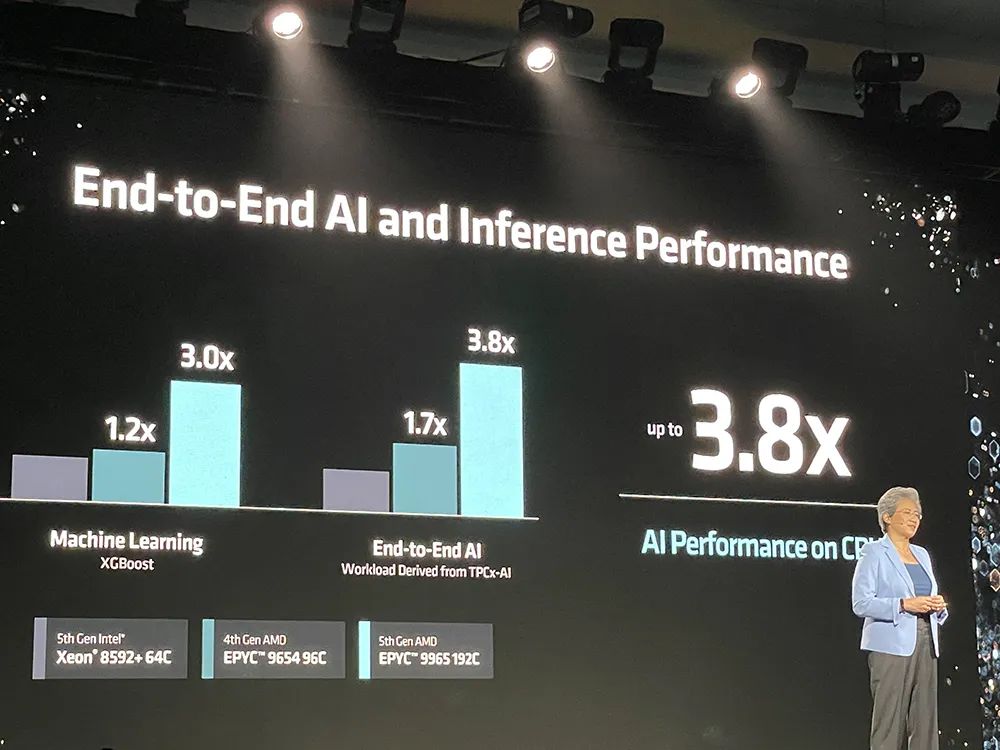

與第五代英特爾至強鉑金8592+處理器相比,AMD EPYC 9575F處理器的SPEC CPU性能提高多達2.7倍,企業級性能提高多達4.0倍,HPC(高性能計算)性能提高多達3.9倍,基於CPU的AI加速提高多達3.8倍,GPU主機節點提升多達1.2倍。

自2017年重回數據中心市場後,AMD一路形勢強勁:其數據中心CPU收入市佔率在2018年還只有2%,今年上半年已攀爬到34%,在全球覆蓋超過950個雲實例和超過350個OxM平台。

AMD是唯一一家能夠提供全套CPU、GPU和網絡解決方案來滿足現代數據中心所有需求的公司。

AI PC芯片也迎來了新成員——AMD第三代商用AI移動處理器銳龍AI PRO 300系列。它被AMD稱作「為下一代企業級AI PC打造的全球最好處理器」,預計到2025年將有超過100款銳龍AI PRO PC上市。

01.

旗艦AI芯片三代同堂:

內存容量帶寬暴漲,峰值算力衝9.2PF

AI芯片,正成為AMD業務增長的重頭戲。

AMD去年12月發佈的Instinct MI300X加速器,已經成為AMD歷史上增長最快的產品,不到兩個季度銷售額就超過了10億美元。

今年6月,AMD公佈全新年度AI GPU路線圖,最新一步便是今日發佈的Instinct MI325X。在7月公佈季度財報時,AMD董事會主席兼CEO蘇姿豐博士透露,AMD預計其今年數據中心GPU收入將超過45億美元。

微軟、OpenAI、Meta、Cohere、Stability AI、Lepton AI(賈揚清創辦)、World Labs(李飛飛創辦)等公司的很多主流生成式AI解決方案均已採用MI300系列AI芯片。

微軟董事長兼CEO薩提亞·納迪拉維杜華對MI300讚譽有加,稱這款AI加速器在微軟Azure工作負載的GPT-4推理上提供了領先的價格/性能。

基於Llama 3.1 405B運行對話式AI、內容生成、AI Agent及聊天機器人、總結摘要等任務時,MI300的推理速度最多達到英偉達H100的1.3倍。

新推出的MI325X進一步抬高性能,跑Mixtral 8x7B、Mistral 7B、Llama 3.1 70B等大模型的推理性能,比英偉達H200快20%~40%。

MI325X擁有1530億顆晶體管,採用CDNA 3架構、256GB HBM3E內存,內存帶寬達6TB/s,FP8峰值性能達到2.6PFLOPS,FP16峰值性能達到1.3PFLOPS。

由8張MI325X組成的服務器平台有2TB HBM3E內存;內存帶寬達到48TB/s;Infinity Fabric總線帶寬為896GB/s;FP8性能最高達20.8PFLOPS,FP16性能最高達10.4PFLOPS。

相比英偉達H200 HGX,MI325X服務器平台在跑Llama 3.1 405B時,推理性能可提高40%。

從訓練性能來看,單張MI325X訓練Llama 2 7B的速度超過單張H200,8張MI325X訓練Llama 2 70B的性能比肩H200 HGX。

AMD Instinct MI325X加速器或將於今年第四季度投產,將從明年第一季度起為平台供應商提供。

下一代MI350系列採用3nm製程工藝、新一代CDNA 4架構、288GB HBM3E內存,新增對FP4/FP6數據類型的支持,推理性能相比基於CDNA 3的加速器有高達35倍的提升,有望在2025年下半年上市。

MI355X加速器的FP8和FP16性能相比MI325X提升了80%,FP16峰值性能達到2.3PFLOPS,FP8峰值性能達到4.6PFLOPS,FP6和FP4峰值性能達到9.2PFLOPS。

8張MI355X共有2.3TB HBM3E內存,內存帶寬達到64TB/s,FP16峰值性能達到18.5PFLOPS,FP8峰值性能達到37PFLOPS,新增FP6和FP4的峰值性能為74PFLOPS。

三代GPU的配置顯著升級:相比8卡MI300X,8卡MI355X的AI峰值算力提升多達7.4倍、HBM內存提高多達1.5倍、支持的模型參數量提升幅度接近6倍。

AMD持續投資軟件和開放生態系統,在AMD ROCm開放軟件棧中提供新特性和功能,可原生支持主流AI框架及工具,具備開箱即用特性,搭配AMD Instinct加速器支持主流生成式AI模型及Hugging Face上的超過100萬款模型。

ROCm 6.2現包括對關鍵AI功能的支持,如FP8數據類型、Flash Attention、內核融合等,可將AI大模型的推理性能、訓練性能分別提升至ROCm 6.0的2.4倍、1.8倍。

此前AMD收購了歐洲最大的私人AI實驗室Silo AI,以解決消費級AI最後一英里問題,加快AMD硬件上AI模型的開發和部署。歐洲最快的超級計算機LUMI便採用AMD Instinct加速器來訓練歐洲語言版的大語言模型。

02.

下一代AI網絡:後端引入業界首款支持UEC的AI網卡,前端上新400G可編程DPU

網絡是實現最佳系統性能的基礎。AI模型平均有30%的訓練週期時間都花在網絡等待上。在訓練和分佈式推理模型中,通信佔了40%-75%的時間。

AI網絡分為前端和後端:前端向AI集群提供數據和信息,可編程DPU不斷髮展;後端管理加速器與集群間的數據傳輸,關鍵在於獲得最大利用率。

為了有效管理這兩個網絡,並推動整個系統的性能、可擴展性和效率提升,AMD今日發佈了應用於前端網絡的Pensando Salina 400 DPU和應用於後端網絡的Pensando Pollara 400網卡。

Salina 400是AMD第三代可編程DPU,被AMD稱作「前端網絡最佳DPU」,其性能、帶寬和規模均提高至上一代DPU的兩倍;Pollara 400是業界首款支持超以太網聯盟(UEC)的AI網卡。

Salina 400支持400G吞吐量,可實現快速數據傳輸速率,可為數據驅動的AI應用優化性能、效率、安全性和可擴展性。

Pollara 400 採用 AMD P4可編程引擎 ,支持下一代RDMA軟件,並以開放的網絡生態系統為後盾,對於在後端網絡中提供加速器到加速器通信的領先性能、可擴展性和效率至關重要。

UEC Ready RDMA支持智能數據包噴發和有序消息傳遞、避免擁塞、選擇性重傳和快速損失恢復。這種傳輸方式的消息完成速度是RoCEv2的6倍,整體完成速度是RoCEv2的5倍。

在後端網絡,相比InfiniBand,以太網RoCEv2是更好的選擇,具有低成本、高度可擴展的優勢,可將TCO節省超過50%,能夠擴展100萬張GPU。而InfiniBand至多能擴展48000張GPU。

03.

服務器CPU:

3/4nm製程,最多192核/384線程

今年7月公佈財報時,蘇姿豐提到今年上半年,有超過1/3的企業服務器訂單來自首次在其數據中心部署EPYC服務器CPU的企業。

第五代EPYC處理器9005系列(代號「Turin」)專為現代數據中心設計。

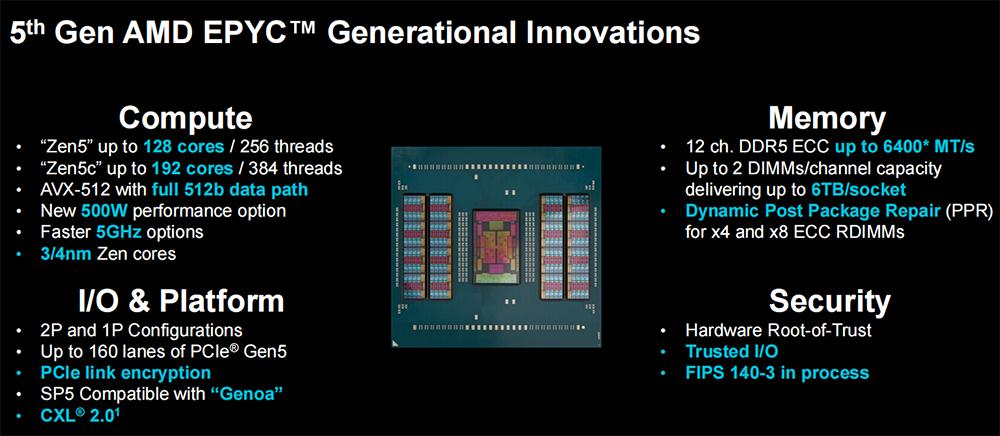

該處理器在計算、內存、IO與平台、安全四大層面全面升級。

第五代EPYC擁有1500億顆晶體管,採用台積電3/4nm 製程、全新「Zen 5」 及「Zen 5c」核心兼容廣泛部署的SP5平台,最多支持192核、384個線程,8~192核的功耗範疇為155W~500W。

它支持AVX-512全寬512位數據路徑、128 PCIe 5.0/CXL 2.0、DDR5-6400MT/s內存速率,提升頻率高達5GHz,機密計算的可信I/O和FIPS認證正在進行中。

與「Zen 4」相比,「Zen 5」核心架構為企業和雲計算工作負載提供了提升17%的IPC(每時鍾指令數),為AI和HPC提供了提升37%的IPC。

在SPEC CPU 2017基準測試中,192核EPYC 9965的整數吞吐量是64核至強8592+的2.7倍,32核EPYC 9355的每核心性能是32核6548Y+的1.4倍。

跑影片轉碼、商用App、開源數據庫、圖像渲染等商用工作負載時,192核EPYC 9965的性能達到64核至強8592+性能的3~4倍。

在處理開源的HPC密集線性求解器、建模和仿真任務時,EPYC 9965的性能可達到至強8592+性能的2.1~3.9倍。

達到相同性能,第五代EPYC所需的服務器數量更少,有助於降低數據中心的TCO(總擁有成本)以及節省空間和能源。

例如,要達到總共391000個單位的SPECrate 2017_int_base性能得分,相比1000台搭載英特爾至強鉑金8280的服務器,現在131台搭載AMD EPYC 9965的現代服務器就能實現,功耗、3年TCO均顯著減少。

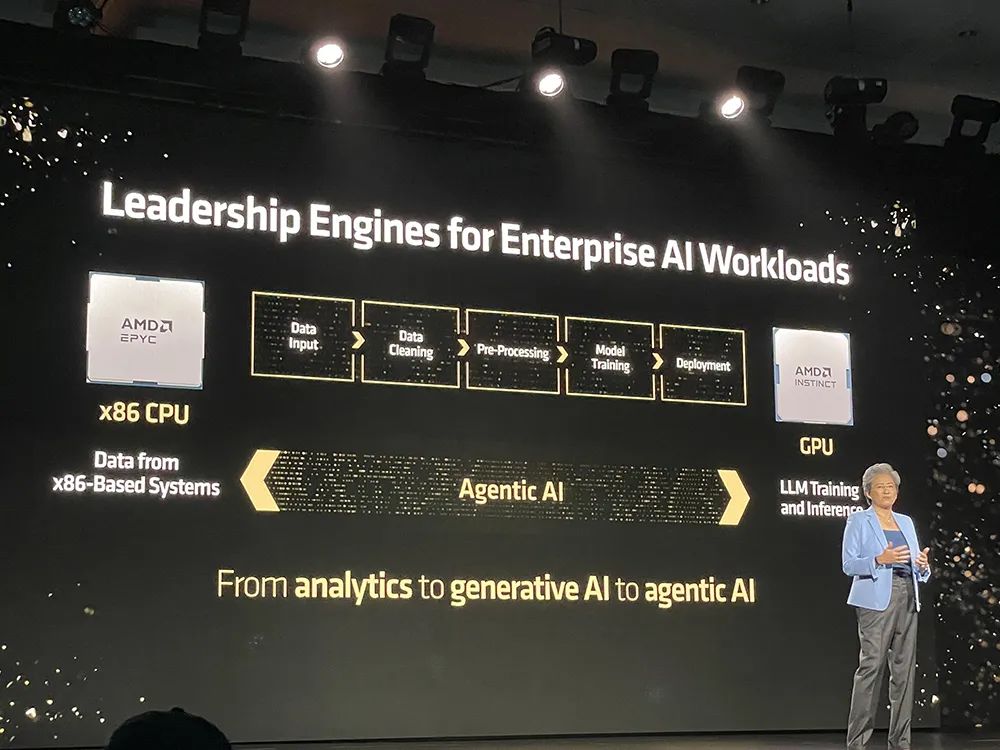

通過優化的CPU+GPU解決方案,AMD EPYC CPU不僅能處理傳統通用目的的計算,而且能勝任AI推理,還能作為AI主機處理器。

相比64核至強8592+,192核EPYC 9965在運行機器學習、端到端AI、相似搜索、大語言模型等工作負載時,推理性能提升多達1.9~3.8倍。

AMD EPYC 9005系列的新產品是64核EPYC 9575F,專為需要終極主機CPU能力的GPU驅動AI解決方案量身定製。

與競爭對手的3.8GHz處理器相比,專用AI主機的CPU EPYC 9575F提供了高達5GHz的提升,可將GPU編排任務的處理速度提高28%。

面向企業級HPC工作負載,64核EPYC 9575F的FEA仿真和CFD仿真&建模的性能,可提升至64核至強8592的1.6倍。

EPYC 9575F可使用其5GHz的最大頻率提升來助力1000個節點的AI集群每秒驅動多達70萬個推理token。同樣搭配MI300X GPU,與64核至強8592+相比,EPYC 9575F將GPU系統訓練Stable Diffusion XL v2文生圖模型的性能提升20%。

搭配Instinct系列GPU的AMD EPYC AI主機CPU型號如下:

同樣搭配英偉達H100,EPYC 9575F可將GPU系統的推理性能、訓練性能分別相比至強8592+提升20%、15%。

與英偉達GPU系統適配的AMD EPYC AI主機CPU型號如下:

將EPYC用於計算與AI混合工作負載時,相比至強鉑金8592+,EPYC 9654+2張Instinct MI210在處理50%通用計算+50% AI的混合任務時,每美元性能可提升多達2倍。

04.

企業級AI PC處理器:

升級「Zen 5」架構,AI算力最高55TOPS

AI PC給企業生產力、身臨其境的遠程協作、創作與編輯、個人AI助理都帶來了全新轉型體驗。

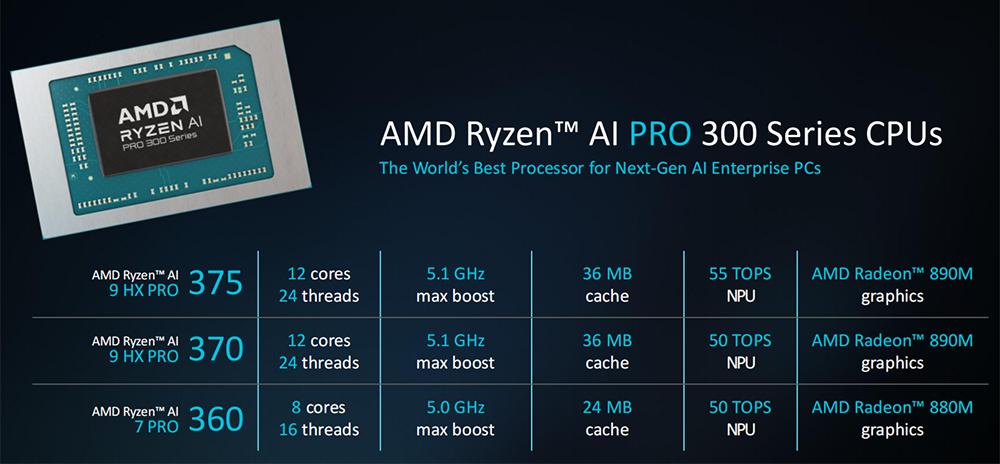

繼今年6月推出第三代AI移動處理器銳龍AI 300系列處理器(代號「Strix Point」)後,今日AMD宣佈推出銳龍AI PRO 300系列。

該處理器專為提高企業生產力而設計,採用4nm工藝、「Zen 5」 CPU架構(最多12核、24個線程)、RDNA 3.5 GPU架構(最多16個計算單元),支持Copilot+功能,包括電話會議實時字幕、語言翻譯、AI圖像生成等。

其內置NPU可提供50-55TOPS的AI處理能力。

40TOPS是微軟Copilot+ AI PC的基準要求。相比之下,蘋果M4、AMD銳龍PRO 8040系列、英特爾酷睿Ultra 100系列的NPU算力分別為38TOPS、16TOPS、11TOPS。

與英特爾酷睿Ultra 7 165H相比,旗艦銳龍AI 9 HX PRO 375的多線程性能提高了40%,辦公生產力提高了14%,支持更長續航。

銳龍AI PRO 300系列採用AMD PRO技術,提供世界級領先的安全性和可管理性,旨在簡化IT運營及部署並確保企業獲得卓越的投資回報率。

由搭載銳龍AI PRO 300系列的OEM系統預計將於今年晚些時候上市。

AMD也擴展了其PRO技術陣容,具有新的安全性和可管理性功能。配備AMD PRO技術的移動商用處理器現有雲裸機恢復的標準配置,支持IT團隊通過雲無縫恢復系統,確保平穩和持續的操作;提供一個新的供應鏈安全功能,實現整個供應鏈的可追溯性;看門狗定時器,提供額外的檢測和恢復過程,為系統提供彈性支持。

通過AMD PRO技術,還能實現額外的基於AI的惡意軟件檢測。這些全新的安全特性利用集成的NPU來運行基於AI的安全工作負載,不會影響日常性能。

05.

結語:AMD正在數據中心市場攻勢兇猛

AMD正沿著路線圖,加速將AI基礎設施所需的各種高性能AI解決方案推向市場,並不斷證明它能夠提供滿足數據中心需求的多元化解決方案。

AI已經成為AMD戰略佈局的焦點。今日新發佈的Instinct加速器、EPYC服務器CPU、Pensando網卡&DPU、銳龍AI PRO 300系列處理器,與持續增長的開放軟件生態系統形成了組合拳,有望進一步增強AMD在AI基礎設施競賽中的綜合競爭力。

無論是蠶食服務器CPU市場,還是新款AI芯片半年攬金逾10億美元,都展現出這家老牌芯片巨頭在數據中心領域的衝勁。緊鑼密鼓的AI芯片產品迭代、快速擴張的全棧軟硬件版圖,都令人愈發期待AMD在AI計算市場創造出驚喜。

本文來自微信公眾號「智東西」,作者:ZeR0,36氪經授權發佈。