開源模型突破原生多模態大模型性能瓶頸,上海AI Lab代季峰團隊出品

Mono-InternVL團隊 投稿

量子位 | 公眾號 QbitAI

原生多模態大模型性能瓶頸,迎來新突破!

上海AI Lab代季峰老師團隊,提出了全新的原生多模態大模型Mono-InternVL。

與非原生模型相比,該模型首個單詞延遲最多降低67%,在多個評測數據集上均達到了SOTA水準。

與常見的採用CLIP等結構進行視覺編碼的模塊化多模態大模型不同,Mono-InternVL將視覺感知和多模態理解均集成到大語言模型中。

相比於現有多模態大模型,Mono-InternVL有以下技術亮點:

-

開源原生多模態架構最優解:無需額外的視覺編碼器,通過內嵌視覺專家打通了一條從大語言模型到原生多模態模型擴展的新路徑,2B模型多模態能力優於7B參數的現有原生多模態模型,多個指標超越InternVL1.5。

-

兼具視覺靈活性和部署高效性:支持高達2M像素輸入的動態圖像解像度,在原生多模態架構中感知精度最高。相比於InternVL1.5,在部署框架上首個單詞延遲最多降低67%,整體吞吐量提高31%。

破解原生多模態大模型遺忘問題

現有的多模態大模型(MLLM)通常採用視覺編碼器-對齊模塊-語言模型的結構,將視覺編碼和語言解碼分別進行處理。

具體來說,這些模型通常通過將預訓練的視覺編碼器(例如CLIP)與大語言模型(LLM)結合來實現,即模塊化MLLM。

最近新興的Chameleon、EVE等原生MLLM,將視覺感知和多模態理解直接集成到一個LLM中,可以更方便地通過現有工具進行部署、具備更高的推理效率。

然而,由於原生MLLM缺乏視覺能力,視覺相關的訓練通常不可避免,但視覺預訓練過程中語言基座能力常常出現災難性遺忘問題,導致現有原生MLLM的性能仍顯著低於模塊化MLLM。

為此,Mono-InternVL提出了採用增量預訓練的方法,解決此前原生MLLM中的災難性遺忘問題。

因此,作者在預訓練的LLM中嵌入了專門服務於視覺建模的視覺專家,通過MoE的方式實現稀疏化的建模。

基於此,作者通過僅優化視覺參數空間來進行視覺預訓練,同時保留了語言基座的預訓練知識。

原生多模態結構

具體來說,Mono-InternVL 由視覺文本嵌入和多模態MoE結構兩部分組成:

-

視覺和文本嵌入:與使用CLIP等視覺編碼器的模塊化 MLLM 相比,Mono-InternVL 通過patch embedding直接將圖像轉換為patch序列。文本嵌入模塊則直接使用LLM的分詞器。

-

多模態MoE結構:Mono-InternVL 的核心是將視覺專家FFN嵌入到預訓練的 LLM 中。視覺FFN從預訓練LLM中的文本FFN初始化。由此不僅可以利用預訓練的 LLM 知識促進視覺預訓練,還能顯著緩解災難性遺忘問題。

內生視覺預訓練

作者提出內生視覺預訓練(EViP)方法,旨在通過在大規模噪聲數據和合成數據上進行預訓練來最大化Mono-InternVL的視覺能力。

EViP被設計為一個從基本視覺概唸到複雜語義知識的逐步學習過程,包括三個階段:

-

概念學習,用於掌握基本的視覺概念;

-

語義學習,用於捕捉高層次語義知識,例如世界知識;

-

對齊學習,用於將知識與下遊任務對齊。

在視覺預訓練完成後,Mono-InternVL通過指令微調處理複雜的多模態任務。

在前兩個階段中保持預訓練LLM的參數固定,僅訓練視覺部分的嵌入模塊和視覺FFN,而在第三階段和指令微調中逐步放開LLM中的multi-head attention和文本FFN。

得益於這一架構和預訓練策略,Mono-InternVL的視覺可擴展性得到了充分釋放,隨著預訓練數據規模的增加,其下遊性能持續提高。

原生多模態大模型性能大幅提升

作者基於InternLM2-1.8B開發了Mono-InternVL-2B模型,在16個多模態基準上進行了廣泛的實驗。

下圖展示了中英文OCR、問答、圖表解析等任務的可視化樣例,體現了Mono-InternVL的實際效果。

如圖,模型成功識別出了圖中的「盧保物理學獎2024」標題,Hopfield、Hinton等人名,以及瑞典皇家科學院落款等文本。

對於動漫風格的圖片,模型識別出了形狀扭曲的NEC、PANASONIC等品牌名,並提供了細緻生動的圖像描述。

在Grounding任務上,Mono-InternVL可以精準定位照片中的美短的坐標。

對於中文的手寫文本同樣具備不錯的識別能力。

在代碼生成任務上也表現較為出色。

數據上看,實驗結果也表明,1.8B激活參數的Mono-InternVL可以大幅超越此前的7B參數原生多模態模型EVE,平均提升15.5%。

與最先進的模塊化MLLM InternVL-1.5相比,Mono-InternVL在6個多模態基準上表現更優。

通過LMDeploy的部署實驗表明,Mono-InternVL與模塊化模型InternVL-1.5相比,首個token延遲減少了67%,整體吞吐量提高31%。

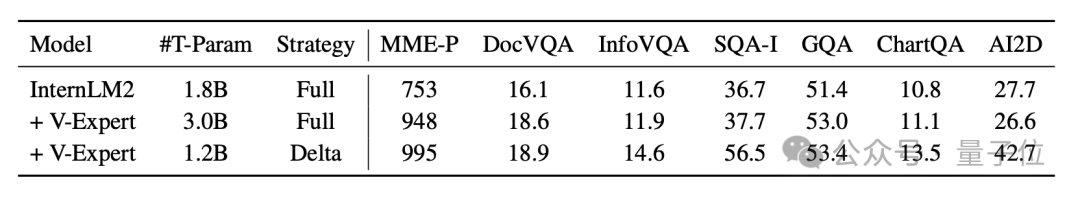

消融實驗結果,也驗證了視覺專家和增量預訓練的有效性。

下遊任務性能與預訓練數據規模的曲線圖表明,在三階段的EViP的幫助下,Mono-InternVL 的能力隨著數據規模增加而不斷提升。

作者可視化了不同層的注意力圖,展示了模型淺層部分所存在的視覺局部性、視覺文本交互較少等問題,為未來原生MLLM 的設計提供啟發。

作者簡介

本文的共同一作為羅根 (上海人工智能實驗室博士後研究員),楊學(上海人工智能實驗室青年研究員),竇文涵(清華大學本科生),王肇凱(上海交通大學&上海人工智能實驗室聯培博士生)。

本文的通訊作者是朱錫洲,他的研究方向是視覺基礎模型和多模態基礎模型,代表作有 Deformable DETR、DCN v2等。

論文地址:

https://arxiv.org/abs/2410.08202

項目主頁:

https://internvl.github.io/blog/2024-10-10-Mono-InternVL/

推理代碼&模型鏈接:

https://huggingface.co/OpenGVLab/Mono-InternVL-2B