突破短影片局限!MMBench 團隊構建中長影片開放問答評測基準,全面評估多模態大模型影片理解能力

新宇 投稿 凹非寺

量子位 | 公眾號 QbitAI

GPT-4o 四月發佈會掀起了影片理解的熱潮,而開源領軍者Qwen2也對影片毫不手軟,在各個影片評測基準上狠狠秀了一把肌肉。

但當前的大部分評測基準仍然具有以下幾個缺陷:

-

多注重於短影片,影片長度或影片鏡頭數不足,難以考察到模型的長時序理解能力;

-

對模型的考察局限在部分較為簡單的任務,更多細粒度的能力未被大部分基準所涉及到;

-

現有的基準仍可以僅憑單幀圖像以獲取較高的分數,說明問題和畫面的時序性關聯不強;

-

對開放性問題的評估仍舊採用較舊的GPT-3.5,打分和人類偏好有較大的偏差且並不準確,容易高估模型性能。

針對這些問題,有沒有對應的基準能夠較好解決這些問題呢?

在最新的NeurIPS D&B 2024中由浙江大學聯合上海人工智能實驗室,上海交通大學和香港中文大學提出的MMBench-Video打造了一個全面的開放性影片理解評測基準,並針對當前主流MLLM構建了開源的影片理解能力評估榜單。

全能力鏈條覆蓋高質量數據集

MMBench-Video這一影片理解評測基準採取全人工標註,歷經一次標註和二次質量核驗,影片種類豐富且質量高,問答涵蓋模型能力全面,準確回答問題需要橫跨時間維度對信息進行提取,更好的考察了模型的時序理解能力。

與其他數據集相比,MMBench-Video具有如下幾個突出特點:

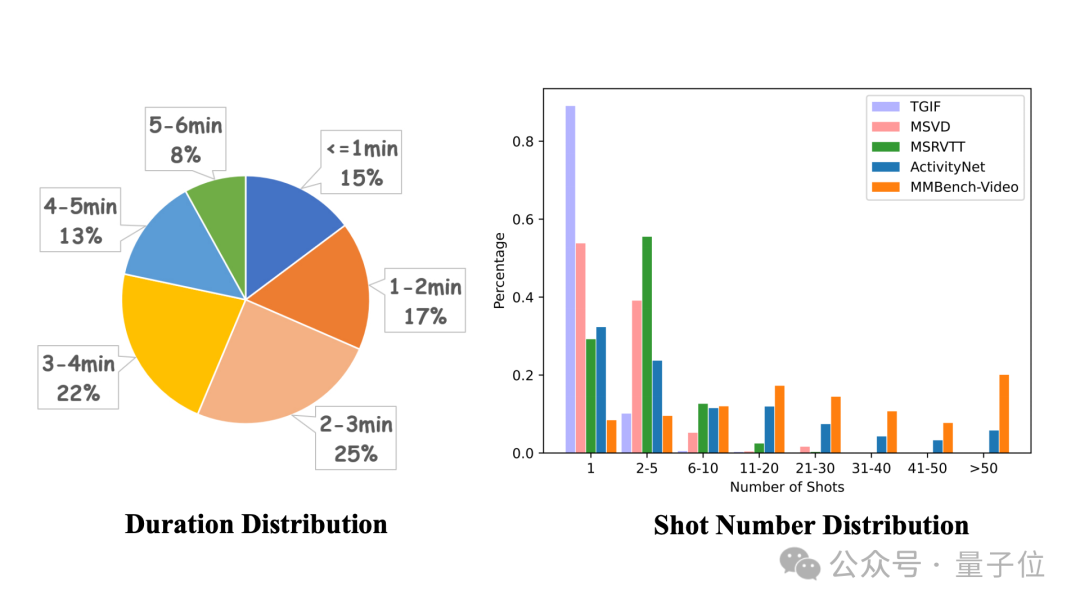

影片時長跨度較廣,鏡頭數多變:採集的影片時長從30秒到6分鐘不等,避免了過短影片語意信息簡單,過長影片評測帶來的資源消耗大等問題。同時影片涵蓋的鏡頭數整體呈長尾分佈,一個影片最多具有210個鏡頭,包含了豐富的場景與語境信息。

全方位能力大考,感知與推理的全面挑戰:模型的影片理解能力主要包含感知和推理兩個部分,每個部分能力可以再額外進行細化。受MMBench啟發並結合影片理解所涉及到的具體能力,研究者建立了一個包含26個細粒度能力的綜合能力譜系,每個細粒度能力都用數十到數百個問答對進行評估,且並不為現有任務的集合。

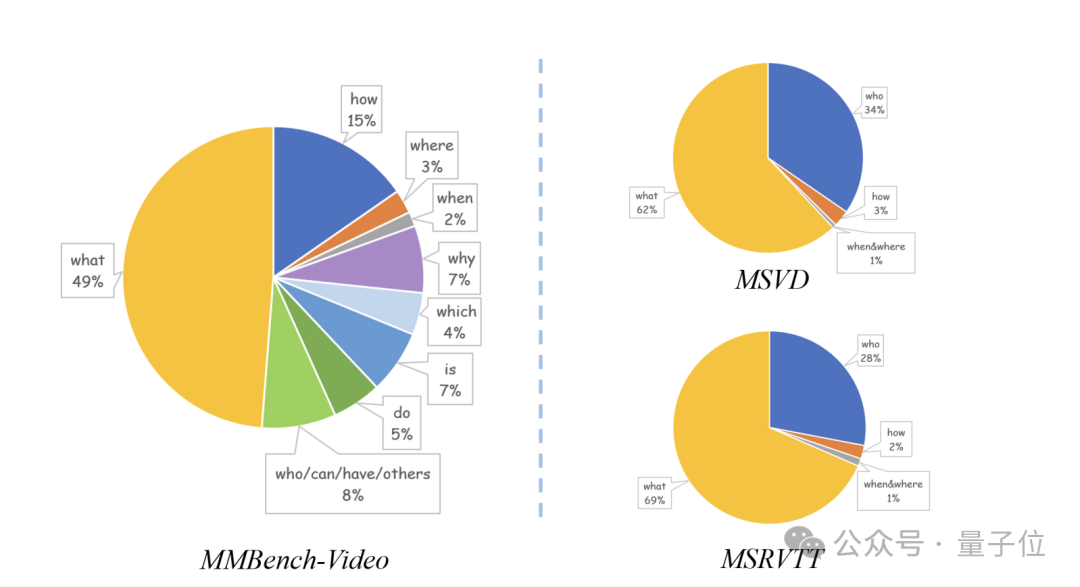

影片種類豐富,問答語言多樣性強:覆蓋了人文、體育、科教、美食、金融等16個主要領域,每個領域影片均佔到5%以上。同時問答對相比傳統VideoQA數據集有了進一步的長度及語意豐富度提升,不局限於’what’’when’等簡單問題類型。

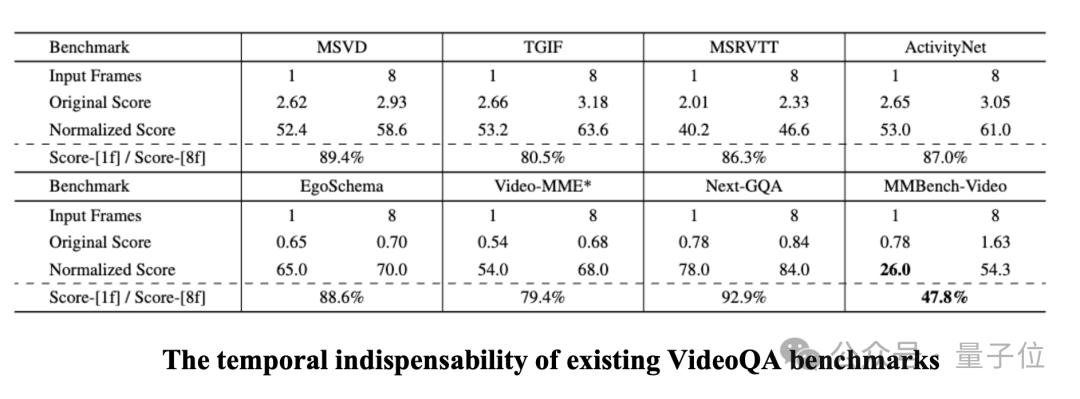

時序獨立性佳,標註質量高:在研究中發現,大部分VideoQA數據集能夠僅通過影片內的1幀獲得充足的信息,從而進行準確的回答。這可能是因為影片內前後畫面變化較小,影片鏡頭少,也可能是因為問答對質量較低。研究者將這一情況稱之為數據集的時序獨立性較差。與他們相比,MMBench-Video由於在標註時給出了詳細的規則限制,且問答對經過二次核驗,具有顯著較低的時序獨立性,能夠更好的考察模型的時序理解能力。

主流多模態大模型成績單

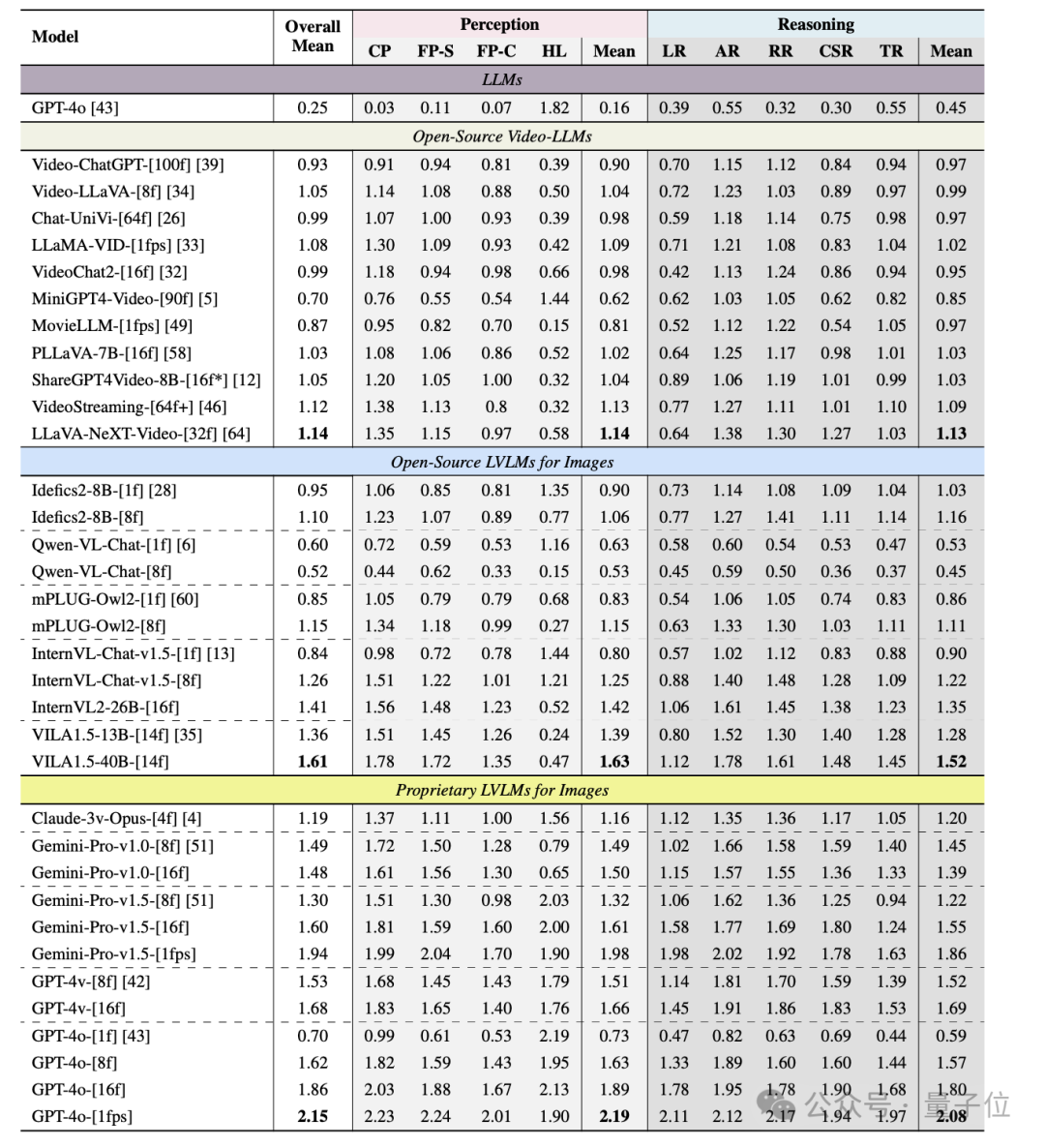

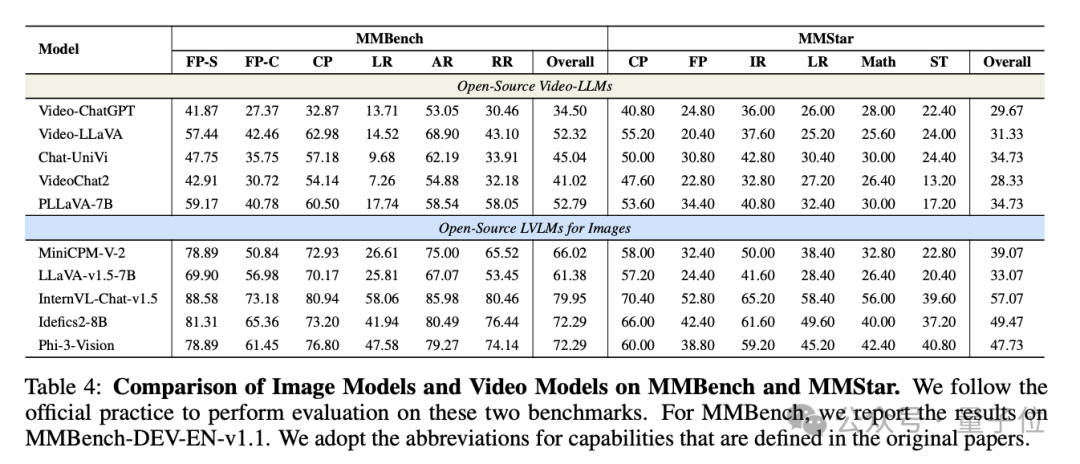

為了更加全面評估多個模型的影片理解性能,MMBench-Video選取了11個代表性的影片語言模型,6個開源圖文多模態大模型及GPT-4o等5個閉源模型進行全面的實驗分析。

在所有模型當中,GPT-4o在影片理解方面表現突出,同時Gemini-Pro-v1.5也展現出了出眾的模型性能。

令人訝異的是,現有的開源圖文多模態大模型在MMBench-Video上表現整體優於經過影片-問答對微調的影片語言模型,最優的圖文模型VILA1.5在整體性能上超出最優的影片模型LLaVA-NeXT-Video近40%。

經過進一步探究發現,圖文模型之所以在影片理解上表現更優,可能歸因於它們在處理靜態視覺信息時的精細化處理能力更強,而影片語言模型在面向靜態圖像的感知及推理性能均有不足,進而面對更複雜的時序推理和動態場景時顯得力不從心。

這種差異揭示了現有影片模型在空間和時間理解上的顯著不足,尤其是在處理長影片內容時,其時序推理能力亟待提升。此外,圖文模型通過多幀輸入在推理上的性能提升表明,它們有潛力進一步拓展至影片理解領域,而影片模型則需要在更廣泛的任務上加強學習,以彌補這一差距。

影片長度和鏡頭數量被認為是影響模型性能的關鍵因素。

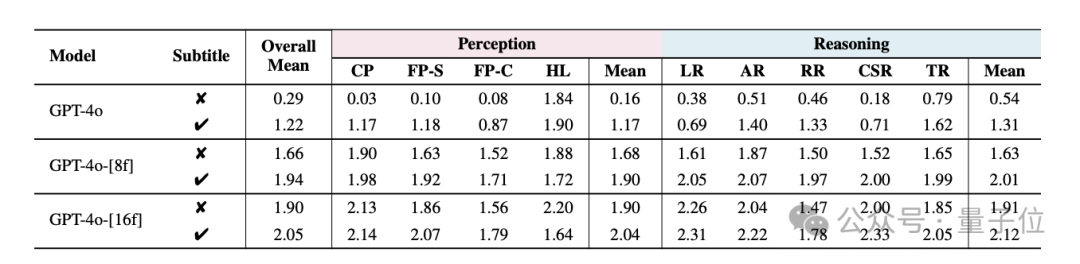

實驗結果表明,隨著影片長度的增加,GPT-4o在多幀輸入下的表現有所下降,而開源模型如InternVL-Chat-v1.5和Video-LLaVA的表現相對穩定。相比影片長度,鏡頭數量對模型性能的影響更為顯著。

當影片鏡頭超過50個時,GPT-4o的性能下降至原始得分的75%。這表明,頻繁的鏡頭切換使得模型更難以理解影片內容,導致其表現下降。

除此之外,MMBench-Video還借助接口獲取到了影片的字幕信息,從而通過文字引入了音頻模態。

在引入後,模型在影片理解上的表現得到了顯著提升,當音頻信號與視覺信號結合時,模型能夠更加準確地回答覆雜問題。這一實驗結果表明,字幕信息的加入能極大豐富模型的上下文理解能力,尤其是在長影片任務中,語音模態的信息密度為模型提供了更多線索,幫助其生成更精確的回答。然而,需要注意的是,雖然語音信息可以提升模型性能,但同時也可能增加生成幻覺內容的風險。

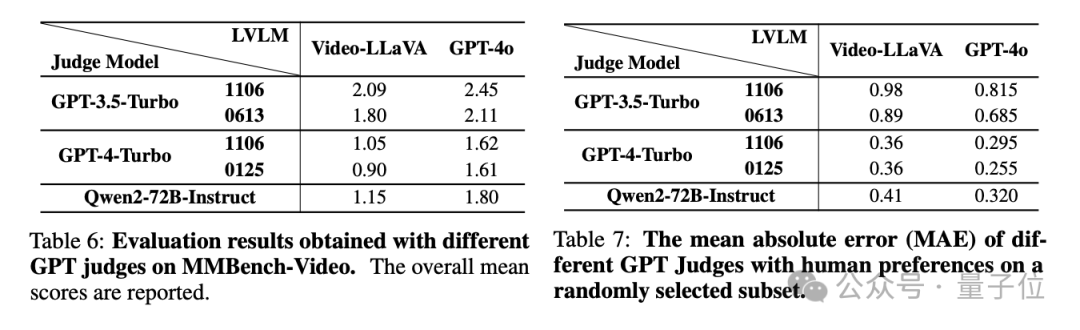

在球證模型選擇方面,實驗顯示GPT-4具備更為公正和穩定的評分能力,其抗操縱性強,評分不偏向於自己的回答,能夠更好地與人工評判對齊。

相比之下,GPT-3.5在評分時容易出現偏高的問題,導致最終結果的失真。與此同時,開源的大語言模型,如Qwen2-72B-Instruct,也展現了出色的評分潛力,其在與人工評判的對齊度上表現突出,證明其有望成為一種高效的評估模型工具。

使用VLMEvalKit一鍵評測

MMBench-Video目前支持在VLMEvalKit中一鍵評測。

VLMEvalKit是一個專為大型視覺語言模型評測設計的開源工具包。它支持在各種基準測試上對大型視覺語言模型進行一鍵評估,無需進行繁重的數據準備工作,使評估過程更加簡便。VLMEvalKit適用於圖文多模態模型及影片多模態模型的評測,支持單對圖文輸入、圖文交錯輸入及影片-文本輸入。它實現70多個基準測試,覆蓋了多種任務,包括但不限於圖像描述、視覺問答、圖像字幕生成等。所支持的模型及評測基準正在不斷更新中。

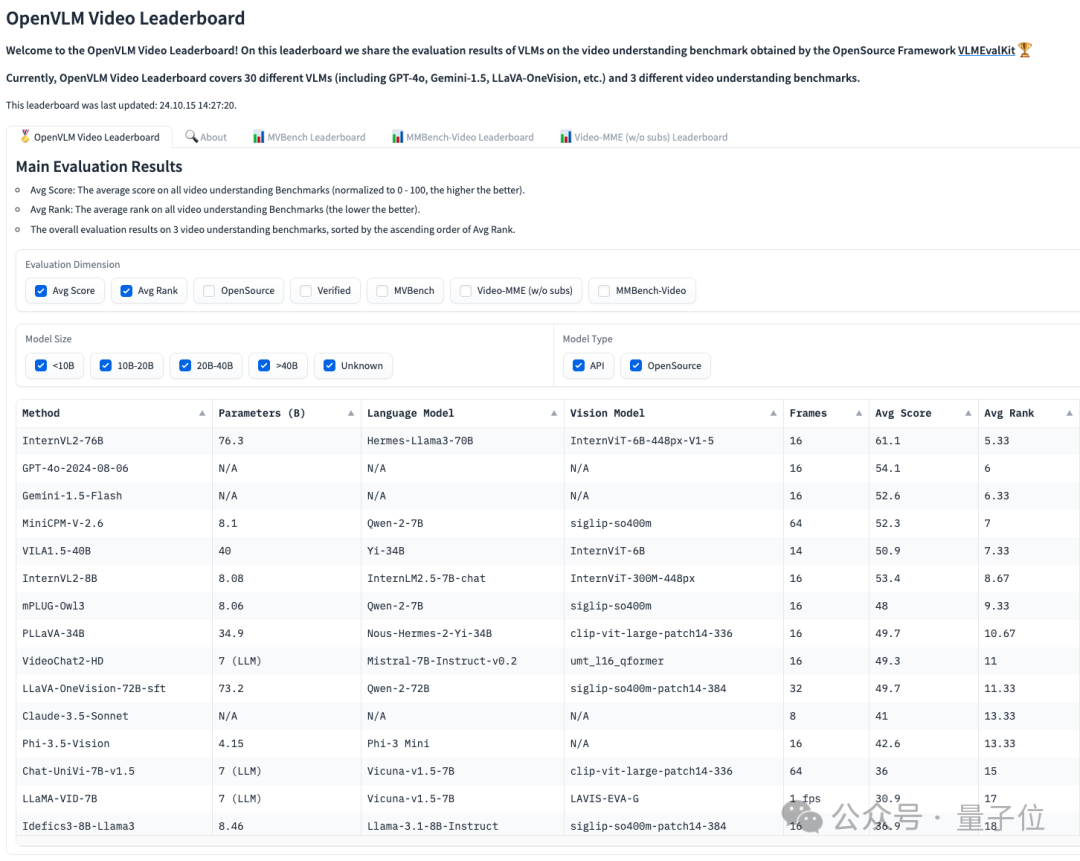

同時基於現有影片多模態模型的評測結果較為分散,難以複現等現實,團隊還建立了OpenVLM Video Leaderboard這一針對模型的綜合影片理解能力評測榜單。OpenCompass VLMEvalKit團隊將持續更新最新多模態大模型及評測benchmark,打造主流,開放,便捷的多模態開源評測體系。

最後總結一下,MMBench-Video是一個針對影片理解任務設計的全新長影片、多鏡頭基準,涵蓋了廣泛的影片內容和細粒度能力評估。

基準測試包含從YouTube收集的600多個長影片,涵蓋新聞、體育等16個主要類別,旨在評估MLLMs的時空推理能力。與傳統的影片問答基準不同,MMBench-Video通過引入長影片和高質量的人工標註問答對,彌補了現有基準在時序理解和複雜任務處理方面的不足。

通過GPT-4評估模型的答案,該基準展現了更高的評估精度和一致性,為影片理解領域的模型改進提供了有力的工具。

MMBench-Video 的推出為研究人員和開發者提供了一個強大的評估工具,幫助開源社區深入理解和優化影片語言模型的能力。

論文鏈接:

https://arxiv.org/abs/2406.14515

Github鏈接:

https://github.com/open-compass/VLMEvalKit

HomePage:

https://mmbench-video.github.io/

MMBench-Video LeaderBoard:

https://huggingface.co/spaces/opencompass/openvlm_video_leaderboard