ChatGPT的AI搜索正式上線,實測後我們發現了這些細節

今天淩晨,OpenAI 正式推出 ChatGPT search 功能。

調用的方式非常簡單,ChatGPT 會根據你的問題選擇搜索網絡,亦或者選擇通過點擊問題框左下角的「網絡」搜索圖標手動選擇搜索。

所有 ChatGPT Plus 和 Team 用戶,以及 SearchGPT 候補名單用戶,今天都可以訪問。Enterprise 和 Edu 用戶將在接下來的幾週內獲得訪問權限。

值得注意的是,該功能將在未來幾個月內向所有免費用戶推出,但預計會有次數限制。

為了縮短我們與答案的距離,現在,我們可以以更自然、對話的方式提出問題,ChatGPT 選擇使用來自網絡的信息來回答。

同時通過後續問題進行更深入的調查,ChatGPT 還會考慮與用戶聊天的完整上下文,以便提供更好的答案。

在信息來源方面,ChatGPT 搜索利用第三方搜索提供商以及 OpenAI 的合作夥伴直接提供的內容來提供用戶正在尋找的信息,比如與一些新聞和數據提供商達成了合作關係。

並且,OpenAI 還為天氣、股票、體育運動、新聞和地圖等不同類別使用新的視覺設計。

搜索能力更新之前,ChatGPT 擁有的知識局限於大模型的訓練數據,僅限於 2021 年至 2023 年之間。

OpenAI 表示,該搜索模型是 GPT-4o 的微調版本,使用新穎的合成數據生成技術進行後訓練,包括從 o1-preview 中提取輸出。

注意,這裏畫個重點——GPT-4o 的微調版本。

那化身為 AI 搜索引擎的 ChatGPT 能幹些什麼呢?我們也試著簡單向 ChatGPT 詢問幾個問題。

2024 年盧保物理學獎和化學獎有什麼共同點?

ChatGPT 給出的答案內容詳實,充滿條理性,還貼心地附上了引用的信息來源。

又或者,我們試著詢問「甄嬛的生日和薛寶釵的生日相差幾天?」

面對中文語境下的問題,顯然 ChatGPT 的表現「有點慌了」,不僅回答表現一般,也有些偏科。

我們試著複現 OpenAI 官方給出的問題示例「what are some great ways to fix up a backyard」。

這回,具體的圖片、引用來源、高質量的回答倒是一應俱全了。

製糖工廠的創新產品也羅列得十分清晰,這一點,值得好評。

既然是 AI 搜索引擎,那自然是要考究時效性方面。

很不錯,身處廣州的我感覺這個回答可以得到滿分,看來以後出門不用看天氣預報,隨手一問就可以了。

當然,如果同一個問題反復問兩遍,根據引用的不同信息來源,我們得到的答案也會有所不同。

而且,股市有風險,投資需謹慎的免責聲明也沒落下。

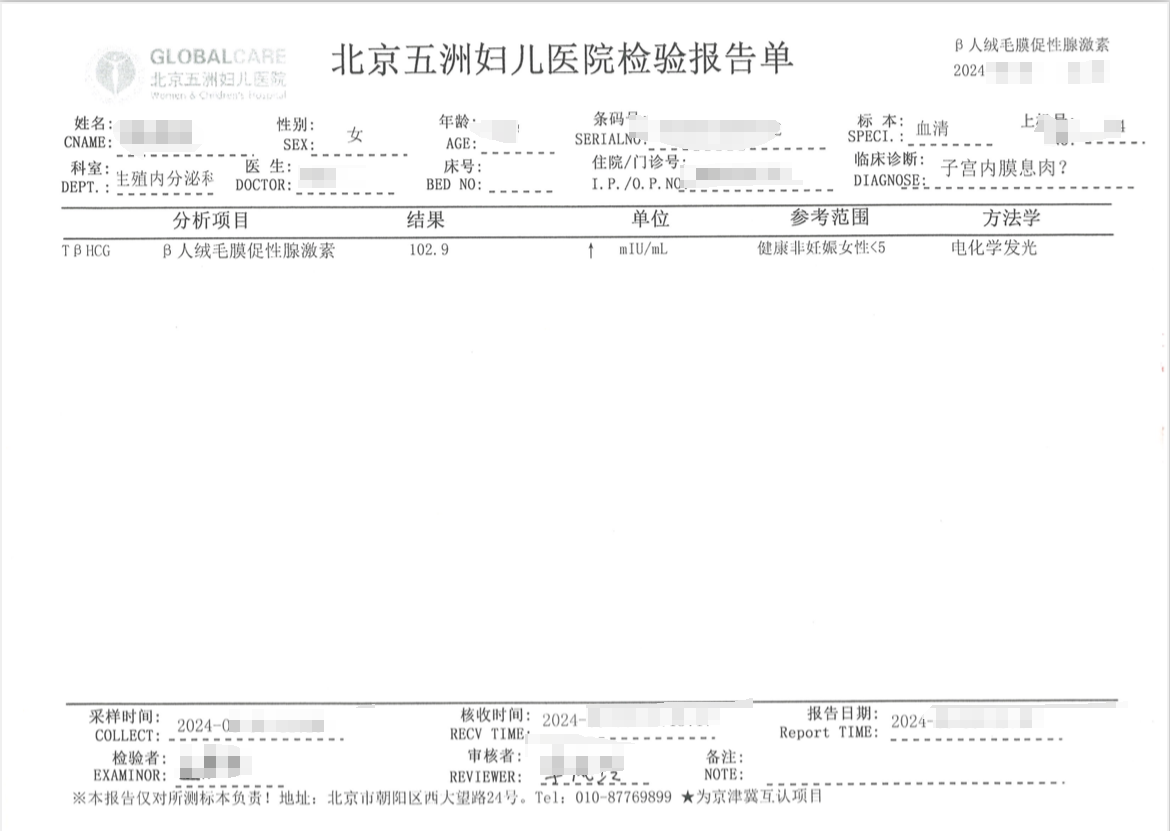

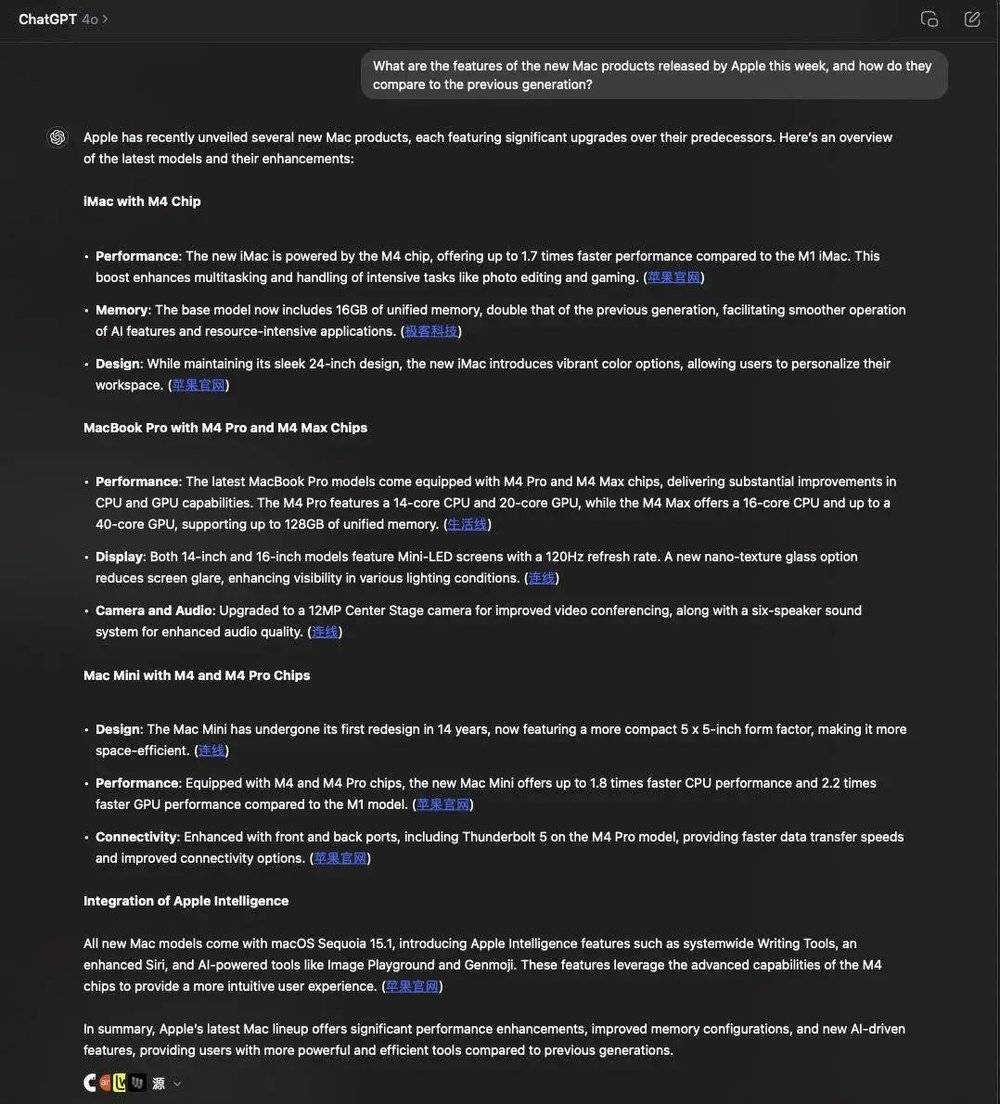

最後,我們也試著在 Mac 桌面端詢問了蘋果本週發佈的新品。這資料的詳細程度以及條理性,四捨五入可以充當導購了。

當然,以上只是簡單實測,可以期待我們後續一手詳細的評測。

根據 Similarweb 的數據, ChatGPT 在 2024 年 9 月達到創紀錄的 31 億次訪問量,同比增長 112%,成為全球訪問量第 11 大的網站。

值得注意的是,這甚至超越了 Bing。要知道,這還是 ChatGPT Search 尚未全量推送的結果。

也許再過幾年,成長起來的 20 後甚至會忘記傳統搜索引擎最初的模樣。

只不過,希望那時或許已經成為 Google 殺手的 ChatGPT 不要重演屠龍者終成惡龍的故事。畢竟 Perplexity 已經開始考慮競價廣告了。

一如 Sam Altman 今天在 X 平台表達的初心:

搜索是我們自 ChatGPT 推出以來,我最喜歡的功能!

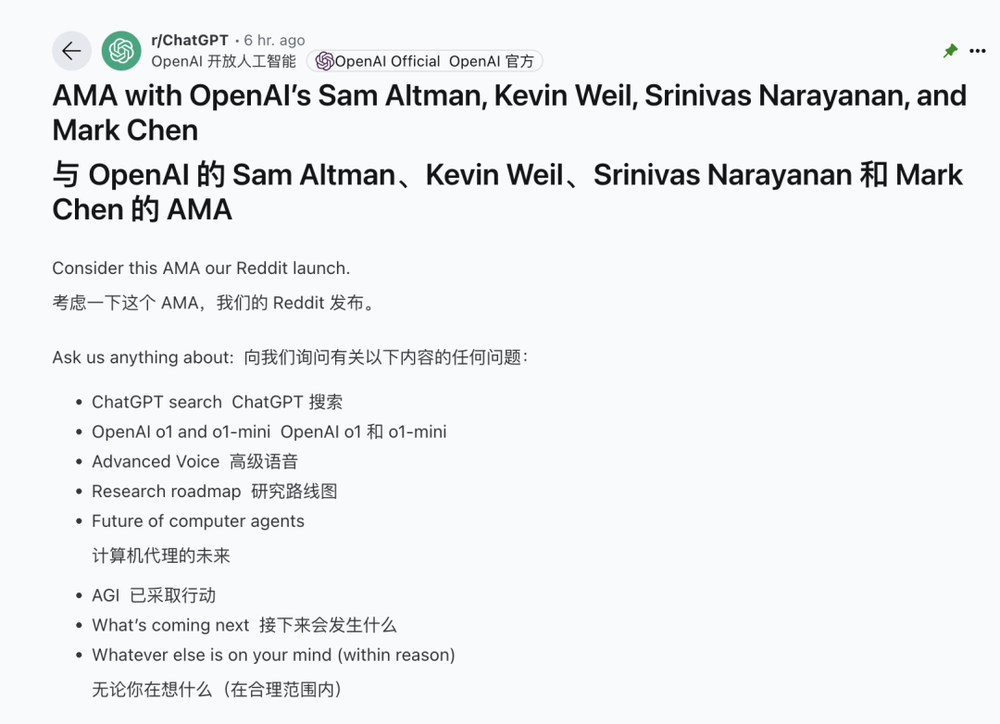

OpenAI 高管化身客服,在線解疑答惑

在發佈 ChatGPT Search 之後,OpenAI 還宣佈在 Reddit 上進行了 AMA 問答。

ChatGPT Search、模型、高級語音模式、未來的研究路線圖等等,只要問題在合理的範圍內,Reddit 用戶都可以提出問題,而參與的 OpenAI 高管也會一一作出回答。

一起來看看,有哪些值得注意的回答吧!

Q:對 2025 年有什麼大膽預測?

Sam Altman:AI 將全面超越所有基準測試。

Q:計劃未來繼續推出o系列的新模型嗎?例如,對 GPT 3、4、4.0、5 等「常規」模型進行改進。是繼續這兩種方式,還是將它們結合起來?

Kevin Weil(OpenAI 首席產品官):兩者都會繼續發展!我預計,在某個階段,它們將會有所融合。

Q:Ilya 看到了什麼?

Sam Altman:Ilya 是一位卓越的遠見者,他比大多數人更能清晰地預見未來。他早期的創見、熱情和願景對我們所取得的成就至關重要。

例如,他是最初探索並積極倡導一些最終演變成 o1 項目的重要想法的關鍵人物之一。這個領域能有他真是太幸運了。

Q:你們什麼時候給我們一個新的文本到圖像模型?Dalle 3 有點過時了。

Sam Altman:下一次更新值得等待!但我們還沒有發佈計劃。

Q:ChatGPT-5 或其類似模型的發佈日期是什麼時候?它將具備哪些特性?

Sam Altman:我們今年晚些時候將推出一些非常出色的產品!不過,我們不會將其命名為 GPT-5。

Q:你好,OpenAI 團隊,謝謝你們舉辦這次 AMA。我想瞭解一下 SearchGPT 與主流搜索引擎相比,有哪些獨特的優勢或關鍵特點,能夠吸引普通搜索引擎用戶選擇使用它?

Sam Altman:對於許多查詢,我發現使用 SearchGPT 能更快、更輕鬆地獲取所需信息。我認為這種優勢在需要進行更複雜研究的查詢中尤為明顯。我也期待未來搜索查詢能夠動態生成定製的網頁作為響應。

Q:你們有沒有計劃增加 ChatGPT 可以存儲的內存?

Kevin Weil:你的意思是更長的上下文窗口嗎?如果是這樣,是的。

Q:對使用 ChatGPT 進行治療的人的看法?

Sam Altman:雖然它顯然不是一名治療師,但很明顯,很多人通過與它討論問題而受益匪淺。我們看到許多初創公司正在積極探索如何在這方面做得更好;我希望有人能創造出卓越的成果!

Q:你好,我想諮詢一下 GPT 4.0 的上下文 token 數量何時會增加。我認為,對於較長的編程或寫作任務來說,32k 的容量與其他 AI 模型相比實在太小了。

Kevin Weil:同意。我們正在努力!

Q:你會用 ChatGPT 來回答這些問題嗎?

Sam Altman:有時,是的。你能說說是哪些問題嗎?

Q:是否有計劃為出版商提供集成服務,以便他們能夠驗證和註冊賬戶,從而查看在 ChatGPT 中的呈現方式?理想情況下,他們能夠看到自己的內容是如何被引用的,以及引用的頻率。

Sam Altman:這是個好主意!我們會談談它。不過,目前沒有計劃。

Q:ChatGPT 的搜索功能在幕後是否仍然使用 Bing 作為其搜索引擎?

A:我們採用了一系列服務,其中 Bing 是一個關鍵的服務。

Q:AGI 可以通過已知硬件實現,還是需要完全不同的東西?

Sam Altman:我們相信,可以通過當前的硬件可以實現

Q:完整的 o1 什麼時候發佈?

Kevin Weil:soon(表情包)

Q:為什麼 o1 不支持圖像輸入?

Kevin Weil:我們優先考慮的是先將產品推向市場,而不是等到它功能完備後再發佈。圖像輸入功能將在 o1 版本中加入,而且 o 系列模型將在未來幾個月內增加多模態、工具使用等新功能。

Q:Sora 的推遲是由於推理所需的計算資源或時間,還是出於安全考慮?

Sam Altman:我們需要優化模型,確保安全性、防止模仿以及其他方面的準確性,並且還需要增加計算能力!

Q:o1將如何影響 scaling law?你們會繼續遵循 scaling law 來增大LLM的規模,還是會因為推理計算時間的考慮,使得更小型的模型、更快速的推理和更長的推理時間成為主要的研究方向?

Kevin Weil:這並非是非此即彼的選擇,而是兩者都要——既要提升基礎模型的性能,也要增加推理時間計算的資源。

Q:作為一名經驗豐富的創始人和與許多人密切合作的人,您如何看待 AI 在創業開發過程中增強創始人的能力?創業將如何因此而改變?

Sam Altman:我對這一點感到非常興奮!如果 AI 能將創始人的生產力提升 10 倍,我們將會看到更多(且更優秀的)初創公司的出現。這在許多方面都比擁有一個 10 人創始團隊更為高效(例如,減少協調上的負擔)。雖然 10 倍生產力的提升目前看來還比較遙遠,但我相信這一天終將到來。AI 帶來的經濟加速,特別是對初創公司而言,將是顯著的。

Q:我們何時可以獲得有關 GPT-4o 圖像和 3D 模型生成的更多信息?

Mark Chen:很快!

Q:AVM 視覺功能何時能夠推出?為什麼 GPT-5 的研發週期如此漫長?o1 的完整版本何時發佈?

Sam Altman:我們正在優先推出 o1 及其後續版本。由於這些模型都變得非常複雜,我們無法像期望的那樣同時推出多個項目。(我們也面臨許多限制和艱難的選擇,關於如何將計算資源分配給眾多優秀的想法。)

目前還沒有確定 AVM 視覺的發佈日期。

本文來自微信公眾號:APPSO,作者:appso