DeepMind新方法:訓練時間減少13倍,算力降低90%

一水 發自 凹非寺

量子位 | 公眾號 QbitAI

大幅節省算力資源,又又又有新解了!!

DeepMind團隊提出了一種新的數據篩選方法JEST——

將AI訓練時間減少13倍,並將算力需求降低90%。

簡單來說,JEST是一種用於聯合選擇最佳數據批次進行訓練的方法。

它就像一個智能的圖書管理員,在一大堆書(數據)中挑選出最適合當前讀者(模型)閱讀的幾本書(數據批次)。

這樣做可以讓讀者更快地學到知識(訓練模型),還能節省時間(減少迭代次數)和精力(減少計算量)。

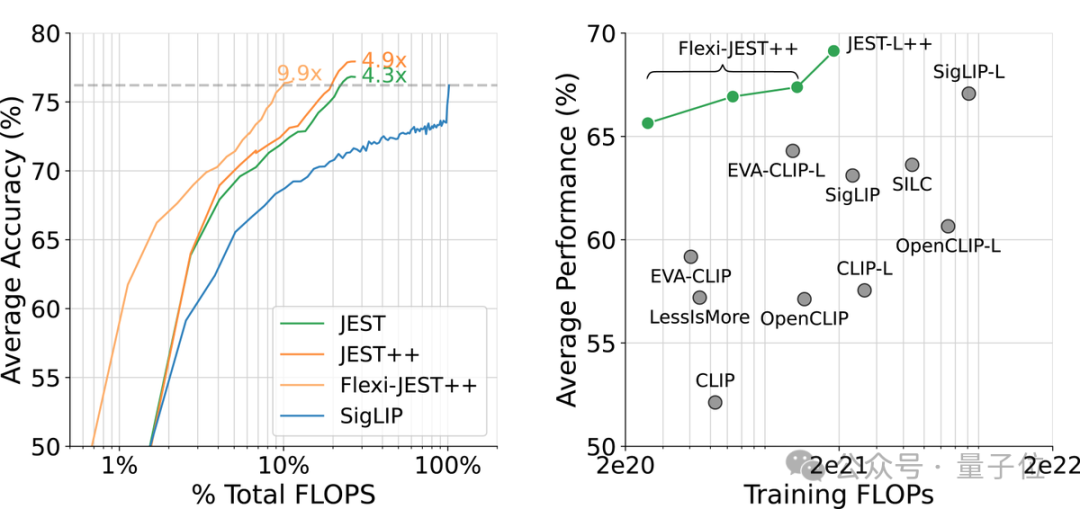

研究顯示,JEST大幅加速了大規模多模態預訓練,與之前的最先進水平(SigLIP)相比,迭代次數和浮點運算次數減少了10倍。

對於上述結果,有網民驚呼:

新研究將成為AI訓練的遊戲規則改變者!

還有人點出了關鍵:

對於擔心人工智能需求過高的電網來說,這可能是個極好的消息!

那麼,新方法究竟是如何運作的?接下來一起看團隊成員相關揭秘。

揭秘新方法JEST

首先,現有的大規模預訓練數據篩選方法速度慢、成本高,並且沒有考慮到批次組成或訓練過程中數據相關性的變化,這限制了多模態學習中的效率提升。

因此,DeepMind團隊研究了聯合選擇數據批次而非單個樣本是否能夠加速多模態學習。

研究得出了3個結論:

-

挑選好的數據批次比單獨挑選數據點更為有效

-

在線模型近似可用於更高效地過濾數據

-

可以引導小型高質量數據集以利用更大的非精選數據集

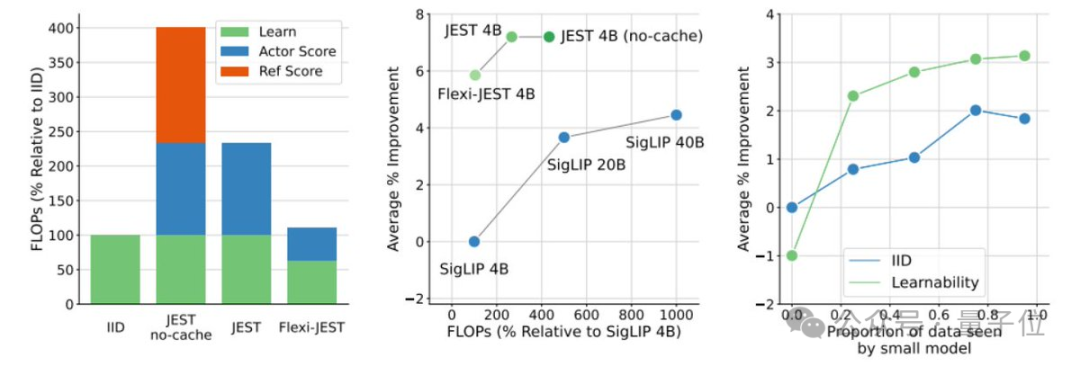

基於上述,JEST能夠在僅使用10%的FLOP預算的情況下超越之前的最先進水平。

這一結果是如何實現的呢?

據團隊介紹,他們在之前的工作中已展示了,對最好的50%數據進行訓練如何顯著提高FLOP效率。

而現在,新研究證明過濾更多數據(高達90%)可以產生更好的性能。

這裏有三個關鍵:

-

選擇好的批次 > 選擇稍微好的數據點

-

調整預設的ADAM超參數

-

非常高質量(但很小)的參考數據集

具體而言,JEST是從一個更大的候選數據集中選擇最佳的訓練數據批次。

在數據選擇標準上,JEST借鑒了之前關於RHO損失的研究,並結合了學習模型和預訓練參考模型的損失來評估數據點的可學習性。JEST選擇那些對於預訓練模型來說較容易,但對於當前學習模型來說較難的數據點,以此提高訓練效率和效果。

成員Nikhil進一步解釋了多模態對比學習的過程,即通過最大化文本和圖像嵌入的對齊性,同時最小化不相關數據之間的對齊性,來提高模型的性能。

利用這一點,團隊採用一種基於阻塞基比斯采樣的迭代方法,逐步構建批次,每次迭代中根據條件可學習性評分選擇新的樣本子集。

與單獨選擇數據相比,新方法在過濾更多數據時持續改進。包括使用僅基於預訓練的參考模型來評分數據也是如此,即CLIPScore,這是離線基礎數據集篩選的流行基線。

不過,過濾更多數據會增加浮點運算次數(FLOPs),因為評分需要學習者和參考模型進行推理傳遞。

對此,團隊在數據集中緩存了預訓練的參考模型分數,他們採用了FlexiViT架構進行低解像度評分,並在多種解像度下進行了訓練。

這一研究證明了:

多解像度訓練對於協調評分和學習者模型至關重要

另外,研究強調了使用高質量的精選數據集來訓練參考模型的重要性,這有助於優化大規模預訓練的數據分佈,從而提升模型的泛化能力。

總而言之,相關變體JEST++和FlexiJEST++的性能顯著優於許多其他先前的SOTA模型,同時使用的計算量更少。

針對大家可能的疑問:

為什麼不只在用於參考模型的精選數據集上進行訓練呢?

團隊預先解釋,相關結果表明精選的參考模型是專家型模型(在某些任務上表現良好)。JEST++利用專家型參考模型,將其轉化為通用模型,在所有基準測試中都取得了改進。

最後,研究發現JEST++最終可以通過消除對預訓練數據集的任何篩選需求來簡化數據管理流程。

通過使用預訓練參考模型,在未經篩選(原始)的網絡規模數據上進行訓練,性能幾乎沒有下降。

來自DeepMind

上述研究由來自DeepMind的4位成員共同完成。

Talfan Evans,至今在DeepMind工作3年多,是機器學習團隊的一名研究科學家,近期研究方向是大規模模型數據訓練和任務對齊。曾就讀於倫敦帝國理工學院戴森機器人實驗室(空間/視覺感知系統中的實時分佈式推理)。

高級研究員Olivier Hénaff,至今在DeepMind工作5年多,專注於瞭解生物和人工智能的基本原理。在DeepMind一直研究自監督算法,近期對視覺表徵如何構建我們的記憶、實現靈活的感知推理和長影片理解感興趣。曾就讀於美國紐約大學神經科學中心博士和法國巴黎綜合理工學院碩士(數學)。

研究科學家Nikhil Parthasarathy,至今在DeepMind工作5年多,負責建立視覺感知模型,研究方向涵蓋表示學習、計算機視覺、計算神經科學和視覺感知。曾就讀於紐約大學博士,史丹福大學本碩。

研究工程師Hamza Merzic,2018年加入DeepMind,研究領域包括主動學習、視覺想像、表徵學習、強化學習、深度學習和機器人技術。他是瑞士聯邦理工學院的碩士生,並在2023年至今期間擔任博士生導師。

目前相關論文已公開,感興趣可以進一步瞭解。

論文:

https://arxiv.org/abs/2406.17711

參考鏈接:

[1]https://x.com/rohanpaul_ai/status/1809792337293566209

[2]https://x.com/olivierhenaff/status/1805995802352910557

[3]https://x.com/nikparth1/status/1806001404294672775

[4]https://x.com/talfanevans/status/1805996146826817726