呼之慾出的OpenAI「草莓」,其實早在1個月前就公開了

世界的問題不在於人們知道得太少,而在於他們知道了太多未經思考的信息。

——馬克·吐溫(Mark Twain)

OpenAI到底在做什麼?GPT-5什麼時候發佈?Sam Altman為什麼會在Twitter上發草莓照片?「草莓」就是下一代模型的代稱麼?

似乎OpenAI的每一步都很神秘,全世界都在猜測他下一步會投出什麼重磅炸彈。但往往越複雜的問題,謎底常會隱藏在謎面上。

實際上,OpenAI的每一步進展,一直都大大方方地寫在它的官網上,無需胡亂猜測,一驚一乍。一手信息,往往都是最準確的。

如果你有在持續關注OpenAI官網,就會發現,早在2024年7月17日,他就已經公開了一篇用弱模型驗證強模型以提高輸出結果可信度和安全性的文章《Prover-Verifier Games improve legibility of language model outputs》,網址:https://openai.com/index/prover-verifier-games-improve-legibility/

這篇文章透露出的關鍵信息有這麼2個:

1、過度優化模型,會導致處理複雜問題的過程難理解,進而增加結果的錯誤率,產生幻覺。

意思是,現在的大模型,參數量越來越大,訓練成本也越來越高,Scaling Law雖然會帶來智能湧現,但也容易導致生成過程的不可控,最終加劇了結果的不確定性,典型的表現之一就是「幻覺」問題,特別是在處理複雜的數學問題時,模型常常會得出錯誤答案。這種現象的關鍵原因在於,模型的推導過程超出了人類的理解和評估能力。

換句話說,如果無節制地增加算力、增加參數,雖然能懟出GPT-5、GPT-6,但它們胡說八道的能力也會越來越強。所以OpenAI才不急著發新模型,而是要先搞掂這個「對齊」問題。

怎麼解決呢?讓大模型訓出一個小模型,用小模型驗證大模型的結果,簡單來講就是:用魔法打敗魔法。

2、可以使用「證明者-驗證者遊戲」(prover-verifier games)框架,驗證輸出的正確性,並增加結果的可讀性。

「證明者-驗證者遊戲」是一種博弈論框架,其中「證明者」的目標是生成一個能通過「驗證者」審查的解答,而「驗證者」的目標則是準確評估這些解答的正確性。在這個框架中,「證明者」代表大模型,而「驗證者」則是計算量差三個數量級的小模型。

遊戲過程分兩個主要部分。第一部分,訓練驗證者來評估由證明者生成的解答是否正確,如果驗證者未能識別出錯誤,則通過增加錯誤解答的訓練樣本來改進驗證者的識別能力。第二部分,訓練證明者生成解答,並根據驗證者的反饋給予獎勵。

在第二部分證明者的訓練中,模型會分別扮演「幫助者」和「狡猾者」兩個角色。「幫助者」儘可能生成正確的解答,如果驗證者給出高評分,則幫助者會獲得獎勵;「狡猾者」則嘗試生成錯誤的解答,如果驗證者被誤導並給予高評分,狡猾者同樣會得到獎勵。

隨著訓練的推進,驗證者逐漸提高了識別錯誤解答的能力,使得狡猾者的策略越來越難以奏效,最終迫使證明者生成更準確且易於驗證的解答。這個過程的核心在於通過驗證者的反饋(評分)來引導證明者生成更優質或更難識別的解答,從而逐步提升模型的能力。這個反饋機制使得證明者必須在生成解答時考慮驗證者的反應,以便獲得更多獎勵。其流程我畫了一張圖,方便你理解:

當成功訓練出一個強大的驗證者時,就可以在無人類監督的情況下,不斷讓大模型輸出結果成為更可信的存在。

再回過頭來看目前泄露出的,有關「草莓」的信息:

- 「草莓」的推出,是為下一代模型做準備。

- 「草莓」的強大之處在於,它能解決之前從未見過的數學問題。

- 「草莓」的出現,是用來生成訓練「獵戶座」(Orion,一個OpenAI正在研發的新旗艦大語言模型)的數據。它試圖在保留大模型性能的同時,簡化操作並降低成本。

- Minion AI 的 CEO、前 GitHub Copilot 首席架構師 Alex Graveley 表示,用「草莓」生成更高質量的訓練數據,可能有助於 OpenAI 減少模型產生的錯誤,也就是所謂的「幻覺」。

我認為很有可能「草莓」就是指這個「驗證者」模型。「草莓」的作用並不是生成數據,而是在易於理解的範圍內儘可能對齊強模型的輸出結果。而這個「強模型」,也許就是未來可能會推出的「獵戶座」(Orion)。

有興趣的朋友,可以去看看這篇論文。也歡迎留言與我交流。

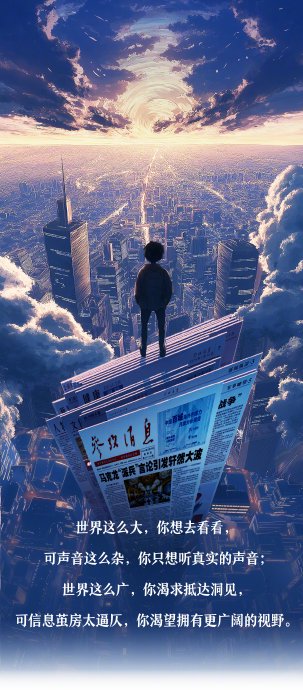

AI時代,保持對一手信源的關注,是擁有獨立判斷力的最優解。

本文來自微信公眾號「互聯網悅讀筆記」,作者:申悅,36氪經授權發佈。