看懂OpenAI o1背後玄機!打破數據瓶頸,AI也能像人一樣思考

今天淩晨,OpenAI發了一個新模型——OpenAI o1系列模型。

對比以往發佈的模型,o1模型可以說相當有特色。用官方的說法,o1代表了現階段AI最強的推理能力,尤其擅長解決數學解題、代碼生成等等複雜推理任務。

OpenAI也很重視這個模型,沒有用GPT繼續給這個模型命名,而是採用了一個新名字:OpenAI o1。

Sam Altman更是將OpenAI o1的發佈比作一個新階段的開始:

可以進行通用複雜推理的AI。

那麼,為什麼AI學會複雜推理這麼重要?o1的發佈,又對AI通往AGI有著什麼樣的意義?

/ 01 /

AI也會慢思考了

與之前發佈的模型相比,o1最大的特點就是推理能力很強。

打個比方,之前大模型更像是文科生,擅長文本類工作,但邏輯推理和複雜計算方面差點意思,遇到奧數題目就歇菜。而o1則更像一個理科生,不僅能推理複雜任務,還能解決科學、編碼和數學領域中比以往更為困難的問題。

o1的邏輯能力有多強?用OpenAI發佈的一組圖,你就明白了。

第一個圖是o1參加AIME 2024的成績。AIME 2024是國際數學奧林匹克競賽(IMO)的資格考試,難度不言而喻。在這個比賽里,o1的準確率是83.3%,而GPT4o的準確率只有13.4%。

第二項是編程競賽,o1的準確率高達89%,而GPT4o準確率只有11.0%。最後一項測試是GPQA Diamond,主要測試的是化學、物理和生物學方面的專業知識。在這個測試里,o1超越了人類專家的表現,成為第一個在這個測試中表現優於博士級別專家的模型。

這些測試結果表明,o1在數學、編程、科學等推理類任務上達到了新高度,甚至在某些任務上已經超過了人類專家的水平。

為什麼o1的推理能力這麼強?這得益於思維鏈的構建。

思維鏈,最早出現在2022年Google發佈論文《Chain-of-Thought Prompting Elicits Reasoning in Large Language Models》中,是大模型提示詞(Prompting)工作的一種。

在o1回答問題前,會產生一個內部的思維鏈,思維鏈會把大模型沒辦法直接回答的複雜問題,分解為一個個簡單的任務各自計算,然後把這些答案拚接在一起進行求解,而不是直接給出計算結果。

對於思維鏈的價值,知乎答主絕密伏擊打過一個很形象的比喻:

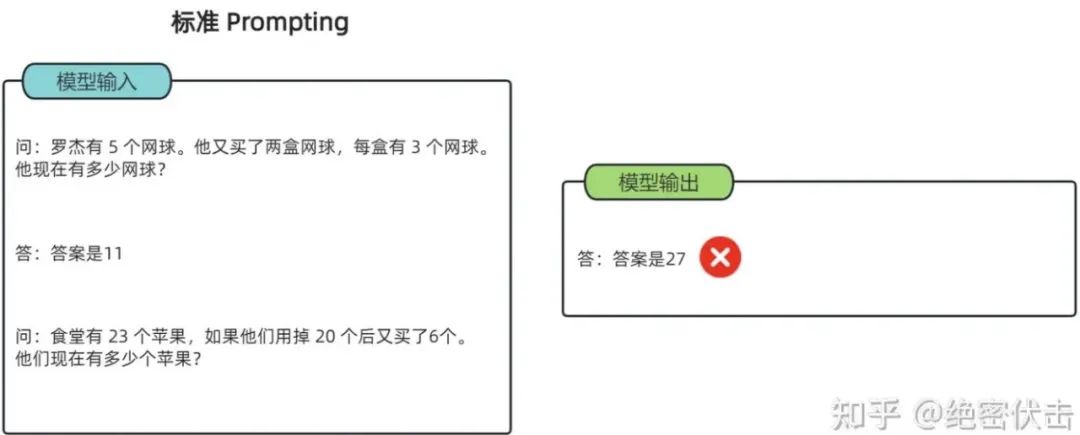

標準 Prompting

給大模型一道數學題,在標準Prompting下,模型無法做出正確的回答。但如果我們給模型一些關於解題的思路,在CoT提示下,它就會像我們數學考試,都會把解題過程寫出來再最終得出答案,比如下圖:

CoT提示

在這個過程中,大模型能夠識別和修正自己的錯誤,不斷改進推理策略。這種思維過程不僅讓它的推理能力得到顯著提升,還讓模型在回答問題時更加可靠。

不過這種思維方式,需要更長的響應時間。理論上,大模型思考的時間越長,推理任務上的表現就越好,可以理解為用時間換取推理深度。

o1的發佈補足了GPT模型在推理方面的缺陷,讓AI更接近人類雙系統的思考方式。

人類大腦在處理信息和做出決策通常有兩種方式:快思考(系統1)和慢思考(系統2)。前者無意識且快速的,它依賴直覺、記憶和經驗迅速作出判斷。後者則有意識的、需要調動注意力的思考方式,它通過分析和解決問題,並作出決定,雖然較慢,但不容易出錯。

這種互補性,也極有可能會出現在GPT和o1上。

GPT系列對應系統1,負責快速、直接決策,依賴於經驗和情感,而o1則對應系統2,複雜較慢的思考和推理,依賴於邏輯和理性分析。

兩種系統協同運作,當系統1快速反應不足以面對複雜情況時,系統2會介入進行更深入的分析,進而讓AI最終能夠讓人一樣思考。

當然,讓AI像人一樣思考,還不是o1唯一的意義。

/ 02 /

智能提升的另一種路徑

在o1發佈後,OpenAI研究員諾姆·布朗(Noam Brown)在X上寫下:

o1模型,意味著一種新的擴展範式。

這是o1發佈的另一個重要意義。大模型將進入了一個新的擴張範式:從模型參數增大,轉向強化學習的探索。

眾所周知,過去一年里,大模型的升級全靠「大力出奇蹟」的方式,也就是說,隨著計算量、模型參數和數據集大小的增加,模型的性能通常會顯著提高。

但現在這條路越來越不好走了。因為在這種訓練模式下,大模型需要大量且優質的訓練數據,但這帶來了兩個問題:

一是隨著訓練需要的數據量越來越大,去哪找這麼多高質量數據是個問題。二是喂了這麼多數據,大模型學習方式本質還是歸納總結,但並沒有真正搞懂事物的邏輯。

舉個例子,大模型發現人渴了,就需要喝水。大模型理解了口渴和喝水之間的關聯性,但它可能沒辦法理解,為什麼人渴了,要喝水。這也是為什麼大模型面對複雜問題時,經常出現邏輯錯誤的原因。

在這種情況下,就需要新的擴張範式來提升大模型的智能能力。於是,強化學習進入了AI大廠的視野。

所謂的強化學習,是讓AI在一個環境里自己探索。在探索過程中會得到很多反饋,這些反饋有好的,也有不好的,AI再根據反饋不斷調整自己的策略和對環境的認知。

這樣的策略以前在AlphaGo身上也用過。為了提高AlphaGo的圍棋水平,研究員讓AlphaGo自己和自己下棋,從而產生大量高水平的棋譜,這有點像金庸武俠小說里老頑童周伯通的左右互搏武功。再通過下棋輸贏(或者平棋)的結果對走棋路徑進行評估。

在後來的AlphaZero訓練里,模型進行了大約500萬局自我對弈,每局大約200步,做好每一步平均需要1600次模擬。這使得總的模擬次數達到了1.6萬億次。大量的高質量合成數據,最終讓AI探索出和人類不一樣的遊戲套路,並戰勝了大部分職業選手。

從本質上說,這個方法是用AI無限的計算能力,來補足它數據利用效率不夠的短板。也就是說,只要擴張推理計算能力,就能實現大模型智能水平的提升。

這更符合當下AI發展的現狀。相比尋找更大規模的優質數據,通過基建實現推理算力的增長是一條更可行的路徑。

如今,有了思維鏈,大模型可以把推理過程中的每一步思考都記錄下來,並進行打分,再根據評分高低反饋給模型進行調整。在這個過程中,大模型不僅能學到如何給出正確答案,還能舉一反三獲得更多的數據反饋,進而提升其智能水平。

當然,作為剛剛發佈的新模型,o1仍然有很多的缺陷。但在GPT5遙遙無期的情況下,這至少給行業帶來了新的思路。至於這條路線究竟是否會將我們帶向AGI,我們可以拭目以待。

文/林白