AI大模型擊碎陰謀論,登上Science封面,用聊天戳破謠言漏洞

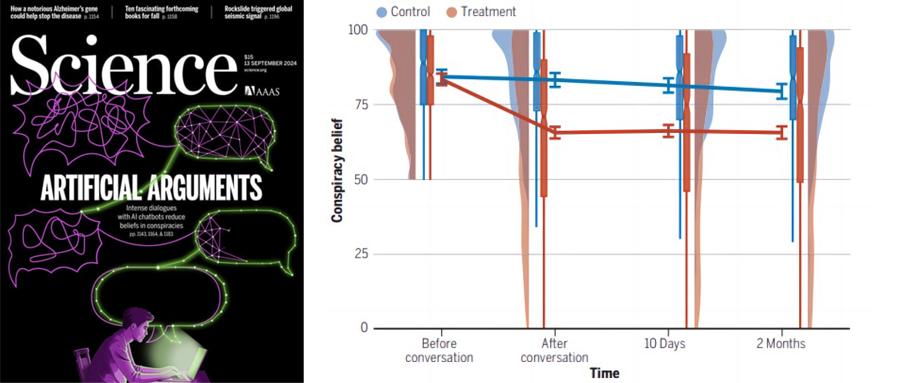

智東西9月15日消息,AI聊天機器人在破除陰謀論上取得重要突破,能有效削弱一些信眾對陰謀論的篤信程度,論文登上9月13日的國際頂級學術期刊Science封面。

很多人對陰謀論深信不疑,致使一些荒謬謠言層出不窮。麻省理工學院研究團隊發現,GPT-4 Turbo模型可以在對話中通過量身定製的呈列證據、個性化的深度聊天,將一些陰謀論者對陰謀論的信任度平均降低20%,且效果持續了至少2個月。這種干預說明了負責任地部署生成式AI有助於闢謠和緩解衝突。

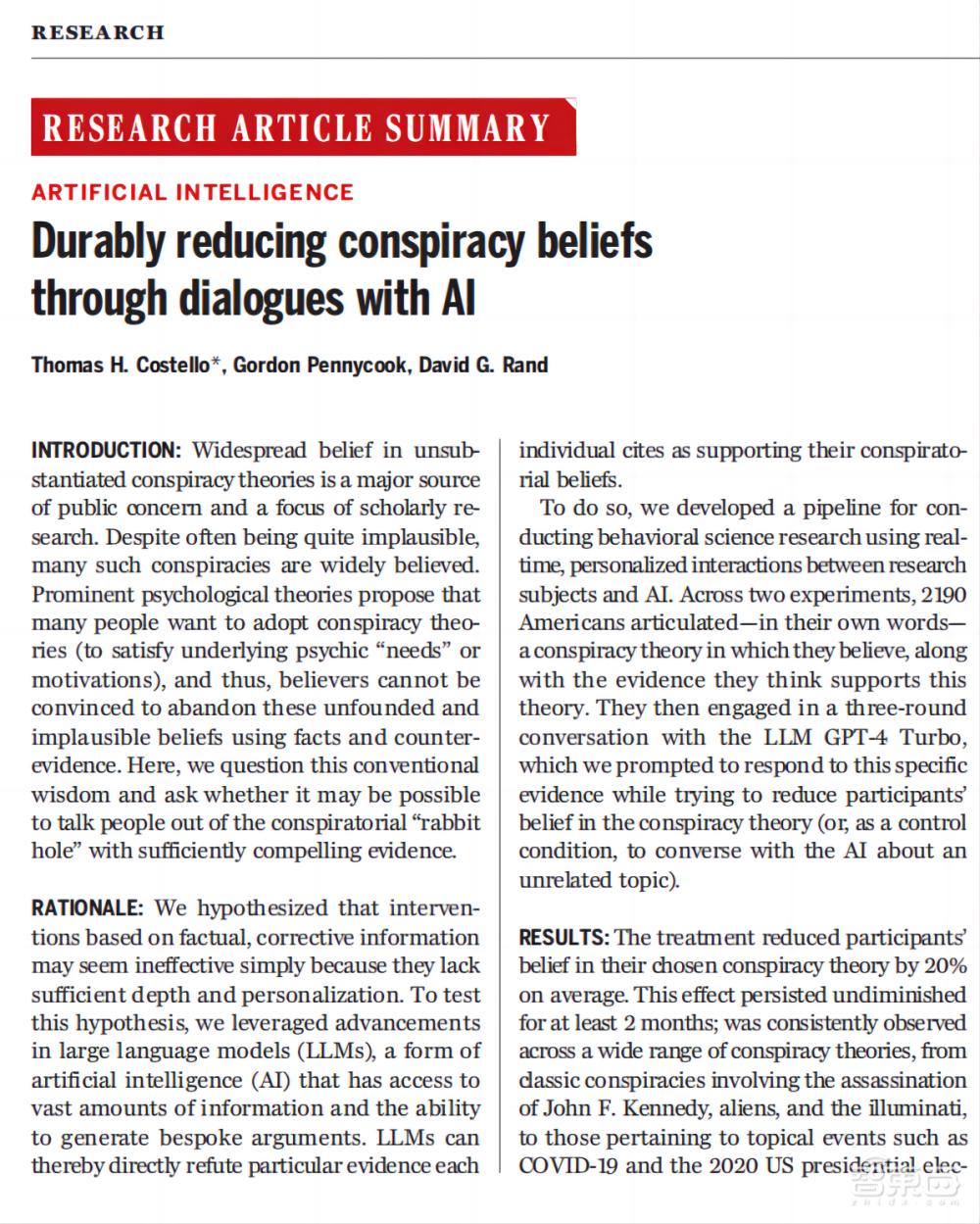

論文題目為《通過與AI對話持續減少相信陰謀論(Durably reducing conspiracy beliefs through dialogues with AI)》。

▲論文內容截圖(圖源:Science)

▲論文內容截圖(圖源:Science)論文鏈接:https://www.science.org/doi/10.1126/science.adq1814

一、足夠有力的證據是否能說服人們放棄陰謀論?

無論是關於月球登陸從未發生過的錯誤觀念,還是關於新冠疫苗含有微芯片的虛假說法,陰謀論比比皆是,有時甚至會產生危險的後果。對未經證實的陰謀論的信任是大眾關注的重要議題,也是學術研究的焦點。

儘管這些陰謀論往往非常不可信,但仍有許多人選擇相信。著名的心理學理論認為,許多人想要採用陰謀論以滿足潛在的心理「需求」或動機,因此他們很難被事實和反證據說服,來放棄這些毫無根據的陰謀論。這篇論文對這一傳統觀點提出質疑。是否有可能用足夠有力的證據說服人們走出陰謀論的 「無底洞」。

「傳統觀點會告訴你,那些相信陰謀論的人很少會改變他們的想法,哪怕是根據證據。」論文的第一作者湯馬斯·科斯特洛(Thomas H. Costello)說。然而,這項新研究提供了不同的觀點。「我們的研究結果從根本上挑戰了這種觀點:一旦掉入無底洞相信陰謀論,證據和論點就幾乎沒有用處了。」研究團隊寫道。

二、與GPT-4 Turbo進行3輪對話,用證據駁斥陰謀論觀點

研究假設,基於事實性、糾正性信息的論據可能會顯得無效,因為它們缺乏足夠的深度和個性化。為了驗證這一假設,研究人員利用了大語言模型的進步,這是一種AI,能夠獲取大量信息並生成定製論據。因此,大語言模型可以產生具有批判性思維的對話,直接反駁每個人所引用的支持其相信陰謀論的特定證據。

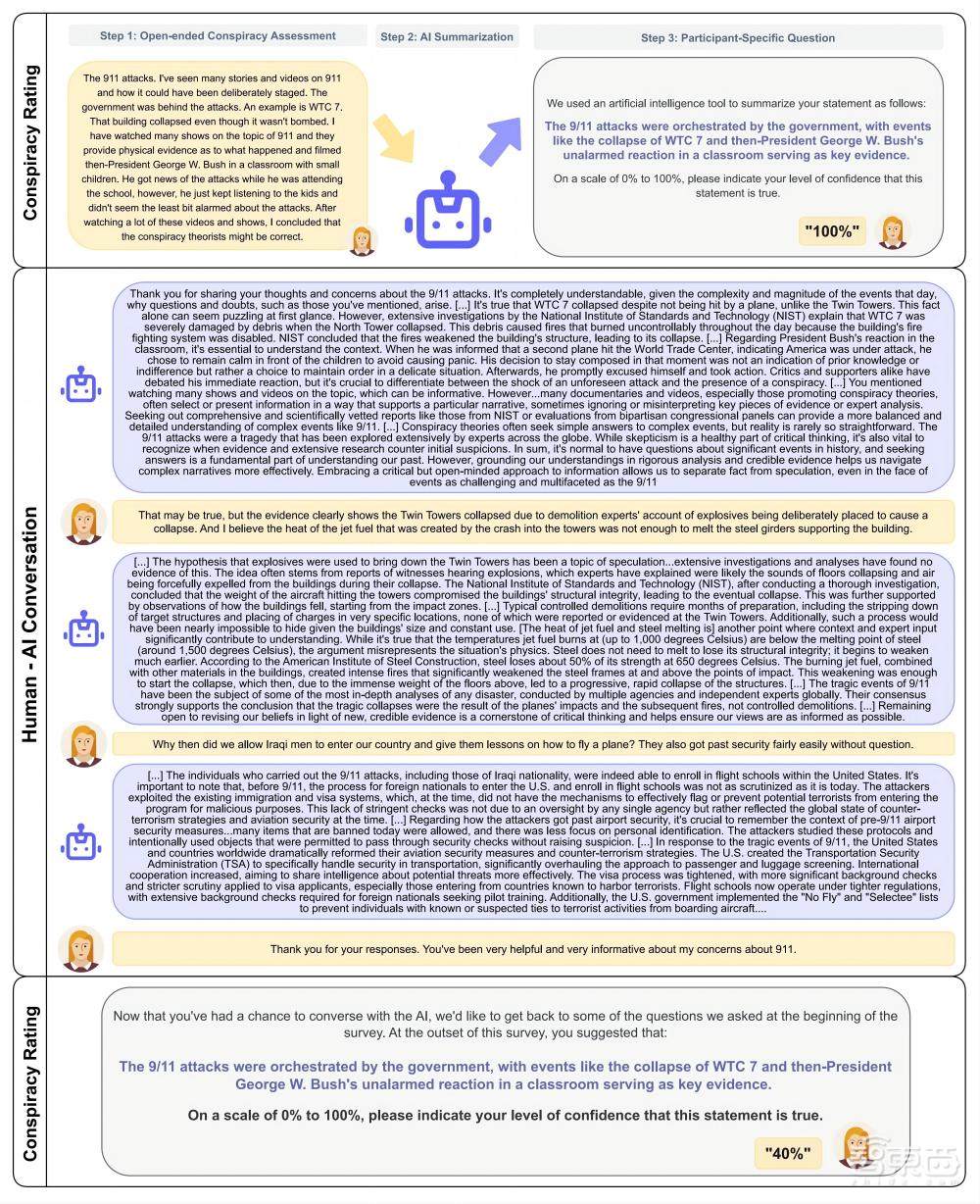

在兩次實驗中,2190位參與者用自己的話闡述他們所相信的陰謀論,以及他們認為支持這一理論的證據。這些信息被輸入到AI系統中。參與者還被要求以100分的標準來評估他們所相信的陰謀論的真實程度。

然後,他們與大語言模型GPT-4 Turbo進行了三輪對話,在我們的提示下,GPT-4 Turbo回應了這些具體證據,同時試圖降低參與者對陰謀論的信任度。或者作為對照條件,與AI就不相關的話題進行對話。對話結束之後,再次評估參與者他們認為陰謀論的真實性。

▲參與者與AI對話的設計和流程,一共進行三輪對話。上圖展示一名參與者與AI對話後,其對陰謀論的信任度降低了60%。(圖源:Science)

三、參與者對陰謀論的信任度平均降低20%,效果持續兩個月

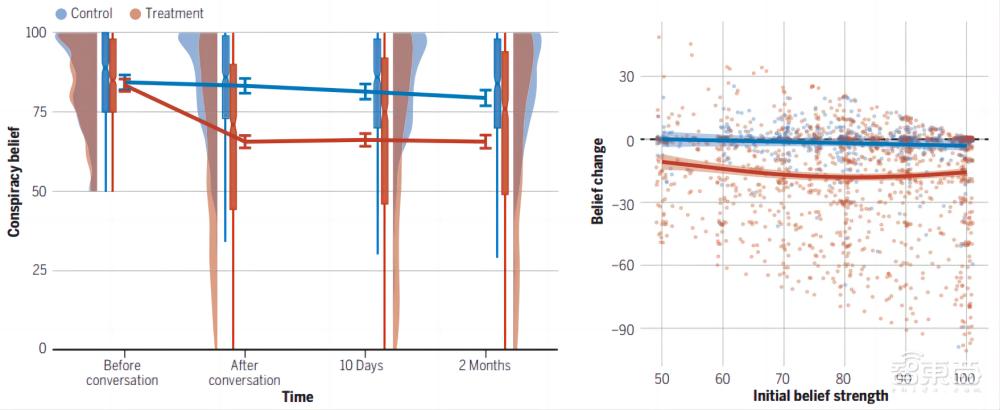

研究結果顯示,與AI討論陰謀論的參與者對所選陰謀論的信任度平均降低了20%。這種效果持續了至少2個月,絲毫未減。而那些討論非陰謀論話題的人對真實性的評分只略有下降。

研究團隊談道,在各種陰謀論中,都能持續觀察到這種效果,包括涉及暗殺甘迺迪、外星人和光明會的經典陰謀論,到與COVID-19和2020年美國總統大選等熱點事件相關的陰謀論。值得注意的是,AI並沒有減少參與者對真實陰謀論的信任度。

▲與AI對話能持久降低陰謀論可信度,即使是堅定的陰謀論者也不例外。對話後參與者對所選陰謀論的平均信任度降低,效果持續兩個月。(圖源:Science)

研究人員補充說,效果的大小取決於多種因素,包括陰謀論對參與者的重要性以及他們對AI的信任程度。

「有大約四分之一的參與者,在實驗開始時相信陰謀論,但在結束時不再相信。」科斯特洛說。

「在大多數情況下,AI只能逐漸削弱——使人們變得更加懷疑和不確定——但少數人完全擺脫了他們的陰謀論信任度。」

研究人員補充說,降低參與者對一個陰謀論的信任,也能在一定程度上降低他對其他陰謀論的信任。陰謀論世界觀普遍減少,並增加了反駁其他陰謀論者的意圖。這種方法在現實世界中可能有應用——例如,AI可以回覆社交媒體上陰謀論相關的帖子。

此外,一個專業人員評估了AI提出的128個樣本,其中99.2%是正確的,0.8%是有誤導性的,無一虛假。

結語:專家質疑AI說服陰謀論者的實際應用

研究說明,陰謀論的「無底洞」可能確實有一個出口。心理需求和動機本質上並不會導致陰謀論者對證據視而不見——他們只是需要正確的證據。實際上,通過展示大語言模型的說服力,該研究既強調了生成式AI在負責任地使用時可能產生的積極影響,也強調了最大限度地減少不負責任地使用這項技術的緊迫性。

未參與該工作的劍橋大學教授辛特爾·範·德林登(Sander van der Linden)質疑人們是否會在現實世界中自願與這樣的AI互動。

他還談道,目前尚不清楚如果參與者與匿名人類聊天是否會得到類似的結果,同時也有關於AI如何說服陰謀論者的問題,因為該系統還使用了諸如同情和肯定等策略。

但是,他補充說:「總的來說,這是一個非常新穎且可能重要的發現,也是AI如何被用來打擊錯誤信息的一個很好的例證。」

來源:Science、《衛報》