Qwen 2.5 開源,API 打一折

長話短說

就在剛剛,Qwen 開源了其最新版本模型 Qwen2.5 全家桶:

-

Qwen2.5: 0.5B、1.5B、3B、7B、14B、32B 和 72B

-

Qwen2.5-Coder:1.5B、7B 和 32B(即將發佈)

-

Qwen2.5-Math:1.5B、7B 和 72B。

Qwen API 大降價,低至 1 折(Qwen Turbo 的輸出)

進一步的

在線體驗

https://huggingface.co/spaces/Qwen/Qwen2.5

相關報告

https://qwenlm.github.io/zh/blog/qwen2.5/

開源協議

除 3B 和 72B 外,均通過 Apache 2.0 協議進行開源

API 大幅降價

Qwen-VL-Max(對比 Qwen-Max)

原價格(每千 token)

輸入 0.04 元,輸出 0.12 元

現價格(每千 token)

輸入 0.02 元,輸出 0.02 元

Qwen-Plus

原價格(每千 token)

輸入 0.004 元,輸出 0.012 元

現價格(每千 token)

輸入 0.0008 元,輸出 0.002 元

Qwen-Turbo

原價格(每千 token)

輸入 0.002 元,輸出 0.006 元

現價格(每千 token)

輸入 0.003 元,輸出 0.0006 元

性能大為提升(來自官方)

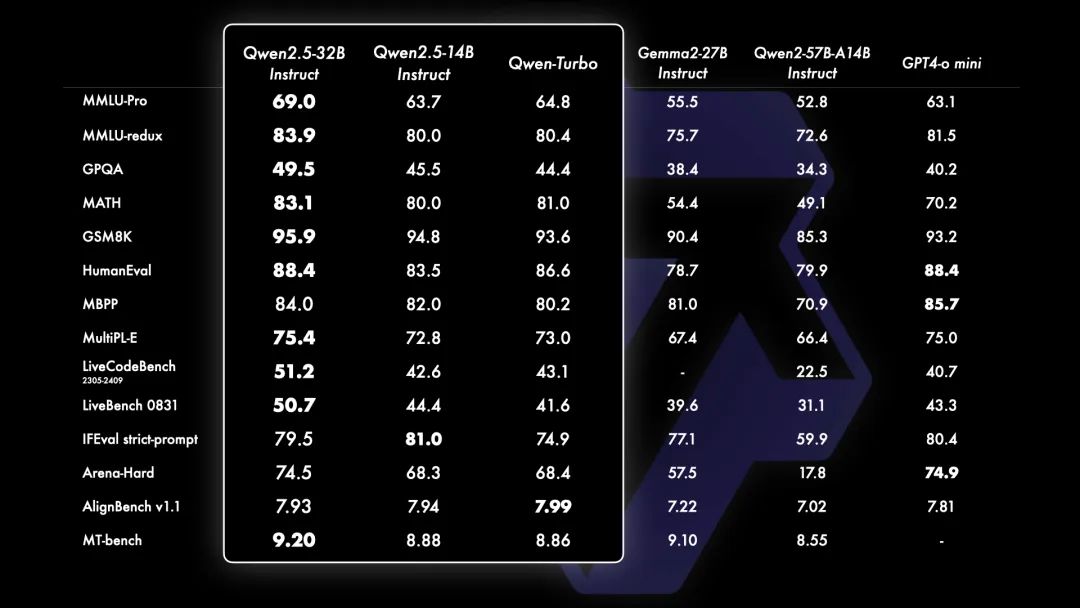

Qwen2.5

在開源模型中,最大杯的 Qwen2.5-72B,在參數中超過眾多開源模型

在 API 中,從參數上看,Qwen-Plus 顯著優於 DeepSeek-V2.5,並且在與 Llama-3.1-405B 的競爭中表現出了競爭力,儘管在某些方面仍不及 GPT4-o 和 Claude-3.5-Sonnet。

對於開源的 Qwen2.5-14B 和 Qwen2.5-32B,在同等量級的模型中,頗具競爭力,如 Phi-3.5-MoE-Instruct 和 Gemma2-27B-IT。

基於 API 的 Qwen2.5-Turbo 的性能極具競爭力,同時提供了成本效益高且快速的服務。

對於小模型 Qwen2.5-3B,僅憑約 3B 參數便實現了 Llama-3 8B 的性能。

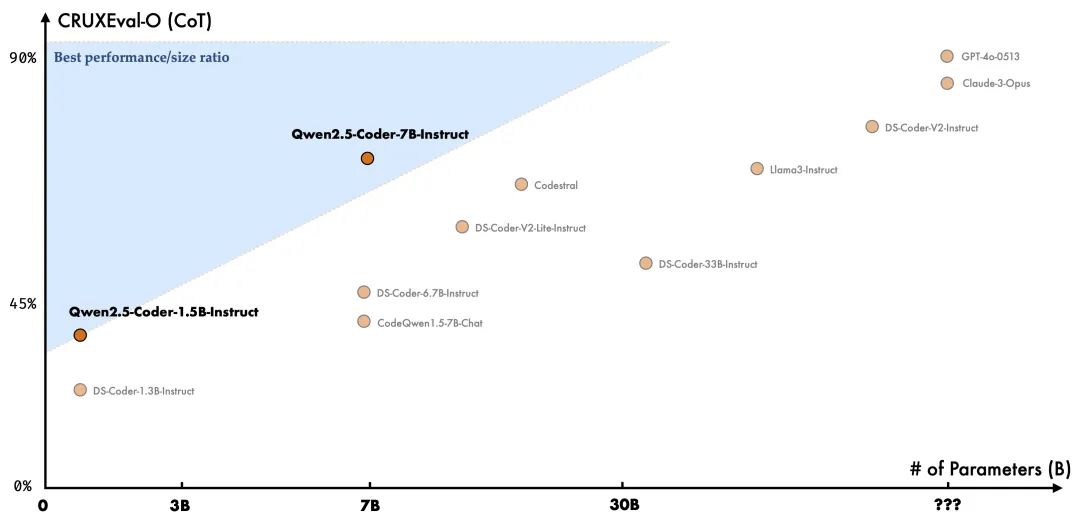

Qwen2.5-Coder

Qwen2.5-Coder 是為編程特別設計的模型,基準測試數據如下:

Qwen2.5-Coder: Base Models

Qwen2.5-Coder 最多 128K tokens 上下文,支持 92 種編程語言。

本次開源的 7B 版本 Qwen2.5-Coder,甚至打敗了更大尺寸的 DeepSeek-Coder-V2-Lite 和 Codestral-20B,成為當前最強大的基礎代碼模型之一。

Qwen2.5-Coder-Instruct

Qwen2.5-Coder-Instruct 是 Qwen2.5-Coder 的指令微調版,在更多的評估中體現出了卓越的泛化性。

特別的,Qwen2.5-Coder-Instruct 在幾個方面表現非常突出:

-

多語言編程能力很強

-

代碼推理能力出色

3. 數學能力和基礎能力都很強

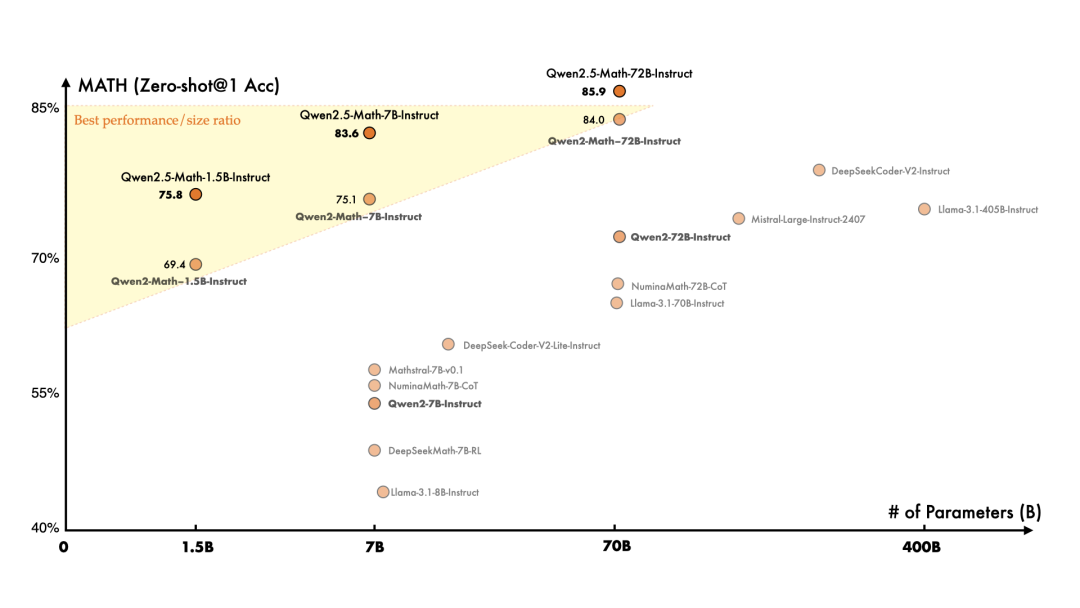

Qwen2.5-Math

比以往模型,Qwen2.5-Math 在更大規模的數學相關數據上進行了預訓練,包括由 Qwen2-Math 生成的合成數據。此外,這一次我們增加了對中文的支持,並通過賦予其進行 CoT(Chain of Thought)、PoT(Program of Thought)和 TIR(Tool-Integrated Reasoning)的能力來加強其推理能力。

Qwen2.5-Math-72B-Instruct 的整體性能超越了 Qwen2-Math-72B-Instruct 和 GPT4-o,甚至是非常小的專業模型如 Qwen2.5-Math-1.5B-Instruct 也能在與大型語言模型的競爭中取得高度競爭力的表現。