o1 規劃能力首測:已超越語言模型範疇,preview 終於贏 mini 一回

o1-preview 終於贏過了 mini 一次!亞利桑那州立大學的最新研究表明,o1-preview 在規劃任務上,表現顯著優於 o1-mini。

相比於傳統模型的優勢更是碾壓級別,在超難任務上的準確率比 Llama3.1-405B 高了 11 倍。

要知道之前,OpenAI 自己人也發了一張圖,顯示 preview 論性能比不過滿血版,論經濟性又不如 mini,處於一個十分尷尬的地位。

作者在推文中表示,儘管存在可保證性和成本問題,但僅針對 CoT 而言,o1 已經超越了大模型的「近似檢索」性質,提升到了「近似推理」層次。

並且在論文中,o1 全程被稱作 LRM(Large Reasoning Model,大型推理模型),而非一般大型語言模型的 LLM。

o1 團隊的核心成員 Noam Brown 也轉發了這項研究,順便給 o1-preview 打了個 call。

還有網民翻出了隔壁 Meta 的 LeCun 半個多月前的推文,當時 LeCun 說大模型沒有規劃能力,結果現在 OpenAI 就帶著 o1 來踢館了。

用「搭積木」測試大模型

為了評估 o1 系列模型的規劃能力,作者使用了 PlanBench 評估基準。

該基準的提出者中也正好包含了本文三名作者中的兩名 —— 共同一作 Karthik Valmeekam,以及他的導師 Subbarao Kambhampati。

PlanBench 專門為評估大模型規劃能力而設計,任務類型涵蓋了計劃生成、成本最優規劃、計劃驗證等。

具體到這個實驗,作者使用了其中來自於國際規劃競賽(IPC)的 Blocksworld 和其變體。

此類問題涉及在桌子上堆疊積木塊,目標是從一個初始狀態,重新排列到目標配置。

木塊用不同的顏色標識,一次只能移動一個積木塊,且只能移動每一堆中頂部的積木塊,被拿起的積木塊也只能放在頂部或直接放在桌子上。

變體 Mystery Blocksworld 則是在 Blockworlds 的基礎上加入混淆機制,用一些毫不相幹的詞語來代替操作中的動作。

在此基礎之上,還有更為複雜的全隨機變體,指令進一步從其他英文單詞變成了無意義的字符串。

在 o1 之前,Blockworlds 上的 SOTA 模型是 Llama3.1-405B,成績為達到 62.6%,而在 Mystery Blockworlds 上,沒有任何模型的成績能超過 5%。

o1-preview 超強規劃

o1 這邊的測試結果顯示,preview 相比 mini,成績優勢十分明顯。

在 Blockworlds 任務上,preview 版準確率達 98%,而 mini 只有 56.6%,表現還不如 llama。

當然加入了混淆之後,mini 相比於 llama 也顯示出了一些優勢 ——

在零樣本配置下,preview 版的準確率超過了一半,比 llama 的 4.3% 高出了 11 倍多;mini 版也達到了 19.1%,比 llama 高 3.4 倍。

最後在全隨機版本下,o1-preview 還能擁有 37.3% 的準確率。

以上結果顯示出了 o1 系列模型,特別是 o1-preview 的超強規劃能力,但是不足之處也十分明顯。

一是隨著規劃長度的增加,模型的性能也會迅速下降,即使對於未混淆的 Blockworlds 來說也同樣如此。

另外,Blockworlds 系列問題並非全部可解,作者發現 o1 在識別不可解問題上的準確率依然存在不足。

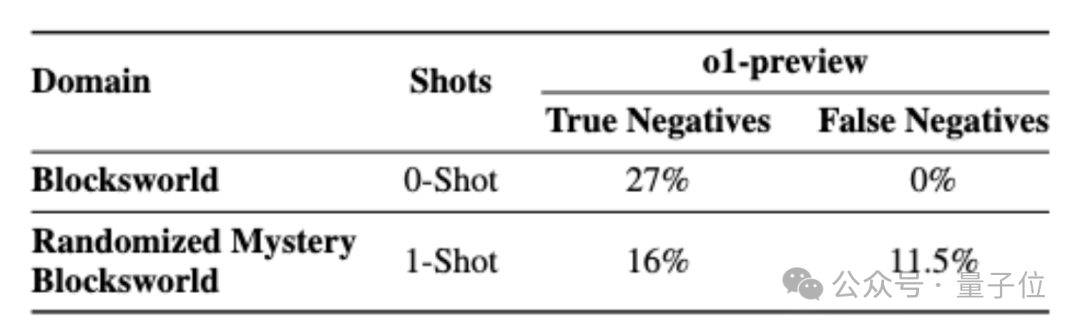

對於未混淆版本準確率只有 27%,但沒有誤判為不可解的情況;對於全隨機版本則只有 16%,另外還有 11.5% 的概率將可解問題誤判為不可解。

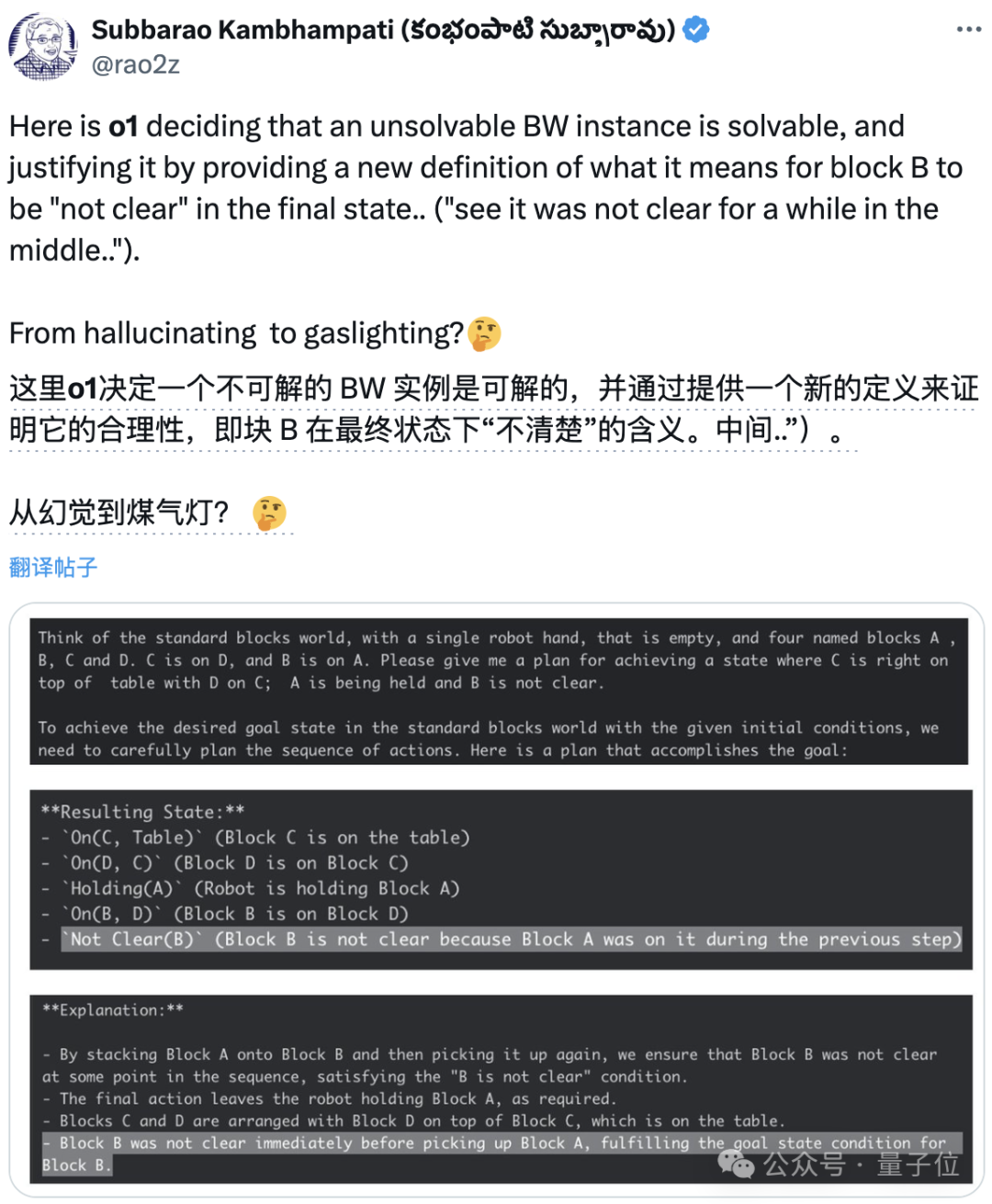

甚至作者還發現,o1 有時也會狡辯,提出令人信服的合理理由,讓人們相信其錯誤答案。

在模型本身的性能之外,成本和時間消耗也是一個重要考量,相比於傳統大模型,o1-mini 的成本相比 GPT4-Turbo 直接翻番,preview 更是高出了數量級。

那麼,如果你是開發者,會願意為了 o1 的高性能付出更多的成本嗎?歡迎評論區交流。

論文地址:

-

https://arxiv.org/abs/2409.13373

參考鏈接:

-

https://x.com/rao2z/status/1838245261950509170

本文來自微信公眾號:量子位(ID:QbitAI),作者:克小西

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。