盧保物理學獎罕見一幕,「AI教父」意外獲獎,物理圈傻眼

近日,瑞典皇家科學院宣佈,將2024年盧保物理學獎授予約翰·霍普菲爾德(John J. Hopfield)和傑佛瑞·辛頓(Geoffrey E. Hinton),以表彰他們推動利用人工神經網絡進行機器學習的基礎性發現和發明。

▲瑞典皇家科學院公告截圖

▲瑞典皇家科學院公告截圖其中,出生於1933年、現年91歲的Hopfield是美國著名的物理學家、生物學家和神經科學家。他發明了一種具有聯想記憶功能的神經網絡模型,可以存儲和重建圖像及其他類型的數據,對人工智能和神經網絡發展具有奠基作用。

▲約翰·霍普菲爾德(John J. Hopfield)

▲約翰·霍普菲爾德(John J. Hopfield)出生於1947年、現年77歲的Hinton是圖靈獎得主、「深度學習之父」,他在Hopfield研究基礎上,發明了一種可以自主查找數據屬性的方法,從而執行識別圖片中特定元素等任務。他憑藉玻爾茲曼機以及反向傳播算法、分佈式表示等研究被業內譽為「AI先驅」。

▲傑佛瑞·辛頓(Geoffrey E. Hinton)

▲傑佛瑞·辛頓(Geoffrey E. Hinton)Hinton今日在盧保物理學獎頒布時線上接受媒體採訪,被問及現在的感受時說:「我大吃一驚,不知道會發生這種事。」

▲Hinton在盧保物理學獎頒布時線上接受媒體採訪

▲Hinton在盧保物理學獎頒布時線上接受媒體採訪「獲獎者的工作已經產生了巨大的效益。在物理學領域,我們將人工神經網絡應用於廣泛的領域,例如開發具有特定屬性的新材料等。」盧保物理學獎委員會主席Ellen Moons說。

01 John J. Hopfield:用物理學訓練人工神經網絡,42年前論文為AI奠基

根據瑞典皇家科學院公告,Hopfield的主要貢獻如下:

「John J. Hopfield發明了一種使用保存和重現模式方法的網絡——霍普菲爾德網絡(Hopfield Network)。

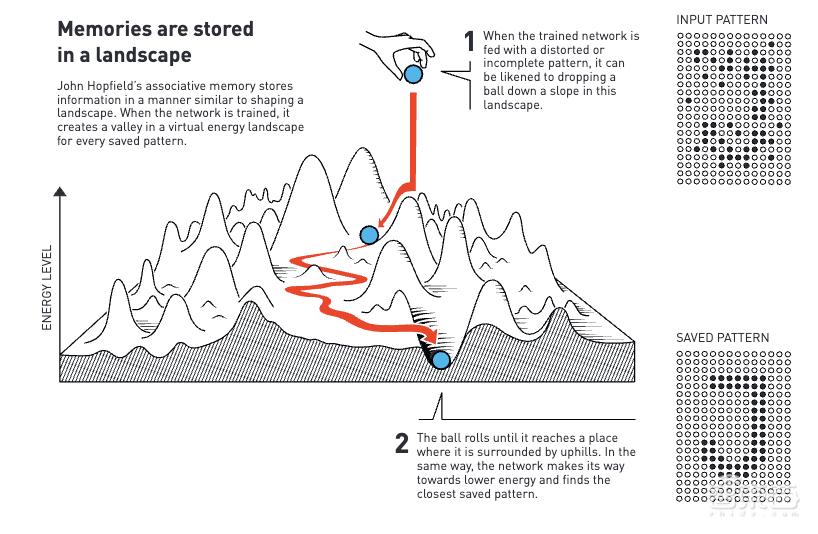

我們可以將節點想像成像素。霍普菲爾德網絡利用物理學來描述材料由於原子自旋而產生的特性,這種特性使每個原子都成為一個微小的磁鐵。整個網絡的描述方式相當於物理學中自旋系統的能量,並通過尋找節點之間連接的值來進行訓練,以便保存的圖像具有較低的能量。

當霍普菲爾德網絡被輸入扭曲或不完整的圖像時,它會有條不紊地處理節點並更新它們的值,從而降低網絡的能量。

因此,網絡逐步找到與輸入的不完美圖像最相似的保存圖像。」

出生於1933年、現年91歲的Hopfield是美國著名的物理學家、生物學家和神經科學家,1958年獲得美國紐約州艾沙卡康奈爾大學博士學位,現任美國紐澤西州普林斯頓大學教授。

他曾在巴爾實驗室做過技術人員,1982年發表了 「Neural networks and physical systems with emergent collective computational abilities」(《具有湧現集體計算能力的神經網絡和物理系統》)論文,是他被引用次數最多的論文,1986年參與創立了加州理工學院的計算與神經系統博士項目。

Hopfield提出的霍普菲爾德網絡是一種具有聯想記憶功能的神經網絡模型,在當時使得遭受質疑而陷入停滯的神經網絡重新成為AI重要研究方向,為後續神經網絡的蓬勃發展奠基。

02 Geoffrey E. Hinton:「深度學習之父」,將深度學習推向主流

根據瑞典皇家科學院公告,Hinton的主要貢獻如下:

「Hinton以霍普菲爾德網絡為基礎,發明了一個採用不同方法的新網絡:玻爾茲曼機(the Boltzmann machine)。

它是一種基於統計物理學的網絡,可以學習識別給定類型數據中的特徵元素。

Hinton使用了統計物理學的工具,通過輸入機器運行時很可能出現的示例來訓練機器。玻爾茲曼機可用於對圖像進行分類,或創建訓練模式類型的新示例。Hinton在此基礎上繼續發展,幫助開啟了機器學習的爆炸式發展。」

出生於1947年、現年77歲的AI先驅Hinton是一位英裔計算機科學家,1978年在英國愛丁堡大學獲得博士學位,現任加拿大多倫多大學教授。

2012年,Hinton聯合其學生構建了一個神經網絡,可以分析數千張照片,並自學識別花、狗和汽車等常見物體。Hinton與學生研發的神經網絡在當年ImageNet大規模視覺識別挑戰賽中以巨大優勢奪冠,從而將深度學習推向主流。

2018年,Hinton與Yoshua Bengio(祖舒亞·本吉奧)和Yann LeCun(楊立昆)一起獲得了2018年圖靈獎,自此,他們三人經常被合稱為「深度學習之父」。

▲三人並稱「深度學習之父」

▲三人並稱「深度學習之父」Hinton當下非常關注AI未來的巨大不確定性,並強調負責任監管AI的重要性。他在Google工作了十年,由於擔心AI的風險而於去年5月離職,辭去Google副總裁和工程研究員職務。

03 融合物理學背景,為機器學習革命奠定基礎

Hopfield和Hinton從1980年代開始的工作,為2010年左右開始的機器學習革命奠定了基礎。

1982年,Hopfield發明了聯想記憶,這類似於人們在相似單詞中搜索不常使用單詞的過程。他構建的網絡可以基於存儲信息重新創建模式,當為網絡提供的是不完整或略微扭曲的模式時,這一網絡可以找到最相似的存儲模式。

當時,Hopfield利用了他的物理學背景來探索分子生物學的理論問題,在南加州帕薩迪納加州理工學院,他找到了構建具有許多小組件協同工作系統的靈感。受益於瞭解磁性材料的物理學原理,他能夠使用描述自旋相互影響時材料的物理學特性,來構建具有節點和連接的示例網絡。

他構建的網絡具有以不同強度連接在一起的節點,每個節點都可以存儲一個單獨的值,在第一項工作中該值可以是0或1,就像黑白圖片中的像素一樣。這一方法很特殊,其網絡可以同時保存多張圖片並且進行區分。

同時,如下圖所示,霍普菲爾德網絡可用於重新創建包含噪聲或已部分擦除的數據。

這之後,Hopfield和其他人繼續開發這一網絡如何運作的相關細節,包括可以存儲任何值的節點不僅僅是0或1。

但存儲圖像是一回事,想要解釋它所描繪的內容是另一回事。

Hinton在美國匹茲堡卡內基梅隆大學工作時,就和同事一起利用統計物理學的思想對霍普菲爾德網絡進行擴展,並構建新的東西。

1990年代,許多研究人員對人工神經網絡失去了興趣,但Hinton仍沒有放棄,並開啟了這一研究領域的新一輪爆髮式增長。2006年,他和同事開發了一種預訓練網絡的方法,該方法將一系列玻爾茲曼機分層,一個在另一個上面。這種預訓練為網絡中的連接提供了一個更好的起點,從而優化了其訓練以識別圖片中的元素。

Hopfield和Hinton開發的開創性方法和概念是有助於塑造人工神經網絡領域。此外,Hinton在這項工作中發揮了主導作用將方法擴展到深度和密集的ANN。

當下機器學習的發展是基於大量數據以及計算能力的巨大提高而實現的。1982年,Hopfield發佈關於聯想記憶的文章,就為這一發展提供了支持。他使用了具有30個節點的網絡,如果所有節點都相互連接,就有435個連接。與今天的大型語言模型進行比較,這些模型被構建為可以包含超過1萬億個參數(100 萬萬個)的網絡。

許多研究人員現在正在研發機器學習的相關應用,但哪一個方法更可行還有待觀察,同時圍繞這項技術的開發和使用的道德問題也存在廣泛的討論。不過,由於物理學為機器學習的發展提供了工具,因此看到物理學作為一個研究領域如何從人工神經網絡中受益是很有趣的。

同時,機器學習長期以來一直被用於盧保物理學獎中熟悉的領域,包括使用機器學習來篩選和處理髮現希格斯粒子所需的大量數據、減少測量碰撞黑洞引力波的噪聲、尋找系外行星等。

04 結語:神經網絡基礎研究,助AI爆髮式發展

今年的兩位盧保物理學獎得主,利用物理學工具開發出的方法,為當今強大的機器學習奠定了基礎。

他們從1980年代開始就對人工神經網絡進行了重要的研究。AI領域基礎研究在當下節點上獲得國際重量級的盧保獎,體現了AI的巨大效益和對人類發展的深刻影響日益顯著。

本文來自微信公眾號「智東西」,作者:智東西,36氪經授權發佈。