影片生成模型變身智能體:史丹福Percy Liang等提出VideoAgent,竟能自我優化

機器之心報導

編輯:Panda

現在正是「文本生影片」賽道百花齊放的時代,而且其應用場景非常多,比如生成創意影片內容、創建遊戲場景、製作動畫和電影。甚至有研究表明還能將影片生成用作真實世界的模擬器,比如 OpenAI 今年初就發佈過一份將影片生成模型作為世界模擬器的技術報告,參閱機器之心報導《我在模擬世界!OpenAI 剛剛公佈 Sora 技術細節:是數據驅動物理引擎》。

文本生影片模型的這些近期應用既有望實現互聯網規模級別的知識遷移(比如從生成人類影片到生成機器人影片),也有望打通實現通用智能體的道路(比如用單個策略控制不同環境中不同形態的機器人來執行多種多樣的任務)。

然而,現實情況是,文本生影片模型的下遊應用還很有限,原因包括幻覺問題以及生成的影片內容不符合現實物理機制等。

雖然理論上可以通過擴大數據集和模型大小來有效減輕這些問題,但對影片生成模型來說,這會很睏難。

部分原因是標註和整理影片的人力成本很高。另外,影片生成方面還沒有一個非常適合大規模擴展的架構。

除了擴大規模,LLM 領域的另一個重要突破是能整合外部反饋來提升生成質量。那文本生影片模型也能受益於這一思路嗎?

為瞭解答這一問題,一個多所機構的研究團隊探索了影片生成模型能自然獲得的兩種反饋類型,即來自視覺 – 語言模型(VLM)的 AI 反饋和將生成的影片轉換成運動控制時得到的真實世界執行反饋。

為了利用這些反饋來實現影片生成模型的自我提升,該團隊提出了 VideoAgent,即影片智能體。該研究有三位共一作者:Achint Soni、Sreyas Venkataraman 和 Abhranil Chandra。其他參與者包括滑鐵盧大學 Sebastian Fischmeister 教授、史丹福大學基礎模型研究中心(CRFM)主任 Percy Liang 以及 DeepMind 的 Bo Dai 和 Sherry Yang(楊夢嬌)。

-

論文標題:VideoAgent: Self-Improving Video Generation

-

論文地址:https://arxiv.org/pdf/2410.10076

-

代碼地址:https://github.com/Video-as-Agent/VideoAgent

不同於將生成的影片直接轉換成運動控制的策略,VideoAgent 的訓練目標是使用來自預訓練 VLM 的反饋來迭代式地優化生成的影片規劃。

在推理階段,VideoAgent 會查詢 VLM 以選擇最佳的改進版影片規劃,然後在環境中執行該規劃。

在在線執行過程中,VideoAgent 會觀察任務是否已成功完成,並根據來自環境的執行反饋和從環境收集的其它數據進一步改進影片生成模型。

生成的影片規劃獲得了兩方面的改進:

-

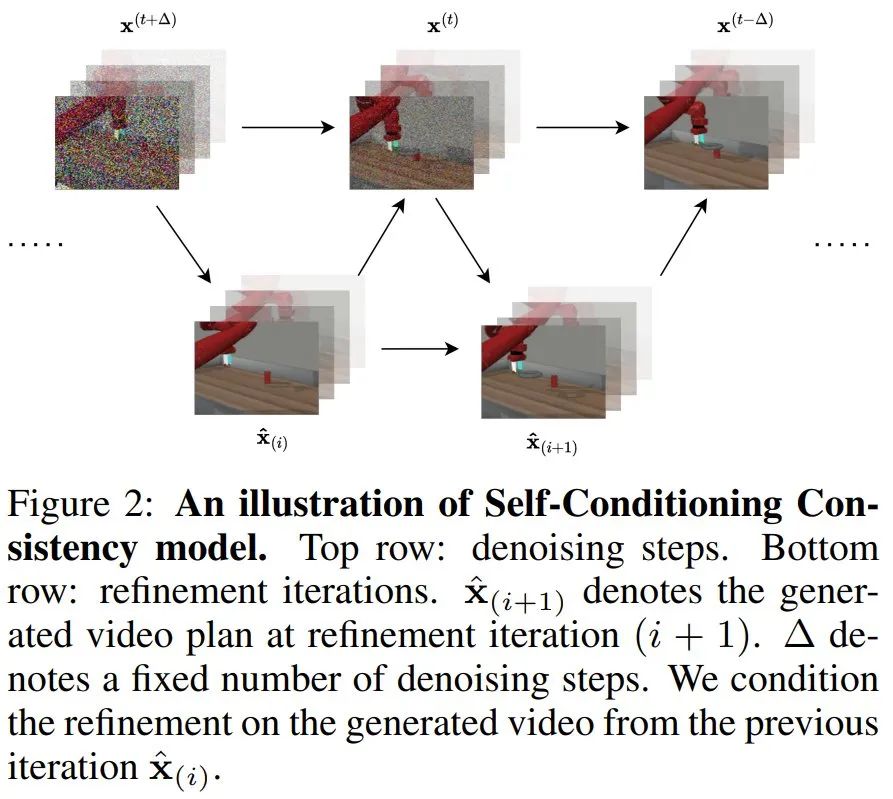

該團隊受一致性模型的啟發,提出了用於影片擴散模型的自我調節一致性(self-conditioning consistency),其可將來自影片擴散模型的低質量樣本進一步優化成高質量樣本。

-

當可在線訪問環境時,VideoAgent 會執行當前影片策略並收集其它成功軌跡,以進一步在成功軌跡上微調影片生成模型。

圖 1 是 VideoAgent 的直觀圖示。

通過自我調節一致性實現影片優化

他們首先考慮的是基於第一幀和語言的影片生成,即根據語言描述找到從初始圖像開始的一個圖像幀序列。通常來說,當某個樣本來自一個影片生成模型時,其中一部分更真實(開始部分),另一部分則充滿幻覺(結尾部分)。

也就是說,雖然生成的影片規劃可能無法完全完成指定的任務,但它能提供有意義的信息,以幫助進一步改進以實現正確的規劃。

為了利用這樣的部分進展,該團隊使用了一個影片一致性模型,即基於之前的自我生成的樣本為 ground truth 影片執行擴散,這樣模型就可以學會保留影片的真實部分,同時優化其中的幻覺部分。

此外,除了基於之前生成的樣本來優化影片,該團隊還納入了反饋,包括來自人類的反饋和來自 VLM 的反饋。這被稱為反饋引導的自我調節一致性。

這裏我們僅描述了其大概方法,詳細過程和形式化描述請參閱原論文。

通過 VLM 引導的影片生成實現推理

在訓練了影片生成模型和影片優化模型之後,可采樣影片生成模型然後迭代式地使用優化模型來實現影片優化。

具體來說,VideoAgent 首先會基於第一幀和語言的影片生成來「猜測」影片規劃。

接下來,迭代地使用優化模型來執行優化,這裏會使用 VLM 來提供反饋。

算法 1 展示了使用 VLM 反饋的影片生成和優化模型。

算法 2 則給出了在推理時間生成、優化和選擇影片規劃(重新規劃)的方式。

通過在線微調實現自我改進

除了上面描述的基於自我調節一致性的影片優化,該團隊還進一步將影片生成和影片細化的組合描述為一種策略,該策略可以通過在線交互期間從環境中收集的額外真實數據進行訓練,從而實現改進。

有多種強化學習技術可以滿足這一需求,算法 3 描述了其細節。

實驗

為了評估 VideoAgent,該團隊進行了多個實驗,包括該模型的端到端成功率、不同組件的效果以及能否提升真實機器人影片的質量。

數據集

實驗中,該團隊考慮了三個數據集:

-

Meta-World:11 個機器人操作任務,由模擬的 Sawyer 機器臂執行,影片演示是從三個不同的攝像機角度拍攝的。

-

iTHOR:一個模擬的 2D 目標導航基準,其中智能體在四種房間類型中搜索指定的目標物體。

-

BridgeData V2:一個真實的機器人操作數據集。

端到端任務成功率

實驗過程就不過多贅述了,直接來看結果。

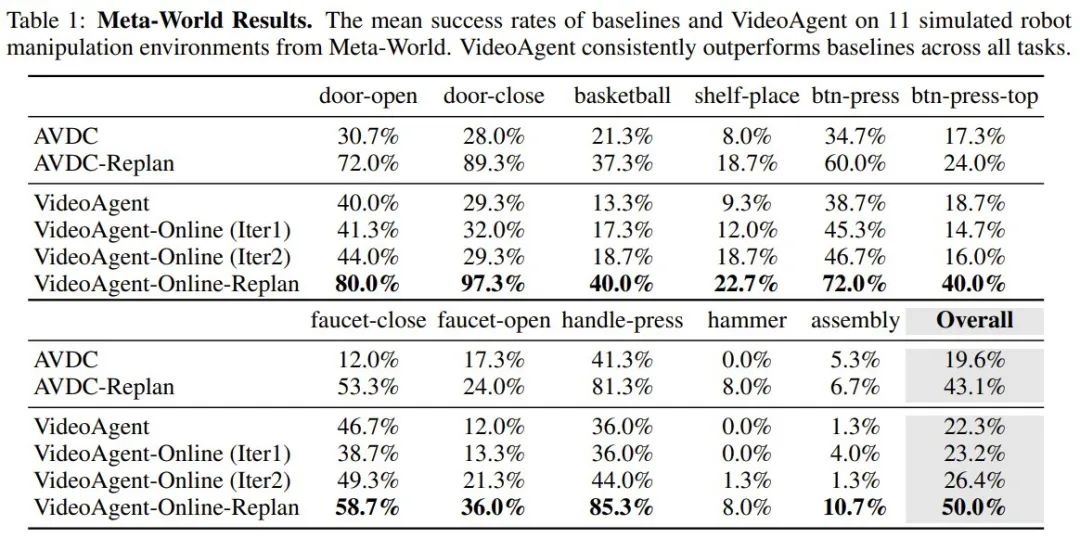

首先,表 1 給出了在 Meta-World 上的端到端任務成功率。

可以看到,自我調節一致性已經能讓 VideoAgent 的總體成功率超越基線(19.6% 到 22.3%),其中一些任務更是大幅提升,比如在關閉水龍頭(faucet-close)任務上的成功率從 12% 猛增至 46.7%。

而如果再進一步引入在線微調,成功率還能進一步提升,並且多迭代一次都會多一點提升。

引入重新規劃後,VideoAgent 的優勢仍然存在,並且總體任務成功率達到了 50%,達成了該設置下的當前最佳水平。

表 2 展示了在 iTHOR 上的成功率,可以看到 VideoAgent 同樣全面優於基線 AVDC。

理解 VideoAgent 不同組件的效果

該團隊也通過對比研究分析了 VideoAgent 不同組件的效果,具體包括 (1) 向優化模型提供不同類型的反饋,(2) 改變優化和在線迭代的次數,(3) 調整 VLM 反饋的質量。

表 3 展示了不同 VLM 反饋的效果(基於 Meta-World)。可以看到,不管是二元反饋還是描述性反饋,都比沒有反饋好,更比基線 AVDC 好得多。

圖 3 和 4 分別展示了優化和在線迭代的次數的影響。整體來看,增多迭代次數有助於提升模型,並且效果很顯著。

圖 3 和 4 分別展示了優化和在線迭代的次數的影響。整體來看,增多迭代次數有助於提升模型,並且效果很顯著。

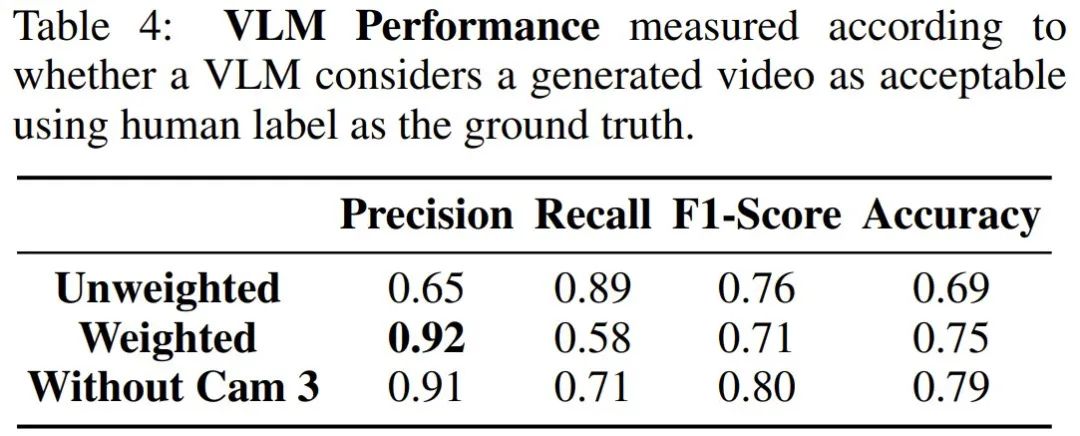

由於這項研究是首批利用 VLM 為影片生成提供反饋的研究之一,因此一個重要的研究課題是:瞭解 VLM 是否真的可以為影片生成提供足夠準確的反饋。

表 4 給出了 VLM 反饋的各項性能指標,這裏使用了人工標註作為 ground truth 來進行評估。

可以看到,原始提示詞(Unweighted)的準確度是 69%,這說明 VLM 足以評價生成的影片。而通過重新加權來懲罰假正例(Weighted)還能大幅提升其準確度。另外值得注意的是,從提示詞中移除第三個攝像頭甚至還能獲得更高的準確度,這說明 VLM 的準確性會受到部分可觀測性的影響。

在真實世界影片上評估自我優化

最後,該團隊也評估了 VideoAgent 改進真實影片的能力。結果見表 5。

可以看到,在影片分數的 5 個子指標上,VideoAgent 在其中 4 個上表現更優,在唯一的例外「動態分數」上也與基線差距細微。此外,VideoAgent 在 CLIP 分數、流一致性和人類評估上也都更好。這表明 VideoAgent 可以生成更流暢、更符合現實世界的物理邏輯的影片。

最後,圖 5 給出了一個定性評估結果。

其中,中間行是基線,可以看到其出現了幻覺(碗消失了),而 VideoAgent 很好地完成了影片生成任務。