企鵝蘭登要將AI拒之門外,但頭埋進沙裡就有用嗎

如果要說當下哪個群體是AI大模型的「鐵粉」,或許非學生黨莫屬。沒錯,相比於打工人,學生如今顯然更青睞AI。據畢馬威日前在加拿大發佈的一項研究結果顯示,有59%的加拿大學生表示他們在學業中會使用生成式人工智能,相比去年上升了7%。

不過學生們的好日子恐怕也難以長久了,近期又有一家大型出版集團宣佈拒絕人工智能。日前據海外科技媒體The Verge公佈的消息顯示,圖書出版商企鵝蘭登書屋正在以印刷體的形式表明對於人工智能訓練的立場,其新書和再版書籍的標準版權頁將會寫明,「本書的任何部分不得以任何方式用於或複製用於訓練人工智能技術或系統。」

沒錯,自從ChatGPT將AI大模型、生成式人工智能帶火之後,數字版權問題日漸白熱化。一邊是AI公司攫取高質量訓練語料的需求日益高漲,另一邊則是出版機構千方百計地維護自身的版權價值。但遺憾的是,企鵝蘭登書屋的努力或許是螳臂當車,效仿康泰納仕將自家內容賣個好價錢才是上策。

為什麼要這麼說呢?因為當下的現實,是絕大多數AI廠商反對訓練大模型需要版權許可和付費,真正願意付費的只有OpenAI等寥寥幾個大廠。以Google為例,該公司在去年回覆美國版權局時就表示,如果拆開看大模型的預訓練過程,從抓取信息、複製輸入到處理分析,只有最初的複製行為能落在版權法的範疇中,其他行為並不觸發相關法律法規。

事實上,從技術原理來說,AI大模型記住的是統計關係、而不是文本本身,ChatGPT等產品最後輸出的結果是一種聯想而非複製,並不會通過數據庫重新訪問版權作品,也不會直接複製黏貼作品的相關內容。所以認為自己的行為並不違反版權保護,這也是大量AI廠商普遍不願意為語料資源付費的關鍵所在。

更為重要的是,大模型的訓練和內容生成呈現的「黑箱」特質,導致了通過技術手段進行數據溯源的難度巨大,也使得傳統的按比例直接分成這一方法不再適用。其實AI廠商不願意付錢還不是大問題,真正的問題在於,語料數據耗盡很有可能是一個偽命題。

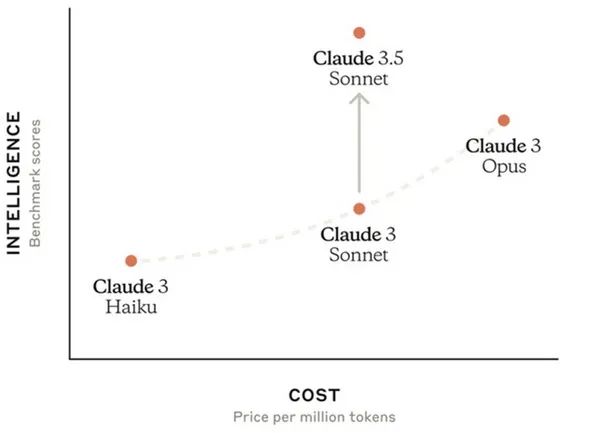

目前在AI行業中,OpenAI和Anthropic兩隻獨角獸旗下的大模型在性能層面一騎絕塵,遠勝於Meta的LLama、Google的Gemini。而OpenAI背後的微軟、Anthropic背後的亞馬遜,均不是以社交和搜索著稱,所以在私有語料規模上要遠遜於Google和Meta。

比如,OpenAI訓練ChatGPT的45TB數據,主要來源於Common Crawl、域奇百科、美國專利文件數據庫,都是公開資料。換而言之,如果大模型真的是以語料為王,那麼Google目前最強的Gemini 1.5 Pro表現就不會不如GPT-o1。因此一個可能的事實,是語料本身的重要性或許不如數據清洗。

如果越來越多的廠商發現,相比於花大價錢購買出版商手裡的數據,高水平的數據清洗依然能從「髒數據」里洗出高質量的數據。特別是在不久前OpenAI曝出ChatGPT會「看菜下碟」,用戶名可能影響聊天機器人的響應、並反映出有害的刻板印象。對此OpenAI方面的猜測,是刻板印象很可能源自AI訓練使用的數據集。

要知道AI是否會出現歧視等倫理問題一直是外界關注的重點,以至於AI廠商不得不花費大量的時間來校正AI的價值觀,使其認知世界的觀念與人類靠攏。現在OpenAI主動自曝ChatGPT的問題,大概率會導致其他廠商更審慎地對待訓練數據,並更徹底地清洗數據。

AI廠商現階段已經幾乎把公共語料庫用光是事實,但語料的作用沒有想像中大可能也是事實。因此對於企鵝蘭登書屋等版權方來說,挾內容以令AI廠商的畫面並不會必然發生。儘管現階段對人工智能說「不」,確實可能會籠絡一部分擔憂自身被AI取代的創作者,但AI滲透社會生活已經是大勢所趨,抵製幾乎沒有意義。

現階段更有價值的事情,是探討如何緩解訓練數據版權所有者與AI開發者之間的緊張關係,並且兩者建立起互利的收益分享方案可能才是更加有效的破局之道。只有這樣才能確保在鼓勵創新的同時,也可以保護數據提供者的合法權益。

【本文圖片來自網絡】

本文來自微信公眾號「三易生活」,作者:三易菌,36氪經授權發佈。