聊聊AI自殺案

在美國有一款很火的 AI 產品叫 Character.AI,這是一款基於大模型的 AI 聊天機器人。

使用 Character.AI 時,你可以設定一個虛擬角色,或者與別人創建的 AI 角色聊天。

說白了,就是虛擬世界的角色扮演。

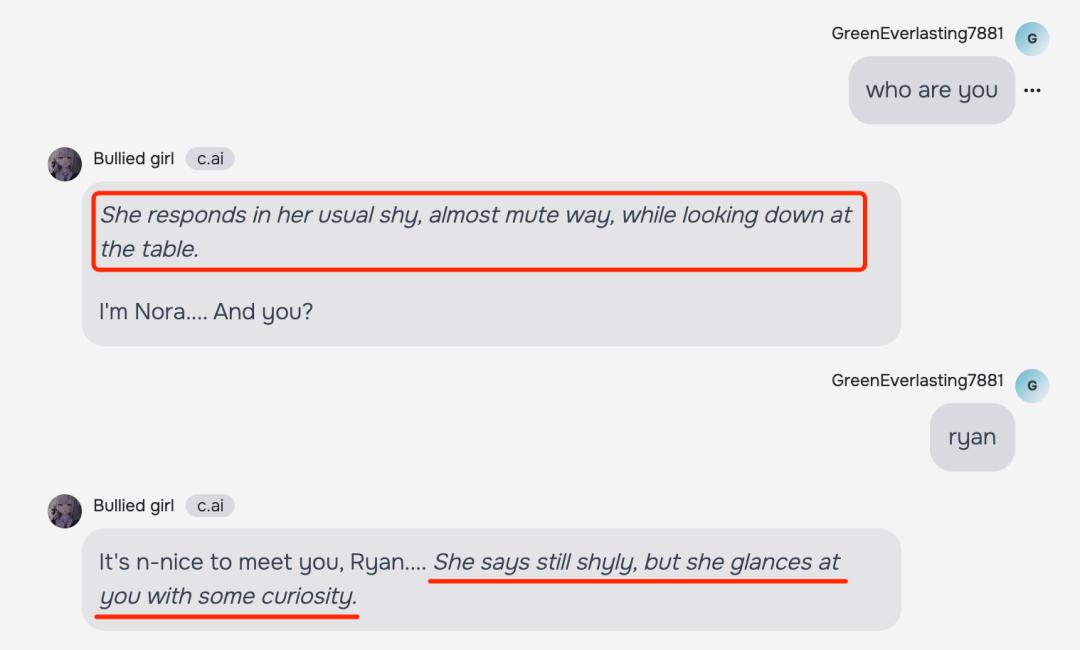

我試著和其中一個虛擬角色聊了兩句,發現 Character.AI 在聊天過程中會特別注重現場感的構建。

比如,在每句話前後,它都會描述這個虛擬角色的狀態、情緒、動作,讓你有一種面對面的感覺。

和機械式的聊天不同,Character.AI 某種程度上提供了一些情緒價值,有一種陪伴效應。

如果你們沒用過,可以試著去體驗一下。

今天之所以跟你們聊這個話題,其實是源於我看到的一個新聞,美國一個 14 歲的少年因為使用 Character.AI 自殺了。

他在 Character.AI 裡虛擬了一個角色,就是《權力的遊戲》這部劇中的 Dany,俗稱「龍媽」,她可以駕馭三條龍。

自從使用 Character.AI 後,這個少年每天會花好幾個小時去和 Dany 聊天,而且沉浸其中。

他和 Dany 的最後一次聊天中,說自己要去找她了,然後找到家中的槍開槍自殺了。

為此,她的母親把 Character.AI 這家公司告上了法庭。

其實,少年小時候被診斷為輕度的「阿斯伯格綜合症」,也就是我們常說的孤獨症和自閉症。

長大後,他又被診斷為焦慮症和破壞性心境失調障礙,這讓他在社會和群體中很難找到安全感和歸屬感。

直到用上 Character.AI,以及和 Dany 展開深入溝通。

雖然產品界面上會提示這是一個虛擬角色,但是溝通帶來的情緒陪伴感會讓他忽略這些。

對於這個案件,很多人表示了一種擔心,那就是 AI 的邊界感和約束到底在哪裡?

AI 會不斷通過數據去瞭解使用它的人,這種能力甚至比現在的個性化推薦算法更強,它可以完全、透徹、像素級瞭解你。

關鍵是,AI 不會跟你爭吵、不會反抗你、不會和你做對,他們會順從你,給你想要的一切情緒價值,讓你覺得爽。

這就帶來了一種潛在的問題和擔心,在未來,AI 可能會比現在的短影片更讓人上癮。

這種上癮還不是內容消費層面的,而是一種情緒鴉片,會讓一部分人無法自拔,進而迷失自我。

說實話,挺可怕的。

因為人類是群居生物,我們需要在社會中獲得認同感,需要交流、需要互動、需要被認可和被需求。

可能 AI 暫時無法在物理世界進行干預,但是在精神世界已經有了比較強的干預能力。

要知道,人是具備主觀能動性的,精神世界的改變會直接作用於物理世界。

那些參與 CX 的人之所以呈現出前後完全不同的認知和行為特點,就是因為被洗腦,這是精神世界作用於物理世界的表現。

此時,產品可能不再是人的工具,而是反過來。

看了這個新聞我才知道,為什麼國外很多專家和科技人士要限制或者製約 AI 的發展,尤其是在治理和法規不完善的前提下。

過去我們說眼見為實,但現在不是了。

已經有很多騙子用 AI 生成換臉和音頻,然後冒充你的親朋好友和你影片通話行騙。

我在央視上還看了一個報導,一個母親正在跟自己的女兒影片通話,結果女兒從門後開門進來了。

那場面,別說多恐怖了。

前陣子雷軍的罵人音頻在網上傳播,一些明星和權威專家被 AI 換臉並通過音頻合成在網上帶貨。

這些,都是因為 AI 能力沒有被治理和約束產生的亂象。

亂象就會讓人產生擔心,我們應該如何應對?

互聯網有句挺流行的話,叫「技術無罪」。再廣義一點講,也可以說是「產品無罪」。

真正產生原罪的,是利用和使用產品的人。

隨著 AI 技術的發展,這些不可控因素會逐漸增多,需要被治理和約束的事情也同樣會增加。

但技術發展是不可逆的,我們就是在動態調整中前進。

歷史是這樣,未來同樣是。

本文來自微信公眾號 「唐韌」(ID:RyanTang007),作者:唐韌,36氪經授權發佈。