OpenAI錯過的7個月,智能體2.0借終端爆發?

文 | 光錐智能,作者 | 魏琳華 劉俊宏,編輯 | 王一粟

2024年3月,OpenAI關停僅運營兩個月的GPT Store。

時隔僅7個月,同樣是做Agent平台,OpenAI現任董事會主席Bret Taylor創立的新公司,融了45億美元。整個AI界在前後發佈的Claude的「Computer Use」和智譜的AutoGLM智能體下,開始了一場「丟下」OpenAI的狂歡。

10月26日,微軟開源了基於純視覺的GUI屏幕解析工具OmniParser,Google的同類產品「Project Jarvis」也有望在12月上線。

加入狂歡的不止是大模型廠商。和智譜宣佈達成深度合作的一個月後,榮耀也交出了自己的答卷。10月30日,榮耀CEO趙明展示了AI智能體YOYO自主處理任務的能力,只需要對手機說一句「訂2000杯咖啡」,YOYO就幫他在附近下單成功,忙壞了周圍的咖啡店和外賣員。

無論是電腦端還是手機端,Agent開始真正實現了「自主性」:從點咖啡到買牙膏,無需人類操作,一句指令就能讓AI完成所有任務。和前一代只能提建議的Agent相比,AutoGLM實現了從1.0到2.0的進階。

二級市場的熱度,也被智能體點燃。發佈AutoGLM後,一眾投資、參股智譜,或是和智譜合作密切的公司股價明顯上漲,「智譜概念股」走強。上週開始,智譜概念股持續活躍,豆神教育、思美傳媒、常山北明等相關概念股一度漲停。

當端側大模型開始落地到手機端,苦於落地的大模型廠商,不僅僅只將目光放在了軟件能力上,從智能體到做以大模型為能力中心的「AI OS」,大模型創企們找到了AI大模型商業化的新道路。

在OpenAI錯過的7個月中間,Agent到底發生了什麼變化?

AI Agent進入2.0時代

為什麼智能體突然點燃了二級市場的熱情?

華泰證券指出,AI Agent已經解決了大模型從「言」到「行」的突破。

對比上一代「只動嘴皮子」的Agent,無論是Computer Use還是Phone Use,上述智能體產品均實現了AI端的自主操作:接收到指令後,AI將親自接管設備,包括點擊、輸入等交互功能。

以Anthropic發佈的「Computer Use」為例。演示中,無需人類操作,它完成了「填寫公司表格數據」的任務。

接到上述任務後,AI將工作拆分為多個步驟:

1、首先,查找已有表格中是否有所需公司的相關數據;

2、在查詢不到結果後,AI打開搜索界面,自行查找相關公司的數據信息;

3、最後,它對應著表格的空缺部分逐個完成數據的輸入。

通過在對話欄輸入指令,AI自主根據表格信息情況完成填寫

通過在對話欄輸入指令,AI自主根據表格信息情況完成填寫在展示影片中,智譜發佈的AutoGLM 調用手機上的多個App也很絲滑,當用戶要求購買瑞幸的美式咖啡,AutoGLM打開美團搜索品牌,並把想要的商品自動加入購物車,並跳轉至結算界面。交給用戶的,只有選擇「下單」按鈕。

根據用戶的需求,AI自主選定咖啡的口味

根據用戶的需求,AI自主選定咖啡的口味微軟也在近日開源了一個用於識別Web端視覺界面的工具產品OmniParser。在Github展示頁的示例影片中,OmniParser也做到了自主操作的能力:

當交付給它一個收集素食餐廳的任務時,OmniParser通過解析界面元素,在網頁中定位到「餐廳」字樣。檢索不符合要求後,它再自動拉起搜索框,根據關鍵詞定位到相關餐廳,並完成勾選。

這些對人類來說非常簡單的操作,交給AI,需要克服的障礙不少:

首先,無論是電腦端還是手機端的交互,Agent均需要完成點擊、劃動、查找等步驟,如何讓模型學會並做到精準操作,這是阻礙Agent進化的一大難題。

而這個難題的突破,得益於基礎大模型發展帶來的能力躍遷。

比如,如何讓AI理解GUI(圖形用戶界面)並完成操作?

Agent的核心繫統分為感知-規劃-記憶-行動-工具五個部分,其中,感知系統負責捕捉外界的視覺、聽覺、文本信息,並加以分析。通過對上述信息的完整認知,Agent會結合這些信息對接受到的任務進行規劃,也就是用CoT(思維鏈)的方式拆解成多個步驟,依次執行。

但在2023年,大語言模型仍然停留在文本能力階段,在影片、語音等多模態能力發展尚未突破的時候,Agent受底層基座能力的限制,尚且無法完整感知環境,從而在多個任務上的執行過程中犯錯,自然也難以達到應用階段的水準。

對此,微軟的解決方案是,通過屏幕截圖的方式,將屏幕中的所有可交互圖標和按鈕一一標註出來,將它們提取為信息,再根據識別的內容進行定義,讓AI理解每個交互點的作用,從而實現自主操作。而智譜AutoGLM在手機端的操作應用,同樣借助了多模態能力來完成對UI的識別解讀。

而在上述基礎上,針對數據不足、策略分佈漂移等問題,智譜也找到了問題的解法。

比如,受製於軌跡數據獲取成本高昂和數據不足的問題,無法對大模型智能體完成充分的動作執行能力訓練。

為此,他們在AutoGLM中引入自研的「基礎智能體解耦合中間界面」設計。以「提交訂單」為例,把AutoGLM作為中間界面,將「任務規劃」與「動作執行」兩個階段通過自然語言中間界面進行解耦合。

對比過往端到端智能體的直接處理,這種方式將AI的操作準確度提升了將近一倍。

除了實現精準交互操作的需求之外,面對種類繁多的複雜任務,智能體還需要具備即時規劃和糾正能力,從而在遇到問題的時候及時給出有效的解決方法。

對此,AutoGLM上應用了「自進化在線課程強化學習框架」技術,讓智能體在基於手機和電腦的環境中不斷學習和提升應對能力。

「就像一個人,在成長過程中,不斷獲取新技能。」張鵬解釋道。

在上述兩種能力的加持下,AutoGLM 在 Phone Use 和 Web Browser Use 上都取得了大幅的性能提升。官方數據顯示,在 WebArena-Lite 評測基準中,AutoGLM 更是相對 GPT-4o 取得了約 200% 的性能提升。

總體來看,在大語言模型和多模態模型進化一年之後,AI Agent終於實現了從單體智能,向使用工具方向邁進,完成了2.0的進階。

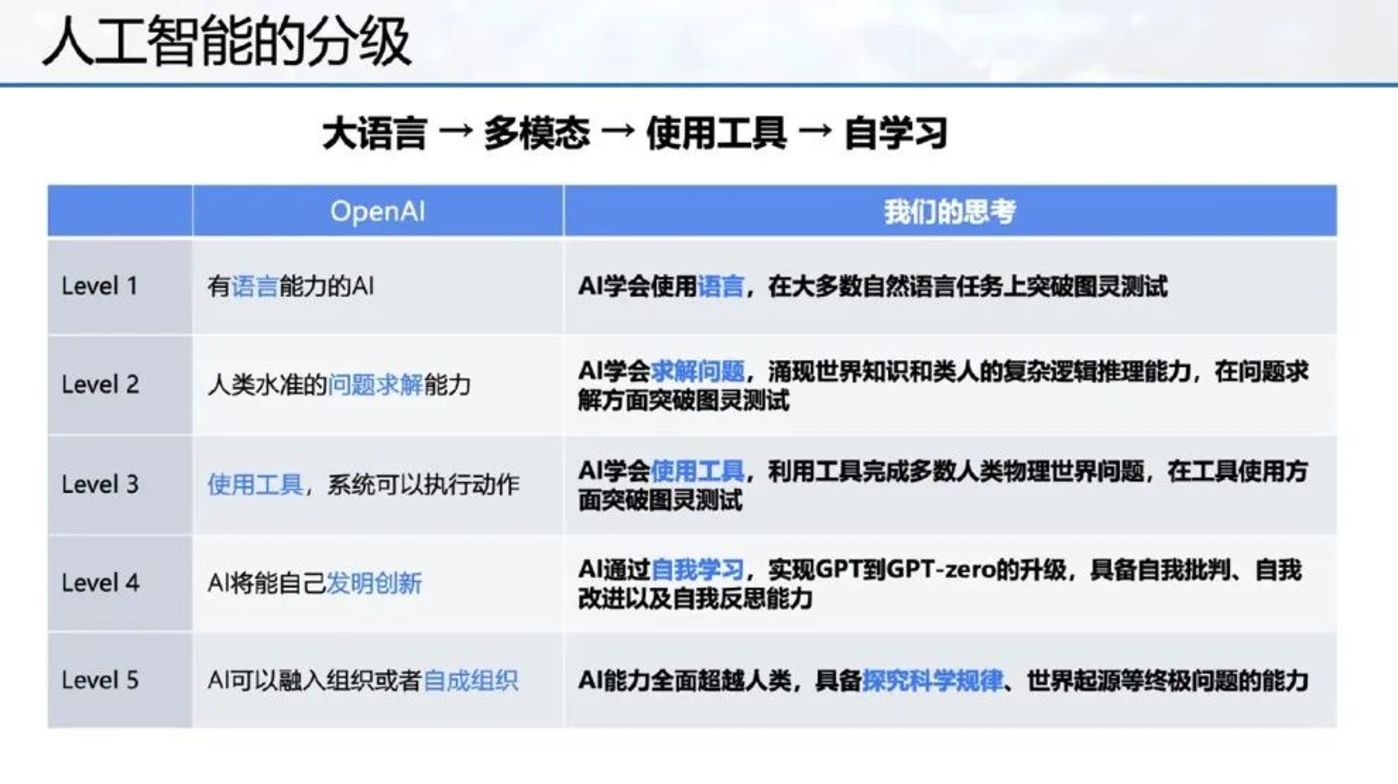

學會使用工具,人工智能進入L3階段

縱觀人工智能的發展史,人工智能和人類的進化路徑何其類似,正在經歷從學會「語言」,到「解決問題」,再到「使用工具」。

3個多月前,OpenAI將通往AGI之路劃分為五個階段。AutoGLM上線當天,智譜也向外界公示了自己的技術路線圖。

首先在L1階段,AI的重點在於學會使用「語言」,包括語音、文字還有視覺。

回顧兩年前,從ChatGPT誕生開始,人們對AI的注意力開始轉移到生成式AI上。在短短半年的時間里,大語言模型頻頻湧現:GPT、Claude、GLM等系列大模型出現並持續更新換代,它們均圍繞語言理解、邏輯能力等指標完成進化。

在大語言模型之外,AI廠商還把關注點放在了另一座高峰——多模態大模型上。圍繞視覺、聽覺等能力,實現了從無到有的突破:

從今年上半年開始,端到端語音模型開始先後發佈,它讓AI能夠「聽到」人的情緒,並完成有溫度的交流。

今年4月,GPT-4o的發佈會向人們展示了和AI實時對話的魅力。和以往模型相比,端到端語音模型將過往的多個大模型串聯完成的任務壓縮到一個模型中完成,降低時延的同時,還能完整保留人聲的情緒、停頓等信息,可以隨時打斷它並繼續交流。

多模態模型則讓大模型裝上了「眼睛」,看到並理解現實世界環境的變化。

以智譜的GLM-4V-Plus為例,它不僅能夠完成大語言模型的對話能力,同時,在影片、圖像的理解能力上提升明顯。智譜還推出了影片通話API接口GLM-4-Plus-VideoCall,讓大模型能夠和人類打「影片通話」,識別周邊物品並對答如流。

「大腦是一個非常複雜的系統,包括聽覺、視覺、味覺、語言等多模態的感知與理解能力,有短期和長期記憶能力,深度思考和推理能力,以及情感和想像力。」張鵬說。

可以看到,當前階段下,大模型能力開始能夠模擬人腦的一些功能,包括視覺、聽覺、語言理解等能力。

智譜方面透露,在他們規劃的五個階段中,L1能力「已經達到了80-90%」。

在聽說讀寫等基本能力的進化過程中,代表L2的邏輯思維能力,也在快速進化。

L2的一個裡程碑就是 OpenAI發佈的o1模型,跳脫出過往的GPT大家族,專注於CoT(思維鏈)能力上精進,它學會了慢思考:在應用思維鏈,將指令拆分為多個簡單步驟完成的同時,o1用強化學習的能力,用於識別和糾正錯誤。

OpenAI表示,隨著強化學習的增加和思考時間的增加,o1的性能會持續提高。官方數據顯示,在Codeforces主辦的編程競賽上,o1取得了超越93%參賽者的成績,並在物理、化學、生物等基礎學科的能力指標上取得了超過博士生的水準。

因此,o1也被視為人類在L2邏輯思維能力上取得的新進化,開始展現和人類旗鼓相當的推理能力。

當L1語言和多模態能力基本打通後,基於上述底層能力,才能湧現出達到L2邏輯思維能力和L3工具能力級別的新產品。

而這次升級的智能體操控智能終端的能力,實際上在L3階段。

正如哲學家恩格斯所言,人類和動物,最本質的區別就是——能否製造和使用工具。

智能體2.0的升級,也代表著人類在通往AGI的路線上,又拿下了一城。

「AutoGLM 可以看作是智譜在 L3 工具能力方面的探索和嘗試」,張鵬表示。

展望L4和L5,OpenAI認為,L4階段,AI能夠自我完成創新;L5階段,AI則具備融入或自成組織的能力。

而智譜也對L4和L5階段給出了新的定義,相對於OpenAI,智譜對AGI的期待更加激進。

「我們認為 L4 級人工智能意味著 AI 可以實現自我學習、自我反思和自我改進。L5 則意味著人工智能全面超越人類,具備探究科學規律、世界起源等終極問題的能力。」張鵬表示。

端側大模型,AI落地的新高地

當AI進階至L3階段,大模型廠商們在商業化的進程上也按下了「加速鍵」。

事實上,終端硬件和大模型廠商們正在雙向奔赴。觀察今年發佈的AI硬件,是否搭載Agent,對應著產品AI能力的「天差地別」。

最顯著的對比,是10月30日發佈的,搭載YOYO智能體的榮耀Magic7。

基於智能體可直接執行任務的特性,趙明一句2000杯飲料的需求,爆單了附近所有咖啡店。 從「一步步」交互,到智能體「脫手自動執行」,趙明自豪地宣佈道,「手機進入自動駕駛時代」。

為了挖掘硬件端和AI能力結合的潛力,智能終端廠商和大模型公司的「聯姻」早已見怪不怪。

其中,智譜是當前國內大模型創企中和手機廠商聯動最多的一家。此前,智譜已經和榮耀官宣戰略合作,而在最近半年的時間中,其先後和三星、英特爾、高通聯手,通過提供底層AI能力支持終端智能化升級。

同樣,蘋果就認為,Apple Intelligence的智能體將直接改善蘋果手機的銷量。在剛剛結束的蘋果2024年四季度財報電話會中,CEO曲克稱,「iPhone 16系列賣得比iPhone 15系列更好,Apple Intelligence上線後,用戶升級iOS18.1版本的積極性都是去年同期的兩倍。」

加持AI,將是手機廠商未來多年的重要戰略。根據IDC預測,預計2024年AI手機出貨量將同比增長363.6%,達到2.3億部。IDC手機研究總監Anthony Scarsella表示,在2024年實現三位數增長之後,AI手機將連續四年實現兩位數增長。

為何硬件終端廠商如此熱衷於智能體的落地?背後是智能體從底層顛覆了硬件廠商與消費平台之間的權力地位。

以「趙明點咖啡」為例,在沒有智能體之前,用戶點咖啡大多依賴渠道慣性。用戶需要根據習慣、優惠券、積分等因素,在美團、星J.巴克小程序、餓了麼等平台之間選擇下單。而有了替用戶下單的智能體之後,由於平台不再直接對接客戶,智能體有了為平台直接分配訂單的權利。換句話說,通過搭載智能體,AI終端廠商有了向軟件平台「徵稅」的權利。

如同蘋果當前被無數廠商「痛」,又無可奈何的「蘋果稅」。正是因為掌握了App Store的分發和流水,蘋果才能依靠幾乎「躺賺」的商業模式,才能以平均高達70%以上毛利率的軟件服務收入,拉高整個公司的營收質量。

據2024年四季報顯示,蘋果本季度軟件服務業務的營收佔比為26%,業務毛利率為74%,公司整體毛利率為44%。

看到如此優質的營收,也難怪AI硬件廠商「大幹快上」智能體。而看到了這場全新變現模式的大模型公司,也紛紛與AI硬件廠商展開了合作。

除了加碼修圖、文本總結等AI軟件功能、植入智能體之外,打造端側大模型,並將其深度融入硬件系統,成為原生能力,是手機廠商加碼AI能力的下一步。

基於端側大模型提供的核心能力,AI手機正在做到更多之前無法完成的事情,用智能體做事還是第一步。

相比之下,智譜還有更加宏大的野心, 他們更希望將AI能力深度植入終端,用大模型重塑操作系統。

「希望我們的努力能夠推動人機交互範式實現新轉變,為構建 GLM-OS ,即以大模型為中心的通用計算系統打好基礎。」在發佈AutoGLM時,張鵬如是說。

不僅智能手機關注AI能力的加碼,芯片端也在加速和AI能力的融合。上個月,高通宣佈將智譜GLM-4V端側視覺大模型搭載到芯片驍龍8至尊版,進行深度適配和推理優化。其推出的應用ChatGLM支持用相機進行實時語音對話,也支持上傳照片和影片進行對話。

在AI完美落地具身智能之前,手機、電腦等終端將是AI大模型落地的更佳場景。通過L3工具能力的展現,AutoGLM們將有機會撕開新的商業模式。

不過,智譜的AutoGLM目前還是通過調用手機的無障礙權限實現跨應用調用,未來如果想要完成更加複雜的指令,還需要和智能終端廠商以及應用開發商達成深度合作,從而獲取更多操作權限。

大模型的「軟」實力,最終還得「硬」實現。

目前,大模型的商業化仍然是以軟件付費為主,包括面向C端的訂閱製和麵向B端的API接口或者項目製。但在未來,要想真正實現AGI,以及釋放更強大的能力,還得是通過硬件來和物理世界交互。

智能體在端側的落地,就像一個機遇,幫助大模型公司在硬件上積累了眾多的工程化能力,甚至還能獲得一些不錯的邊緣數據。這給未來,無論是通過XR設備還是具身智能機器人,來完成物理世界的交互,都打下了一個好的基礎。

未來,在智能終端上的落地,將是大模型技術和商業化的新高地。