科學家提出基於大語言模型的智能體系統框架,促進對不同框架的統一理解

近日,澳州迪肯大學博士生李昕哲通過識別常見的工作流和語言模型角色設定(LMPR,LLM-Profiled Roles),促進了對不同框架的統一理解。

其目標是提出一個統一的易於比較的框架,以便更高效地實現和擴展大模型基礎的智能代理(LLM Agents,Large Language Model Agents)。

那麼,為什麼現在的框架之間很難實現擴展呢?

一個是因為,相似的 LMPRs 用不同的術語表達;另外,許多複雜的框架在不同的任務和應用上存在不一致性,這可能是人為設計,也可能是應用本身帶來的。

比如,傳統面向智能體的任務都存在外部環境提供的反饋,而問答任務則沒有這種反饋。

這項研究很好地改善了第一個問題。具體地說,作為綜述論文,它在術語上圍繞著模型角色的設定進行統一定義,然後在同一些維度下區分具體實現方面的異同。

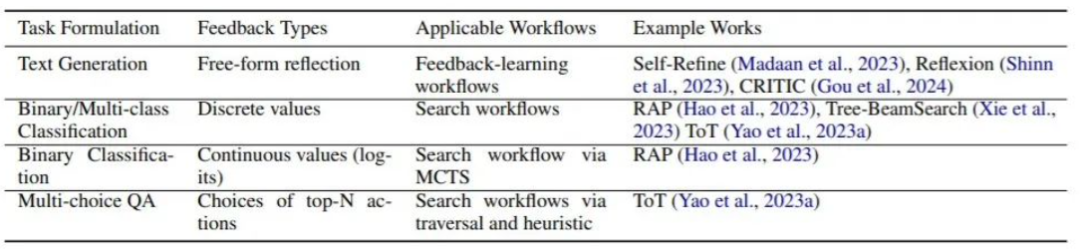

比如,有些框架需要評估類別的角色給出語言表達,而有些框架則需要數值評估,這體現了輸出形式上的差異(見下文表格)。

圖丨在不同維度下(輸入端的任務設計和輸出端的反饋類型)構建語言模型評估角色以適用於不同的工作流(來源:arXiv)

圖丨在不同維度下(輸入端的任務設計和輸出端的反饋類型)構建語言模型評估角色以適用於不同的工作流(來源:arXiv)對於第二個問題,論文歸納了面向任務時的具體人為設計,並指明一些之前被忽視的不合理之處。例如,將問答系統中的真實的回答類比為外部反饋進行反饋學習。

「儘管現有的設計框架還存在改進的空間,但我相信,隨著未來幾年研究的不斷湧現,有望能極大地促進基於大模型的智能代理在多個領域得到發展和應用。」李昕哲說。

首先,在具身智能領域(比如家居機器人),大模型能更好地促進智能體在複雜環境下對複雜問題的規劃能力。

使得開發高效的家庭服務機器人變得更加容易,它們能夠提供做家務、陪伴等多種服務。在這方面已有很多相關進展,尤其是在基於搜索算法的工作流上。

它極大地改善了簡單策略模型角色在工作流中的不足,比如解決了處理長期規劃的難題,以及避免了不合理的環節導致的崩盤。

其次,在自然語言處理和對話系統方面,基於工具和反饋的工作流能夠大大提升虛擬助手的交互和提供正確信息的能力,為用戶提供更準確和高效的服務。

以上提到的三個工作流(搜索、工具和反饋)都在論文中被系統地總結與分析,並作為切入點系統地比較各個工作流下不同的具體框架。

李昕哲認為,這種基於統一模塊化角色的系統能促進智能代理系統的開發和優化,從而促進業內廣泛的應用落地。

李昕哲是論文唯一作者。

圖丨相關論文(來源:arXiv)

實踐出真知,探索開新局

李昕哲對智能代理的研究興趣來自於他在澳州 Aurecon 公司實習期間參與的兩個項目,那時,他對智能代理還沒有明確的概念。

第一個項目是基於 ChatGPT 的檢索增強生成(RAG,Retrieval-Augmented Generation)的對話系統。

這個項目旨在通過結合檢索和生成,來提高項目團隊對內部數據庫和文檔的利用效率,主要應用於項目招標和報告撰寫。

簡單來說,RAG 系統首先根據用戶的提問進行檢索,然後將檢索到的文本與查詢一同輸入大模型生成回答。

然而,該團隊發現這種模式有時存在缺陷,例如大模型本身可能已經具備足夠的知識,無需檢索文本即可回答問題。

此外,檢索的穩定性問題也可能導致無法保證總是提供正確答案,即使查詢文檔中具備相關知識。關於這一點,李昕哲在他的另外一篇論文中 [2] 進行了詳細評估。

因此,研究人員開始思考如何讓大模型有意識地使用檢索工具,這屬於該論文提到的智能代理中基於工具調用的自主工作流設計。其中,包括美國普林斯頓大學姚順雨等研究者提出的 ReAct。

第二個項目是用戶反饋的分類。在這個項目中,他們需要將用戶反饋進行分類,如建設性反饋、無關緊要的小問題、不相關的反饋和不合規的要求。

他們最初直接詢問大模型進行分類,即論文中提到的基本工作流。但是,在某些類別上的表現較差。

於是,該團隊思考:能否對生成的結果和思維鏈進行反饋,並根據反饋結果再次分類,從而糾正思維鏈中的錯誤邏輯。

研究組採用了 Reflexion 框架,一個基於反饋的工作流讓 ChatGPT 提供反饋,但效果並不顯著。當他們具體化反饋標準後,在某些難分類別上準確率提升超過 40%。

這兩個項目讓李昕哲認識到,為了充分探索大模型的能力,構建擁有複雜工作流的智能體是必要的。

除了在以上兩個工作中關注到的 ReAct 和 Reflexion 的智能體框架,他還研究了其他多個框架。並在此基礎上,總結出 LMPRs 和工作流。

通用的工作流包括:基於工具調用、基於反饋和基於搜索的工作流。儘管相關研究不斷湧現,但從協調大模型能力的角度來看,主要工作流可以歸納為上述三種。提取這些通用工作流,是當前這份研究的重要貢獻之一。

在這個系統化的基於工作流的框架下,該課題組梳理出近期各種複雜框架的特點,主要體現在以下四個方面:

其一是引入額外模塊,在下遊任務中引入如 verbalizer 和 parser 等模塊,特別是在具身智能場景下。

其二是相同工作流設計方案的差異。例如,是否有必要在蒙地卡羅樹搜索中加入模擬器的問題。這在傳統該算法應用的任務中並現實,但在基於大模型的任務中,尤其是在文本類這種可回撤的任務中是可行。

其三是工作流實現的差異,如在思維鏈中使用特殊符號觸發工具調用、通過解耦思維鏈和工具調用來明確生成內容,或生成用於工具應用程序編程接口(API,Application Programming Interface)調用的 JSON 格式。

最後是工作流的組合形式,特別是工具調用和基於反饋的工作流的多種組合形式。

通過對這些框架的分析和總結,該課題組對大模型智能體的工作流設計有了更深入的理解,為後續的研究和應用提供了指導,尤其是系統地重構相關的代碼。

科研路漫漫,上下而求索

李昕哲本科就讀於上海師範大學酒店管理專業,起步較晚,相比同期的研究者,他的專業轉變過程更為獨特。

轉向技術領域的契機是在滴滴實習期間,由於厭倦重覆性的工作,他學習用編程自動化日常報表和數據分析流程。在此期間,還自學了大量編程和數據處理的知識。

另一個轉折點是 2018 年,在朋友的帶動下,李昕哲決定轉專業到澳州莫拿殊大學就讀信息技術專業。雖然課程主要集中在開發上,但他更喜歡數學和機器學習相關的課程。

2020 年,李昕哲在莫拿殊大學杜蘭教授的推薦下,開始在迪肯大學劉銘教授的指導下讀博,研究方向為自然語言處理。

當時,雖然深度學習在自然語言處理領域已是主流,但框架還未像現在這樣統一,神經網絡結構和訓練方式也多種多樣,而不是現在統一用 Transformers 的網絡結構端對端地訓練生成模型。

在劉銘教授、複旦大學馬興軍副教授以及山東省計算中心高龍翔教授的指導下,李昕哲的早期研究主要有以下三方面:

• 總結各類不同任務下的模型無法泛化情況,相關論文發表在國際人工智能聯合會議(IJCAI,International Joint Conference on Artificial Intelligence)2023 上。

• 研究不同神經網絡結構和泛化表示的魯棒性,相關論文發表在澳州語言技術協會年會(ALTA,Australasian Language Technology Association Conference)2021 上。

• 探討分詞方法對噪音下生成泛化表示的影響,相關論文發表在計算語言學協會年度會議與詞彙與計算語義聯合會議(ACL-SEM,Annual Meeting of the Association for Computational Linguistics – The Joint Conference on Lexical and Computational Semantics)2023 上。

通過這些研究,李昕哲意識到,特定任務訓練方式存在缺陷,因而他對這種模式持保留態度,並轉向研究基於提示的通用生成式語言模型,探索其表達能力、魯棒性以及主流的部署方式(如 RAG 和智能代理)。

目前,基於大模型的智能體雖然在蓬勃發展,但很多方向還在探索中。

在後續的研究中:

其一,他計劃進一步研究如何利用這些工具來優化智能代理行為,特別是在處理複雜任務時,不僅將大模型用作策略模型的角色,還有基於評估角色、世界模型或模擬器角色下的各種工作流。

其二,他想構建高效的、自主切換工作流的智能體。

目前,智能代理在處理多步推理時,通常需要固定的複雜工作流進行多步的大模型推斷。

然而,對於許多簡單問題,這種多步推理並不是必要的。例如,像「法國的首都是哪個城市」這樣的問題,大模型可直接回答,而不需要複雜的工作流。

李昕哲希望未來能夠構建一種高效的智能體,可根據任務的複雜性自主地切換工作流。這不僅可以提高響應速度,還可以節省計算資源。

其三,希望統一智能代理在不同任務上的工作流。

如何在代碼實現上統一智能代理在不同任務上的工作流,是一個經常被忽視,但對通用人工智能的落地至關重要。

儘管許多研究者在發表論文時會為所開發的框架命名,並闡述如何將其應用於多種任務,但實際上,在該框架下,不同任務的具體設計和代碼實現也存在差異。

所以李昕哲希望,未來能與更多具有相同想法的研究人員或團隊進一步交流,從而共同推動這一領域的發展與落地。

參考資料:

1.https://arxiv.org/pdf/2406.05804

2.https://arxiv.org/abs/2404.19232

運營/排版:何晨龍