多個中國團隊斬獲EMNLP’24最佳論文!UCLA華人學者中三篇傑出論文,明年頂會落戶蘇州

白小交 西小風 發自 凹非寺

量子位 | 公眾號 QbitAI

剛剛,EMNLP 2024最佳論文獎新鮮出爐!

5篇中榜論文中,華人學者參與三篇,分別來自CMU、上海交通大學、中國科學院大學等機構。

其中,Pretraining Data Detection for Large Language Models: A Divergence-based Calibration Method主要由中科院網絡數據科學與技術重點實驗、中國科學院大學的學者完成。

論文一作Weichao Zhang;通訊作者郭嘉豐,現任中科院網絡數據科學與技術重點實驗室常務副主任。

這項研究提出了一個新的數據集和方法,用於檢測給定文本是否為LLM預訓練數據的一部分,有助於提高LLM訓練數據透明度。

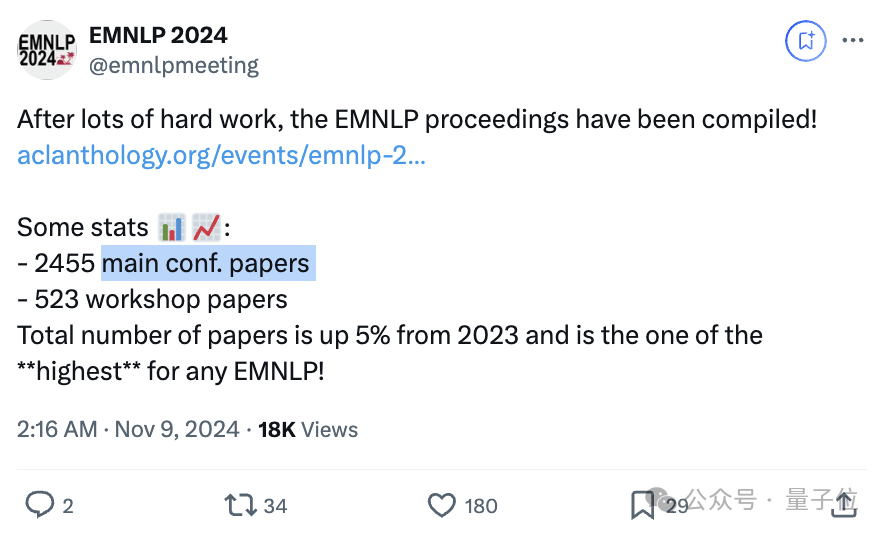

EMNLP’24今年收錄論文總共2978篇,比去年增長5%,其中2455篇主會議論文,523篇workshop論文。

除最佳論文外,傑出論文也揭曉了,超半數華人學者參與。

順便提一嘴,EMNLP 2025將於明年11月5-9日,在中國蘇州舉辦!

國內學者們可以搓搓手準備起來了~

接下來,具體康康獲獎論文有哪些~

上交大CMU等團隊獲最佳論文

此次共有5項研究成果獲得EMNLP’24最佳論文獎。

1、An image speaks a thousand words, but can everyone listen? On image transcreation for cultural relevance

(圖像能表達千言萬語,但每個人都能傾聽嗎?關於圖像再創造的文化相關性)

這篇來自CMU的論文研究了圖像跨文化再創作任務。鑒於多媒體內容興起,翻譯需涵蓋圖像等模態,傳統翻譯局限於處理語音和文本中的語言,跨文化再創作應運而生。

作者構建了三個包含SOTA生成模型的管道:e2e-instruct 直接編輯圖像,cap-edit 通過字幕和 LLM 編輯後處理圖像,cap-retrieve 利用編輯後的字幕檢索圖像,還創建了概念和應用兩部分評估數據集。

結果發現,當前圖像編輯模型均未能完成這項任務,但可以通過在循環中利用 LLM 和檢索器來改進。

2、Towards Robust Speech Representation Learning for Thousands of Languages

(為數千種語言實現穩健的語音表徵學習)

這篇來自CMU、上海交大、豐田工業大學芝加哥分校的論文,介紹了一種名為XEUS的跨語言通用語音編碼器,旨在處理多種語言和聲學環境下的語音。

研究通過整合現有數據集和新收集的數據,構建了包含 4057 種語言、超 100 萬小時數據的預訓練語料庫,並提出新的自監督任務(聲學去混響)增強模型魯棒性。研究結果顯示,XEUS 在多個下遊任務中表現優異,在 ML-SUPERB 基準測試中超越了其他模型,如在多語言自動語音識別任務中實現SOTA,且在語音翻譯、語音合成等任務中也表現出色。

該團隊超半數都是華人,其中一作William Chen目前是CMU語言技術研究所的碩士生,此前獲得佛羅里達大學計算機科學和歷史學學士學位。

3、Backward Lens: Projecting Language Model Gradients into the Vocabulary Space

(逆向透鏡:將語言模型梯度投射到詞彙空間)

瞭解基於Transformer的語言模型如何學習和調用信息成為行業一個關鍵目標。最近的可解釋性方法將前向傳遞獲得的權重和隱藏狀態投射到模型的詞彙表中,有助於揭示信息如何在語言模型中流動。

來自以色列理工學院、特拉維夫大學的研究人員將這一方法擴展到語言模型的後向傳遞和梯度。

首先證明,梯度矩陣可以被視為前向傳遞和後向傳遞輸入的低秩線性組合。然後,開發了將這些梯度投射到詞彙項目中的方法,並探索了新信息如何存儲在語言模型神經元中的機制。

4、Pretraining Data Detection for Large Language Models: A Divergence-based Calibration Method

(大語言模型的預訓練數據檢測:基於散度的校準方法)

這篇論文作者來自中科院網絡數據科學與技術重點實驗、中國科學院大學、中關村實驗室、阿姆斯特丹大學。

通訊作者郭嘉豐,現為中國科學院計算技術研究所研究員、中國科學院大學教授、北京人工智能研究院研究員,中科院網絡數據科學與技術重點實驗室主任。目前研究方向是信息檢索 (Neural IR) 和自然語言理解的神經模型。

他們的研究旨在解決大語言模型預訓練數據檢測問題,因模型開發者不願透露訓練數據細節,現有方法在判斷文本是否為訓練數據時存在局限。

基於這樣的原因,他們提出 DC-PDD 方法,通過計算文本的詞元概率分佈與詞元頻率分佈的交叉熵(即散度)來校準詞元概率,從而判斷文本是否在模型預訓練數據中。實驗在 WikiMIA、BookMIA 和新構建的中文基準 PatentMIA 上進行,結果顯示 DC-PDD 在多數情況下優於基線方法,在不同模型和數據上表現更穩定。

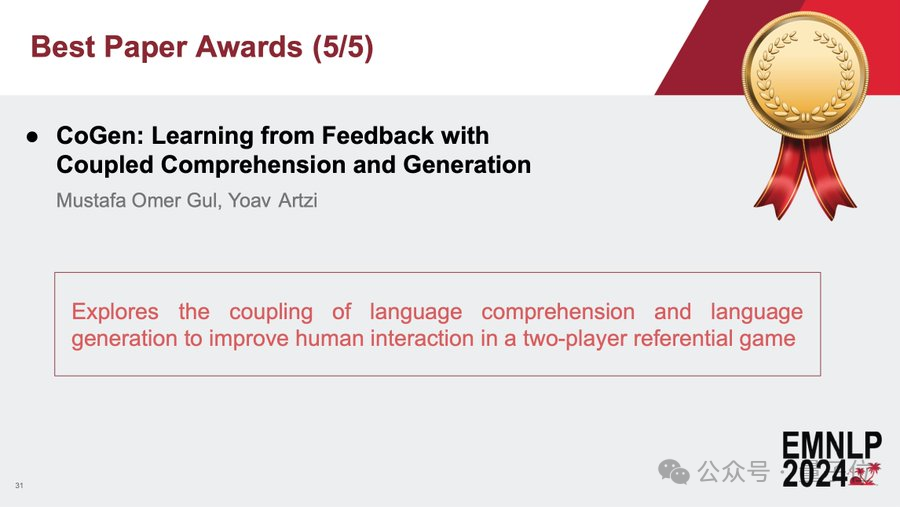

5、CoGen: Learning from Feedback with Coupled Comprehension and Generation

(CoGen,結合理解和生成,從反饋中學習)

來自康奈爾大學的研究團隊研究了語言理解和生成能力的耦合,提出在與用戶交互中結合兩者以提升性能的方法。

具體通過參考遊戲場景,部署模型與人類交互,收集反饋信號用於訓練。採用聯合推理和數據共享策略,如將理解數據點轉換為生成數據點。

實驗結果顯示,耦合方法使模型性能大幅提升,理解準確率提高 19.48%,生成準確率提高 26.07%,且數據效率更高。在語言方面,耦合系統的有效詞彙增加,與人類語言更相似,詞彙漂移減少。

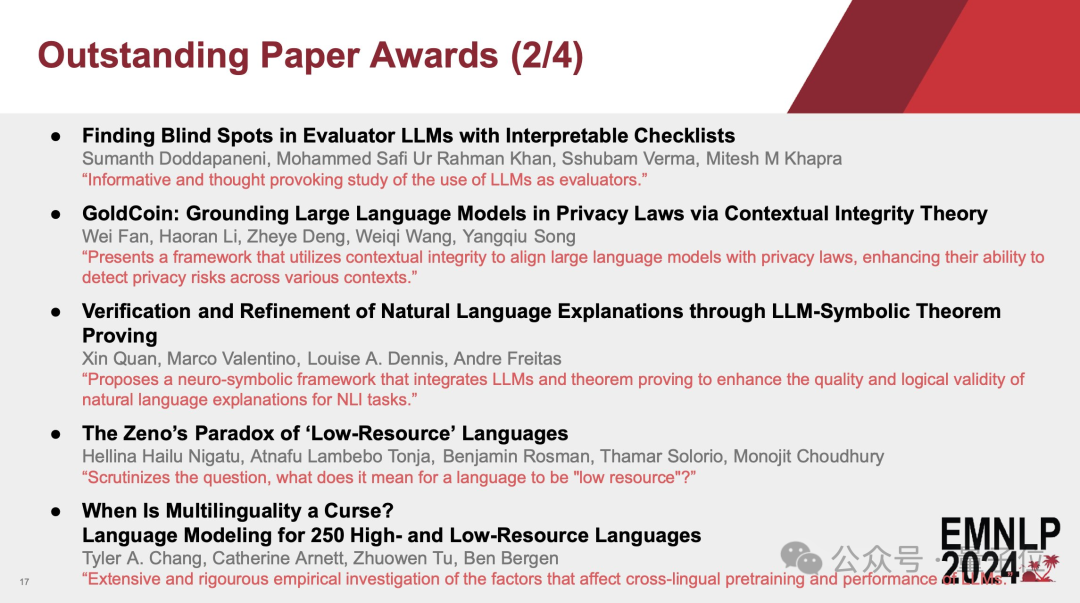

傑出論文

再來看看傑出論文的獲獎情況,此次共有20篇論文上榜。

GoldCoin: Grounding Large Language Models in Privacy Laws via Contextual Integrity Theory,香港科技大學研究團隊完成,論文共同一作Wei Fan、Haoran Li。

團隊提出了一個新框架,基於情境完整性理論來調整大語言模型使其符合隱私法律,提高其在不同情境下檢測隱私風險的能力。

Formality is Favored: Unraveling the Learning Preferences of Large Language Models on Data with Conflicting Knowledge,南京大學團隊完成,論文共同一作Jiahuan Li、Yiqing Cao。

論文研究了大語言模型在訓練數據中存在衝突信息時的學習傾向。

科技巨頭獲獎團隊有微軟,Learning to Retrieve Iteratively for In-Context Learning提出了一種創造性的方法,模擬上下文學習示例的選擇作為馬爾可夫決策過程。

Towards Cross-Cultural Machine Translation with Retrieval-Augmented Generation from Multilingual Knowledge Graphs,由Adobe、蘋果與羅馬大學研究人員聯合完成。

論文探討並挑戰了在跨文化機器翻譯中翻譯文化相關命名實體的傳統方法。

此外值得一提的是,華人學者、加州大學洛杉磯分校計算機科學系副教授Nanyun Peng團隊這次贏麻了,她參與/指導的三篇論文都獲獎了。

三項工作都是關於評估LLM在創意敘事生成方面的能力,分別為:

-

Measuring Psychological Depth in Language Models(測量語言模型中的心理深度)

-

Do LLMs Plan Like Human Writers? Comparing Journalist Coverage of Press Releases with LLMs(大語言模型能像人類作家一樣規劃嗎?通過與記者對新聞稿的報導比較來評估)

-

Are Large Language Models Capable of Generating Human-Level Narratives?(大語言模型能生成人類水平的敘述嗎?)

以下是完整獲獎名單:

最佳論文鏈接:

[1]https://arxiv.org/abs/2404.01247

[2]https://arxiv.org/abs/2407.00837

[3]https://arxiv.org/abs/2402.12865

[4]https://arxiv.org/abs/2409.14781

[5]https://www.arxiv.org/abs/2408.15992

參考鏈接:

[1]https://x.com/emnlpmeeting/status/1857176170074460260?s=46

[2]https://x.com/emnlpmeeting/status/1857173122598010918

[3]https://aclanthology.org/events/emnlp-2024/