集成500+多模態現實任務,全新MEGA-Bench評測套件:CoT對開源模型反而有害?

【導讀】MEGA-Bench是一個包含500多個真實世界任務的多模態評測套件,為全面評估AI模型提供了高效工具。研究人員發現,儘管頂級AI模型在多個任務中表現出色,但在複雜推理和跨模態理解方面仍有提升空間。

隨著人工智能技術的進步,多模態大模型正逐漸應用於多個領域,極大地提升了機器在視覺、文本等多種信息模式下的理解和生成能力。這些模型不僅用於對話、圖片標註、影片分析等較常見的任務,還被廣泛應用在複雜場景中,如程序編寫、醫療影像診斷、自動駕駛、虛擬助手中的多模態交互,甚至用於遊戲策略分析與操作應用程序。

然而,全面、系統地評測多模態大模型的能力需要投入大量的資源。

最近,加拿大滑鐵盧大學TIGER Lab的MEGA-Bench團隊的研究人員提出了一個全新的評測套件,集成了500多種任務,涵蓋廣泛的多模態任務場景,支持多種輸入和輸出格式,以一個相對較低的測試成本為模型產生詳盡的多維度分析報告,旨在為多模態模型的全面能力評估提供一個更加高效且不失全面性的工具。

項目主頁:https://tiger-ai-lab.github.io/MEGA-Bench/

論文鏈接:https://arxiv.org/abs/2410.10563

數據鏈接:https://huggingface.co/datasets/TIGER-Lab/MEGA-Bench·

排行榜:https://huggingface.co/spaces/TIGER-Lab/MEGA-Bench

代碼鏈接:https://github.com/TIGER-AI-Lab/MEGA-Bench

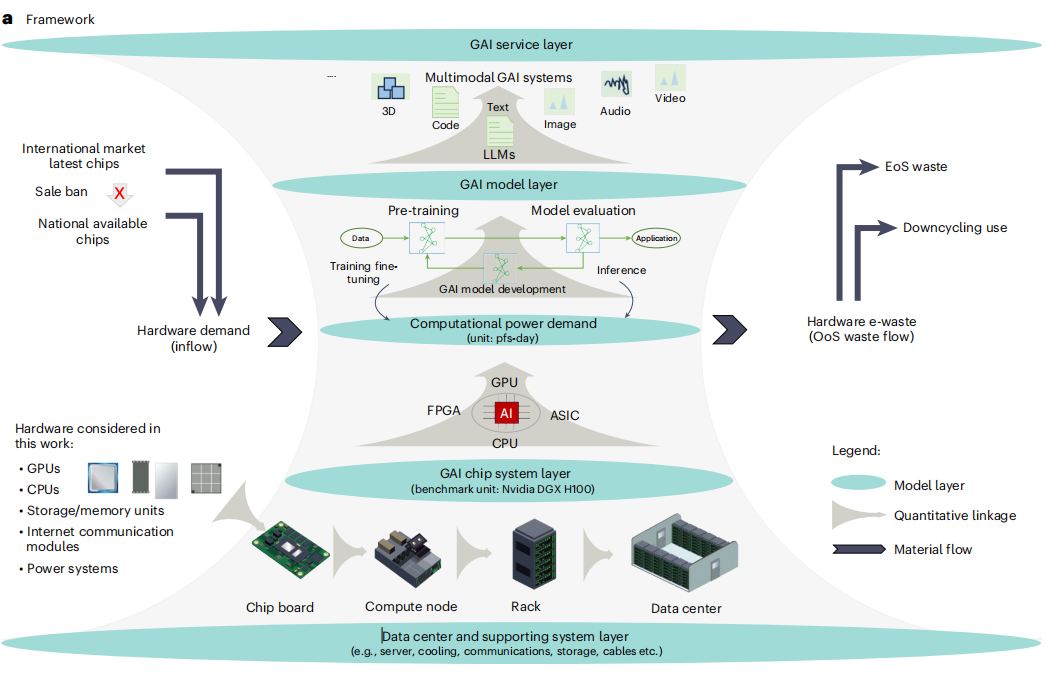

更具體的,MEGA-Bench的505個任務來自8個廣義的任務大類(如信息提取、數學、規劃、感知、代碼等,詳見圖1),如圖2所示,這些任務涵蓋7種常見的視覺輸入類型(包括了單圖,多圖,以及影片),6種不同的輸出格式,以及10種多模態核心能力;還根據任務的具體需求,定製了40餘種測試metrics

研究人員在MEGA-Bench上評估了前沿的多模態大模型並得到了一些有趣的發現:

1. 頭部商用模型中,GPT-4o與新版Claude 3.5 Sonnet獲得了幾乎一樣的總分,且多維度分析顯示,新版Claude 3.5 Sonnet與舊版相比,在規劃任務以及處理圖形界面、信息圖表類視覺輸入上性能提升明顯,與Anthropics推廣的「computer use」的應用場景相符。

2. 在開源模型中,Qwen2-VL在各維度上的性能都有明顯的領先優勢,其總分相比其他開源模型有超過10分的優勢。

3. 「思維鏈提示」(Chain-of-Thought prompting)普遍對商用模型的效果有明顯提升,卻對大部分開源模型帶來負面的效果。

三大局限

現有的評測體繫在三個方面仍存在明顯局限:

1. 輸出格式的真實性與多樣性

由於早期多模態大模型的指令跟隨能力有限,模型在回答問題時未必能按照規定格式輸出,這使得自動評估回答的準確性變得困難。為簡化評測過程,許多現有的多模態基準測試(如MMBench、MMMU)採用了選擇題形式,方便系統直接判斷回答是否正確。

然而在實際應用中,人們與模型的交互方式很少是選擇題形式,且隨著模型理解和生成能力的快速提升,這種設計顯得不夠真實。因此,評測體系需要支持更豐富且貼近實際的輸出格式,以更好地反映模型在真實場景中的表現。

2. 多模態任務的覆蓋廣度

大部分多模態數據集往往集中在單一類型的任務上,缺乏對多模態任務的廣泛覆蓋。

例如,MMMU的任務來自大學以上難度的各種不同學科的考題,MMBench、MMT-Bench主要集中於傳統視覺任務及其變種,MathVista、MathVision著重考察數學相關任務,等等。

這種局限性導致了評測時需要使用多個數據集才能涵蓋不同多模態任務,而無法通過一個統一評測集來全面且便捷地衡量模型的各方面能力。

3. 較高的測試成本

使用多個數據集進行測試不僅費時,還帶來了較高的成本。例如,不同數據集中重覆性較高的樣本導致資源浪費。

類比考試測試,高考不需要對每個學科出1000道題的試捲來評估學生在這個學科的能力,只需選擇具有代表性的題目組成一份考卷,即可在有限時間內準確區分不同學生的水平。多模態模型的評測也應朝著高效與全面的方向發展,以減少冗餘並優化資源利用。

Benchmark具體介紹

Benchmark構建過程

MEGA-Bench的構建過程始於任務分類樹的設計。首先定義了一個初步的分類樹,將任務按照大類劃分為「感知」、「規劃」和「推理」等頂層類別,每個大類下再細分為更具體的子類,如「文檔理解」、「應用理解」和「邏輯推理」等。這種自上而下的分類框架確保了任務覆蓋的廣度,並減少了重覆任務的可能性。

接下來,MEGA-Bench團隊分配了不同的分類節點給標註專家進行具體任務的設計和創建。團隊的16位標註專家來自計算機科學、電子工程、生物統計等多個領域,負責在其分配的領域內精細化任務分類樹並添加具體任務。

每個標註專家可以對分類樹進行微調,例如新增或刪除任務節點,以保證任務的獨特性和多樣性。

為簡化標註過程,研究人員開發了一系列輔助工具,包括:

1. 交互式標註工具:該工具幫助標註人員定義任務格式,並自動生成標準化的JSON文件,從而確保所有任務的格式一致性。

2. 任務提交與審核平台:通過GitHub平台管理任務的提交、審核和討論流程,類似於NLP的BIG-bench的收集流程。標註人員可以通過提交拉取請求(Pull Request)的方式更新任務,核心貢獻者則負責審核並提供反饋。

3. 可視化工具:標註專家可以實時查看模型在各個任務上的表現,這不僅幫助他們理解任務的難度,還可以根據模型反饋改進任務質量。

整個標註過程分為兩個階段:

在第一階段中,每位標註專家被要求設計20個任務,確保數據源的多樣性並提供至少15個實例。團隊對提交的任務進行了初步審核,模型的表現結果也通過可視化平台提供給標註人員,幫助他們調整任務的難度。

在第二階段中,團隊集體回顧了第一階段創建的任務,找出任務分佈的偏差以指導後續的標註、平衡任務覆蓋,最終構建出505個高質量任務和約8,200個實例。

為了確保任務的標註質量,需要隨著新任務的增加,週期性的對最先進的多模態模型(如GPT-4o和Claude 3.5 Sonnet)進行評測,以便標註人員可以直觀瞭解每個任務的難度並適當調整。

例如,對於評分接近滿分的任務,要求標註人員增加任務的難度,以避免評測時無法區分模型能力的情況;對於平均評分幾乎為零分的任務,作者手動檢查是否存在標註錯誤或者不清晰的任務指令,並將這類標註樣本刪除。

經過多輪優化,MEGA-Bench最終成為一個涵蓋全面且高效的多模態評測套件,為研究人員提供了精確且豐富的模型能力分析。

多樣化的輸出格式評估指標

為了適應不同的輸出格式,MEGA-Bench開發了豐富的評估指標。主要包括:

1. 基於規則的評分:適用於單一答案或能夠通過規則驗證正確性的任務,包括選擇題,各種帶條件的文本匹配,代碼執行結果比較,等等。

2. LLM輔助評分:對於開放式任務,使用大型語言模型(LLM)輔助對模型生成的回答進行評分,以評估生成的準確性和流暢性。這種LLM-as-a-judge的評測方式在較新的大模型評測中已相當常見。

這種評估體系使MEGA-Bench能夠靈活應對多種輸出類型,並提高了評測的準確性和靈活性。所有任務被分成兩個子集,核心集(Core set)用基於規則的評分進行評測,開放集(Open-ended set)用LLM輔助評分。

下圖給出了一些任務輸出的例子以及對應的評測指標。在標註過程中,評測指標根據新增任務的需求而「按需實現」。

其他測評集的對比

MEGA-Bench包含505個真實任務,總計8,186個標註樣本。如上表所示,與現有多模態基準相比,其在數據源、輸入輸出格式、評估指標的多樣性和任務數量上都具備顯著優勢。

這種設計使得可以通過較小的成本得到詳盡的多維度模型分析報告,不僅提升了評測範圍的廣度,也讓模型評測更加經濟高效,為多模態模型的全面分析提供了可靠便捷的工具。

評測結果與分析

主要結果與多維度關鍵詞分析

在MEGA-Bench上,研究人員對22種多模態大模型進行了廣泛的評估,包括大型旗艦模型(Flagship models)和高效版模型(Efficienty models),深入分析了它們在不同任務和維度上的表現。以下是主要的評測結果和發現:

旗艦模型的表現

在旗艦級別的大模型中,新版的Claude 3.5 Sonnet和GPT-4o表現最為優異,兩者在多個任務中展現了極強的能力。

具體來說:

1. Claude 3.5 Sonnet在規劃、數學推理等任務中表現出色,尤其在規劃相關任務(如路徑規劃、邏輯推理)上略有優勢。

2. GPT-4o在信息提取和知識密集型任務中表現更好,展現了優異的自然語言理解和信息提取能力。總的來說,新版Claude 3.5 Sonnet和GPT-4o在整體評分上接近,差異小於0.1%

開源模型的競爭力

在開源模型中,Qwen2-VL的表現尤為突出。與部分閉源旗艦模型相比,Qwen2-VL在感知任務和信息提取方面的表現相當,甚至在信息提取類任務中超越了Gemini 1.5 Pro等部分閉源模型。

此外,Qwen2-VL在整體評分上領先其他開源模型約10%,成為當前開源多模態模型中的領先者。

高效版模型的表現

在參數較小的高效版模型中,Gemini 1.5 Flash總體表現最佳,尤其在科學和度量任務上取得了出色的分數。度量類任務包括對生成式AI結果質量的評分等,通常需要深層的多模態推理和常識判斷。

然而,Gemini 1.5 Flash在用戶界面相關的輸入和信息提取任務上的表現落後於GPT-4o mini。

儘管高效模型的性能不及旗艦級模型,但其較低的計算資源需求和高性價比使其在特定應用場景中具有重要應用價值。

思維鏈提示(CoT)的效果

評測顯示,思維鏈提示(Chain-of-Thought, CoT)對旗艦級閉源模型的推理能力有較顯著的提升。

具體而言,加入思維鏈提示後,Claude 3.5 Sonnet和GPT-4o等模型能夠生成更為詳盡的推理過程,從而提高了任務的完成質量。

然而,大部分開源模型在加入CoT提示後未能表現出明顯的改進,甚至在部分任務中因生成推理過程而影響了輸出格式的準確性。

總體上,CoT提示對閉源旗艦模型效果顯著,但對開源模型的幫助有限。

更多分析

任務樣本數量的影響

為了平衡評測的覆蓋廣度、標註成本,以及評測時的計算成本,MEGA-Bench在每個任務中平均包含約15個樣本,這一設置旨在優化評估效率,但是存在導致評測結果方差較大的可能性,作者對此進行更詳細的分析(上圖左)。

通過對任務樣本數量的實驗,可以發現隨著每個任務樣本數量的增加,模型評分的方差逐漸縮小。起初的下降速遞非常快,當樣本數量達到7個以上時,方差的下降幅度明顯減緩。

從11增加到15個樣本的過程中,方差減小已不明顯。這表明在現有樣本數量下,模型評分已具備較好的穩定性。

因此,MEGA-Bench通過增加任務的廣度而非單一任務的樣本數,在覆蓋範圍和評估成本之間找到了平衡,而且沒有因此影響到評測分數的穩定性。

錯誤分析

為了深入理解當前多模態模型的不足之處,作者手動對GPT-4o在255個任務的結果進行了詳細的錯誤分析。

上圖(右)的分析結果顯示,推理能力的缺失是模型在MEGA-Bench任務上失敗的主要原因。具體來說,模型在符號推理、空間和時間推理等複雜任務上表現較弱。

此外,模型還在感知任務中出現了較高比例的錯誤,這些任務通常涉及對視覺信息的精確理解和解析。並且,還可以觀察到模型在某些任務中未能遵循指令或缺乏知識背景,這些因素導致了錯誤的回答。

GPT-4o的錯誤分佈揭示了當前的頂級多模態模型在複雜推理和跨模態理解方面的不足,為未來模型的改進提供了方向。

總結

MEGA-Bench是一個覆蓋廣泛、結構嚴謹的多模態評測套件,為全面評估多模態大模型的能力設立了新的標準。

通過多樣化的任務設計和多維度的評估指標,MEGA-Bench揭示了各類模型在實際應用中的優勢和不足。作者提供了交互式的可視化工具,便於研究者深入探索模型的表現。

此外,項目主頁提供了交互式可視化工具幫助分析,Hugging Face Space中的排行榜提供了最新的各模型詳細評分。

參考資料:

https://tiger-ai-lab.github.io/MEGA-Bench/

本文來自微信公眾號「新智元」,編輯:LRST,36氪經授權發佈。