十問月之暗面楊植麟:Kimi與字節豆包競爭,孰強孰弱? 丨 科創100人

文 丨 新浪科技 周文猛

期數:No.58

嘉賓:月之暗面Kimi創始人兼CEO楊植麟

月之暗面Kimi Chat面向全社會開放一週年之際,今年31歲的月之暗面Kimi創始人兼CEO楊植麟,再次步入媒體聚光燈下,向外界介紹了公司正在研發的新一代數學推理模型——k0-math。

當談及近期出現的“AI人才回流大廠”現象時,楊植麟直言:“倒也正常,因為行業發展進入了一個新的階段,最初很多公司在做,變成現在少一點公司在做。”在他看來,強化學習將成為人工智能最重要的方向之一,範式將發生新的變化。

值得一提的是,當被問及與字節跳動旗下豆包的競爭時,他表示,“不希望過多地去關注競爭本身,因為競爭本身並不產生價值,只有交付更好的技術和產品,給用戶創造更大的價值,才是現在最核心的問題”。

以下為楊植麟回應內容:

問:怎麼看待AI創業公司被收購、人才回流大廠的現象?

楊植麟:這個問題我們沒有遇到,但可能有一些別的公司遇到。我覺得倒也正常,因為行業發展進入了一個新的階段,它從一開始有很多公司在做,變成現在少一點的公司在做,接下來大家做的東西會逐漸不一樣,我覺得這是必然的規律,有一些公司做不下去了,就會產生這些問題,這也是行業發展的規律。

對於我們來說,其實我們主動地選擇做了業務減法,這個還是很重要的,也是我們過去一年比較大的lesson(經驗)——你應該聚焦一些重要的事情,然後做好。在幾個大模型創業公司里,我們始終保持人數最少,我覺得這個是非常關鍵的。

我們不希望把團隊擴那麼大,擴大對創新的影響有一個致命性的傷害,如果你想把團隊保持在一定的規模,其實最好的方式是業務上做一些減法。

問:你是什麼時候決定聚焦Kimi的?

楊植麟:大概今年2-3月份吧,或者3-4月份。一是基於美國市場的判斷,二是基於我們自己的觀察,主要是這兩點。還有就是做產品本身確實得做減法,不是瘋狂地做加法。

問:AI時代的超級應用似乎還沒有出現,但一大堆的智能體卻逐漸同質化了,你覺得做好一款AI應用的關鍵是什麼?

楊植麟:其實Super App已經出現了,ChatGPT已經超過5億月活,它至少是半個超級應用了,這個問題已經很大程度上被驗證了。像Character這種的產品,一開始它用戶量也蠻多,但是後面很難破圈。所以在這個過程中,我們也根據美國市場的情況,包括我們自己的觀察和判斷,聚焦在我們認為上限最高,而且跟我們AGI的願景也最相關的事情上。我們正通過這種方式去控製業務不要過多,控製人數不要太多,真正聚焦把核心的創新能力做好。

問:你們預訓練的情況是怎樣的?現在Scaling law開始撞牆變慢,你們會被限制住啊?

楊植麟:我覺得預訓練還有空間,半代到一代的模型,這個空間會在明年釋放出來,明年我覺得領先的模型會把預訓練做到一個比較極致的階段。但是我們判斷,接下來最重點的東西會在強化學習上,就是範式上會產生一些變化。但是它還是Scaling,並不是它不用Scale,只是說會通過不同的方式去Scale,這是我們的判斷。

你說Scaling law會不會是一個天花板或者上限,這個相對來說我比較樂觀一點,核心就在於原來你用靜態數據集,這其實是比較簡單粗暴地使用方式,現在用強化學習的方式,很多情況下是有人在參與這個過程的,但是人沒有辦法給你標註那麼多數據,不可能把每道題具體的思路都標出來,所以你其實用AI本身把人的東西加上一個杠杆。比如,你標100條數據,你就能產生非常大的作用,因為剩下的他都是在自己思考,我覺得更多的會用這種方式去解決。

我覺得從做法上來說,確定性是比較高的,很多時候是真正把它調出來的過程,所以我現在覺得這個大概率可以通過這種方式去做出來,所以我覺得它上限是很高的。

問:你們怎麼看自己跟字節跳動旗下豆包的競爭?

楊植麟:我們還是更希望關注怎麼能給用戶真正的價值,我不希望我們過多地去關注競爭本身,因為競爭本身並不產生價值,我覺得我們只有交付更好的技術和產品,給用戶創造更大的價值,這是我們現在最核心的問題。我們會更聚焦怎麼提升模型的思考推理能力,通過這個東西給用戶帶來更大的價值,就是做正確的事情,而不專門去做不一樣的事情,因為我覺得只要能有人實現AGI,它都是非常好的結果。

問:月之暗面現在最核心的任務是什麼?

楊植麟:最核心的任務就是提升留存,或者把留存作為一個重要的衡量指標。因為我覺得基本上它跟你的技術的成熟度或者技術的水平也是一個正相關的過程,所以這個對我們來說當前是最重要的。

我覺得現在我們還處於AGI的初級階段,當然每年都有一些比較大的進步,如果我們今年用去年的產品,你會發現可能根本沒法忍受,但是可能還有很多東西,比如說我剛剛說的思考能力還不夠強,交互不夠豐富,所以它今天能做的交互還比較有限。

這個交互可能是兩個維度的,一個是跟用戶的交互,一個是跟客觀世界的交互,我覺得都還有很大的提升空間。當我們把這兩個做好之後,留存也會進一步上升。

問:OpenAI o1模型發佈後,您曾提及大模型範式從訓練的scaling轉到推理的scaling,月之暗面在看到這個趨勢後,在技術和產品上做了哪些調整?

楊植麟:o1的變化其實是可以預測的,我們很早就說,接下來推理占的比例會遠超訓練,本質上這說的是一個事情,因為它基本上是必然的。你如果去分析的話,它是必然會產生的,你沒有那麼多數據訓練,你肯定是要生成數據,生成數據肯定是強化學習,本質是一樣的。

我覺得這個是我們很早看到的,只不過在早期預訓練的很多紅利沒有被完全發揮出來,所以你可能很關注怎麼通過Next—Token prediction能壓縮出更多的智能。

問:你們在這上面做佈局,具體大概什麼時間段?

楊植麟:人才上我們從去年就開始,中間也會有不同的過程,比如說一開始是LHF,標準的LHF,那個東西上線率並沒有那麼高,你可能還要去探索一些新的方式,真正更加規模化的方式,我覺得會有這樣的過程。

問:你去年說長文本是登月的第一步,你覺得數學模型和深度推理是第幾步?

楊植麟:第二步。

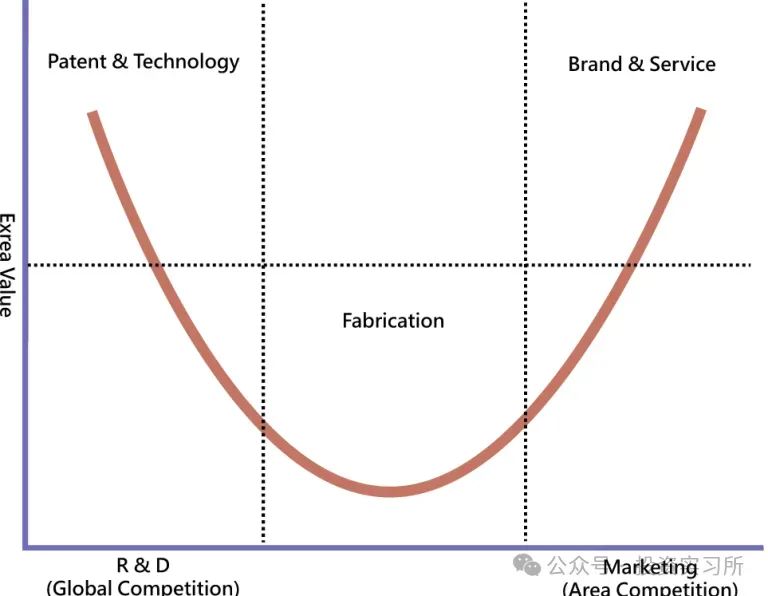

問:預訓練的Scale現在可能遇到瓶頸了,美國遇到瓶頸後對中美大模型的格局影響是什麼?對於中國公司來說是好事還是壞事?

楊植麟:對我們來說它有可能是一個好事。假設你一直預訓練,你的預算今年1B(billion)、明年10B或者100B,它不一定可持續。當然你做推理也要Scaling,只是說你Scaling的起點很低,在一段時間內你的算力就不會是瓶頸,這個時候你的創新能力是更重要的,在這種情況下我覺得對我們反而是一個優勢。