AI「規模暴力」真的失效了嗎?

近期,圍繞Scaling Law的討論不絕於耳。

起因是,The information在一篇文章指出,OpenAI下一代旗艦模型Orion(或稱GPT-5)相較於現有模型,能力提升「有限」(代碼能力甚至不如現有模型),遠不如GPT-3到GPT-4的躍升,而且Orion在數據中心的運行成本更高。為此,OpenAI不得不連夜轉變策略。

如果其所言非虛,就不會只有OpenAI一家被困擾。

果不其然,Google也「出事」了。其下一代Gemini模型原本應該是一次重大升級,但有員工透露:近期在大幅增加資源投入後,模型性能未達到領導層預期,團隊連夜調整策略。

與此同時,Anthropic被曝已暫停推進Opus 3.5的工作,官網還撤下了「即將推出」字樣。

「三巨頭」接連碰壁,讓人聯想到:Scaling Law可能失效了?

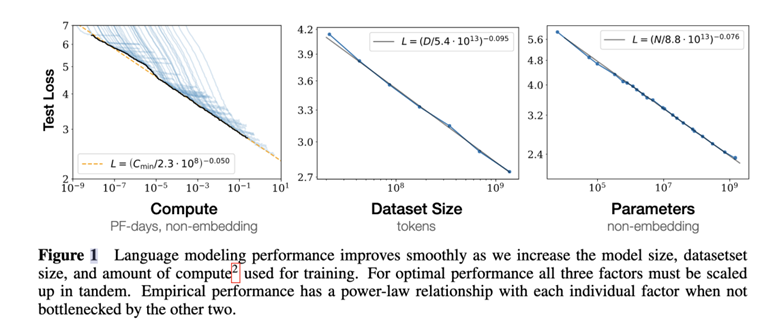

Scaling Law,即尺度定律,稱得上AI行業的大模型第一性原理。

2020年,OpenAI在論文Scaling Laws for Neural Language Models提出該定律。其核心的觀點是,影響大模型性能的三大要素:計算量、數據集大小、模型參數量。當不受其他兩個因素製約時,模型性能與每個單獨的因素都存在冪律關係。

只要Scaling Law成立,意味著「更大更好」「大力出奇蹟的暴力美學」——大模型的能力可以通過堆更多的算力、搞更多的參數,喂更多的數據得到大幅提升。

如今,當模型規模和成本大幅增加,但實際性能卻提升「有限」時,Scaling Law神話是否會被終結?

一、正方:Scaling Law神話終結

Ilya Sutskever:擴展訓練的結果,已經趨於平穩

作為Scaling Law的早期倡導者之一,前OpenAI首席科學家Ilya Sutskever表示,擴展訓練的結果,已經趨於平穩。即,傳統的無監督Pre-training已達極限。

他說,2010年代是Scaling的時代,現在我們再次回到發現奇蹟的時代。每個人都在尋找下一個奇蹟。現在重要的是擴大「正確」的規模。

何謂「正確」?Ilya表示,SSI正在研究一種全新的替代方法,來擴展預訓練。

雖然他沒有透露新方法是什麼,但根據OpenAI和Google的嘗試,或許可以窺探一二。

OpenAI的研究人員開發推理模型(reasoning models)等新技術,用於彌補傳統訓練方法的局限性。

Google也效仿這一思路。近幾週,DeepMind在Gemini團隊內組建了一個由首席研究科學家Jack Rae和前Character.AI聯創Noam Shazeer領導的小組,專注於開發類似能力。

此外,DeepMind團隊還在手動優化模型性能,包括調整超參數(hyperparameters)等變量。這些超參數決定了模型處理信息的方式,例如,迅速在訓練數據中建立概念或模式之間的聯繫。研究人員通過「模型調優」測試不同的超參數,以確定哪些變量將帶來最佳效果。

Arvind Narayanan & Sayash Kapoor:合成數據作用不大

今年6月,普林斯頓大學計算機科學教授Arvind Narayanan與其博士生Sayash Kapoor發表了一篇文章AI scaling myths。文章指出,Scaling「崇拜論」是建立在一系列誤解之上。

第一,什麼是「更好的」模型?具有「湧現能力」的模型。

Scaling僅僅將困惑度(perplexity)下降進行了量化,即模型能夠預測下一個單詞。然而,對最終的用戶而言,困惑度幾乎毫無意義——真正重要的是模型規模增長時,模型呈現出的「湧現能力」,即模型隨著大小增加而獲得新能力的趨勢。

問題在於,「湧現能力」不受任何類似定律的支配。

為什麼「湧現能力」不能無限持續?這一問題直指關於LLM能力的核心爭議:LLM究竟能否進行外推,還是只會學習訓練數據中已有的任務?現有證據尚不完整,不同研究者各執一詞。但Arvind Narayanan團隊傾向於懷疑態度。在一些專門測試LLM解決新任務能力的基準測試中,其表現往往較差。

如果LLM無法超越訓練數據中的內容,就會進入每一個傳統的機器學習模型最終都會進入的平台期。

第二,更多的數據從哪裡來?

有人認為,新的數據源(例如將YouTube轉錄為文本)可以增加一兩個數量級的可用數據量。確實,YouTube包含約1500億分鐘的影片內容。然而,考慮到其中大部分影片缺乏可用的音頻(例如音樂、靜止圖像或遊戲畫面),經過去重、質量過濾後,實際可用的訓練數據遠少於Llama 3所使用的15萬億tokens。

退一步說,關於「數據耗盡」的討論並不合理。訓練數據永遠有,只是成本越來越高,比如版權、監管等等。

對於LLM而言,我們可能還有幾個數量級的擴展空間,也可能擴展已經結束了。如今,研究的重點已從構建更大數據集,轉向提高訓練數據的質量。通過精心的數據清理和過濾,可以用更小的數據集構建出同樣強大的模型。

第三,合成數據不是萬能魔藥。

還有一個觀點,利用現有模型生成訓練數據。

這個觀點同樣存在誤區——開發者並未(也無法)利用合成數據顯著增加訓練數據的總量。

一篇論文詳細列出了合成數據在訓練中的用途——主要集中在彌補特定領域的不足,例如數學、編程、低資源語言的優化。同樣,英偉達最近推出的Nemotron 340B模型,專注於生成合成數據,是將對齊作為其主要用途。雖然它也有一些其他用途,但取代現有預訓練數據源並不在其中。

換句話說,盲目靠生成大量合成數據,無法達到高質量人類數據所具備的效果。

儘管如此,合成訓練數據在某些場景中取得了巨大成功,例如2016年AlphaGo 擊敗圍棋世界冠軍,以及其後續版本 AlphaGo Zero 和 AlphaZero 的表現。這些系統通過自我對弈學習,後兩者甚至能自己生成高質量棋局。

自我對弈是「系統2->系統1蒸餾」的經典案例,即通過一個緩慢且昂貴的「系統2」生成訓練數據,用於訓練快速且廉價的「系統1」模型。

這種方法在圍棋這樣完全封閉的環境中表現出色,將其推廣到遊戲之外的領域仍然是一個有價值的研究方向。在某些重要領域(如代碼生成)中,這一策略或許可以發揮作用。然而,我們不能指望在更開放的任務(如語言翻譯)上實現類似的無限自我改進。可以預見,通過自我對弈實現大幅提升的領域將是特例,而非普遍規律。

二、反方:Scaling Law沒有牆

OpenAI CEO Sam Altman:there is no wall

前方The information擾亂軍心,後方Sam Altman在X平台上發言——there is no wall。

近期,他在Reddit的Ask Me Anything上也表示,OpenAI將在今年晚些時候發佈「非常好的版本」。

只不過,鑒於「草莓」炒作的影響、Ilya Sutskever的威望,以及OpenAI的當前表現,Altman的話難免有「挽尊」之嫌。

微軟AI主管Mustafa Suleyman:不會有任何放緩

Suleyman在近期採訪中表示:模型的規模既在變大,也在變小,這種趨勢會持續下去。去年開始流行一種新方法,稱為蒸餾。這類方法利用大型、高成本模型來訓練小型模型。這種監督效果相當不錯,目前已有充分的證據支持這一點。因此,規模仍然是這場競爭中的關鍵因素,未來還有很大的發展空間,數據量也將持續增長。至少在接下來的兩三年內,Scaling Law在提供超預期表現方面的進度不會有任何放緩。

微軟CEO Satya Nadella:是定律,並且一直有效

今年10月21日,在微軟AI之旅倫敦站活動上,Satya Nadella在演講中表示:Scaling Law是經驗觀察所得,但它被我們稱作定律,並且一直有效。

微軟CTO Kevin Scott:讓其他人想去吧

今年7月,微軟首席技術官Kevin Scott在接受紅杉資本合夥人採訪時表示:儘管其他人可能這樣想,但是我們在規模化上並沒有遇到邊際收益遞減的情況。

前GoogleCEO Eric Schmidt:沒有證據顯示

11月14日,前GoogleCEO Eric Schmidt在播客中表示:沒有證據表明Scaling Law已經開始停止。他預測在未來五年,人工智能系統的能力將是現在的100倍,能夠在物理和數學領域進行推理。

Abacus.AI CEO Bindu Reddy:是技術太成熟了

Bindu Reddy表示,所謂的AI減速實際上無關緊要。主要原因在於AI技術發展的潛力已經幾乎在各類基準測試中得以體現。當達到100/100的高分時,就很難再找到新的突破方向。因此,AI 市場的「放緩」更多地反映了技術成熟度,而非創新能力的不足。(你信嗎?)

三、Scaling Law 2.0:token越多,精度也要越高

無論各位如何「挽尊」,都掩蓋不了大模型「減速」的事實——感受不到當初的驚豔。

或許,還有其他辦法。

近期,來自哈佛大學、史丹福大學、麻省理工等機構的合作團隊發表了一篇題為Scaling Laws of Precision的論文,引發瘋狂討論。

研究提出:精度在模型擴展規律中比之前認為的更加重要,可以顯著影響語言模型的性能。在以往描述模型性能隨參數量和訓練數據量變化的擴展規律,基本忽略了精度這一因素。隨著模型規模的不斷擴大,低精度的量化或將不再有效。

首先,通過實驗,研究人員製訂了新的精度縮放定律。另一項重要發現則提出了預訓練期間計算的最優精度。根據該研究,當同時優化參數數量、數據和精度時,這一精度通常與計算預算無關。

其次,普遍採用的16位模型訓練法並非最優,因為很多位是多餘的。然而,使用4位進行訓練則需要不成比例地增加模型大小,以維持損失縮放。研究人員的計算表明,對於較大的模型而言,7—8位是計算最優的。

當模型大小從一開始就固定時,情況就會發生變化:更大且更好的模型應以更高的精度進行訓練——例如,使用16位的Llama 3.1 8B模型。實際的計算節省還取決於硬件對更低精度的支持。此外,這裏研究的模型(參數最多達17億個)尚未在最大的實際規模上進行測試。不過,這些一般趨勢仍然適用於更大的模型。

CMU教授Tim Dettmers表示,這是長久以來最重要的一篇論文。他認為,人工智能的大部分進步都來自計算能力的提升,而(最近)這主要依賴於低精度路線的加速(32->16->8位)。現在看來,這一趨勢即將結束。再加上摩亞定律的物理限制,大模型的大規模擴展可以說要到頭了。他預計,隨著低精度帶來的效率提升達到極限,將出現從純規模擴張向專用模型和人本應用的轉變。

AGI路漫漫。不過,大家無需灰心。

退一萬步,正如OpenAI研究人員Steven Heidel所言,就算現在LLM停滯了,在當今模型的基礎上,還有至少十年的產品等著你去開發。

是不是又幹勁十足了?

參考:

1、Scaling Laws終結,量化無用,AI大佬都在審視這篇論文,機器之心

2、新Scaling Law浮出水面!OpenAI內部員工爆料下一代模型Orion性能堪憂;量化Llama3困難,這些都有了新解,51CTO技術棧

本文來自微信公眾號:適道,作者:適道AI組,編輯:獅刀