經典卡爾曼濾波器改進影片版「分割一切」,網民:好優雅的方法

金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

Meta的影片版分割一切——Segment Anything Model 2(SAM 2),又火了一把。

因為這一次,一個全華人團隊,僅僅是用了個經典方法,就把它的能力拔到了一個新高度——

任你移動再快,AI跟丟不了一點點!

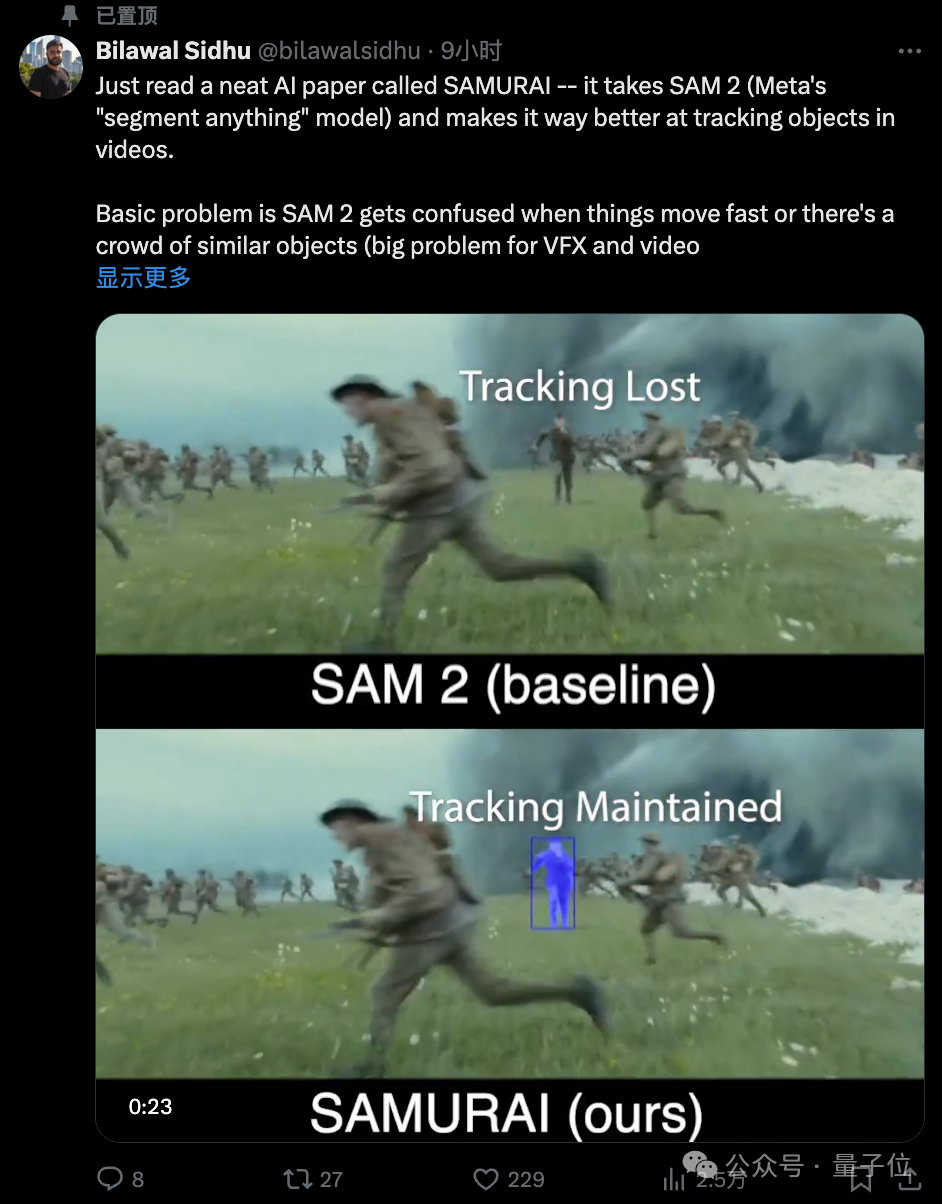

例如在電影《1917》這段畫面里,主角穿梭在眾多士兵之中,原先的SAM 2表現是這樣的:

嗯,當一大群士兵湧入畫面的時候,SAM 2把主角給跟失了。

但改進版的SAM 2,它的表現截然不同:

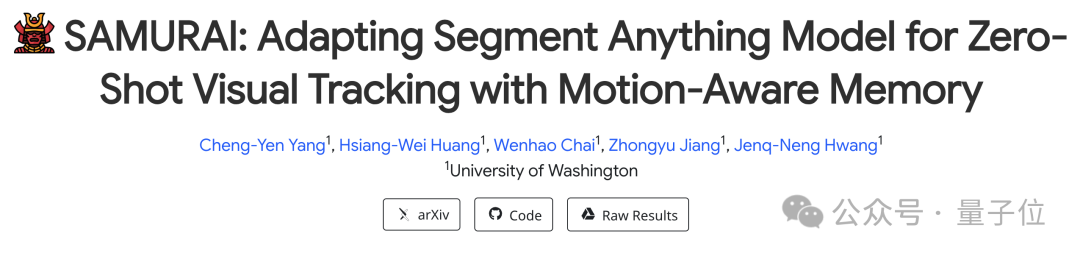

這個改進版的SAM 2,名叫SAMURAI(武士),由華盛頓大學全華人研究團隊提出。

一言蔽之,這項工作就是把SAM 2之前存在的缺點(記憶管理方面的局限性)給填補上了。

更有意思的是,這項改進工作所用到的核心關鍵方法,是非常經典的卡爾曼濾波器(Kalman Filter,KF)。

並且還是無需重新訓練、可以實時運行的那種!

前Google產品經理、國外知名博主Bilawal Sidhu在看完論文後直呼「優雅」:

有時候你不需要複雜的全新架構——只需要聰明地利用模型已知的信息,再加上一些經過驗證的經典方法。

我們的「老朋友」卡爾曼濾波器,這麼多年過去了,它的表現依然如此出色。有時候老派的方法就是管用。

嗯,頗有一種「薑還是老的辣」的感覺了。

黑悟空、女團舞蹈,統統都能hold住

我們先繼續看下SAMURAI能力實現的更多效果。

團隊在項目主頁中便從多個不同維度秀了一波實力。

首先就是打鬥遊戲場景,例如在《隻狼:影逝二度》中,即便人物都「彈出」了畫面,SAMURAI也能再次把目標捕捉回來:

《黑神話:悟空》的打鬥名場面,人物動作變化可以說是非常之快,而且和背景非常複雜的交織在一起。

即便如此,SAMURAI也能精準跟蹤,細節到金箍棒的那種:

但畢竟這兩個遊戲場景的例子,所涉及到的主體還不夠多,那麼我們接下來繼續看下更複雜的case。

例如橄欖球比賽場景,不僅人物移動的快,後來隊員們都撲到了一起,SAMURAI也能hold住:

在女團舞蹈的案例中,人物在變換隊形的時候都已經被其他隊員擋住了,也擋不住SAMURAI的「眼神鎖定你」:

很work的經典方法

在看完效果之後,我們接下來扒一扒SAMURAI的技術細節。

正如我們剛才提到的,這項工作彌補了SAM 2此前存在的缺點。

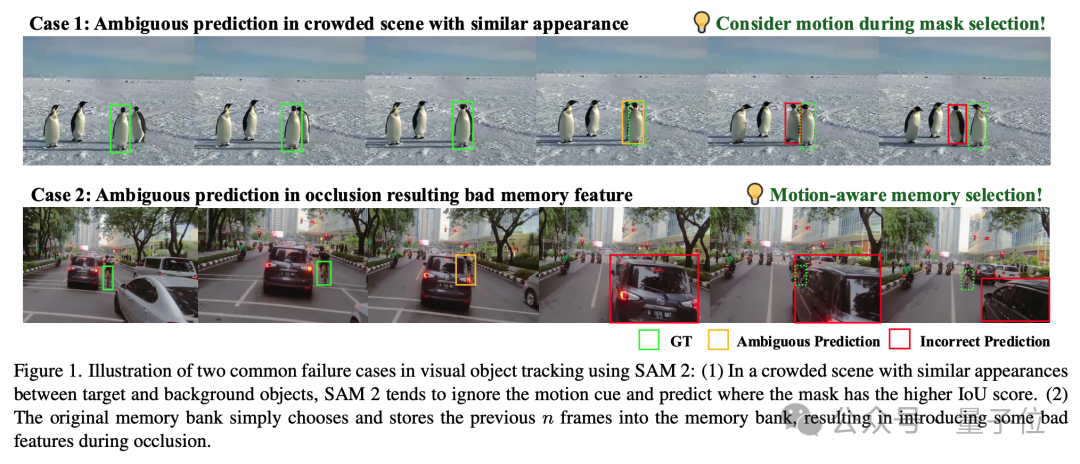

主要的問題就是處理視覺目標跟蹤時,尤其是在擁擠場景中快速移動或遮擋的物體時,它會出現跟失了的情況。

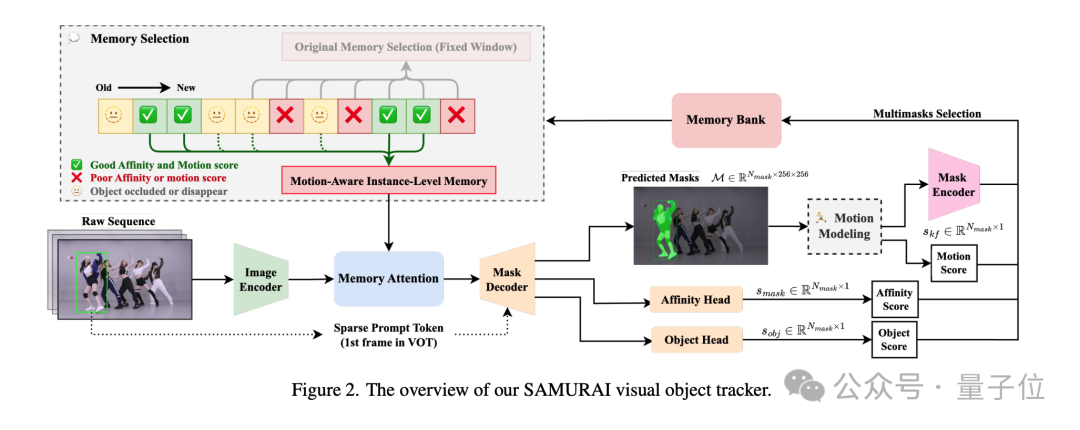

SAM 2的組成部分包括圖像編碼器、掩碼解碼器、提示編碼器、記憶注意力層和記憶編碼器。

在視覺目標跟蹤中,SAM 2使用提示編碼器來處理輸入的提示信息,如點、框或文本,這些提示信息用於指導模型分割圖像中的特定對象。

掩碼解碼器則負責生成預測的掩碼,而記憶注意力層和記憶編碼器則用於處理跨幀的上下文信息,以維持長期跟蹤。

然而,SAM 2在處理快速移動的對象或在擁擠場景中,往往忽視了運動線索,導致在預測後續幀的掩碼時出現不準確。

特別是在遮擋發生時,SAM 2傾向於優先考慮外觀相似性而非空間和時間的一致性,這可能導致跟蹤錯誤。

而SAMURATI,作為SAM 2的增強版,可以說是很好地解決了此前的痛點。

整體來看,SAMURAI主要包含兩個技術關鍵點:

-

運動建模(Motion Modeling)

-

運動感知記憶選擇(Motion-Aware Memory Selection)

讓目標「動」起來

運動建模部分的目的是有效地預測目標的運動,從而在複雜場景中,如擁擠場景或目標快速移動和自遮擋的情況下,提高跟蹤的準確性和魯棒性。

而這裏用到的具體方法,就是那個經典的卡爾曼濾波器,以此來增強邊界框位置和尺寸的預測,從而幫助從多個候選掩碼中選擇最有信心的一個。

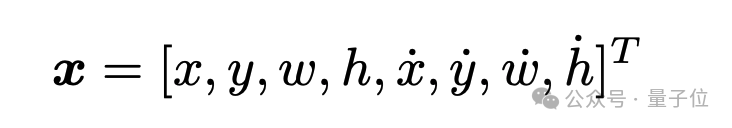

在SAMURAI中,狀態向量包括目標的位置、尺寸及其變化速度;通過預測-校正循環,卡爾曼濾波器能夠提供關於目標未來狀態的準確估計。

目標的狀態向量被定義為:

其中,x和y表示目標邊界框的中心坐標;w和h表示邊界框的寬度和高度;後四個變量則表示坐標與尺寸的速度。

濾波的過程則主要分為兩個步驟。

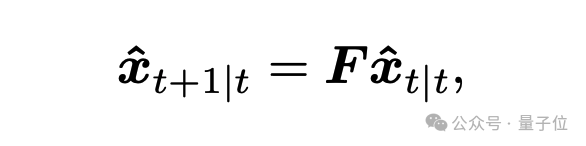

第一個就是預測階段,即根據目標的上一幀狀態,預測下一幀位置:

其中,F是狀態轉移矩陣。

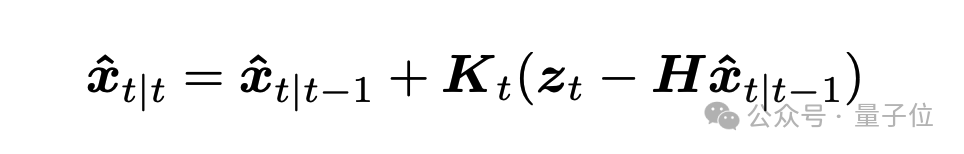

第二個則是更新階段,會結合實際測量值(目標的候選掩膜),校正預測值:

在運動建模部分,除了基於卡爾曼濾波器的運動預測之外,還涉及運動分數(Motion Score)。

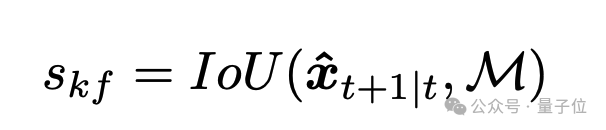

主要是通過計算 Kalman 濾波器預測的邊界框與候選掩膜之間的交並比(IoU),生成運動分數sKf,用以輔助掩膜選擇:

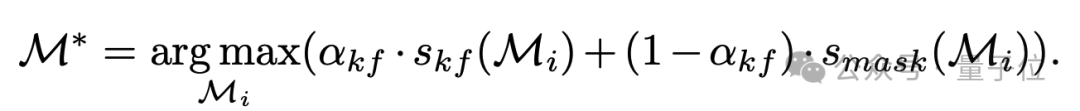

最終的掩膜選擇基於運動分數與掩膜親和分數的加權和:

挑出最關鍵的記憶

SAMURAI第二個關鍵技術,則是運動感知記憶選擇(Motion-Aware Memory Selection)。

主要是為瞭解決SAM 2的固定窗口記憶機制容易引入錯誤的低質量特徵,導致後續跟蹤的誤差傳播的情況。

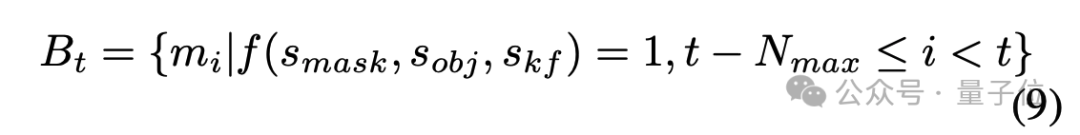

這部分首先涉及一個混合評分系統,包括掩膜分數、目標出現分數和運動分數三種評分,用於動態選擇記憶庫中最相關的幀。

-

掩膜分數smask:衡量掩膜的準確性。

-

目標出現分數 sobj:判斷目標是否存在於該幀中。

-

運動分數 skf:預測目標位置的準確性。

其次是一個記憶選擇機制——

如果某幀滿足以下條件,則其特徵會被保留到記憶庫中:

動態選擇的記憶庫可以跳過遮擋期間的低質量特徵,從而提高後續幀的預測性能。

從實驗結果來看,SAMURAI在多個視覺目標跟蹤基準上表現出色,包括 LaSOT、LaSOText和GOT-10k數據集。

值得一提的是,SAMURAI是在無需重新訓練或微調的情況下,在所有基準上都超過了SAM 2,並與部分有監督方法(如 LoRAT 和 ODTrack)表現相當。

全華人團隊出品

SAMURAI這項工作背後的研究團隊,有一個亮點便是全華人陣容。

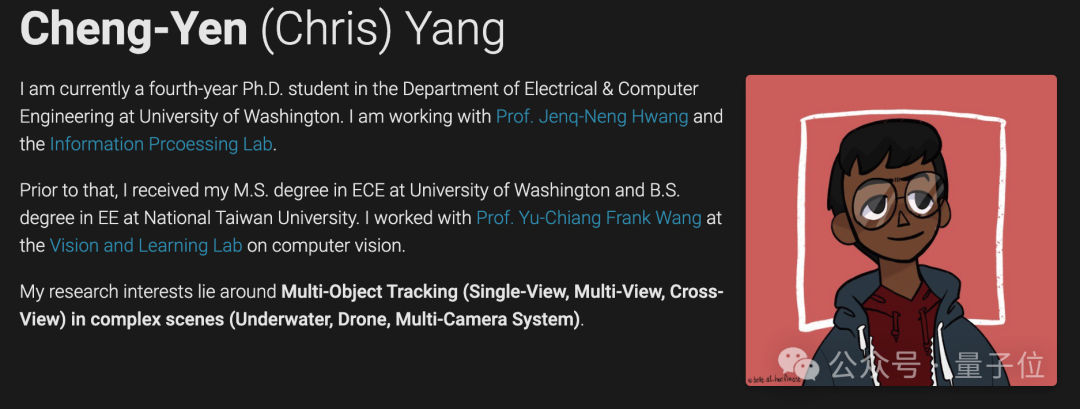

例如Cheng-Yen Yang,目前是華盛頓大學電氣與計算機工程系的一名四年級博士生。

研究方向主要包括在複雜場景(水下,無人機,多相機系統)中的多目標跟蹤(單視圖,多視圖,交叉視圖)。

Hsiang-Wei Huang和Zhongyu Jiang也是華盛頓大學電氣與計算機工程系的博士生,而Wenhao Chai目前則是攻讀研究生。

他們的導師是華盛頓大學教授Jenq-Neng Hwang。

他是IEEE信號處理協會多媒體信號處理技術委員會的創始人之一,自2001年以來,黃教授一直是IEEE院士。

項目地址:

https://yangchris11.github.io/samurai/

論文地址:

https://arxiv.org/abs/2411.11922

參考鏈接:

[1]https://x.com/EHuanglu/status/1860090091269685282

[2]https://x.com/bilawalsidhu/status/1860348056916369881