超越 GPT-4o:開源科研模型 OpenScholar 登場,4500 萬篇論文檢索增強生成回答

只需幾秒鍾,開源模型檢索 4500 篇論文,比 GPT-4o 還可靠!

這就是由華盛頓大學和艾倫人工智能研究所(Ai2)打造的最新模型 OpenScholar。它還是首個從論文到數據集、模型檢查點都完全開源的科研助手模型。

在由 20 位專家進行的 500 次對比實驗中,72% 的情況下他們都覺得 OpenScholar 的輸出結果超越了人類。

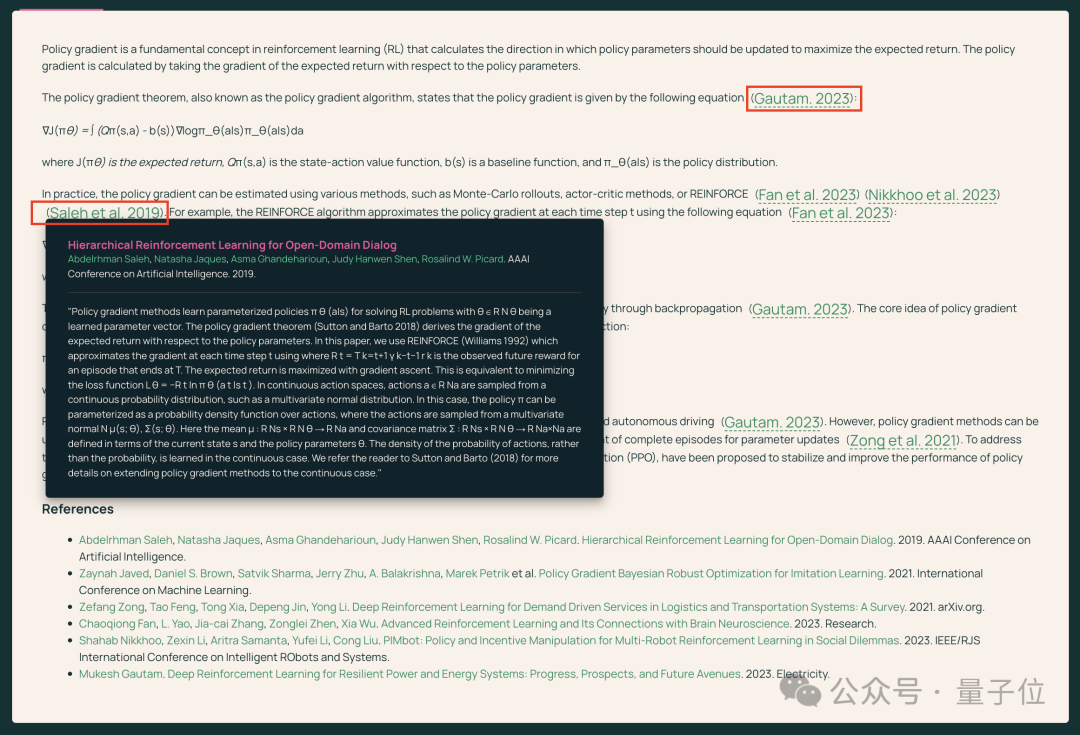

而且 OpenScholar 還會附上參考文獻列表,非常貼心:

它的功能也非常豐富。

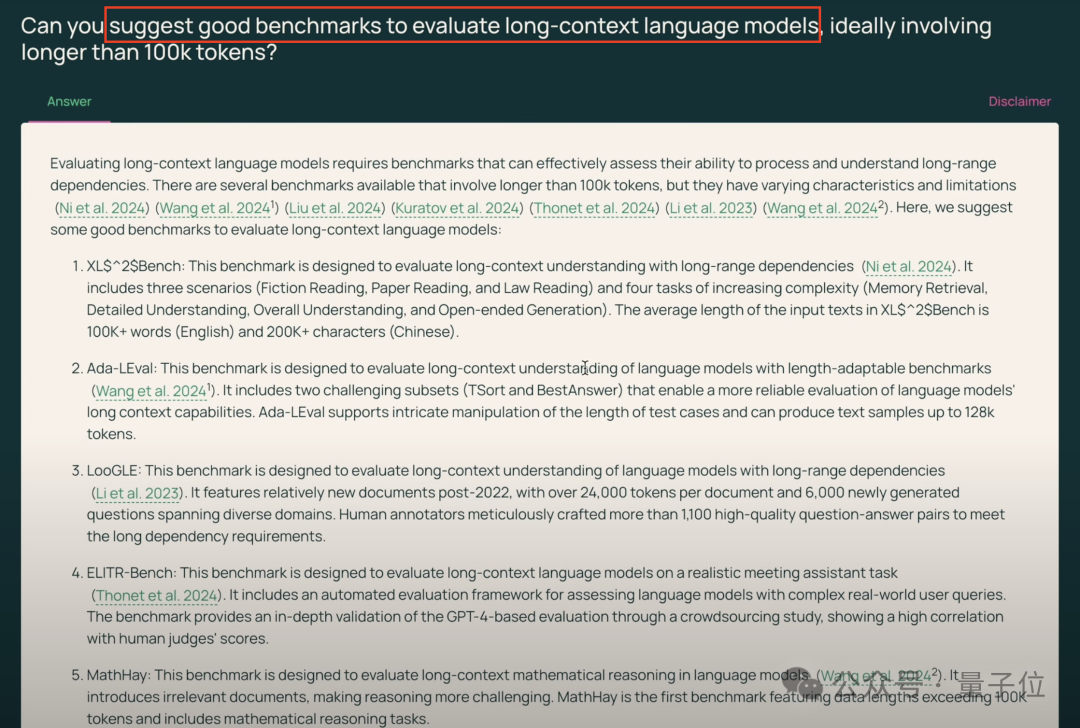

你可以詢問 OpenScholar 某個研究課題的現狀:「有沒有人嘗試過將檢索增強型 LM 的檢索庫擴大到萬億級 tokens?」

尋找最新的數據集:

針對某篇論文詢問技術細節:

或者詢問算法的細節,比如機器人算法 / ReLU 算法等等:

有多位網民使用過後表示:做複雜課題也能快速蒐集有用的資料,真是科研神器!

僅調用 8B 模型

一句話總結:它存儲了 4500 萬篇論文的大規模數據,並使用自定義訓練的檢索器、重排器和 8B 參數語言模型進行檢索,並根據最新的科學文獻內容回答問題。

具體來說,OpenScholar-8B(OS-8B)系統包括以下組件:

-

1.開放學者數據存儲:包含超過 4500 萬篇論文、以及對應的約 2.5 億段落嵌入。底層論文數據截止到 2024 年 10 月。

-

2.專業檢索器和重排序器:這些工具專門用於從科學文獻數據存儲庫中識別相關段落。

-

3.專業 8B 語言模型:這是一個針對科學文獻綜合任務優化的 8B 參數語言模型,在性能與計算效率之間取得了很好平衡。團隊基於來自迭代自我反饋生成管道生成的合成數據訓練並微調了 Llama 3.1 8B。

-

4.迭代自我反饋生成:在推理過程中,團隊使用迭代自我反饋來通過自然語言反饋精煉模型輸出。每次迭代都額外檢索更多論文,使模型能夠提高回答質量並縮小引用差距。

為了評估 OpenScholar,團隊還開發了 ScholarQABench—— 一個專門用於評估從多篇論文中綜合信息以解決開放式科學問題的基準。

ScholarQABench 包含七個數據集:三個專注於單篇論文評估的現有數據集,以及四個需要跨多篇論文綜合的新收集數據集。

最終在實驗自動評估以及人工評估中,OpenScholar 模型的表現優於很多主流模型,包括 GPT-4o 和 Llama 3.1 70B。

搜索的可靠性方面,OpenScholar 更是遠超 GPT-4o。

GPT-4o 在 90% 以上的情況下都引用了不存在的論文,而 OpenScholar 的結果都是來自確定來源。

以及在信息覆蓋率、實用性、相關性等多個維度方面,OpenScholar 撰寫的結果都優於 GPT-4o。

運營成本便宜 100 倍

對比基於 OpenAI 的 GPT-4o 和 Anthropic 的 Claude 的科研模型可以發現,它們雖然性能很強,但價格昂貴、而且工作原理也不透明。而 OpenScholar 正是為了挑戰這些現有的大模型玩家入局的!

據開發人員稱,OpenScholar 是首個完全開源的科學助手語言模型 —— 從數據到訓練食譜再到模型檢查點,全部公開!

研究人員可以非常清除地看到模型的訓練過程和數據集的內容等,也可以根據自己的工作進行調整。

這樣一來,規模較小、架構簡單的 OpenScholar-8B 的運營成本比基於 GPT-4o 構建的同期系統 PaperQA2 便宜 100 倍。

對於小型機構、資金不足的實驗室以及發展中國家的研究人員來說,這樣的運營成本非常有吸引力。

不過,目前 OpenScholar 也有很多局限,比如:

-

1.OpenScholar 可能會引用不那麼具有代表性的論文。

例如,在描述特定方法時,它可能未能引用提出該方法的原始論文,而是引用了提及該方法的另一篇論文。

-

2.OpenScholar 有時可能會生成沒有參考文獻支持的響應,或者檢索到該領域不是最相關或最新的論文。

例如:當被問及機器人學中的大型基礎模型時,此響應引用了一篇具有 3.07 億參數模型的論文,而截至 2024 年 11 月,機器人學中當前最大的基礎模型(RT-2)具有 550 億參數。

-

3.OpenScholar 可能仍然可能生成帶有幻覺的結果,而不是依賴於它檢索到的真實論文。

-

4.許多科學論文都設置了付費牆。

目前出於對版權的尊重,OpenScholar 數據存儲庫僅包含公開的論文。這可能會降低模型在較封閉領域回答問題的能力。

團隊表示,未來他們會納入更多論文、升級檢索增強算法,也會對各個領域的經典研究問題和論文進行深入整合,增強 OpenScholar 的專業程度。

不過,從實驗結果來看,OpenScholar 已經是目前表現最好的 AI 學術研究助理之一啦,感興趣的小夥伴可以直接戳下面的公開資料進行嘗試!

Demo:

https://openscholar.allen.ai/

論文:

https://openscholar.allen.ai/paper

OpenScholar 代碼:

ScholarQABench 數據集代碼:

更多測試 code:

參考鏈接

-

[1] https://venturebeat.com/ai/openscholar-the-open-source-a-i-thats-outperforming-gpt-4o-in-scientific-research/

-

[2] https://allenai.org/blog/openscholar

本文來自微信公眾號:量子位(ID:QbitAI),作者:奇月,原標題《超越 GPT-4o!開源科研神器登場,4500 萬篇論文檢索增強生成可靠回答》

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。