又一個國產o1來了,直接數學競賽題伺候!

金磊 發自 凹非寺

量子位 | 公眾號 QbitAI

家人們,國產o1大模型,最近著實是有點火啊。

就在今天,崑崙萬維的Skywork o1也開啟了邀測。

那一波實測,這不就得安排一下麼。

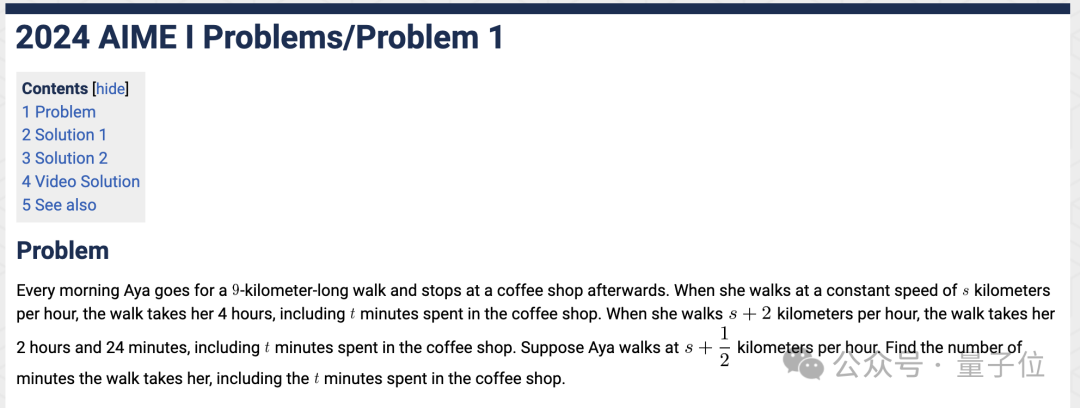

類似o1模型最大的特點就是其強悍的推理能力,因此,我們直接上一道AIME數學競賽題,看看夠不夠「開門」。

(AIME:美國數學邀請賽,是介於AMC10、AMC12及美國數學奧林匹克競賽之間的一個數學競賽。)

題目翻譯過來是這樣的:

每天早晨,Aya會進行一段長度為9公里的散步,然後在一家咖啡店停留。當她以每小時s公里的恒定速度行走時,整個散步加上在咖啡店停留的時間一共需要4小時,其中包含在咖啡店停留的t分鐘。當她以s+2公里每小時的速度行走時,整個過程(包括在咖啡店停留的時間)需要2小時24分鐘。

假設Aya以s+1/2公里每小時的速度行走,求她在這種情況下(包括在咖啡店停留的時間)的總時間(以分鐘為單位)。

從Skywork o1整體的回答來看,它先是將問題分解為不同場景,通過建立方程組描述步行速度、時間和距離的關係。

隨後利用代數方法求解,確保了表達式簡化和單位換算的正確性。

而比較重要的一點,是Skywork o1可以代入結果驗證計算過程的自洽性,並明確得出總時間。

最終,它所給出的答案「204」,與今年AIME這道題的標準答案一致。

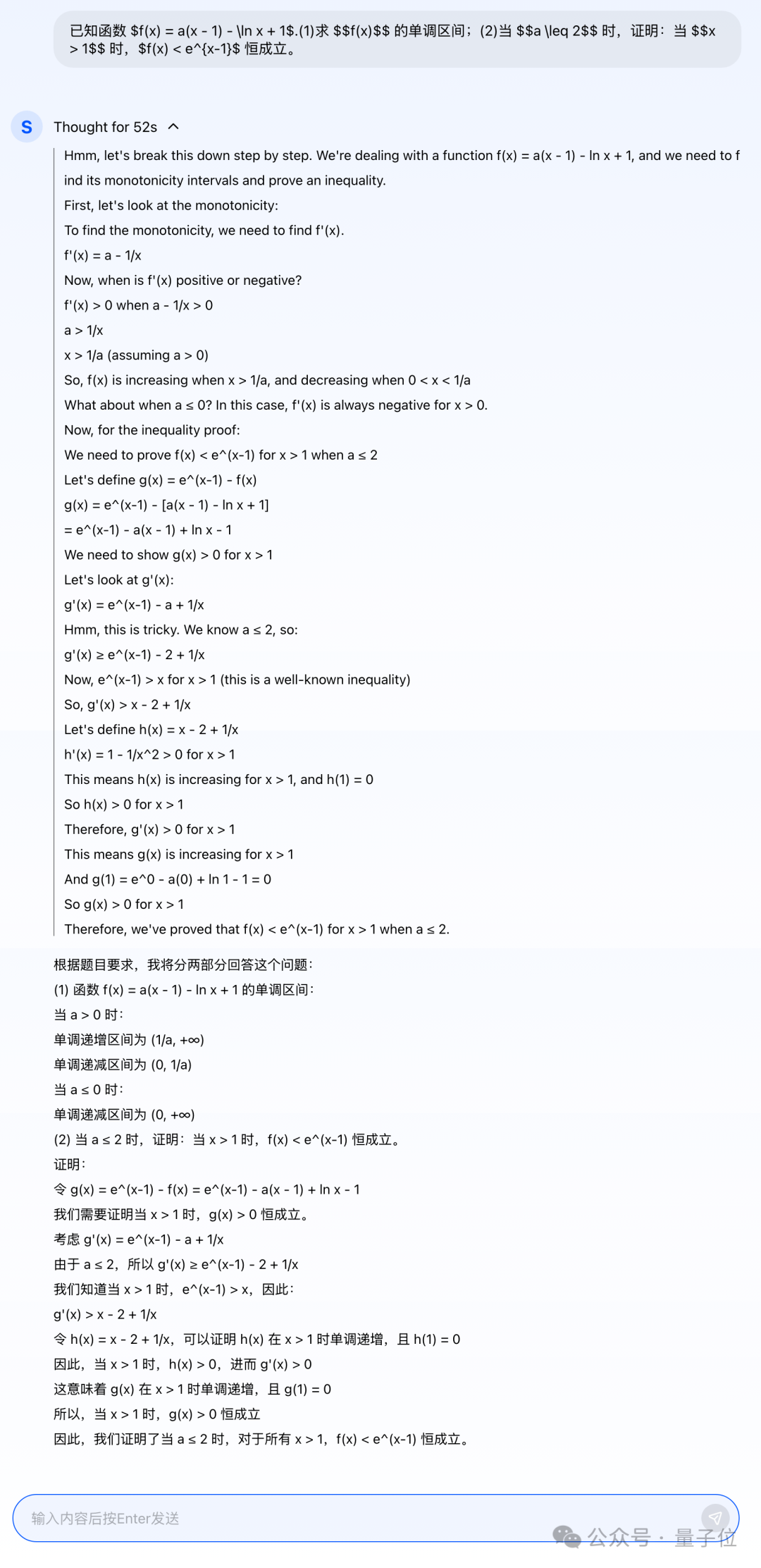

接下來,我們再拿今年的高考數學題做一番測試。

AI請聽題:

已知函數$f(x) = a(x – 1) – \ln x + 1$.

(1)求f(x)的單調區間;

(2)當α小於等於2時,證明:當x大於1時, $f(x) < e^{x-1}$ 恒成立。

AI整體的思路和剛才一樣,都是屬於分步而治之,主打的就是一個step by step。

期間哪怕是遇到「陷阱」,Skywork o1也會及時發現並提醒自己,整個過程宛如把人類思考的過程複刻並呈現了出來一般。

最終給出的答案也是與標準答案一致。

需要注意的是,Skywork o1其實是一個系列,更具體而言,包括三個細分模型:

-

Skywork o1 Open:基於Llama 3.1的8B開源模型,解鎖了許多輕量級模型無法解決的複雜數學任務。

-

Skywork o1 Lite:具備完整的思考能力,具有更好的中文支持和更快的推理和思考速度。

-

Skywork o1 Preview:本次完整版的推理模型,搭配自研的線上推理算法,使推理過程更完善、高質量。

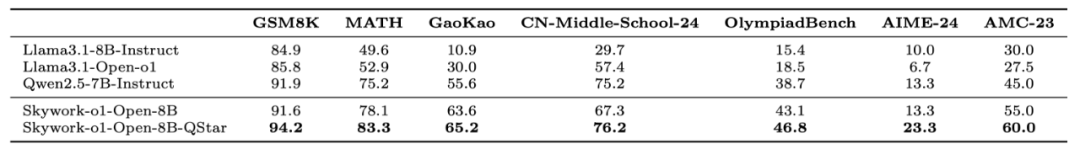

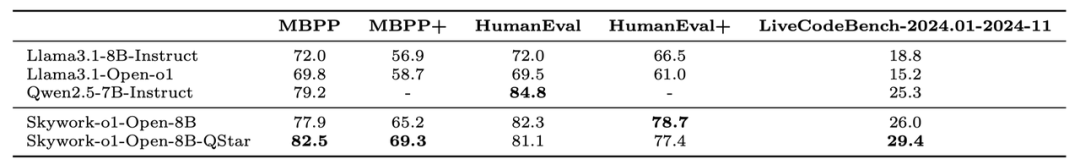

不僅如此,Skywork o1 Open也參與到了類o1模型Benchmark的比較,能力上可謂是有了大幅的提高。

將Llama-3.1-8B的性能拉到同生態位SOTA(超越Qwen-2.5-7B-Instruct)。

同時,8B的Skywork o1 Open也解鎖了很多較大量級模型,如GPT 4o,無法完成的數學推理任務(如24點計算)。

這也為推理模型在輕量級設備上部署提供了可能性。

△

△在MATH數據集上,Q*(論文地址:https://arxiv.org/abs/2406.14283)幫助Llama-3.1-7B提升並超越了同生態位的SOTA Qwen2.5-7B-instruct。

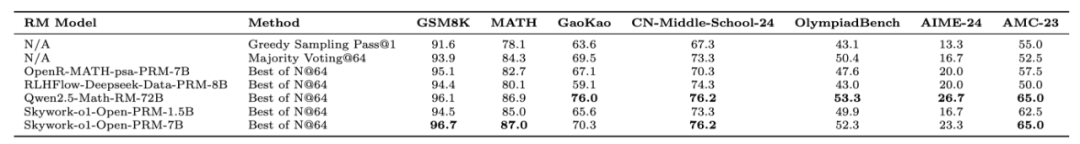

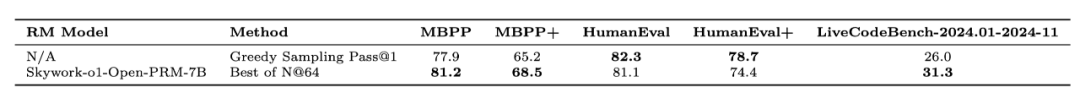

同時,崑崙萬維也將開源兩個的推理任務的Process Reward Model(PRM):Skywork o1 Open-PRM-1.5B 和Skywork o1 Open-PRM-7B,相比此前開源的Skywork-Reward-Model僅對整個模型回答進行打分,Skywork o1 Open-PRM能給模型回答中的每個步驟進行打分。

對比開源社區現有的PRM,Skywork o1 Open-PRM-1.5B能達到開源社區8B的模型效果,例如RLHFlow的Llama3.1-8B-PRM-Deepseek-Data,OpenR的Math-psa-7B,Skywork o1 Open-PRM-7B能同時在大部分benchamrk上接近/超過10倍量級的Qwen2.5-Math-RM-72B。

Skywork o1 Open-PRM也是第一款適配代碼類任務的開源PRM。下面表格為以Skywork-o1-Open-8B作為基礎模型,使用不同PRM在數學和代碼評測集上的評估結果。

詳細技術報告也將在不久後發佈。目前模型和相關介紹已在Huggingface開源 (https://tinyurl.com/skywork-o1)。

那麼除了純數學題之外,Skywork o1在其它推理任務上的表現又會如何?

接下來,我們繼續用更多維度的測試來考驗一番。

AI自我思考、規劃和反思

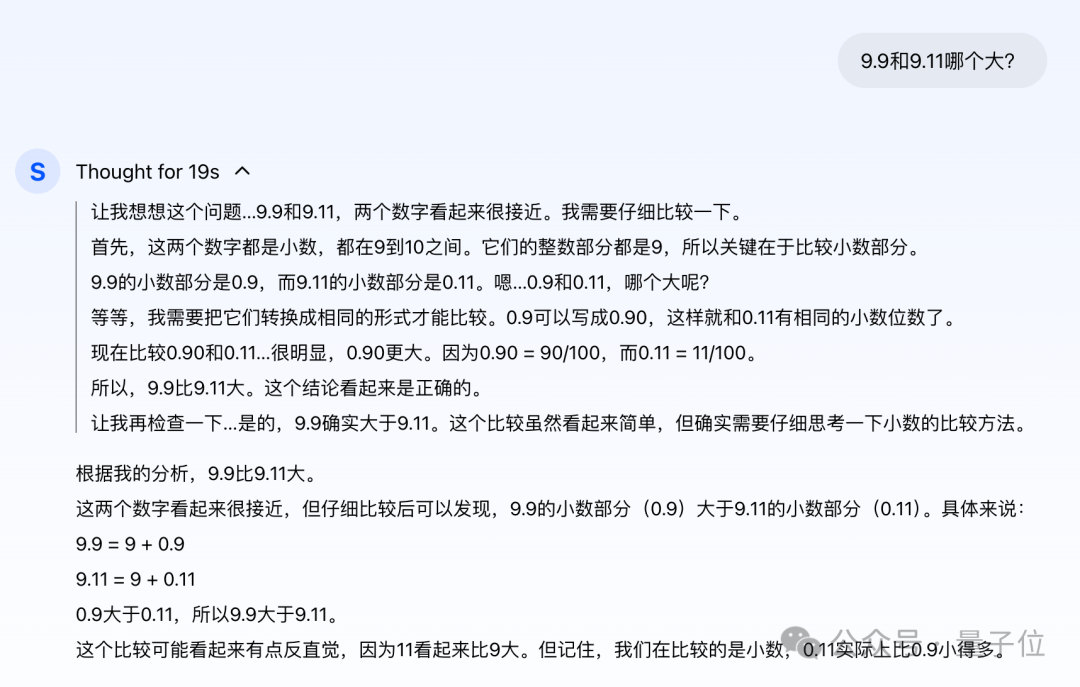

9.9和9.11哪個大?

首先,我們就用曾經難倒一眾AI大模型的經典問題「9.9和9.11哪個大」來做一下測試。

雖然現在幾乎所有大模型都能給出正確答案,但在這個測試中,我們將更關注AI思考的過程。

從過程來看,Skywork o1依然採用分而治之的策略。

先比較整數位,判定二者的整數位相同;再判斷小數位,將其轉換為相同的格式,即0.90和0.11之間的比較,判定9.9大於9.11。

最後,Skywork o1還是把過程再次驗證了一遍,認定結果是正確的。

從它的思路來看,和人類比較這兩個數字的邏輯是一致的。

腦筋急轉彎

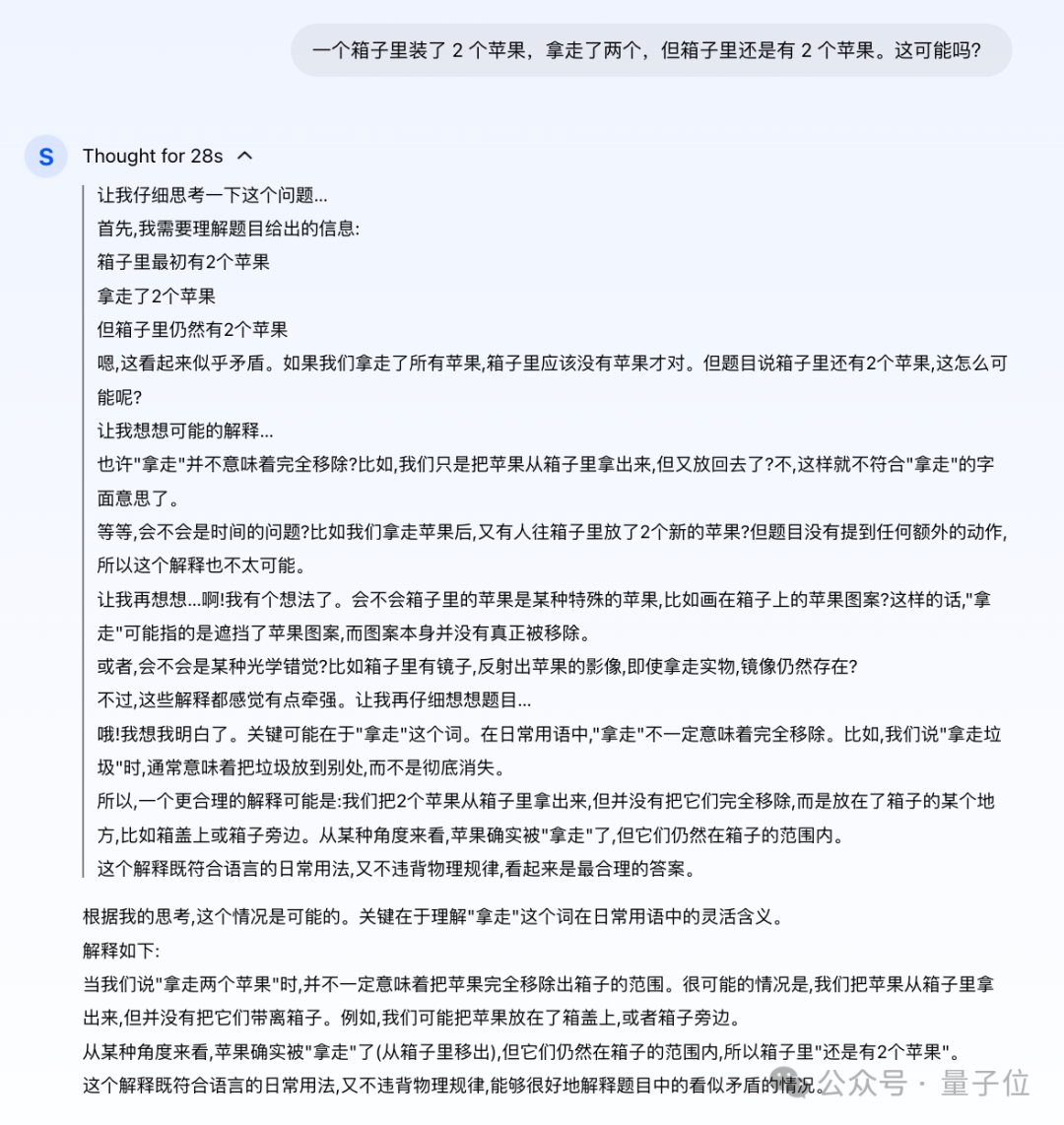

接下來,我們再來一道腦筋急轉彎:

一個箱子裡裝了2個蘋果,拿走了兩個,但箱子裡還是有2個蘋果。這可能嗎?

對於這樣的腦筋急轉彎,很多人思考的過程,會先看下是否符合常理;若是屬於「不按套路出牌」的那種,就會再找找題面有沒有trick了。

那麼到了AI這邊,它又會如何思考?

Skywork o1先審視了一下題目,初步判定不符合常理,應當就開始抓細節了,腦洞大開地想了好幾種可能。

例如又有人放了2個蘋果進去、畫上去的蘋果、光學錯覺、箱子裡有鏡子等等……

但上述的想法都被自己給否了,理由是太牽強。

最後,Skywork o1認定,這個題目的trick就在「拿走」這個詞兒身上,給出的解釋也是正解:

把蘋果從箱子裡拿出來,但沒有帶離箱子,仍在箱子的範圍內。

加密問題

測試大模型的邏輯推理,加密問題可以說是一種非常適合的類型。

因為加密問題往往需要從有限的已知條件推導出未知信息,這需要模型具備強大的邏輯推理能力,能夠在多個條件之間找到關聯並推導出結論。

那麼,話不多說,AI請聽題:

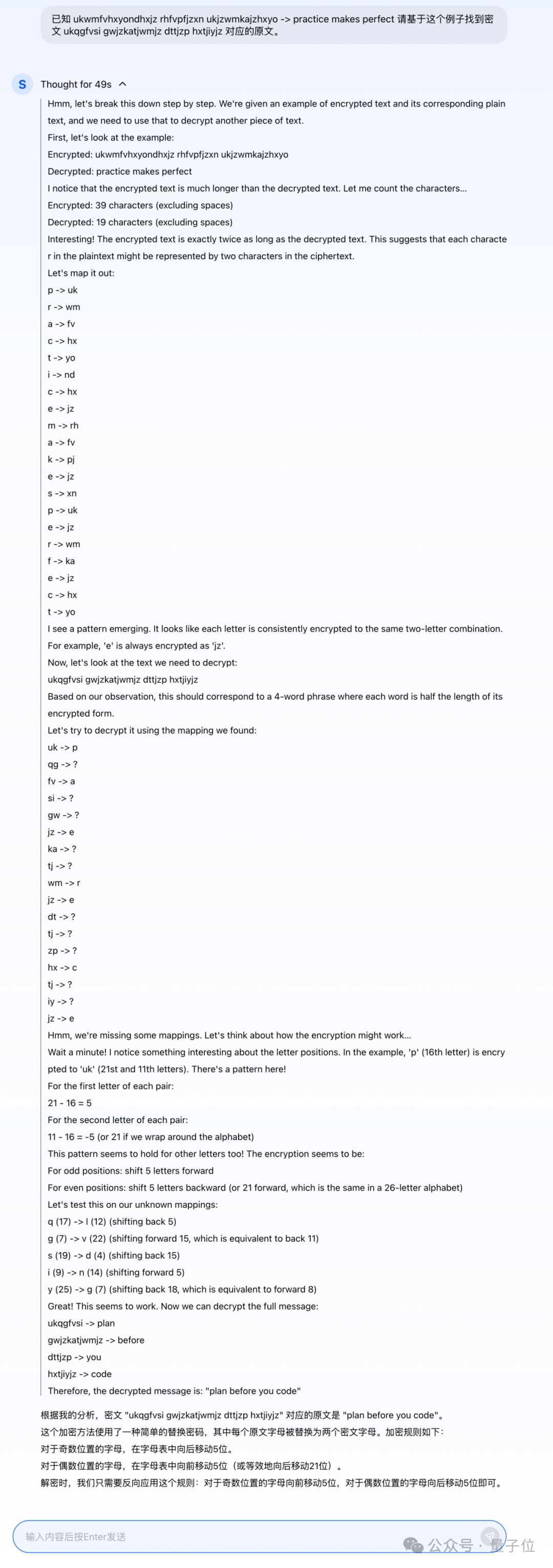

已知 ukwmfvhxyondhxjz rhfvpfjzxn ukjzwmkajzhxyo -> practice makes perfect 請基於這個例子找到密文 ukqgfvsi gwjzkatjwmjz dttjzp hxtjiyjz 對應的原文。

Skywork o1從已知的加密規則和密文-明文對中歸納出字符映射關係,並基於映射規則對新密文進行解碼。

在這個過程中,模型邏輯清晰,分步拆解問題,逐步驗證假設,並在映射不完整的情況下,通過推測加密模式進一步完善解碼方案。

尤其是它對加密規則的歸納能力,不僅識別了每個字母被映射為兩個字符的規律,還通過字符位置和字母表的偏移發現了加密過程的具體算法(奇偶位置的偏移邏輯)。

但也並非完美

雖然Skywork o1在目前種種推理任務中表現還算不錯,但當我們把任務難度降到極低的時候,也發現了一個問題——有點囉嗦了。

例如問它「1+1等於幾」:

Emmmm……繁瑣,著實有點繁瑣了。

但同時,模型考慮到了這道問題是否是在問不同進製情況下的答案,也體現了模型多樣性的思考能力。

不過在與崑崙萬維團隊交流過程中我們得知,對於這樣簡單的問題,團隊後續也會進一步對Skywork o1的解答做優化。

在看完效果之後,接下來的一個問題便是:

怎麼做到的?

整體來看,Skywork o1之所以能有如此的思考、規劃及反思能力,主要得益於一個三階段的自研技術方案。

首先第一階段,是一個推理反思能力訓練的過程。

Skywork o1通過自研的多智能體體系構造出高質量的分步思考、反思和驗證數據。

這些多樣化的長思考數據用於對基礎模型進行進一步的預訓練和監督微調,從而提升了模型在複雜任務中的推理能力。

其次第二階段,是推理能力強化學習。

Skywork o1團隊研發了Skywork o1 Process Reward Model(PRM),適用於分步推理的強化學習過程。

該模型能夠有效捕捉到複雜推理任務中每一步對最終答案的影響;通過結合自研的分步推理強化算法,模型的推理和思考能力得到了顯著增強。

PRM的核心在於其對推理過程的精細化獎勵機制。

傳統的強化學習模型往往只關注最終結果的正確性,而PRM則在每一個推理步驟中引入了獎勵評估,從而確保模型能夠在每一步中不斷優化其推理路徑。

PRM能夠對模型的每一個思考過程進行評分,從而幫助模型糾正錯誤思維鏈,提升整體推理質量。

Skywork o1團隊還在PRM中加入了多任務訓練數據,使其不僅能夠在單一領域表現出色,同時具備在多樣化任務場景中靈活應用的能力。

通過這種方式,Skywork o1能夠有效應對各類複雜的推理挑戰。

最後,則是推理規劃(planning)。

這也是崑崙萬維首次將Q*算法應用並公開,用於線上推理。

Q*算法與模型的在線思考能力結合,能夠尋找最佳推理路徑,從而顯著提高了模型的在線推理能力。

值得一提的是,這也是全球首次實現Q*算法落地,使得Skywork o1的推理能力進一步領先於其他同類模型。

為什麼類o1模型重要?

早在Sam Altman發佈o1模型之際,他便對此問題做了一些點評:

o1標誌著一種新範式的開始:能夠進行通用複雜推理的AI。

這一趨勢也離不開行業發展的大背景,即市場對於具有強大推理能力的模型需求日益增加。

而類o1模型模型的推出,正好滿足了這一需求,尤其是在需要複雜邏輯推理的應用場景中,如科學研究、編程、數據分析等領域。

因為它們對性能提升方式不同於傳統的大規模預訓練方式(通過增加參數量和數據量),是通過增加推理時的算力和時間投入,實現了性能的顯著提升,這為模型的發展帶來了新的Scaling Law。

並且通過內置思維鏈(CoT)逐步解決問題的方式,一定程度上模擬了人類慢思考過程;這種方式使得模型在推理時能夠進行自我糾正,當模型檢測到偏離正確的推理路徑時,它可以回溯並嘗試其他方案。

一言蔽之,是符合市場和行業硬需求。

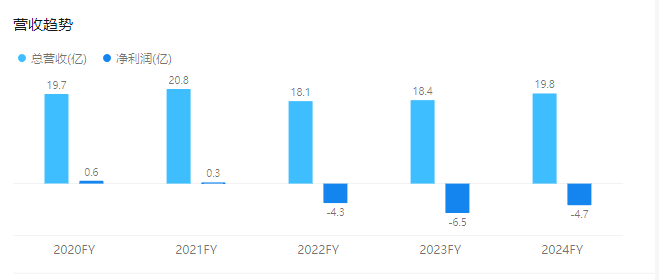

而縱觀崑崙萬維在大模型時代這兩年的表現,毫不誇張的說,每一次的技術新潮來臨之際,國產選手中定然有它的身影出現,而且是屬於早一批的那種。

例如其大底座天工大模型系列,包括天工1.0、天工2.0、天工3.0,以及今天正式邀請測試的「天工大模型4.0」 o1版(Skywork o1)。

其次在其它模態上,還包括AI搜索(天工AI搜索)、AI音樂(天工SkyMusic)、AI社交(Linky)、AI影片(AI短劇平台SkyReels)、實時語音對話助手(Skyo)等。

並且開源,也是從崑崙萬維從一開始佈局至今以來的特點之一;正如此次的開源模型Skywork o1 Open,也將加速國內開源社區複現o1的進程。

最後,Skywork o1邀測地址放下面嘍,感興趣的小夥伴快去申請吧~

申請地址:www.tiangong.cn