rebuttal真的有用!這篇ICLR論文,所有審稿人都加了2分,直接躍升排名第9

機器之心報導

編輯:佳琪、Panda

最近,正處於評議階段的 ICLR 2025 論文真是看點連連,比如前些天爆出的 ICLR 低分論文作者硬剛審稿人的事件以及今天我們要介紹的這個通過 rebuttal(反駁)硬是將自己的平均分拉高 2 分,直接晉陞第 9 名的論文。

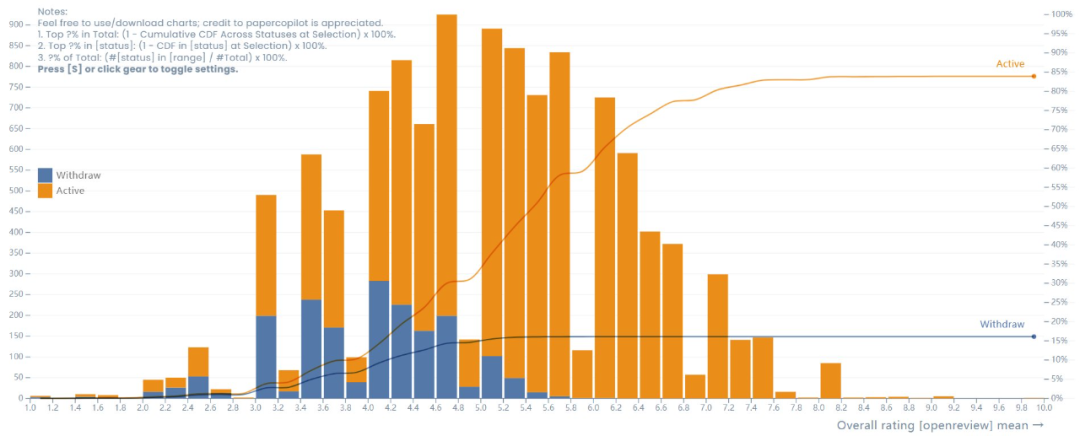

ICLR 2025 論文評分分佈圖,圖源:https://papercopilot.com/statistics/iclr-statistics/iclr-2025-statistics/

順帶一提,不知道是不是因為 ICLR 2025 審稿過程狀況連連,官方此前還決定將論文討論過程延長 6 天。

下面我們就來看看這篇「鹹魚翻身」的論文究竟研究了什麼以及它的評審和反駁之路。

-

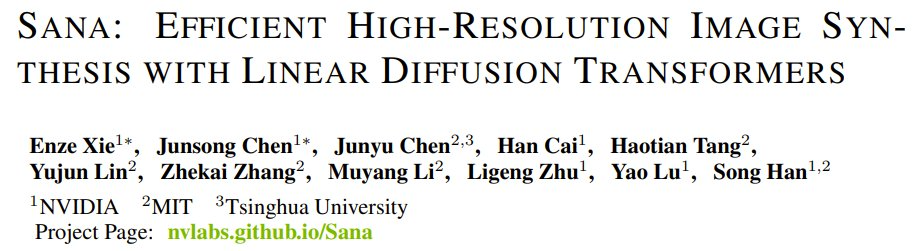

論文標題:SANA: Efficient High-Resolution Image Synthesis with Linear Diffusion Transformers

-

論文地址:https://arxiv.org/abs/2410.10629

-

OpenReview:https://openreview.net/forum?id=N8Oj1XhtYZ

-

項目地址:https://nvlabs.github.io/Sana/

-

代碼地址:https://github.com/NVlabs/Sana

論文主要內容

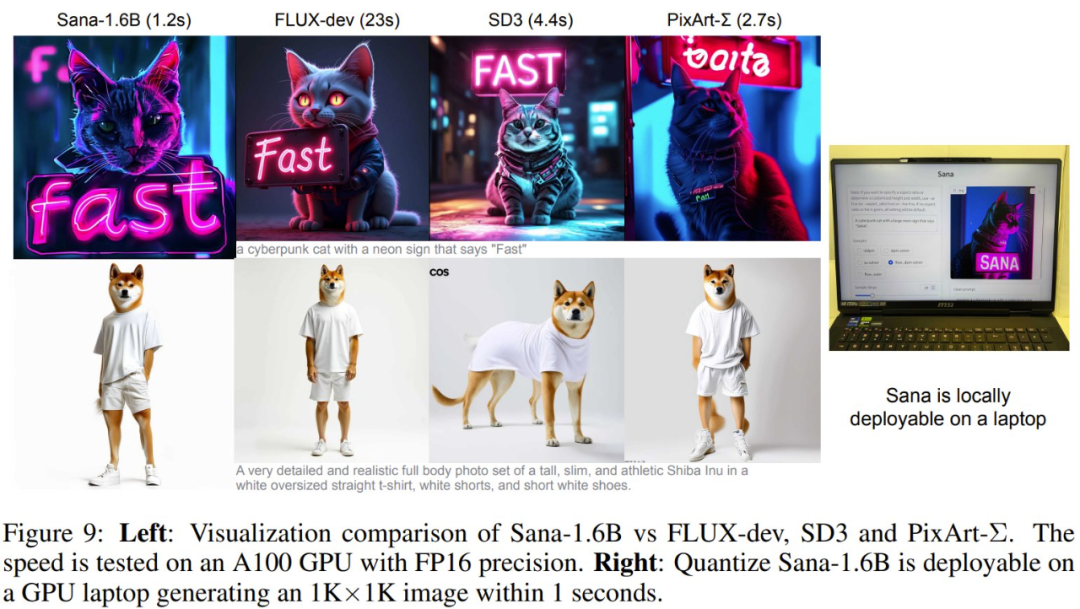

這篇論文提出的 Sana 是一種高效且經濟地訓練和合成高質量圖像的工作流程,並且支持 1024×1024 到 4096×4096 的解像度。下圖展示了 Sana 生成的一些圖像樣本及其推理延遲情況。

作者表示:「據我們所知,除了 PixArt-Σ 之外,還沒有直接探索 4K 解像度圖像生成的已發表研究成果。然而,PixArt-Σ 僅能生成接近 4K 解像度(3840×2160)的圖像,並且生成這種高解像度圖像的速度相對較慢。」

那麼,這個來自英偉達、MIT 和清華大學的研究團隊是如何做到這一點的呢?

具體來說,他們提出了多項核心設計。

深度壓縮自動編碼器

該團隊提出了一種新的自動編碼器(AE),可將縮放因子(scaling factor)大幅提升至 32!

過去,主流的 AE 僅能將圖像的長度和寬度壓縮 8 倍(AE-F8)。與 AE-F8 相比,新提出的 AE-F32 輸出的潛在 token 量可減少 16 倍。這對高效訓練和生成超高解像度圖像(例如 4K 解像度)至關重要。

下表 1 展示了不同 AE 的重建能力。

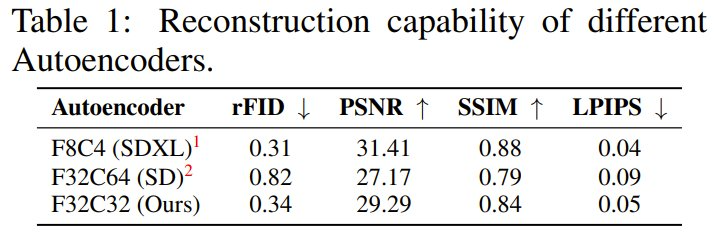

圖 3 則展示了對新提出的深度壓縮自動編碼器進行消融實驗的結果。該結果證明了新 AE 各項設計的重要性。

圖 3 則展示了對新提出的深度壓縮自動編碼器進行消融實驗的結果。該結果證明了新 AE 各項設計的重要性。

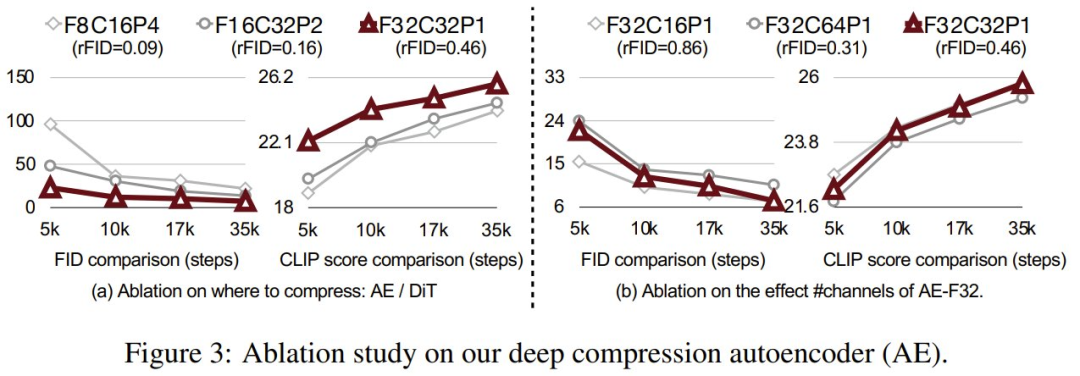

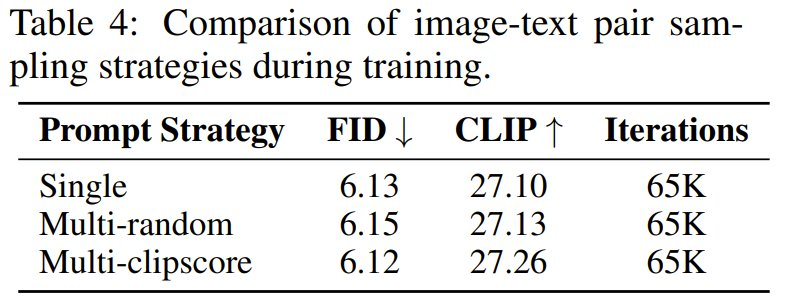

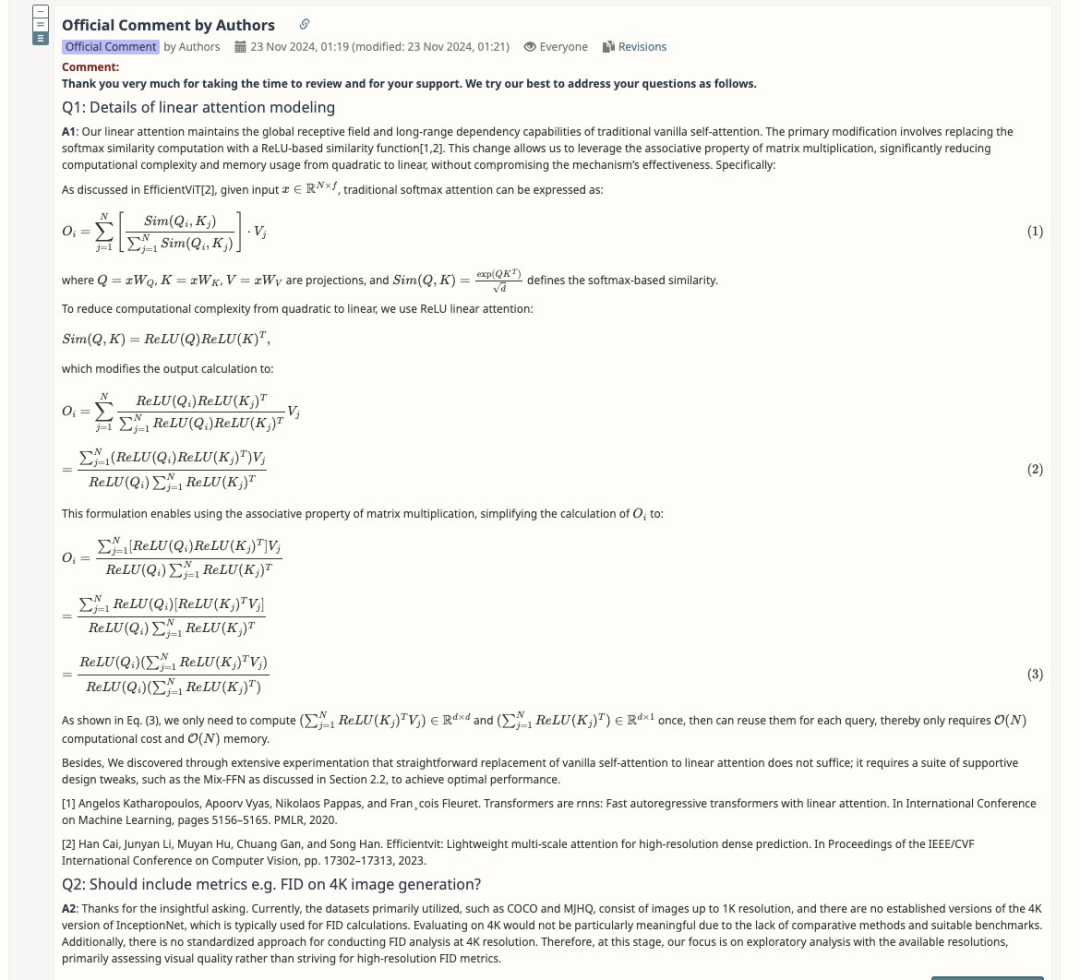

高效的線性 DiT

該團隊還提出使用一種新型的線性 DiT 來替代原生的二次注意力模塊,如上右圖所示。

原始 DiT 的自注意力的計算複雜度為 O (N²)—— 在處理高解像度圖像時,這個複雜度會二次級增長。該團隊將原生注意力替換成線性注意力後,計算複雜度便從 O (N²) 降至 O (N)。

該團隊表示:「我們認為,通過適當的設計,線性注意力可以實現與原生注意力相當的結果,並且還能更高效地生成高解像度圖像(例如,在 4K 時加速 1.7 倍)。

同時,他們還提出了 Mix-FFN,其作用是將 3×3 深度卷積集成到 MLP 中以聚合 token 的局部信息。

Mix-FFN 的直接好處是不再需要位置編碼(NoPE)。該團隊表示:「我們首次刪除了 DiT 中的位置嵌入,並且沒有發現質量損失。」

使用僅解碼器小 LLM 來作為文本編碼器

為了提升對用戶提示詞的理解和推理能力,該團隊使用了最新版的 Gemma 作為文本編碼器。

儘管這些年來文生圖模型進步很大,但大多數現有模型仍然依賴 CLIP 或 T5 進行文本編碼,而這些模型通常缺乏強大的文本理解和指令遵從能力。僅解碼器 LLM(例如 Gemma)表現出的文本理解和推理能力很強大,還能有效遵從人類指令。

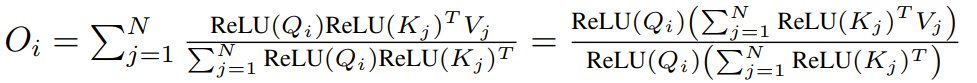

下表比較了不同文本編碼器的效果。

通過直接採用 LLM 作為文本解碼器,訓練不穩定的問題得到瞭解決。

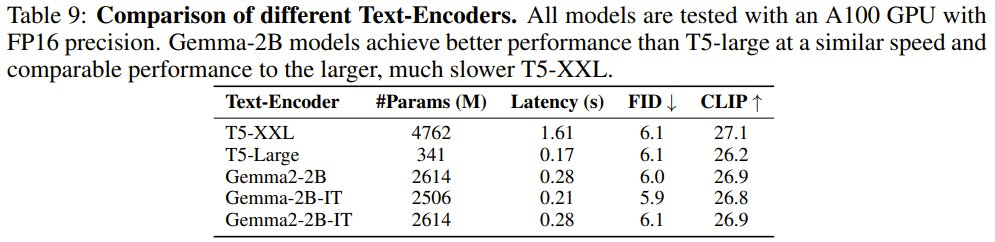

另外,他們還設計了複雜人類指令(CHI),以充分理解 LLM 那強大的指令遵從、上下文學習和推理能力,進而更好地對齊圖像與文本。從下圖可以看到,有無 CHI 的輸出結果差異非常明顯。

高效的訓練和推理策略

為了提升文本和圖像的一致性,該團隊提出了一套自動標註和訓練策略。

首先,對於每張圖像,使用多個 VLM 來重新生成描述。雖然這些 VLM 的能力各不相同,但它們的互補優勢可提高描述的多樣性。

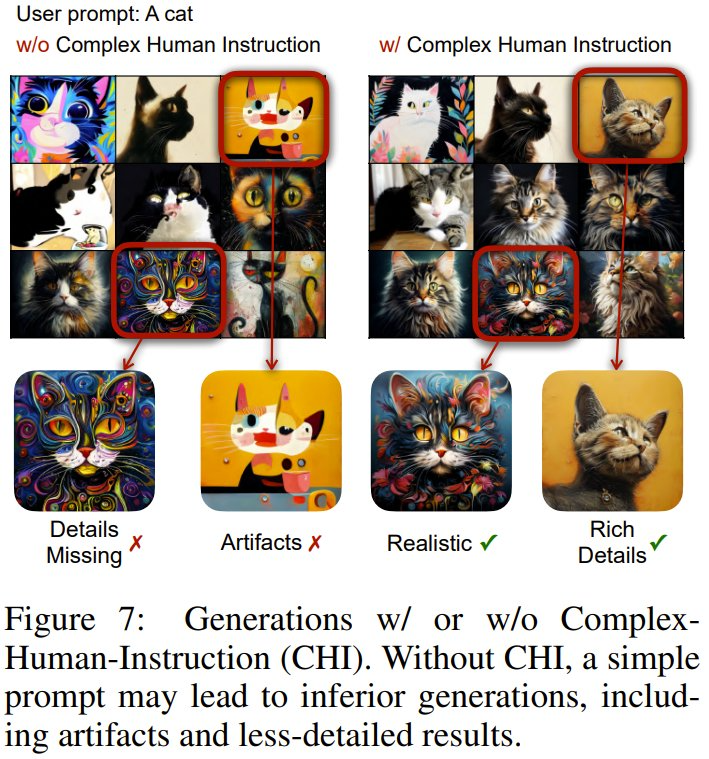

他們還提出了一種基於 Clip Score 的訓練策略,即對於一張圖像的多個描述,根據概率動態選擇具有高 Clip Score 的描述。實驗表明,這種方法可以提高訓練收斂性和文本圖像對齊程度。下表比較了訓練期間不同的圖像 – 文本對采樣策略的效果。

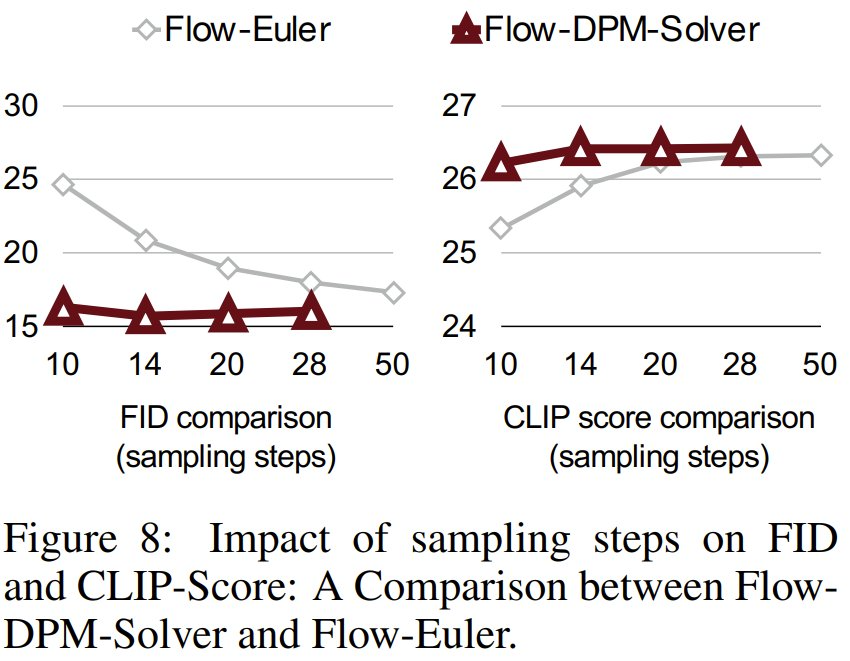

此外,他們也提出了一種 Flow-DPM-Solver,相比於廣泛使用的 Flow-Euler-Solver,這種新的求解器可將推理采樣步驟從 28-50 步減少到 14-20 步,同時還能實現更好的結果。見下圖。

實驗結果

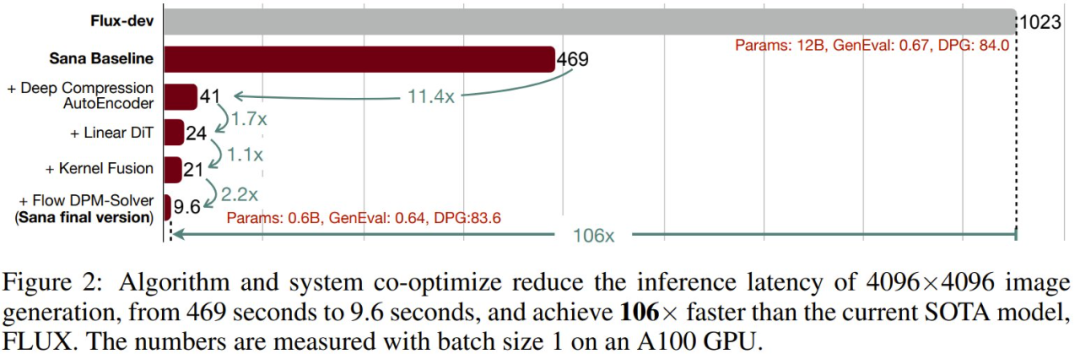

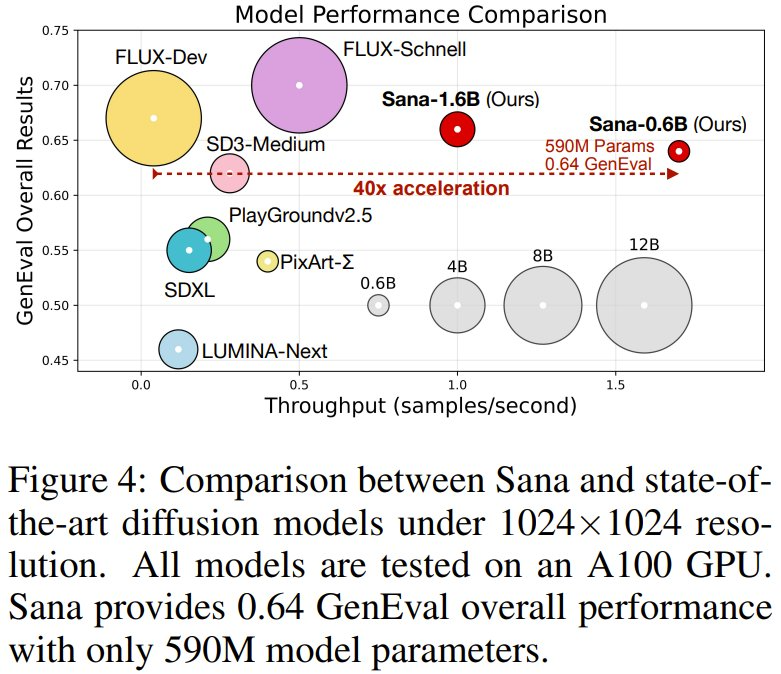

總體實驗下來,該團隊的新模型 Sana-0.6B 表現可謂極佳。在生成 4K 圖像時,速度比當前最佳(SOTA)的 FLUX 方法快 100 多倍(見下圖 2)。在生成 1K 解像度圖像時,也快 40 倍(見下圖 4)。同時,Sana-0.6B 的效果在許多基準上都能與 FLUX 比肩!

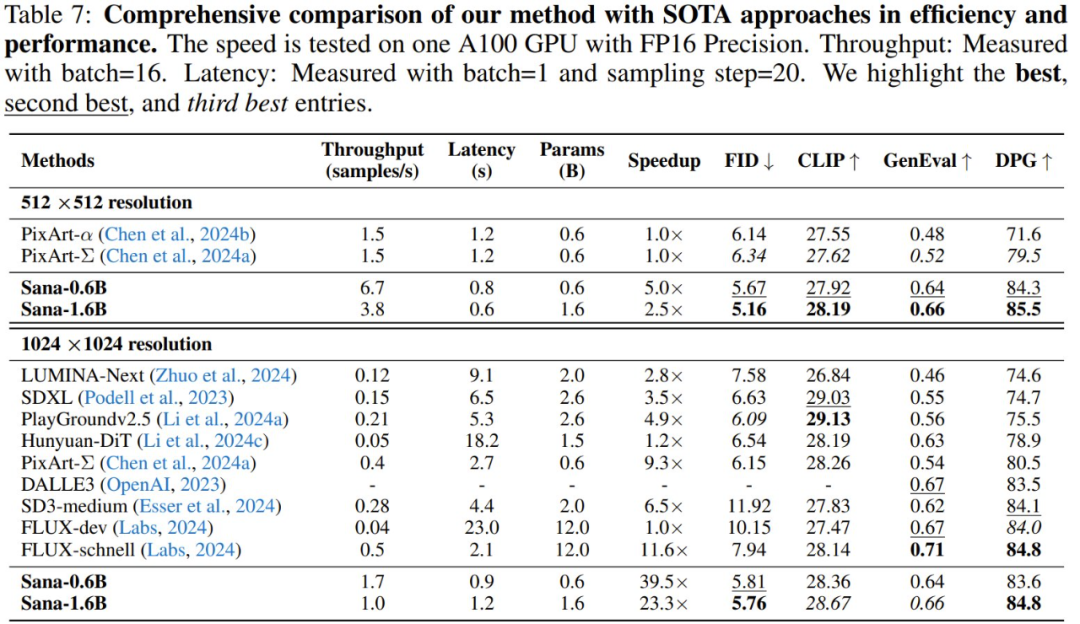

不僅如此,他們還訓練了一個參數量更大的 Sana-1.6B 模型。下表更詳細地展示了這兩個模型的性能表現,可以看到,對於 512 × 512 解像度,Sana-0.6 的吞吐量比大小相近的 PixArt-Σ 快 5 倍,並且在 FID、Clip Score、GenEval 和 DPG-Bench 方面表現明顯優於後者。對於 1024 × 1024 解像度,Sana 比大多數模型強得多。這些結果說明 Sana 確實實現了低延遲、高性能的圖像生成。

此外,他們還為 Sana 打造量化版本,並將其部署到了邊緣設備上。

在單台消費級 4090 GPU 上,該模型生成 1024×1024 解像度圖像只需 0.37 秒,是一個非常強大的實時圖像生成模型。

下面展示了 Sana-1.6B 模型的一些輸出結果以及部署量化版模型的筆記本電腦。

rebuttal 真的有用?

很多時候,在審稿人的第一印像已經確定的情況下,rebuttal 能夠改變的不多。

正如知名長文《審稿 CVPR 而致的傷痕文學(續):關於 Rebuttal 的形而上學》所說,從審稿人的角度來看,收到 rebuttal 時,可能早就已經忘了當時為什麼會給這個審稿意見,對這篇文章的唯一記憶就是「我要拒掉它」。

引自 https://zhuanlan.zhihu.com/p/679556511 作者 @Minogame

那麼,SANA 到底拿出了一份怎樣的 rebuttal,四個審稿人看過後不再「已讀不回」,反倒不約而同地加了 2 分呢?

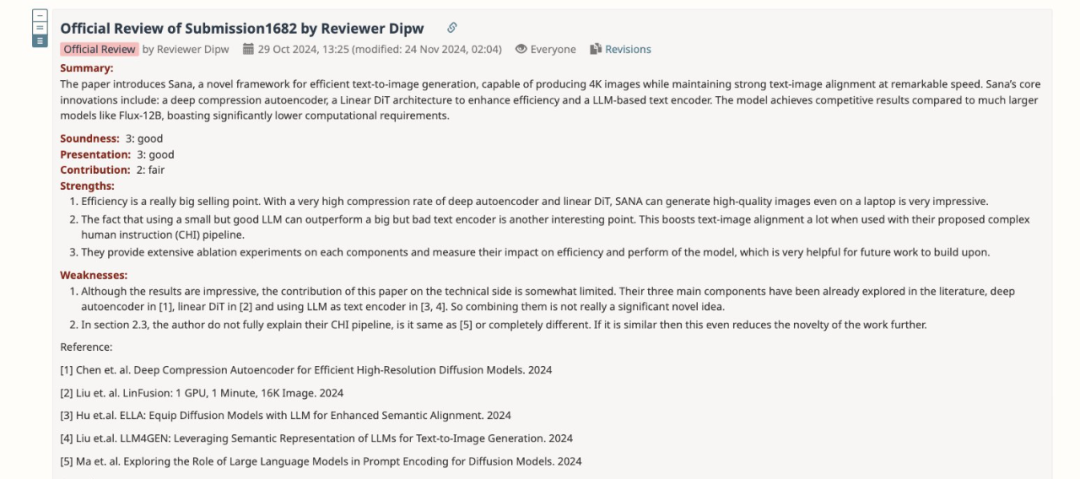

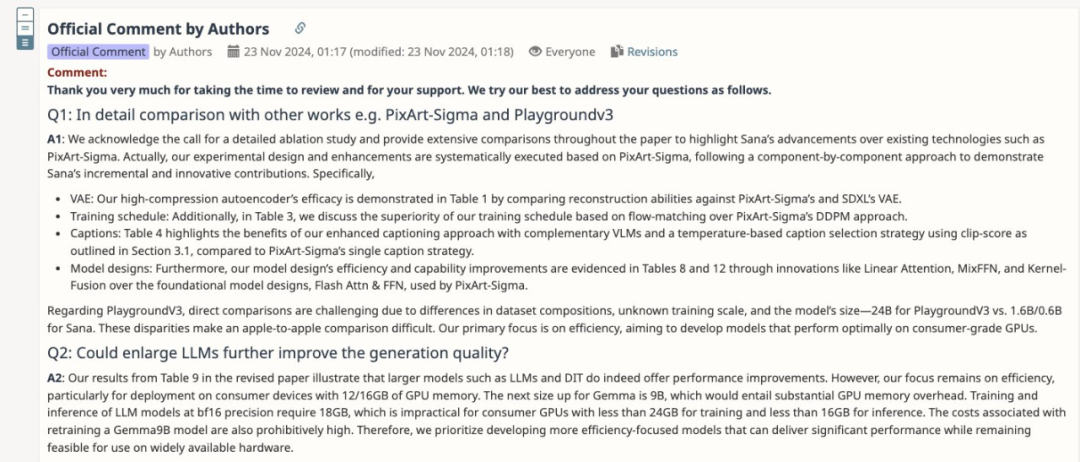

第一位審稿人和第三位審稿人的意見比較相似,他們認為 SANA 的原創性有些不足。具體來說,第一位審稿人在缺點部分寫道:

-

SANA 的三個主要組件在文獻中已有探討:深度自編碼器在 [1] 中有涉及,線性 DiT 在 [2] 中已有研究,[3, 4] 中已經使用了 LLM 作為文本編碼器。將這些組件結合起來並不構成一個真正具有創新性的想法。

-

作者沒有充分解釋他們的 CHI 流程是否與 [5] 中的相同。如果相似,那麼這甚至會進一步削弱該工作的創新性。

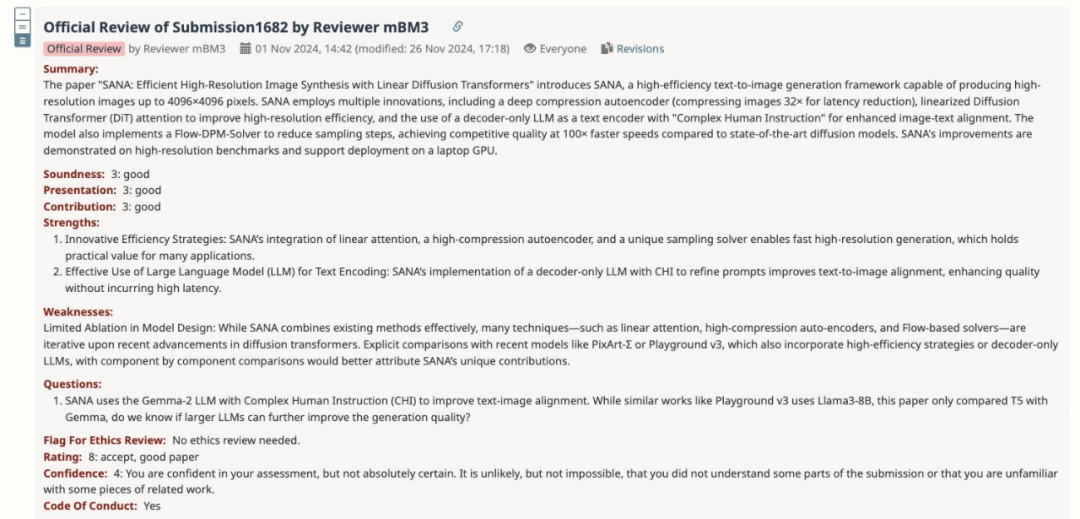

第三位審稿人則希望作者們補一些消融實驗,逐個組件分析,明確 SANA 相較於 PixArt-Σ 和 Playground v3 等類似的模型有什麼創新之處。

SANA 的研究團隊首先詳細地說明了站巨人的肩膀上創新和做學術裁縫的區別。

比如,LinFusion 中的線性注意力是蒸餾策略的一部分,而作者們把 SANA 作為一個基礎生成模型,從頭開始設計、訓練。為了讓線性注意力在所有層中代替原來的自注意力,他們做出了 Mix-FFN 解碼器。

這樣,相比其他方法將所有 token 映射到一個低秩的 NxN 狀態中,SANA 更接近於直接的 O (N) 注意力計算,這是以前的研究未能有效解決的問題。

對比同樣提交給 ICLR 2025 的「DC-AE」,SANA 解決了未涉及的獨特問題,比如簡單地在潛在空間中增大通道(F8C4→F32C32)會使得訓練收斂速度大大減慢,他們設計了線性注意力 + Mix-FFN 塊加速收斂。

而此前 LLM 作為文本編碼器的方法,更多隻是簡單地用 LLM 替代了 T5/Clip,並未像 SANA 一樣深入研究了如何激發 LLM 的推理能力。

針對審稿人的問題,作者補充了一系列消融實驗,比較了 LiDiT 和 SANA 的 CHI 效果,並逐個組件地展示了 SANA 在 PixArt-Σ 基礎上的進展。

這兩位審稿人也是給出了一個提分的大動作:

第二位審稿人更在意技術細節,他覺得 SANA 如何搭建的線性注意力模塊還可以說得更清楚。

具體來說,需要明確一下,他們是如何實現線性注意力能全局替代傳統自注意力,同時保持足夠的上下文信息和依賴關係建模的,還要補 4096*4096 解像度的圖像與其他方法的實驗對比。

在一通極其詳細的解釋之下,這位(可能不清楚目前沒有 4K 版本 InceptionNet 的)審稿人也把分數也提了 2 分。

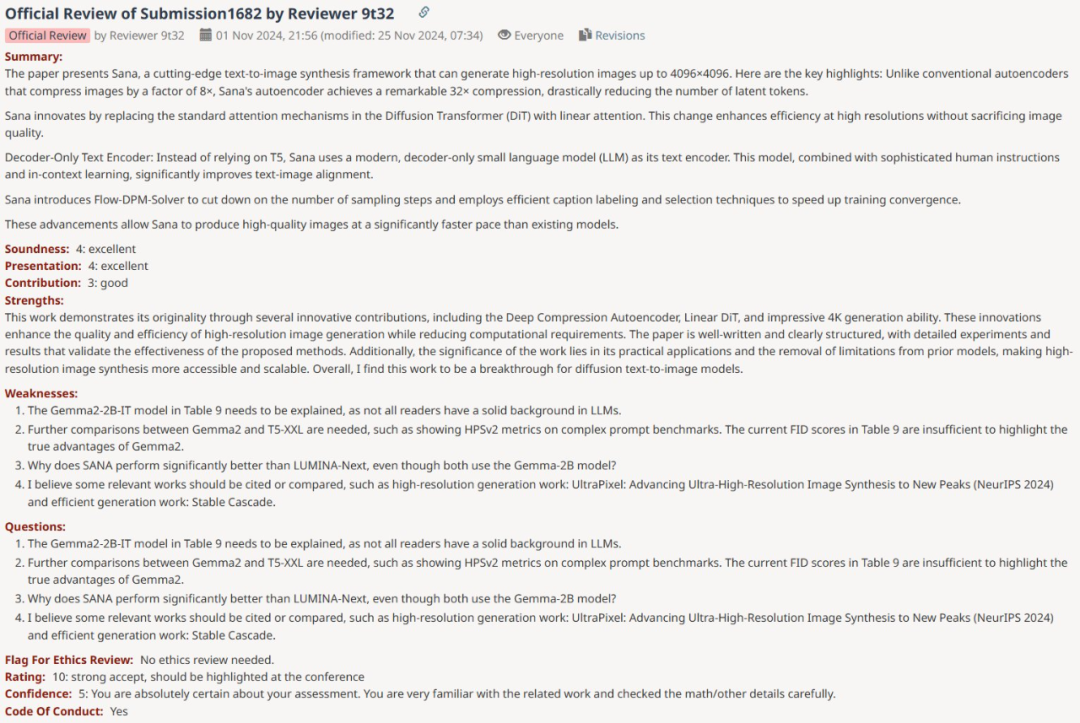

第四位審稿人則給出了 10 分的最高分評價。

一開始,該審稿人指出了這篇論文的一些缺點,包括表 9 中的 Gemma2-2B-IT 模型需要解釋、需要進一步比較 Gemma2 和 T5-XXL 以及缺乏對 UltraPixel 等引用等等。

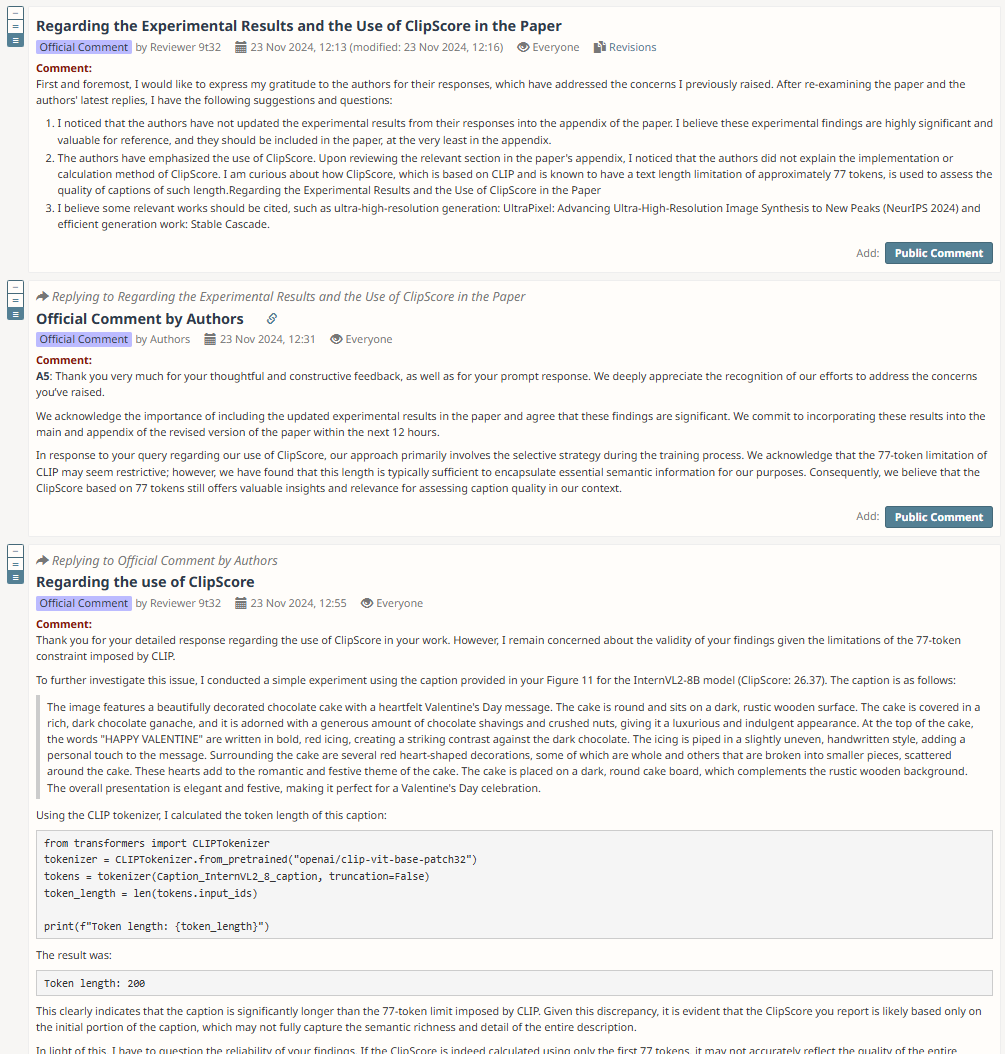

然後,作者對該審稿人的四個問題逐一進行了詳細解答,並為論文內容做了進一步的補充。此後,又是關於 ClipScore 的幾個來回討論。

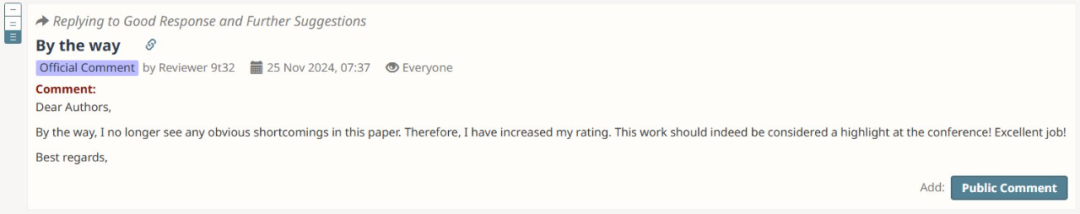

最後,審稿人被作者說服,表示:「我再也看不到這篇論文中任何明顯的缺點了。因此,我提高了我的評分。這項工作確實應該作為會議的亮點!很出色的工作!」

從這些審稿人與作者的互動可以看到,建設性的討論和修正確實可以幫助改善審稿人對一篇論文的看法。

在多次交流中,審稿人對論文中不清晰或薄弱的部分提出了具體改進建議,而作者也根據反饋進行了細緻的修改。這種積極的互動不僅使論文的質量得到了提升,也促進了審稿人與作者之間的理解與信任。最終,審稿人對論文的評審意見變得更加正面,並願意為作者提供更多的指導。

對此,你有什麼看法?