AI 影片巨頭重磅更新,提示詞都不用費勁寫了,從未有過這樣的影片創作方式

AI 影片,還能往哪個方向卷? Luma AI 的答案有些與眾不同。 對手還在練一招一式,它卻像風清揚傳授獨孤九劍,講究靈活變通,如行雲流水,任意所之。

Luma AI 或許不如可靈、Runway 知名,但論實力也在第一梯隊,它的影片模型叫作 Dream Machine,今年 6 月發佈,最近進行了重磅升級,是推出產品以來聲勢最大的一次。

其中包括兩項更新,一是發佈自己的圖像模型 Luma Photon,將文字、圖像、影片一鍋端;二是打造了生成 AI 影片的全新工作流,我們可以像和 ChatGPT 聊天一樣,讓 AI 生成影片,不用對提示詞字斟句酌。

對於生成影片這件事,Dream Machine 首創了一種很新的方式。

指路👉 https://dream-machine.lumalabs.ai/

聊著聊著,就把影片給生成了

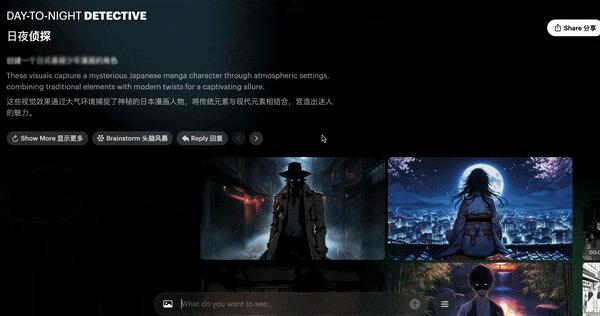

打開 Dream Machine,我們先看到的是「Board」,可以將它理解為無限的創意畫布,在這裏,我們使用自然語言,自由地生成圖像或者影片。

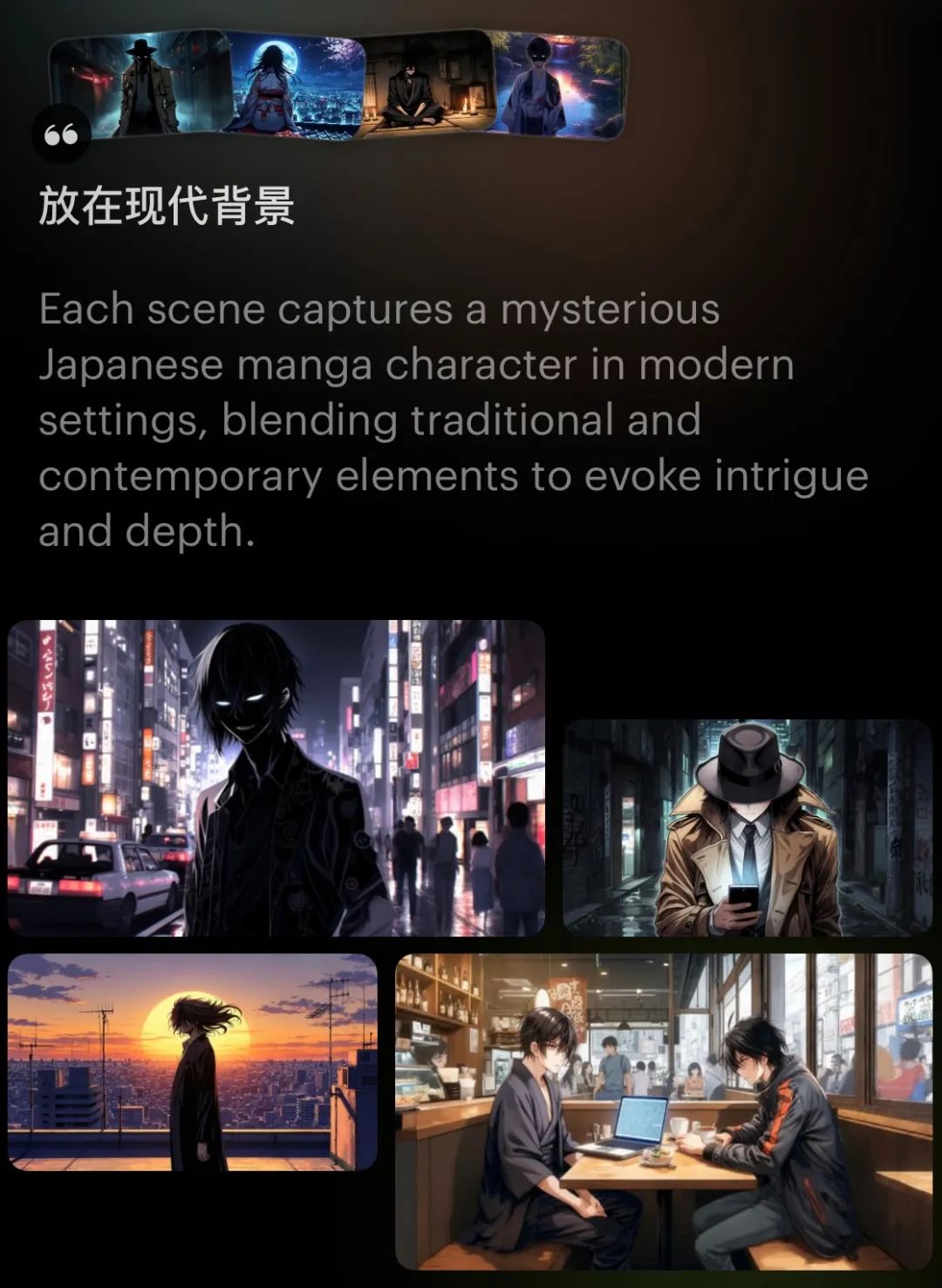

開始一塊 Board,我的提示詞寫得非常簡單:「創建一個日式懸疑少年漫畫的角色。」

AI 擴寫了我的提示詞,一次生成了 4 張圖片,但是不行,年代不對。

沒關係,再在對話框輸入一句,「放在現代背景」。

AI 表示懂了,又生成了 4 張圖片,右上這張孤身走暗巷,已經接近我想要的感覺了,但仍然不夠,我想要他抬起頭,露出五官。

不難,繼續微調,忘掉複雜的提示詞,和 AI 打直球就可以。

右下這張不錯,雖然形象幼態了點。接下來,我想讓 AI 生成一個影片,主角在同一條巷子裡從白天走到黑夜。

Dream Machine 生成影片的首尾幀功能,就是為這種需求準備的——我們挑好頭尾的兩張圖片,讓 AI 補足中間的過程。

那麼,我們只需基於滿意的圖片,讓 AI 生成幾張白天場景的,溝通方式還是一樣的簡單粗暴。最終選定的兩張圖片,細節略有落差,但同框也不違和。

萬事俱備,只等生成影片,AI 過渡得還算自然。

看到這裏,你應該明白 Dream Machine 和其他影片工具的區別了。

其他影片工具,通常是給你一個填入提示詞的文本框,然後讓你設置運鏡、時長等參數。設置一次,生成一次。

但 Dream Machine 的界面,看起來非常像和聊天機器人交互,底部是輸入框,文生圖、圖生圖、圖生影片、文生影片,都可以在這裏進行。

專業創作者可以繼續寫傳統的提示詞,但我們也擁有了「講人話」的權利,壓力給到 AI,Dream Machine 能夠理解上下文,幫我們完善提示詞,我們可以從一個非常粗糙的想法開始,和它邊聊邊改邊優化。

又因為 Dream Machine 是無限畫布形式的,我們可能在一個環節反復生成,素材都會保留下來,不會互相覆蓋。

我們的思維,不會局限在一段提示詞、一個影片,而是像水一樣流淌,更多的想法,可能就在這個過程里產生了。

更可控的圖片,更可控的影片

Dream Machine 的全新工作流就像大樹的主幹,其中一些好玩且實用的功能則像枝椏,相得益彰,才能枝繁葉茂。

起到關鍵作用的,就是 Dream Machine 最新發佈的圖像模型 Luma Photon。

圖片怎麼生成得更符合我們的審美?Dream Machine 支持風格參考和角色參考功能。

先說風格參考,我們可以導入自己的圖片,AI 會將風格融入到創作中。官方給出了一個例子:按蒙德萊恩風格,生成小鳥版的《戴珍珠耳環的少女》。

按這個思路實操一下,基於男性偵探的形象,參考梵高《星月夜》的風格,生成女性偵探。

二次元遇上後印象派,化學反應很奇妙。

角色參考功能,則可以通過一張圖片,就實現角色的一致性,讓這個角色出現在更多的圖片和影片里。

馬斯克是行走的素材庫,這樣的例子太沒挑戰性了,我決定讓甄嬛瞬移到哈利樸達的世界,看場景變了之後,她還能不能氣場兩米八。

結果有些不好評價,看得出來是甄嬛的面容,但娘娘的長相入鄉隨俗,五官尤其眼睛,變得更像歐美人了。

其實,不另外找圖片參考,Dream Machine 也可以讓圖片、影片不泯然於眾人,這時候就要用到「頭腦風暴」功能,它會根據你生成的圖片,推薦一些藝術家的風格。

就像甄嬛進霍格沃茨這張,我們可以用吉卜力工作室風格二創。宮崎駿說過,AI 是對生命本身的侮辱,但現實是,吉卜力已經是 AI 的一個選項,儘管有形無神。

不僅如此,提示詞里的一些關鍵詞,被框選了起來,能用下拉的選項替換,Dream Machine 稱之為「概念藥丸」,我們不用自己手寫提示詞,一鍵更換藝術風格,或者畫面元素。

把「吉卜力」換成「新海誠」,把「獨角獸」換成「龍」,不過點擊幾下的功夫。

Luma Photon 模型,基於 Luma 的通用 Transformer 架構構建。通過開發自己的圖像模型,Luma AI 可以減少對 Midjourney 等外部圖像模型的依賴,同時也能解決文生影片不穩定的問題。

當然,影片是老本行,鏡頭運動這種可控性功能,Dream Machine 也少不了。

紫禁城的甄嬛,和霍格沃茨的甄嬛,能不能實現絲滑的轉場呢?用推拉鏡頭,畫面有動感,人物沒有嚴重的變形,可以打個 80 分。

視覺的思維,講故事的方式

巧的是,前兩天 Runway 也官宣了自己的圖像生成模型 Frame,和 Luma 更新是同一個晚上,看演示就知道非常注重審美,目前正逐步向 Gen-3 Alpha 開放資格。

Runway Frame

Runway Frame 圖片的生成質量、美學高度,以及視覺風格的一致性和可控性,越來越被視覺模型重視了。

這對創作者來說是好事,當我們用 AI 進行平面設計、角色設定時,其實就是在生成一個獨特的世界,講一個獨特的故事。

Runway 的 CEO Cristóbal Valenzuela 認為,Runway 不是一家 AI 公司,而是一家媒體和娛樂公司,AI 公司的時代已經結束了。

他不是在唱衰 AI,恰恰相反,他認為 AI 是一種基礎設施,真正的革命不在於技術本身,而在於它所實現的東西:新的表達形式、講述故事的新方式、連接人類體驗的新方法。這和 Luma 的進化方向不謀而合。

這次更新之後,Luma AI 首席執行官兼聯合創始人 Amit Jain,給 Dream Machine 下了一個很有趣的定義——視覺思維合作夥伴。

概念有些抽像,他的意思其實就是,讓生成圖片、影片這樣的視覺創作,像聊天一樣簡單、直觀。

交互的方式,影響著我們思考的方式。畫布式的工作流,能 將腦洞可視化 ,記錄所有的創作過程和結果,呈現生成影片的完整思路。

無限畫布通常在圖像模型較為常見,比如 Recraft 和 Ideogram 的 Canvas。Dream Machine 的畫布更加規整,相同提示詞生成的素材和變體橫向排列,不同的則豎向排列。

邊聊邊生成邊優化的過程,會讓人覺得,一個獨立的小世界彷彿在畫布里誕生。

先讓 Dream Machine 用超寫實電影 CG 風格,創造一個工業廢土背景遊戲的主角。

然後用環繞鏡頭,讓主角動起來,並塑造環境的空間感。

接著,我們可以再和 AI 聊,讓 AI 繼續生成廢土世界觀里室內室外的各種場景,讓 AI 建議我們怎麼塑造得更有末日氣息。

某種程度上,這個畫布,就是我們個人故事的設定集。

當然,Luma AI 的 bug 也很多,包括但不限於,用一張圖片實現角色一致性,效果並不理想;積分如流水,圖片和影片還是要反復抽卡;圖片模型可以生成準確的英文,但中文不行……

但意思傳達到位了——少談參數,以交互為出發點,構建一個 AI 創作工具。

更好的影片模型,不只是有更快的生成速度、更可控的鏡頭運動、更獨特的美學,它應該也提供更好的講故事的方式,讓文字、圖像、影片都作為表達想法的工具。

Dream Machine,造夢機器。

只管去創作吧,如同 Luma AI 的這句話:「不需要寫複雜的提示詞,問就好了。」未來 AI 留給我們的問題,不再關於技術,而是關於我們用它構建什麼 。

本文來自微信公眾號「APPSO」,作者:發現明日產品的,36氪經授權發佈。