搭建數推分離雙網絡架構,「雙腦」大模型一體機突破落地算力瓶頸|早期項目

作者|黃楠

編輯|袁斯來

在大模型技術浪潮中,Scaling Law被業界遵循為第一性原理,直至科技媒體The Information在獨家報導中指出,OpenAI下一代旗艦模型Orion的訓練效果或遠不及預期:與GPT-4相比,性能提升也許微乎其微。這引發了從業者對大模型發展路徑的深度思考:Scaling Law是否是唯一方向?

長期以來,基於Scaling Law的大模型落地存在重大瓶頸,廠商為提升模型能力,持續擴大預訓練數據、訓練算力並擴大模型參數規模,不僅成本高;同時,算法同質化也會導致數據規模和訓練算力的同質化,最終造成輸出能力的趨同。另一側,大模型能否有效學習客戶數據併成為領域專家,也是一大挑戰。

當前,單一依賴Scaling Law進行集中式暴力訓練已顯露諸多弊端。大模型的「智能」並非僅受參數規模決定,大模型如何在實際場景中發揮作用,才是企業客戶關注的焦點。要打破模型到應用落地之間的高牆,硬氪近日接觸到的「傳神物聯網」提出,集中式預訓練模式值得重新審視,實時學習和訓練模式更具探索價值。

「傳神物聯網」董事長何恩培指出,大模型在相同參數下,模型算法和架構更先進,所需訓練算力越小,訓練數據也越少,不僅不影響模型的能力,甚至在部分指標上可超越常規架構大參數的模型。「相比之下,這種採用高效算法和架構的小參數模型更適合商業落地,而且也可以滿足通用場景的需求。」

傳神創始人何恩培就《基於雙網絡架構數推分離大模型的探索與實踐》發表主題演講

傳神創始人何恩培就《基於雙網絡架構數推分離大模型的探索與實踐》發表主題演講基於這一理念,「傳神物聯網」在其發佈的任度大模型,採用了全技術棧自主研發、未使用任何開源代碼和框架的雙網絡架構,將推理網絡與數據學習網絡分離。

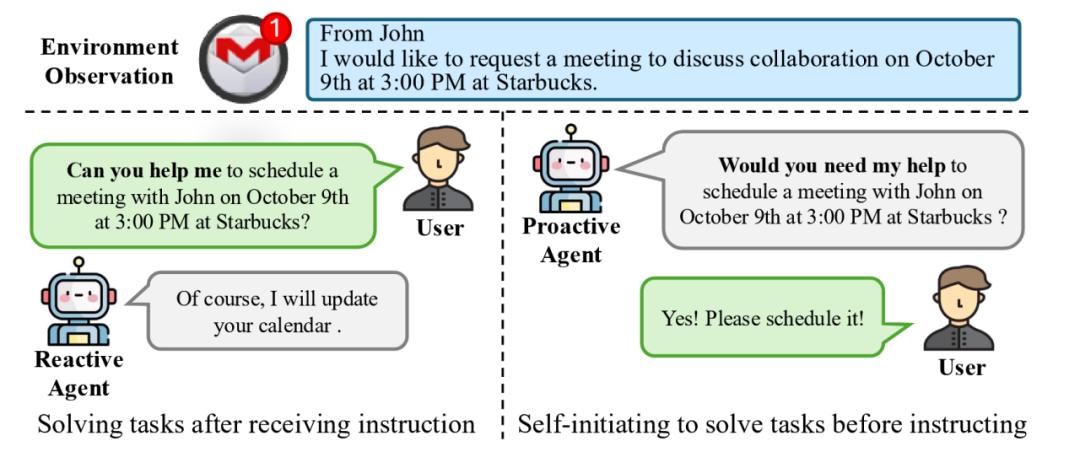

其中,客戶數據學習網絡如同人類左腦,專注於數據的動態管理與迭代訓練,持續為模型注入知識養分;推理網絡則如同人類右腦,作為經大量數據預訓練的基礎網絡,具備不錯的推理和泛化能力。

這種雙網絡協同工作的設計,可有效降低訓練的算力成本,避免微調導致的基座模型能力退化和泛化能力減弱等問題。同時,數據學習網絡還可以學習企業的歷史數據,並實時學習業務運營產生的新數據,兩個網絡聯合工作,輸出客戶所需成果。

測試顯示,任度大模型基於數推分離技術,突破了常規大模型技術架構限制,上下文輸入長度不受限,可將億量級用戶數據壓縮至神經網絡中,並進行深度知識理解,極為接近 「實時」 數據學習模式。即使是極少量數據更新,也能快速上傳並完成數據壓縮,迭代為企業自己的定製化大模型。

任度大模型共有2.1B和9B兩個版本,在降低算力成本方面,其訓練與推理時的算力成本分別為同等大模型的10%-20%以及25%-50%。

硬氪瞭解到,目前「傳神物聯網」已將雙網絡架構的數推分離大模型應用至任度「雙腦」大模型一體機,即將投放市場。該一體機基於數推分離的雙腦模式,可以解決客戶數據離場訓練、向量效果有限及人才投入高等痛點,實現更新數據的本地實時學習,並快速轉化為「企業知識專家」。

針對客戶數據安全和私有化問題,任度「雙腦」大模型一體機可採用本地部署及訓練,無需上傳至公有雲,保障了數據隱私安全。同時,其根原創和高性參比的特性,可在一定程度上解決客戶應用大模型過程中的高硬件投入、高能耗及技術安全和軟件漏洞等痛點。