驚天反轉,LeCun竟與奧特曼達成共識:承認AGI 5到10年降臨,但LLM註定死路一條

【導讀】就在剛剛,LeCun一反常態地表示:AGI離我們只有5到10年了!這個說法,跟之前的「永遠差著10到20年」大相逕庭。當然,他還是把LLM打為死路,堅信自己的JEPA路線。至此,各位大佬們的口徑是對齊了,有眼力見兒的投資人該繼續投錢了。

就在剛剛,LeCun反水了!

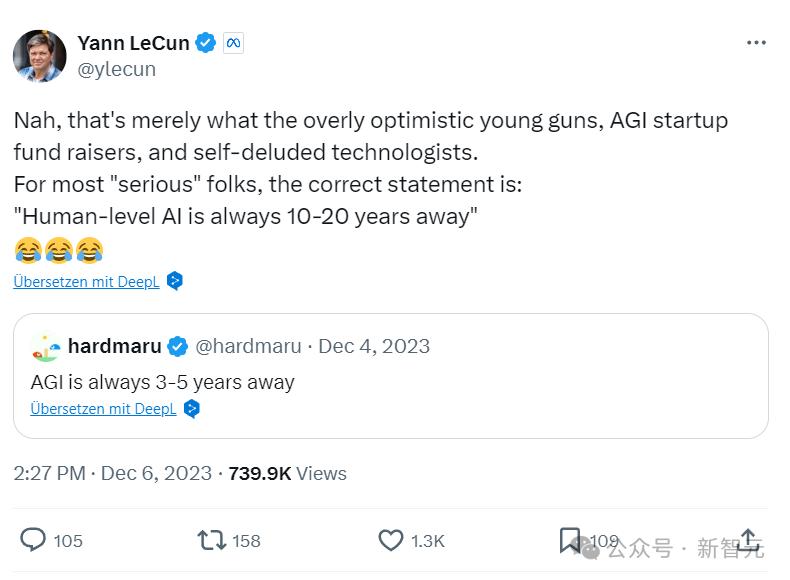

2023年12月,他言之鑿鑿地堅稱:人類水平的AI,離我們還有10到20年。

然而就在最近,他忽然改變說法了!

現在,他表示:在5到10年內,我們就能擁有人類水平的AI了。

主持人追問:我們感覺您之前似乎不喜歡這個觀點啊,您之前不是說過AGI離我們很遠很遠之類的話嗎?

LeCun立馬否決道:不,我不覺得AGI離我們很遠。

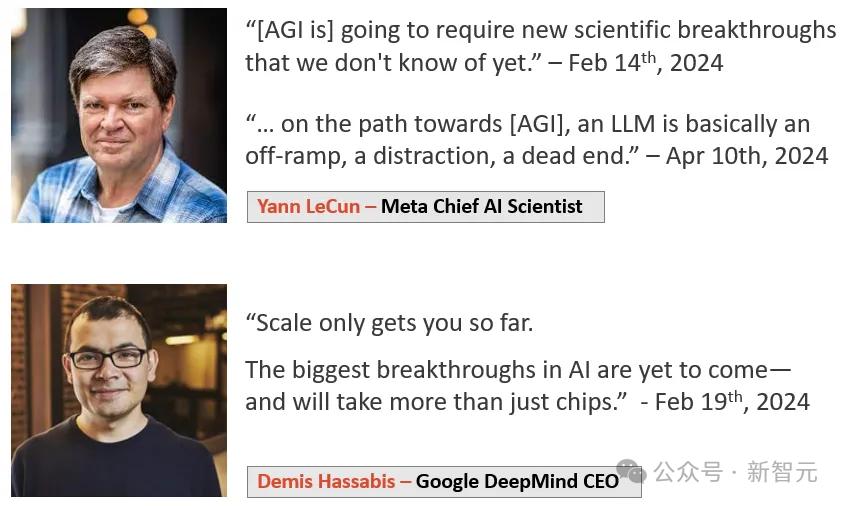

他還強調,自己對AGI何時到來的預測,跟Sam Altman、Demis Hassabis這些人也沒什麼不同。

總之,AGI在十年內大概率要到來,但不太可能是明年或後年。

不過,雖然他改變了對時間的預測,但並沒有改變對目前的大語言模型架構是死路一條的看法。

他表示,我們不能盲目推斷LLM的能力,斷定只要繼續scaling,用更大的超算、更多的數據,AGI就會湧現。

我們需要的是JEPA之類的全新架構,從周圍世界進行學習的系統。這種AI能按重要性計劃一系列動作,而不是像目前的LLM一樣,完全不加思考地在一個詞後產生另一個詞。

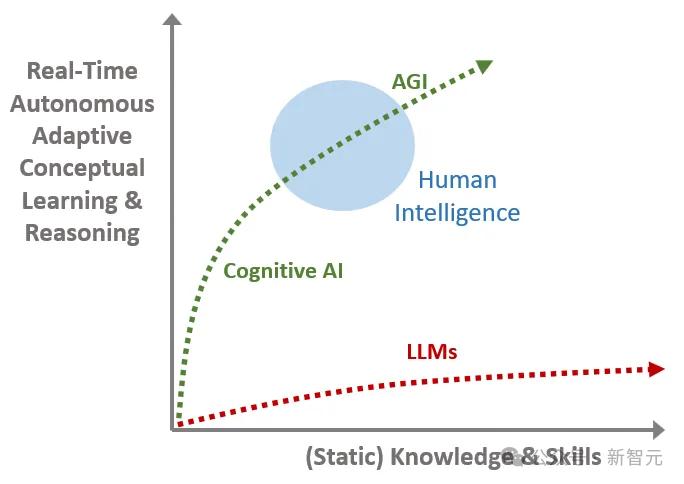

總之,我們需要的是系統2,而不是系統1。而目前的LLM,僅限於系統1的階段。而LeCun所探討系統「目標驅動的人工智能」,就是系統2。

對此,一眾網民都震驚了:他以前不是堅定地否決AGI離我們很近這類觀點嗎?

有人解釋道,這大概是因為大家還缺乏對於AGI共識的定義,因為對於AGI定義很模糊,所以怎麼說都能自圓其說。

其中,下面這條留言最為好笑。

網民表示,估計有Meta內部的人找他談了。說如果想要實現AGI,就得拉很多很多投資。如果還在講什麼AGI遙不可及,我們就沒辦法忽悠更多的投資人了!

AI的核心問題:對世界更好的心智模型

最近,LeCun接受了Nikhil Kamath主持的People by WTF欄目的訪問,討論了關於AI的諸多問題。

LeCun在巴黎的學校里學習的是EE(電氣工程),但隨著學習的深入,他開始對數學、物理和AI中更基本的問題更興趣。

在EE的學習中,總會有些課程涉及到計算機。在1980年代,LeCun就已經和數學教授一起做了一些獨立項目。

現在,LeCun已經成為圖靈三巨頭之一。

作為科學家,他嘗試建立世界的因果模型。

在他看來,幾乎我們面臨的每個問題,根源就是因為人類知識和智慧的不足。我們會犯錯,就是因為不夠聰明,無法意識到存在問題,所以也無法找到解決方案。

LeCun表示,如果我們的智慧更多一點,如果我們對於世界如何運作有更好的心智模型,我們就不會像現在這樣犯錯,而是做出更理性的決策。

而這,也是AI領域的核心問題。

當今世界的一個大問題,就是人們沒興趣去找出事實,也不願意自教育,但是,AI有可能放大全人類的整體智能,這是解決許多人類問題的關鍵。

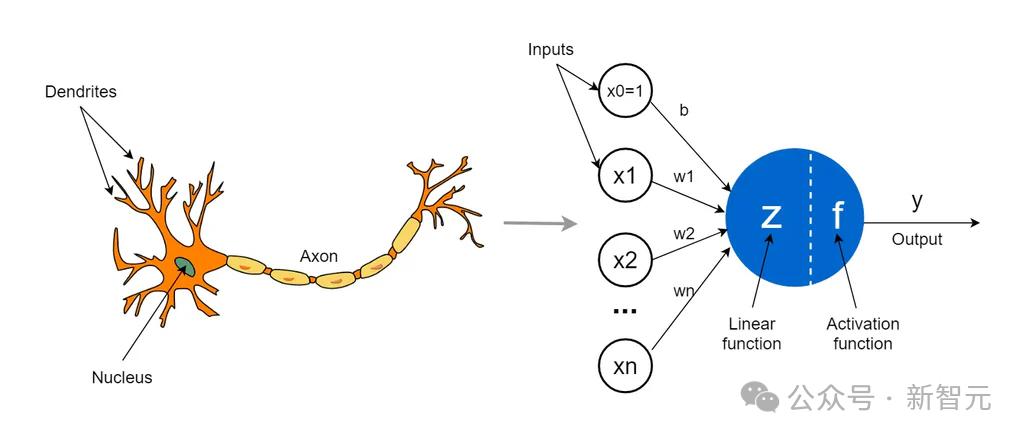

智能是一種由大量簡單元素組成的網絡相互連接所出現的現象。

在40、50年代,人們開始發現,智能和記憶來自於神經元之間連接強度的一種簡化方式。大腦學習的方式,是通過修改神經元之間的連接強度來實現的。

因此,有些人提出了理論模型,並且用電子電路將之複現了。

經典計算機科學的出現:啟髮式編程

按照解決問題能力和學習能力,AI形成了兩個分支。

後者在50、60年代取得了一些成果,但在60年代後期卻失敗了。因為當時設計的神經網絡學習程序非常有限,不可能用來製造真正智能的機器。

不過,它在模式識別的工程領域,卻產生了很大影響。

接下來,他們談到了啟髮式編程。

機器學習最簡單的情況,就是去感知,解釋圖像,解釋聲音,這是經典計算機科學出現的原因。

我們編寫一個程序,這個程序在內部搜索解決方案,並且有一種方式來檢查它提出的方案是否合適,這就是啟髮式編程。

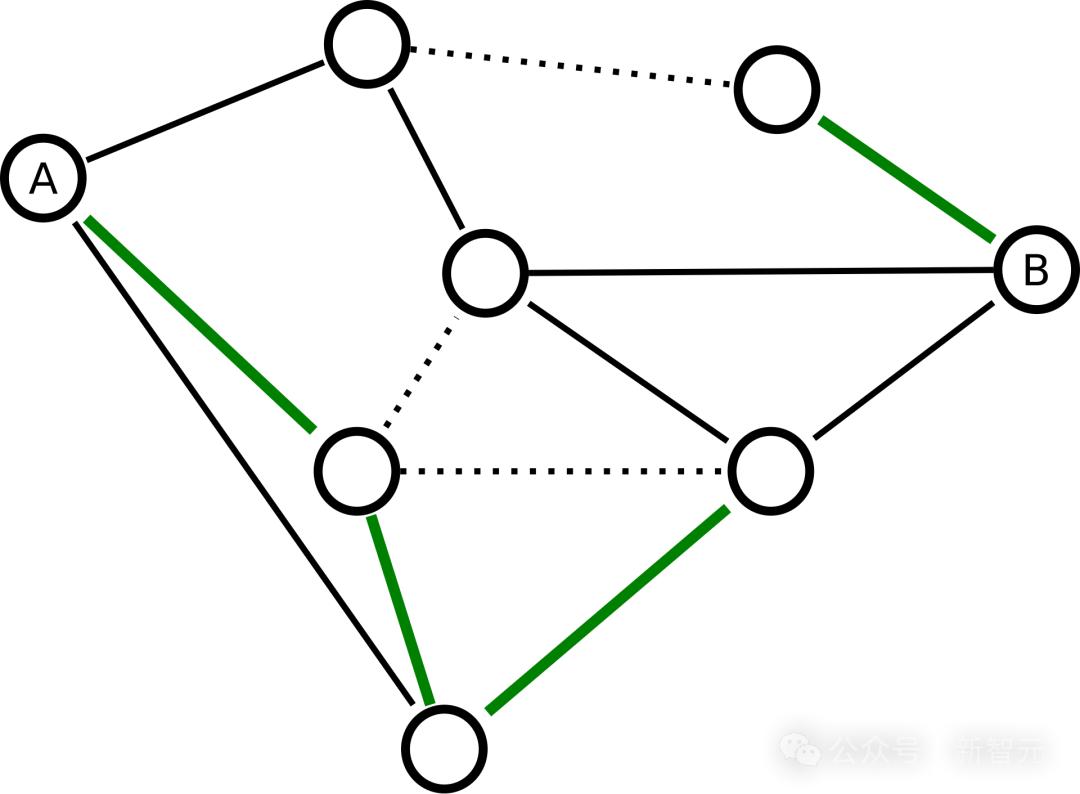

然而,我們無法詳盡無遺地搜索所有可能的方案,來找到一個最好的解,因為解決方案的數量大得驚人。

就像在國際象棋中,動作序列是一個指數級的增長,以後我們需要啟髮式方法,讓樹搜索或專家AI來運行一個函數,嘗試達到最終狀態。

好的系統和壞的系統的區別就在於,系統是否足夠聰明,能在不進行窮盡搜索的情況下,找到一個好的解決方案。

這就引出了專家系統,或基於世界的系統的AI。它們與搜索的概念密切相關。

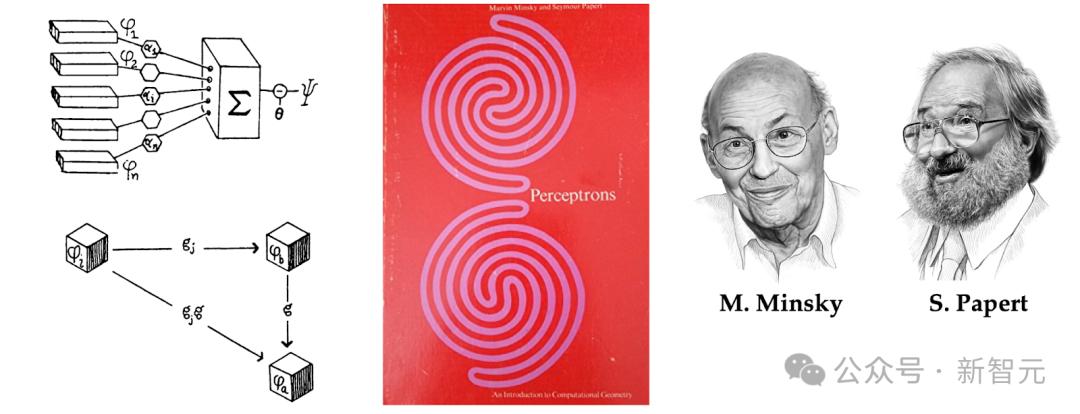

人們提出了一種算法,來改變神經元之間連接的強度,使他們能夠學習任務,這種類型的第一個機器叫做感知機,在1957年被提出來。

MIT教授Marvin Minsky和同校的數學家Seymour Papert就合著了一本《感知機》,這種統計模型識別在現實世界中有巨大的應用。

不過,感知機有個嚴重的問題,就是它可訪問的函數類型非常有限,沒辦法讓我們用一張自然圖片,就能訓練系統判斷其中是否有狗、貓或者桌子。

系統不夠強大,無法真正計算這種複雜的函數。

強化學習與自監督學習

在80年代,神經網絡和深度學習改變了這一切。實際上,神經網絡是深度學習的祖先,深度學習可以看作它的新名字。

我們的想法是,不是完全編程讓機器去做某事,而是通過數據對其進行訓練。

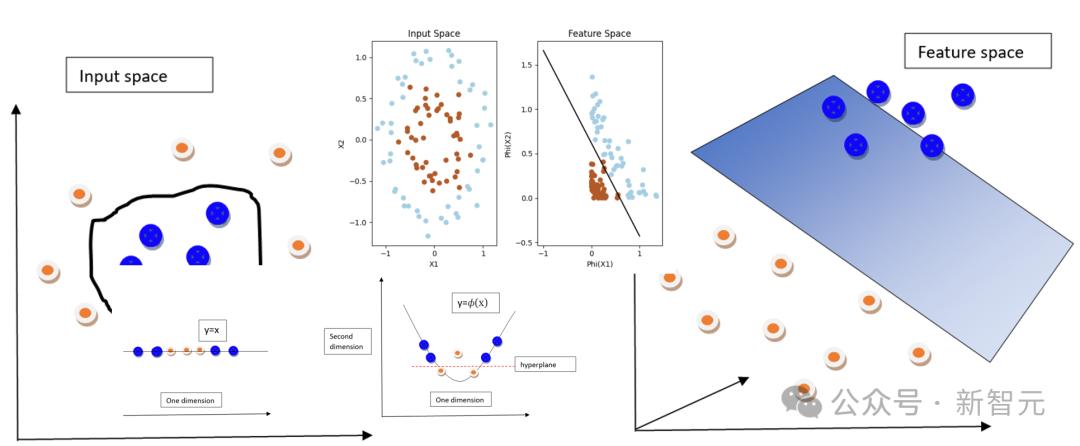

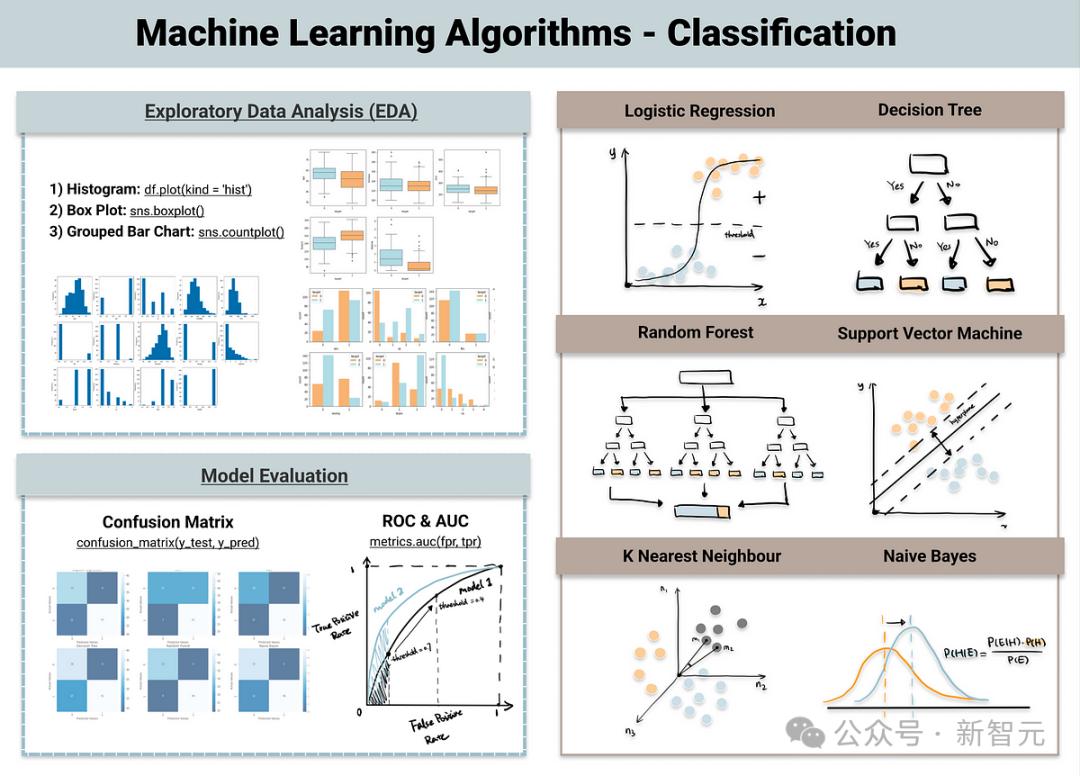

在機器學習中,有線性回歸,分類樹,支持向量機、核方法、貝葉斯推理等等。

在某種程度上,它們都遵循這樣的模型:我們構建了一個程序,但它實際上還沒有完成。它有一堆可調參數,輸入輸出函數由這些參數的值決定。

因此,我們使用迭代調整技術從數據中訓練系統。如果示例答案不正確,就調整參數,使其更接近我們想要的答案。

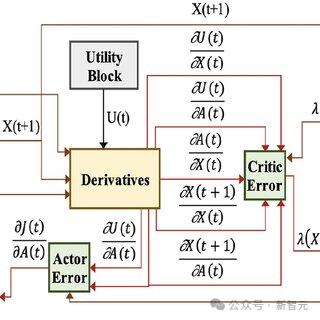

在強化學習中,我們不直接告知系統正確答案。只是告訴它所產生的答案好壞與否。

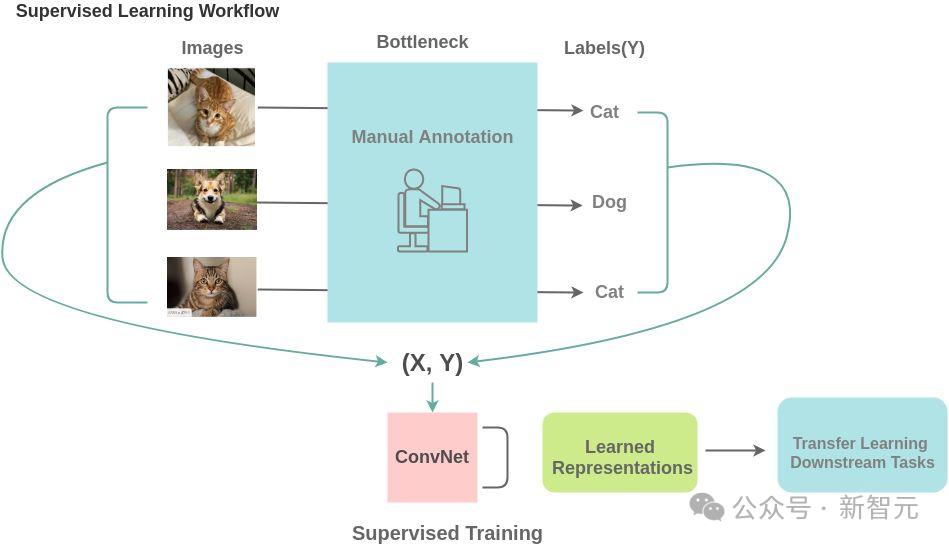

而過去五六年非常突出的自監督學習,已經真正成為讓聊天機器人和自然語言理解系統成功的主要因素。

它更類似於監督學習,但不同之處在於不需要有一個明確的輸入和輸出,並訓練系統從輸入生成輸出。

唯一的區別並不在於算法本身,而是體現在系統的結構和數據的使用及生成方式上。

我們不需要有人逐一檢查數百萬張圖片,告訴它這是貓還是狗在桌子旁邊。我們只需展示一張狗、貓或桌子的照片,並對其進行破壞,部分改變它,然後要求系統從損壞的圖像中恢復原始圖像。

這就是自監督學習的一種特定形式。

而這,對於自然語言理解的成功起到了關鍵作用。

比如,在大語言模型中,我們訓練一個系統來預測下一個詞,但是只允許它查看前面的詞語。這就需要以一種特定的方式構建神經網絡,使得用於預測一個詞的連接只能看到前邊的詞,這樣就不必對輸入進行干擾了。

最終,系統被訓練成從內容中預測出接下來的單詞。

在Transformer架構下,基本原理就是將每個輸入與其他輸入進行比較,並生成權重。

反向傳播算法與卷積神經網絡

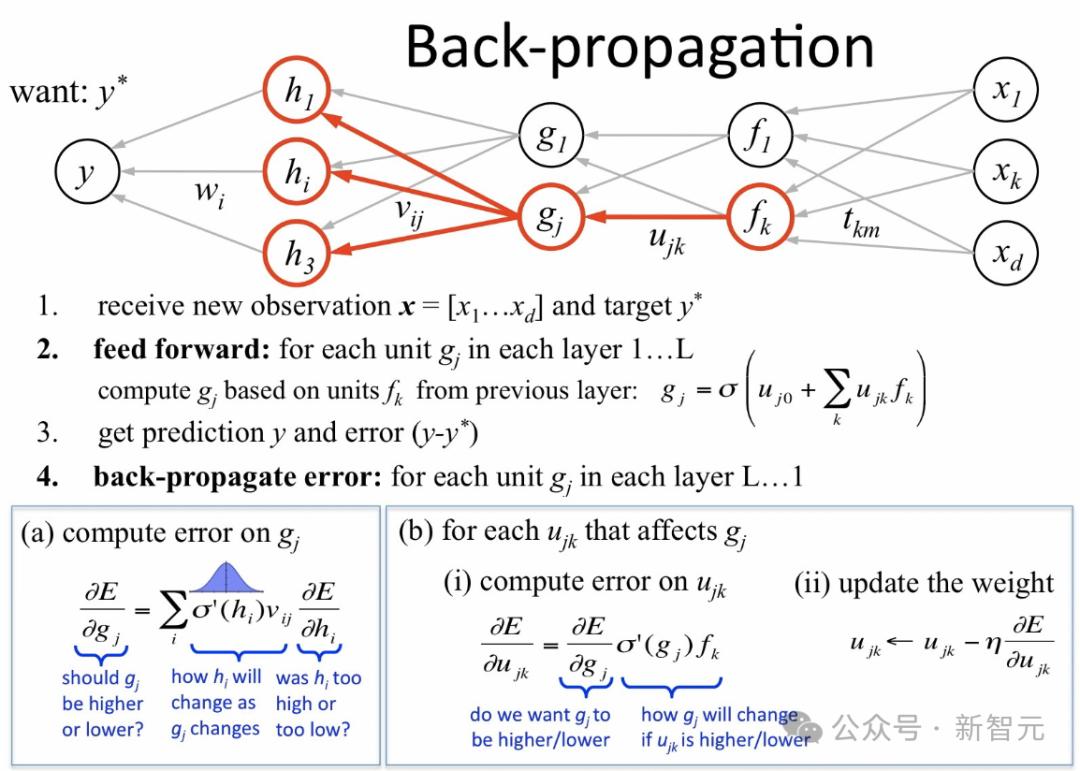

而反向傳播算法的作用,就是在我們展示一張C的圖像,並告訴系統這是C時,它能激活相應的輸出神經元,而不激活其他神經元。

它知道如何調整參數,使得輸出更接近我們想要的結果。這是通過向後傳播信號來實現的,基本上可以說是確定每個權重對每個輸出的敏感度,從而改變權重,讓好的輸出增加,壞的輸出減少。

其實,反向傳播算法之前就存在,但當時人們沒有意識到它可以用於機器學習,後來它從20世紀80年代開始風靡。

反向傳播算法至關重要,因為它打破了Minsky和Papert在20世紀60年代所說的感知機的限制,因此掀起了一股巨大的浪潮。

但人們後來意識到:訓練這些神經網絡需要大量的數據。

那時候還沒有互聯網,數據並不豐富,計算機速度也不快,因而人們對此興趣減弱。

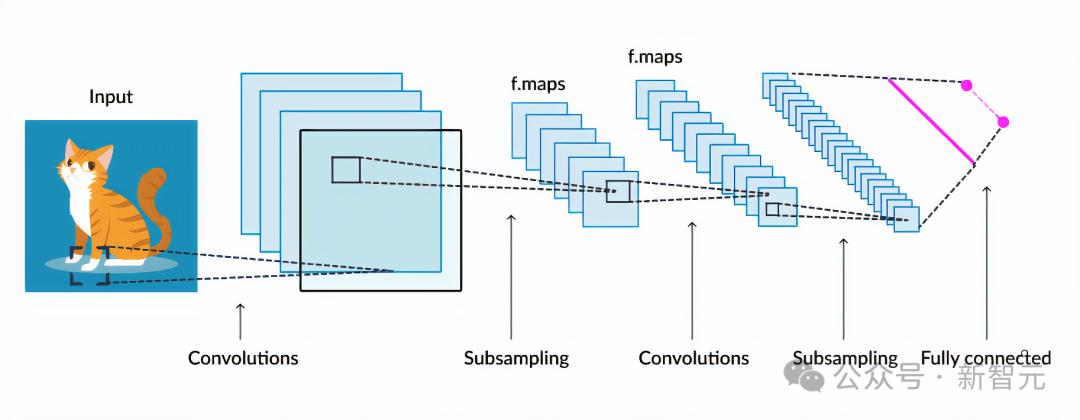

但是在80年代末、90年代初,LeCun研究的一個項目是,如果想讓這種系統識別圖像,就需要以某種特定的方式連接神經元來促進系統的關注。

他從生物學中獲得了靈感,借鑒了可以追溯到20世紀60年代的經典神經科學研究,以分層的方式來組織神經元之間的連接,使它們傾向於找到良好的圖像識別解決方案。

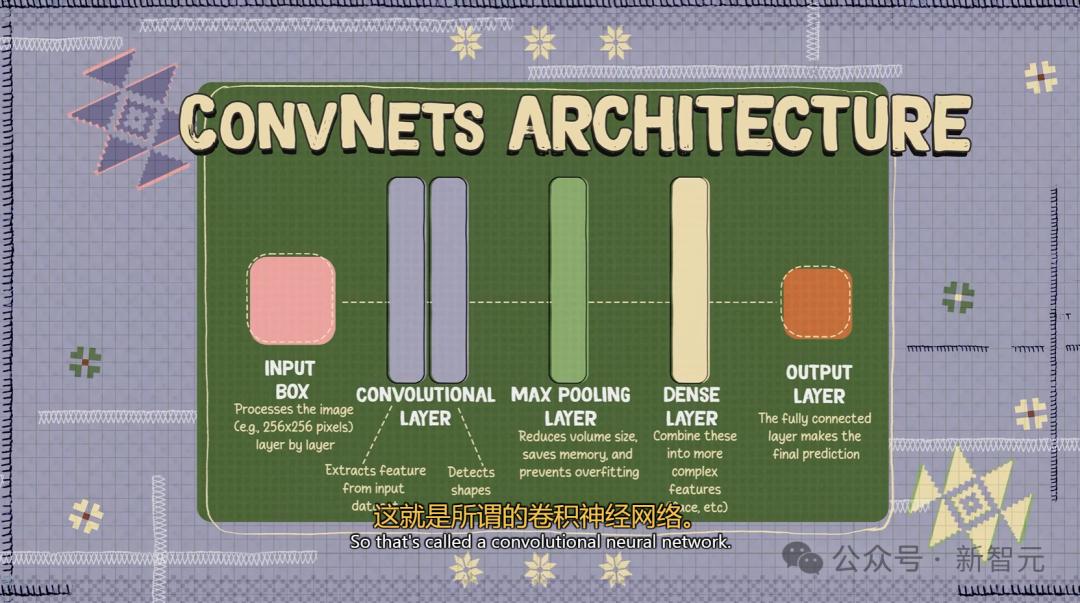

這就是所謂的卷積神經網絡。

它的設計靈感,來源於視覺皮層的架構。

卷積神經網絡特別適合處理來自自然世界的數據,如果我們拍一張照片,並取其中兩個相鄰的像素點,它們很可能具有相同的顏色或相同的強度。

像圖像和音頻這樣的自然數據,以及幾乎所有類型的自然信號都有其內在的結構。如我們以特定方式構建神經網絡來利用這種結構,它將學得更快,並且只需較少樣本即可學習。

卷積是卷積神經網絡中的一個組件。

它的思想是,一個神經元查看輸入的一部分,另一個神經元查看輸入的另一部分,但它計算與第一個神經元相同的函數。

接著將這個相同的神經元複製到輸入的所有位置上,這樣我們就可以把每個神經元看作是在檢測輸入某一部分的一個特定模式,並且所有神經元在輸入的不同部位都檢測同一個模式。

所以現在如果你取一個輸入並將其移動,就會得到同樣的輸出,但位置不同,因為相同的神經元會查看,並在不同的位置上檢測到相同模式。

這就是為什麼它會給你這種位移等變性,也就是所謂卷積。

它們之於真正的神經元,就如同飛機的機翼之於鳥類的翅膀——功能相同,具有同樣的概念。

AI捕捉到了語法的機器學習機制

香農的n-game模型,是一個語言模型。

我們可以在字符級別這樣做,但是在單詞級別這樣做,就會更困難,因為可能有一萬個可能的單詞。

我們需要在通過在一個大型文本語料庫上訓練,來填充這個概率表,從而訓練一個詞模型或語言模型。

但是在某個上下文長度以上,就變得不切實際了。因為需要大量的計算和工作量,還涉及到存儲所有這些表格的記憶,另外這些表格的填充也會非常稀疏,因為即使有數十億個詞的文本,大多數詞組組合都是不會出現的。

而如果採用Transformer這類架構的話,就能構建起一個系統,使其能夠根據上下文中的詞語預測下一個詞。

如果讓這個上下文儘可能大,比如幾千個、幾萬個甚至一百萬個詞,那麼就會得到具有湧現特性的系統。如果把它們做得足夠大,可能能達到數十億或數百億個參數。

在這種情況下,如果是文本的話,它們會複述解謎的答案,會給出你可能需要的問題答案。

這個過程中主要是檢索,有一點點推理,但不多。

人們真正感到驚訝的,是這些系統能以令人印象深刻的方式操縱語言。

要知道,人類在操縱語言方面其實相當有限,但AI似乎做得很好——它們捕捉到了語法的機器學習機制。

大語言模型,並不是通往AGI的路徑

在語言中,可能性有限的情況下,我們的確可以輸出一個概率列表。

但如果想預測影片中會發生什麼,幀數卻是無限的。一張圖像有一千個像素,像素顏色有三個值,因此需要生成三百萬個值,但我們還不知道如何表示所有可能的圖像集的概率分佈。

這是我們很多人認為AI領域下一個挑戰的地方。

如果說從影片和圖片中學習,這將是下一階段,那麼它應該放在哪裡?它屬於大語言模型現在的範疇嗎?

不,它與大語言模型完全不同。這也是為什麼LeCun一直明確表示,大語言模型並不是通往人類級別智能的路徑。

這也是為什麼大語言模型無法理解物理世界,並且不能以目前的形式真正理解和應對現實世界的原因。

儘管LLM在處理語言方面表現出色,但它們也會犯非常愚蠢的錯誤,這表明其實它們並不理解世界是如何運作的。

我們沒有真正理解基本事物的系統,而這些是你的貓都能理解的事。

所以LeCun一直直言不諱地說,最聰明的LLM也並不比你家裡貓更聰明。

JEPA:LeCun心中的「世界模型」

由此,也就引出了AI領域的下一個挑戰——如何構建能夠通過影片學習世界運行規律的系統。

人類對於週遭世界的認識,特別是在生命的早期,很大程度上是通過「觀察」獲得的。

就拿牛頓的「運動第三定律」來說,即便是嬰兒,或者貓,在多次把東西從桌上推下並觀察結果,也能自然而然地領悟到:凡是在高處的任何物體,終將掉落。

這種認識,並不需要經過長時間的指導,或閱讀海量的書籍就能得出。

相比之下,如今的LLM只適用於離散的語言世界,而無法理解連續高維的物理世界,例如影片中的動態。

這種局限性使LLM難以應對現實世界的問題,也就是為什麼LLM能通過考試寫文章,但我們還沒有家用機器人和L5自動駕駛。

目前,LLM的記憶分為兩種:

1. 參數記憶:在訓練過程中學到的知識,但無法逐字複述訓練數據。

2. 上下文記憶:通過輸入提示詞暫時存儲信息,但範圍有限。

然而,真正理解物理世界的AI需要持久記憶,類似於人類大腦中的海馬體,能夠存儲和檢索長期信息。但目前的LLM缺乏獨立的記憶模塊,無法卡奧效搜索和評估多種可能的答案。

為了實現這一目標,我們需要新的架構,擺脫LLM的自回歸方法,轉而適用於影片的自監督學習。

具體方法是讓AI通過預測影片中接下來的變化來理解世界的底層結構,而不是簡單地生成每個像素的變化。

這種預測能力可以幫助AI構建「世界模型」,從而支持規劃和推理。例如,預測推杯子、抓取、提起等動作的結果是否能實現目標。

回到如何讓機器通過觀察世界來學習這個問題上。很顯然,我們不能靠著現在這種僅僅生成影片中每個像素的生成式架構。

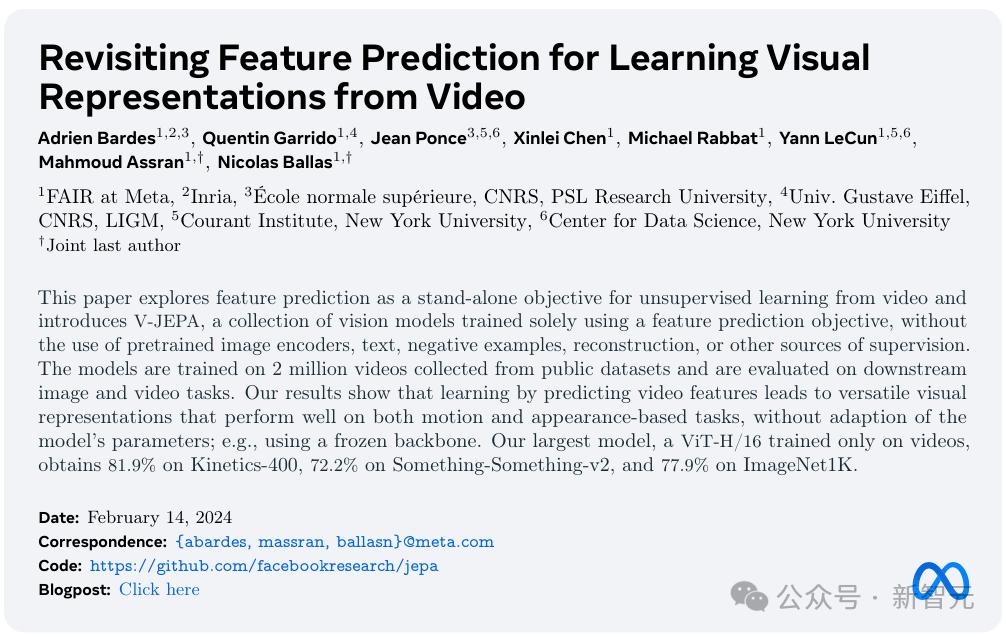

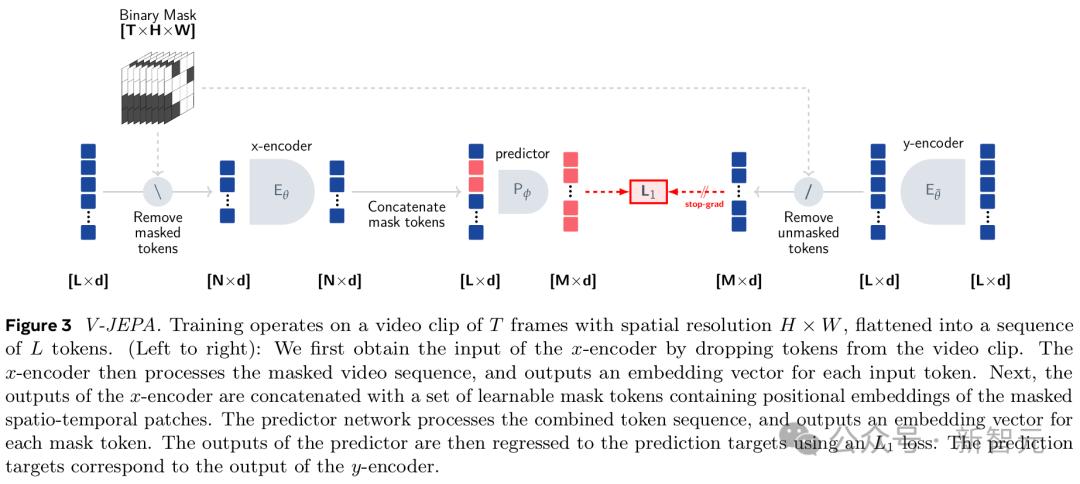

為此,LeCun的團隊嘗試了近15年的時間,並在5年前提出了一種全新的方法——JEPA(聯合嵌入預測架構)。

一直以來,LeCun堅信世界有一種「世界模型」,並著力開發一種新的類似大腦的AI架構,目的是通過更真實地模擬現實世界來解決當前系統的局限性,例如幻覺和邏輯上的缺陷。

這也是想要AI接近人類智力水平,需要像嬰兒一樣學習世界運作的方式。

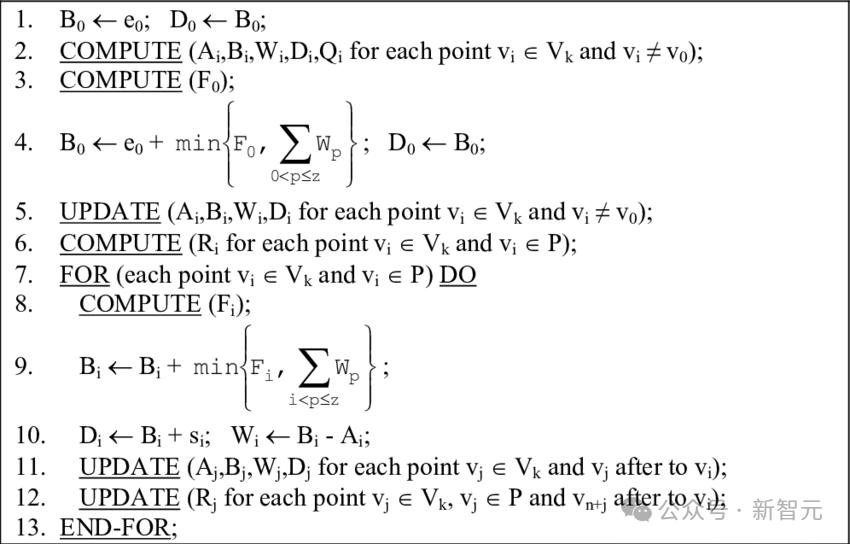

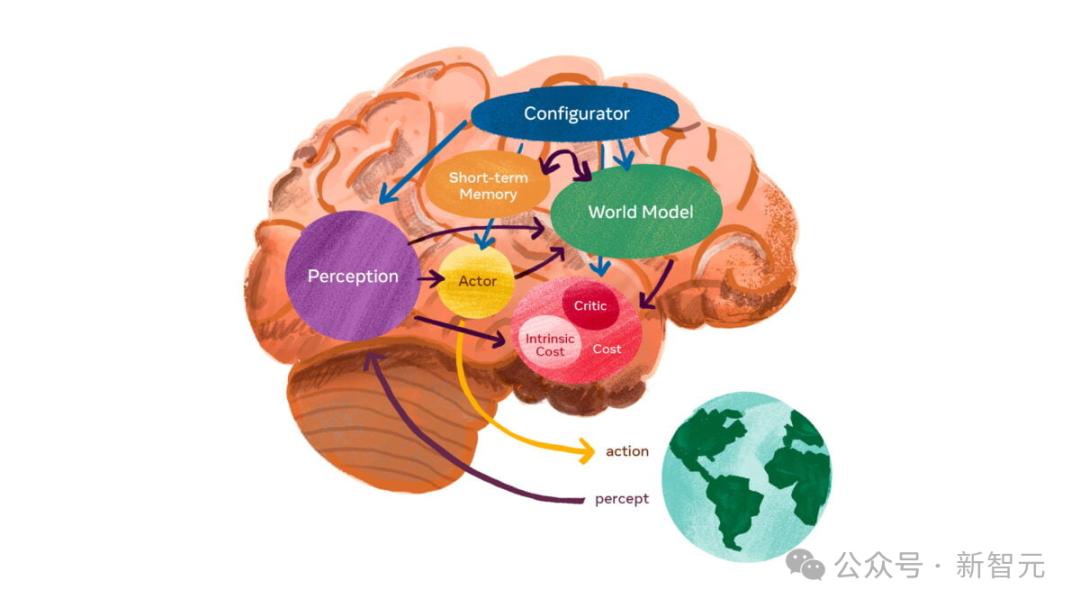

這個世界模型的架構,由6個獨立的模塊組成:配置器模塊、感知模塊、世界模型模塊、成本模塊、短期記憶模塊,以及參與者模塊。

其中,核心是世界模型模塊,旨在根據來自感知模塊的信息預測世界。能夠感知人在向哪移動?汽車是轉彎還是繼續直行?

另外,世界模型必須學習世界的抽像表示,保留重要的細節,並忽略不重要的細節。然後,它必須在與任務水平相適應的抽像級別上提供預測。

自2022年LeCun首提JEPA之後,I-JEPA和V-JEPA分別基於圖像、影片擁有強大的預測能力。

值得一提的是,V-JEPA的發佈正好是OpenAI推出Sora模型的當天。

論文地址:https://ai.meta.com/research/publications/revisiting-feature-prediction-for-learning-visual-representations-from-video/

與生成式AI模型完全不同,V-JEPA是一種「非生成式模型」。它通過預測影片中被隱藏或缺失部分,在一種抽像空間的表示來進行學習。

這與圖像聯合嵌入預測架構(I-JEPA)類似,後者通過比較圖像的抽像表示進行學習,而不是直接比較「像素」。

不同於那些嘗試重建每一個缺失像素的生成式方法,V-JEPA能夠捨棄那些難以預測的信息,這種做法使得在訓練和樣本效率上實現了1.5-6倍的提升。

由於採用了自監督的學習方式,V-JEPA可以完全依靠未標註的數據進行預訓練,然後再通過標註數據進行微調即可。

在看到下面影片中的動作時,V-JEPA會說「將紙撕成兩半」。

再比如,翻看筆記本的影片被遮擋了一部分,V-JEPA便能夠對筆記本上的內容做出不同的預測。

這些,是V-JEPA在觀看200萬個影片後,就獲取到的超能力。

總結來說,現有的大語言模型屬於系統一思維,即快速、直覺性的反應。而AGI需要的是系統二思維:深度思考、理性分析和戰略規劃。

對此,LeCun提出的「目標驅動人工智能」架構正是基於系統二思維,也就是說,它能夠從真實世界中學習並且可以進行分層規劃。

參考資料:

https://x.com/tsarnick/status/1861921602235150545

本文來自微信公眾號「新智元」,編輯:Aeneas 好睏 ,36氪經授權發佈。