清華新VLA框架加速破解具身智能止步實驗室「魔咒」,LLM開銷節省4-6倍 | NeurIPS’24

DeeR-VLA團隊 投稿

量子位 | 公眾號 QbitAI

計算、存儲消耗高,機器人使用多模態模型的障礙被解決了!

來自清華大學的研究者們設計了DeeR-VLA框架,一種適用於VLA的「動態推理」框架,能將LLM部分的相關計算、內存開銷平均降低4-6倍。

(VLA:視覺-語言-動作模型,代表一類用於處理多模態輸入的模型)

簡單來說,DeeR-VLA就像人的決策系統:簡單任務快速思考,複雜任務仔細思考。通過多出口架構,模型在足夠計算後即可提前「刹車」,避免浪費算力。

在CALVIN機器人操作基準測試中,DeeR-VLA實現了大語言模型(LLM)計算成本減少5.2-6.5倍,GPU內存減少2-6倍,同時保持了性能不受影響。

大模型存在冗餘性

近年來,多模態大語言模型(MLLM)讓機器人具備了前所未有的理解與執行能力。通過語言指令和視覺信息的結合,機器人可以完成複雜任務,比如「抓起藍色物體並放到桌上」。

一些前沿模型,如RT-2,甚至可以泛化到新任務或新物體。然而,要讓這些強大的模型走進實際場景,還有一道難題需要解決——MLLM雖然聰明,但也「貪吃」。

每次推理動輒調用數十億參數,消耗巨大的計算資源。

這對於嵌入式機器人平台來說是致命的——GPU內存不足、計算時間長、電池續航不夠,直接讓「通用機器人」的夢想止步於實驗室。

然而實際上,在機器人控制領域,很多實際應用場景並沒有我們想像的那麼複雜。

論文作者通過觀察發現,絕大多數任務實際上可以通過較小的模型就能完成,只有在面對少數複雜場景時,才需要調用完整的大型多模態模型。

以Calvin數據集為例的實驗結果便充分體現了這一點:當使用24層的OpenFlamingo作為基座模型時,相比於6層的模型,任務完成率僅提高了3.2%,但計算成本卻增加了整整4倍。

這無疑凸顯了現有的多模態大模型對大部分簡單機器人任務的冗餘性。

這一發現引發了對現有模型設計的深刻思考:

為什麼在大多數簡單任務中還要使用高計算資源的複雜模型?

在很多情況下,使用更大的模型不僅沒有帶來明顯的性能提升,反而浪費了寶貴的計算資源。

作者認為,如何根據任務的複雜性動態調整模型的規模,才能在不犧牲性能的情況下,最大化計算效率,成為了提升機器人智能的關鍵。

DeeR-VLA的設計

DeeR-VLA框架的核心在於其靈活的動態推理機制,能夠根據任務複雜度智能調節LLM的計算深度。

這意味著,DeeR-VLA能夠在不同場景中激活任意規模的模型。

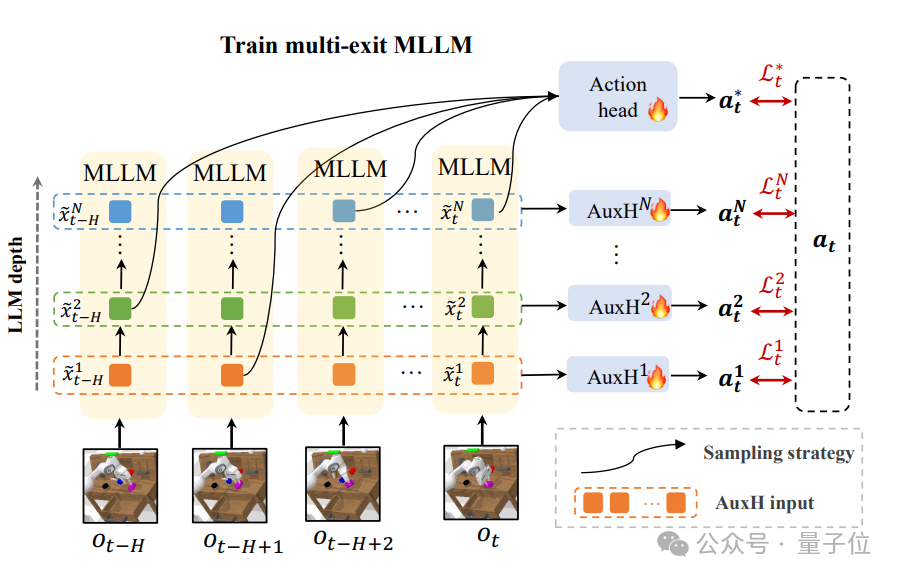

為了實現這一目標,DeeR-VLA引入了多出口架構,該架構能在多模態大語言模型中按需選擇性激活不同的層級。

以下是其關鍵技術組件:

-

多出口MLLM結構: DeeR-VLA通過在MLLM中引入多出口架構,將模型劃分為多個階段,每個階段都可以輸出中間結果。一旦任務複雜度達到某個出口的需求,模型就會提前停止計算,避免激活更多層級。

-

特徵池化方法: 每個出口的中間特徵通過特徵池化技術進行壓縮,提取出最核心的信息。這種方法確保即便在早期退出,模型也能生成適用於後續動作預測的高質量特徵。

-

動作預測頭設計: 在每個出口後,模型通過輕量級的動作預測頭,將特徵轉化為機器人具體的執行動作(如機械臂的位置和夾爪的開合狀態)。

DeeR-VLA使用了一種獨特的動作一致性準則來決定是否提前退出。

通過對比相鄰出口的動作預測結果,若結果差異小於閾值,則推斷模型已經達到收斂狀態,無需進一步計算。

動作一致性的閾值無需手動設置,模型可以自動計算出合適的閾值來滿足給定的設定平均計算成本、峰值計算、顯存預算,動態調整計算規模,以適應不同的硬件環境和實時性需求。

為了自動尋找最佳退出閾值,DeeR-VLA還引入了貝葉斯優化方法。在訓練或實際應用中,該方法通過探索和反饋不斷微調退出策略,確保計算資源的最優分配。

在DeeR-VLA中,動態推理時,模型根據確定性的標準在每個時間步選擇合適的出口,並彙集時序上每一個時刻的特徵生成最終的預測。

然而,在訓練階段,由於缺乏明確的終止標準,模型並不清楚時序上出口特徵的分佈,這導致訓練時的行為與推理時有所不同。

為瞭解決這一問題,DeeR-VLA引入了隨機出口采樣策略。

在訓練過程中,模型在每個時間步隨機選擇一個出口進行計算,這樣可以確保模型在所有出口序列上都能進行有效學習,並生成高質量的預測。

這種策略有效減少了訓練和推理之間的分佈差異,使得模型能夠更好地應對動態推理過程中的不確定性。

此外,論文作者還引入了輔助預測頭(Auxiliary Heads)作為額外的監督信號,對每個出口的特徵進行優化,使其更適合於動作預測任務。

實驗驗證

DeeR-VLA框架在CALVIN長Horizon多任務語言控制挑戰(LH-MTLC)基準上進行評估。該基準目的是測試機器人在自然語言指令下執行任務序列的能力,其中每個任務序列包含五個子任務。

由於多模態大模型中LLM部分佔據主要的參數量,DeeR-VLA主要關注LLM部分的計算量和顯存佔用,而不是整體框架的節省。

通過在不同環境設置下的測試,DeeR-VLA展現了出色的表現,尤其是在任務成功率與計算效率之間的平衡。

與其他SOTA方法相比,DeeR-VLA在任務成功率上保持競爭力的同時,LLM部分的計算資源消耗大幅減少。

例如,在D→D設置下,DeeR-VLA以更少的計算量(5.9倍減少的FLOPs)和2倍更低的GPU內存消耗,依然達到了RoboFlamingo++的性能。

為了驗證DeeR-VLA在實際推理中的效率,研究團隊在Nvidia V100 GPU上對DeeR和RoboFlamingo++進行了比較。

結果表明,DeeR-VLA的LLM部分的推理時間比RoboFlamingo++減少了68.1%,且兩者在任務成功率上幾乎相同。

這一實驗證明了DeeR-VLA框架不僅在理論上能夠減少計算負擔,而且在實際應用中也能顯著提升推理速度。

同時,DeeR-VLA框架能夠與量化技術相結合,進一步減少模型LLM部分的內存使用。

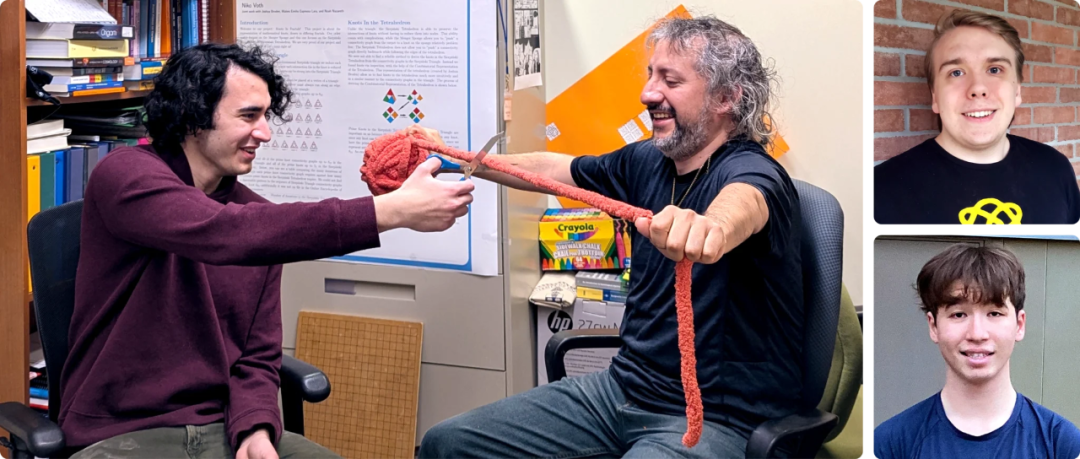

論文作者介紹

該論文的一作是清華大學自動化系三年級博士生Yue Yang,他專注於強化學習、世界模型、多模態大模型和具身智能的研究。

此前他作為核心作者的論文《How Far is Video Generation from World Model: A Physical Law Perspective》被國內外眾多大佬Yan Lecun,xie saining,Kevin Murphy等轉發。

另一位一作王語霖同樣是清華大學的博士生。兩位作者的導師都是黃高。

論文作者主頁:

https://yueyang130.github.io/

論文鏈接:

https://arxiv.org/abs/2411.02359v1

代碼和模型鏈接:

https://github.com/yueyang130/DeeR-VLA