剛剛,三名GoogleVision Transformer作者官宣加入OpenAI

機器之心報導

編輯:張倩、Panda

三人是緊密的合作夥伴。

最近,OpenAI 又迎來了新的人事變動,但這次不是某個技術大牛離職,而是從Google挖來了一些新鮮血液。

這些「新人」來自Google DeepMind 的蘇黎世辦事處,包括資深研究科學家 Xiaohua Zhai(翟曉華)、研究科學家 Lucas Beyer 和 Alexander Kolesnikov。在Google DeepMind 工作期間,三人就是密切的合作夥伴,共同參與了 ViT 等重要研究。之後,他們將一起建立 OpenAI 蘇黎世辦事處。

OpenAI 高管在週二的一份內部備忘錄中告訴員工,三人入職後將從事多模態 AI 研究。

在 DeepMind 工作期間,Beyer 似乎一直在密切關注 OpenAI 發佈的研究成果以及該公司捲入的公共爭議,他經常在 X 上向自己的 7 萬多名粉絲發佈相關信息。去年,當首席執行官 Sam Altman 被 OpenAI 董事會短暫解僱時,Beyer 發帖稱,他目前讀到的關於解僱的「最合理」解釋是,Altman 同時參與了太多其他初創公司的工作。

在競相開發最先進的人工智能模型的同時,OpenAI 及其競爭對手也在激烈競爭,從世界各地招聘有限的頂尖研究人員,通常為他們提供接近七位數或更高的年薪。對於最搶手的人才來說,在不同公司之間跳槽並不罕見。

例如,Tim Brooks 曾是 OpenAI 的 Sora 負責人,最近他離職前往 DeepMind 工作。不過,高調挖角的熱潮遠不止 DeepMind 和 OpenAI。今年 3 月,微軟從 Inflection AI 公司挖走了其人工智能負責人 Mustafa Suleyman 以及該公司的大部分員工。而Google斥資 27 億美元將 Character.AI 創始人 Noam Shazeer 拉回麾下。

在過去幾個月裡,OpenAI 的一些關鍵人物相繼離職,有的加入了 DeepMind 和 Anthropic 等直接競爭對手,有的創辦了自己的企業。OpenAI 聯合創始人、前首席科學家 Ilya Sutskever 離職後,創辦了一家專注於人工智能安全和生存風險的初創公司 Safe Superintelligence。OpenAI 前首席技術官 Mira Murati 於 9 月份宣佈離職,據說她正在為一家新的人工智能企業籌集資金。

今年 10 月,OpenAI 表示正在努力向全球擴張。除了新的蘇黎世辦事處,該公司還計劃在紐約市、西雅圖、布魯塞爾、巴黎和新加坡開設新的分支機構。除舊金山總部外,該公司已在倫敦、東京和其他城市設立了分支機構。

LinkedIn 上的資料顯示,Zhai、Beyer 和 Kolesnikov 都住在蘇黎世,蘇黎世已成為歐洲一個相對突出的科技中心。蘇黎世是 ETH (蘇黎世聯邦理工學院)的所在地,ETH 是一所公立研究型大學,擁有全球知名的計算機科學系。據《金融時報》今年早些時候報導,蘋果公司還從Google挖走了一些人工智能專家,在「蘇黎世的一個秘密歐洲實驗室」工作。

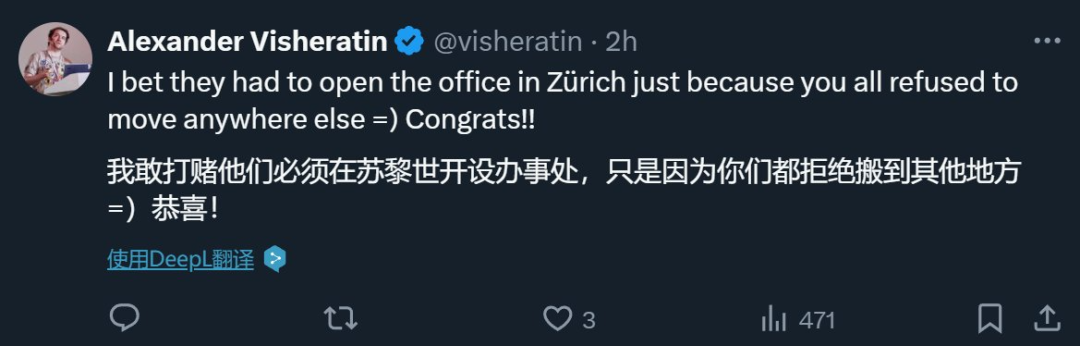

也有人猜測,OpenAI 之所以在蘇黎世設立辦事處,是因為三個人都不願意搬家。

也有人猜測,OpenAI 之所以在蘇黎世設立辦事處,是因為三個人都不願意搬家。緊密合作的三位科學家

從已發表的研究看,這三位研究者經常從事同一個項目的研究,並且他們也做出了一些非常重要的研究成果,其中一些被 AI 頂會作為 Spotlight 和 Oral 論文接收。

Xiaohua Zhai(翟曉華)

個人主頁:https://sites.google.com/view/xzhai

Google DeepMind(蘇黎世)的資深研究科學家和管理者。他領導著蘇黎世的一個多模態研究團隊,其研究重心是多模態數據、開放權重模型和包容性。

根據其領英簡曆,他於 2014 年在北京大學取得了計算機科學博士學位。之後曾在Google從事了三年軟件工程師的工作。2017 年 12 月,他加入 DeepMind 擔任研究科學家,並一直在此工作了 7 年。

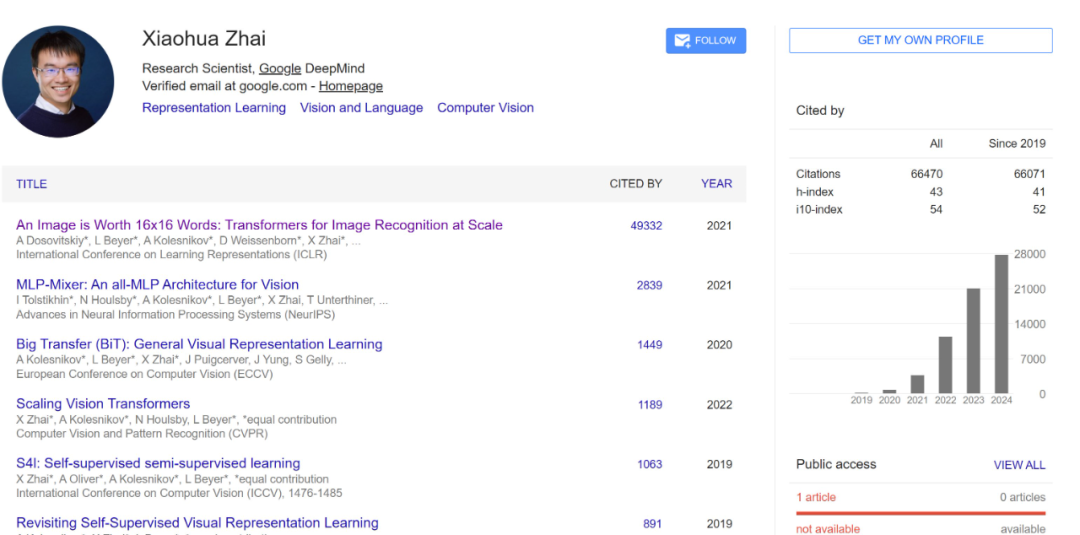

目前,翟曉華在 Google Scholar 上的被引量已經達到了 6 萬多,其中大部分被引量來自他們三人共同參與的 ViT 論文《An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale》。

Lucas Beyer

Lucas Beyer 是 DeepMind 研究科學家。

個人博客:https://lucasb.eyer.be/

他在 2018 年於德國亞琛工業大學完成了自己的高等學業,期間曾在Google以實習生身份從事過研究工作,也在 Kindred.ai 擔任過 AI 工程師,在德國亞琛工業大學擔任過研究助理。

畢業後,他正式加入Google,先後在Google大腦與 DeepMind 從事研究工作。

他在博客中寫到:「我是一名自學成才的黑客和科學家,致力於創造非凡事物。目前在瑞士蘇黎世生活、工作、戀愛和玩耍。」

Alexander Kolesnikov

Alexander Kolesnikov 已經更新了自己的領英頁面,他曾經也是 DeepMind 的研究科學家。

個人主頁:https://kolesnikov.ch

他於 2012 年碩士畢業於莫斯科國立大學,之後在奧地利科學技術研究所取得了機器學習與計算機視覺博士學位。類似地,2018 年博士畢業後,他也先後在Google大腦和 DeepMind 從事研究工作。

出色的研究成果

很顯然,這三位研究者是一個非常緊密的研究團隊,也因此,他們的很多研究成果都是三人共同智慧的結晶(當然還有其他合作者),我們下面將其放在一起介紹。

首先必須提到的就是這篇論文:

-

論文標題:An Image is Worth 16×16 Words: Transformers for Image Recognition at Scale

-

論文地址:https://arxiv.org/pdf/2010.11929

-

項目地址:https://github.com/google-research/vision_transformer

這篇就是大名鼎鼎的 Vision Transformer(ViT)論文,其中提出可以使用 Transformer 來大規模地生成圖像,機器之心也曾做過報導,參閱《NLP/CV 模型跨界進行到底,視覺 Transformer 要趕超 CNN?》。目前,這篇論文的引用量已經接近 5 萬,這三位研究者均是共同技術一作。

此後,他們還研究了 ViT 的 Scaling Law。

-

論文標題:Scaling Vision Transformers

-

論文地址:https://arxiv.org/pdf/2106.04560

通過擴大和縮小 ViT 模型和數據的規模,他們研究了錯誤率、數據和計算之間的關係。在此過程中,他們還對 ViT 的架構和訓練進行了改進,減少了內存消耗並提高了生成模型的準確性。

另外,他們也為 ViT 開發了一些改進版本,對其性能或效率等不同方面進行了優化,比如能適應不同圖塊大小的 FlexiViT,參閱論文《FlexiViT: One Model for All Patch Sizes》。

他們也探索了另一些架構創新,比如他們在論文《MLP-Mixer: An all-MLP Architecture for Vision》中提出了一種用於視覺任務的純 MLP 架構 MLP-Mixer;在論文《Big Transfer (BiT): General Visual Representation Learning》中,他們重新審視了在大型監督數據集上進行預訓練並在目標任務上微調模型的範式,並通過擴大了預訓練的規模提出了所謂的 Big Transfer 方案。

他們也開發了一些在當時都達到了 SOTA 的開發模型,比如 PaliGemma,這是一個基於 SigLIP-So400m 視覺編碼器和 Gemma-2B 語言模型的開放式視覺語言模型 (VLM),其在同等規模下的表現非常出色。而在論文《Sigmoid Loss for Language Image Pre-Training》中,他們僅使用 4 塊 TPUv4 芯片,在 2 天時間內就訓練出了一個在 ImageNet 上實現了 84.5% 的零樣本準確度的模型。

他們在計算機視覺方面的很多研究成果都統一在了 Google 的 Big Vision 項目中,參閱 https://github.com/google-research/big_vision

他們近期的研究重心是統一、簡化和擴展多模態深度學習,比如:

-

UViM: A Unified Modeling Approach for Vision with Learned Guiding Codes,該論文提出了一種建模多樣化計算機視覺任務的統一方法。該方法通過組合使用一個基礎模型和一個語言模型實現了互相增益,從而在全景分割、深度預測和圖像著色上取得了不錯的效果。

-

Tuning computer vision models with task rewards,這項研究展示了強化學習在多種計算機視覺任務上的有效性,為多模態模型的對齊研究做出了貢獻。

-

JetFormer: An Autoregressive Generative Model of Raw Images and Text,這是上個月底才剛剛發佈的新研究成果,其中提出了一種創新的端到端多模態生成模型,通過結合歸一化流和自回歸 Transformer,以及新的噪聲課程學習方法,實現了無需預訓練組件的高質量圖像和文本聯合生成,並取得了可與現有方法競爭的性能。

當然,這三位研究者多年的研究成果遠不只這些,更多成果請訪問他們各自的主頁。

看來,OpenAI 這次是真挖到寶了,難怪有人說Google失去這三位人才會是一個戰略失誤。

參考鏈接:

參考鏈接:https://www.wired.com/story/openai-hires-deepmind-zurich/

https://x.com/XiaohuaZhai/status/1864175652624097366