上交團隊打造新型算法平台,實現關係表格學習和大語言模型高效協同

2022 年底,ChatGPT 的誕生,引發了全球科技界的狂歡。

它讓人感興趣的地方不只在於所具備的強大的認知能力,還包括新穎的收費方式,即按照 token 收費。(編者註:這裏的「token」通常是指文本處理中的基本單位。)

換言之,ChatGPT 按照用戶輸入和輸出的「字數」進行收費,費用約為「$0.002 per 1k tokens」,也就是每 1000 個 token 的費用是 0.002 美元。

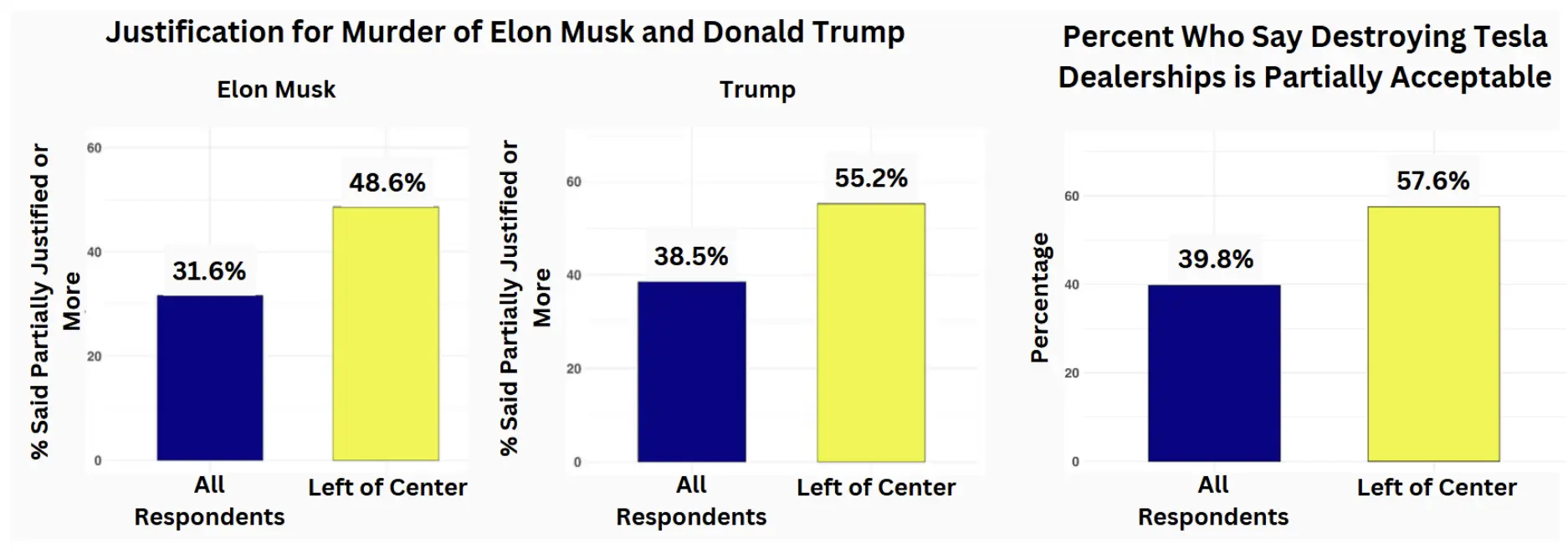

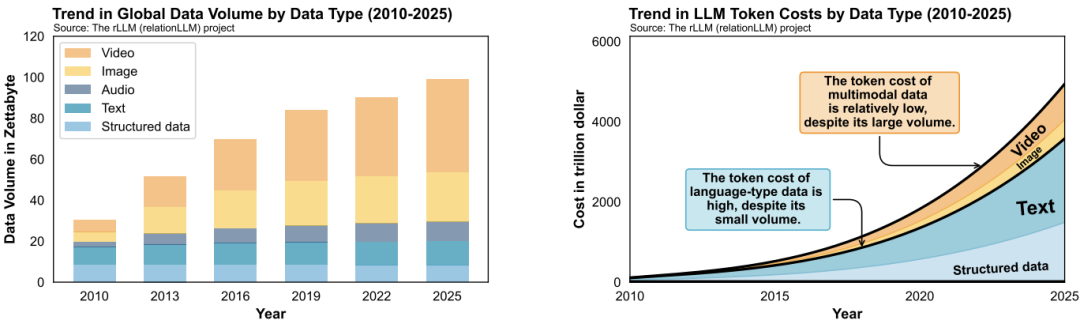

圖丨按數據類型劃分的全球數據量和大語言模型 token 成本的趨勢(來源:arXiv)

圖丨按數據類型劃分的全球數據量和大語言模型 token 成本的趨勢(來源:arXiv)對此,上海交通大學王錚副教授有一個直覺:如果全世界的數據都採用 ChatGPT 來處理,一定會產生巨大的開銷。

圖丨王錚(來源:王錚)

圖丨王錚(來源:王錚)他和團隊經過簡單評估後發現,事實的確如此。

就以 2025 年為例,大語言模型的總體開銷可達 5000 萬億美金,約為美國 2023 年 GDP(27.37 萬億美元)的 214 倍。

此外,他們也發現,儘管關係數據庫佔據了全球數據管理系統 73% 的市場份額 [1],但基於大語言模型的關係數據庫智能分析方面的工作,尚屬空白。

在此背景下,他們決定發起 rLLM(relationLLM)項目,打造一個能夠快速、經濟、高效地搭建關係表格學習和大語言模型協同的算法平台。

並且,也提出了首個關係表格學習算法 BRIDGE,在標準的表格分類任務上,其結果常常能優出傳統方法 2 至 3 倍。

近日,相關論文以《rLLM:使用大型語言模型進行關係表格學習》(rLLM: Relational Table Learning with LLMs)為題在預印本平台 arXiv 上發表 [1]。

圖丨相關論文(來源:arXiv)

圖丨相關論文(來源:arXiv)據王錚介紹,雖然 rLLM 的第一個版本在 2024 年 8 月才正式發佈,但同年 2 月,第一個內部測試版本就已經出現,只是那時還缺少關於 rLLM 的用戶使用反饋。

為解決這一問題,王錚將該項目作為上海交通大學大三年級「IEEE 試點班」《信息內容理解》課程的「打榜」大作業,要求學生以分組的形式,每週在標準的數據集和任務上進行「PK」(精度、時間和開銷)。

通過該方法,該課題組收穫了很多 rLLM 的使用反饋,這為版本的後續改進提供了有效參考。

那麼,rLLM 這一平台的應用前景如何?

從功能上看,目前數據庫產品主要分為聯機事務處理和聯機分析處理兩種類型,前者主要負責基本的事務處理,例如對銀行交易進行記錄和查詢,後者主要負責數據的統計分析,例如生成銀行交易整體分析報告。

所以,聯機智能分析(OLIP,Online Intelligent Processing)一直比較缺乏。

王錚表示:「實際上,業界一直都想做 OLIP,只是效果不太理想,如今大語言模型的出現,給這個方向帶來了曙光。」

也就是說,rLLM 可以被認為是在 OLIP 領域的一次良好探索。據瞭解,目前該項目已獲得國內頭部科技公司的資助,正與後者的業務系統進行對接實驗。

另外,如果從宏觀上看,以關係數據庫為代表的數據行業,擁有較為成熟的萬億規模市場。

與此同時,大語言模型正掀起新一輪人工智能革命,潛在市場規模巨大,極有可能顛覆傳統人類社會底層經濟運行邏輯。

所以,假如 rLLM 和其他「數智協同」項目能為上述兩個領域搭建一座橋樑,將會帶來重大的科技與經濟意義。

這裏,需要說明的是,「數智協同」可以形象的被理解成 AI 時代的操作系統,不僅要調度各類 AI 模型,還要調度各類數據管理系統,這樣才能支撐起未來全球經濟生活的方方面面。

當下,中國擁有全球最豐富的「數智協同」場景。因此,在該研究的基礎上,該團隊接下來也計劃聯合學術界和企業界的合作夥伴,開發一系列相關的解決方案。

王錚指出,在計算機領域,有一個隱秘的「20 年週期定律」:如果一次技術浪潮能夠成功,那麼其將在第一個十年中經歷從萌芽到泡沫的過程,在第二個十年里經歷各類技術各自佔領市場的過程。

其中,比較有代表性的是大數據技術。從 2003 年Google「三駕馬車」誕生至今差不多有 20 年,各類大數據技術已經都發展成熟並獲得廣泛應用。

「而當下也正處於‘AI 的 20 年週期’。前十年從 2012 年圖靈獎獲得者傑佛瑞·辛頓(Geoffrey Hinton)和學生的深度學習算法 AlexNet 碾壓式的 ImageNet Cup 奪冠開始,後十年以 2022 年底 ChatGPT 的推出作為起點。」王錚表示。

從這個角度來看,未來十年會是各類 AI 技術的決勝階段。

「我很期待中國高校和科技公司能在該領域開創出一片天地。」王錚如是說。

參考資料:

1.https://db-engines.com/en/ranking_categories

2.Li W, Huang X, Zheng J, et al. rLLM: Relational table learning with LLMs.arXiv:2407.20157, 2024.https://doi.org/10.48550/arXiv.2407.20157

運營/排版:何晨龍