OpenAI附議Ilya預訓練終結!「但Scaling Law還沒死」

白交 發自 凹非寺

量子位 | 公眾號 QbitAI

Is Scaling is All you Need?

在Ilya探討完「預訓練即將終結」之後,關於Scaling Law的討論再次引發熱議。

這屆NeurIPS將被銘記成預訓練終結的一屆會議

在最新研討會上,OpenAI大神,o1核心成員Noam Brown表示,o1代表的是一種全新的,以推理計算為代表的Scaling。

網民們表示:好好好,Scaling Law還沒有死!Scaling Law還在繼續。

演講實錄:Is Scaling is All you Need?

Noam Brown,OpenAI大神一枚,去年7月從Meta離職,曾開發首個在戰略遊戲中達到人類水平的AI,此前在遊戲AI領域相關研究成果曾登上Science封面。

如今在OpenAI致力於多步推理、自我博弈以及多智能體AI相關的研究。

此前在o1發佈的直播時候露過面。

據網民@swyx分享,Noam Brown首先談到Scaling Law的過去演進。

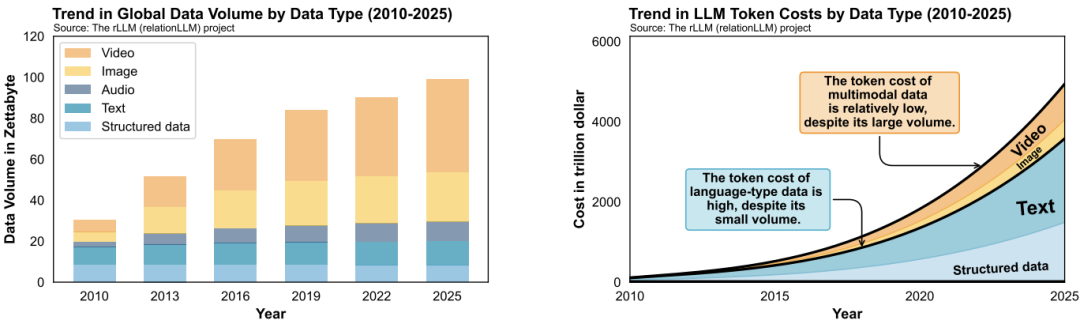

AI從2019年到現在,GPT-2演進到GPT-4,這難以置信的成就都來自於數據和算力規模的擴大。

但大語言模型仍然無法解決像井字棋這樣的簡單問題,

那麼隨之而來的一個問題是,Is Scaling is All you Need?我們真的還需要再消耗更高的成本來訓練更好的AI嗎?

這當中被低估的其實是推理的成本,它在過去的擴展(Scaling)要少得多。o1帶來了Scaling的新的維度。

隨後,他追溯了過去模型展現出來的類似規律。

比如在2012年-2015年間撲克模型的擴展。模型規模每年擴展5倍,但收效不大。但依照「人類需要更長時間思考更難問題」這一見解,增加了模型20 秒的搜索時間,效果大致相當於將模型規模擴大了100000倍。

還有在棋牌中擴展推理的歷史,backgammon- 國際象棋 – 圍棋。AlphaGo Zero在原始NN基礎上實現了從3000到5200 Elo增長,都是因為test-time search(推理時間搜索)。

此外,他還引用了Andy L.Jones關於Scaling Laws of games的圖表——可以用10倍的預訓練計算量換取15倍的測試時間計算量。

如果遊戲結果擴展到 LLMs,是不是也會是如此?

那麼關於o1接下來,會有更高的推理計算能力。在過去 5 年里,LLM概念就是聊天機器人。那麼他們可以做得更好」

最後他還打了個小廣告,目前他的多智能體團隊還在招人ing。

網民評論

如果再結合昨天Ilya談到「預訓練時代即將終結」。那麼對於市場來說,這一波可不是利好英偉達了(Doge)。

不過也有從業者站出來反對他的看法:推理時間計算(Inference Time Computation)並不新鮮,本來還想把它去掉,但出於需要又讓它回來了。

他還糾正說,裡面關於諸多遊戲時間順序是錯誤的,許多遊戲(包括國際象棋和圍棋)一開始都只專注於推理時間計算。但後來大家都傾向於離線學習策略,這樣省去了大量的在線計算時間。

因此,減少面向用戶的推理時間計算是一個深思熟慮的選擇,甚至導致該領域開始改變對計算複雜性考慮的方式。

這一趨勢在 LLMs 中也得到了延續——所有的重點都放在預訓練上,因此推理時間的計算量可以忽略不計。這樣對終端用戶來說成本極低,甚至可以在本地的邊緣設備上完成。

Ilya在談到未來超級智能的暢想時,也提及了當前推理的不可預測性:

推理越多,系統變得越不可預測,這一點在一些複雜任務中表現得尤為突出。

他還提到:

目前的AI系統還不能真正理解和推理,雖然它們能模擬人類的直覺,但未來的AI將會在推理和決策方面展現出更加不可預測的能力。

不過大模型到底會朝著哪些能力上擴展,這個還得看這些科學家們持續探索。

One More Thing

本來啊,從現場repo來看,這本來是個關於數學AI的研討會,硬生生地被他弄成了討論大模型推理Scaling Law。

現場也是人很多,據說門口都還有20多個人在排隊等待。當然也有部分原因是房間太小了。

參考鏈接:

[1]https://x.com/swyx/status/1867990396762243324

[2]https://x.com/e__honig/status/1868002417045840243

[3]https://x.com/drapersgulld/status/1868023022390485052