Ilya Sutskever在NeurIPS炸裂宣判:預訓練將結束,數據壓榨到頭了

「推理是不可預測的,所以我們必須從令人難以置信的,不可預測的 AI 系統開始。」

Ilya 終於現身了,而且一上來就有驚人之語。

本週五,OpenAI 的前首席科學家 Ilya Sutskever 在全球 AI 頂會上表示:「我們能獲得的數據已經到頭,不會再有更多了。」

OpenAI 的聯合創始人兼前首席科學家 Ilya Sutskever 今年 5 月離開公司,創辦了自己的人工智能實驗室 Safe Superintelligence,成為頭條新聞。自離開 OpenAI 後他一直遠離媒體,但本週五在溫哥華舉行的神經信息處理系統會議 NeurIPS 2024 上,他罕見地公開露面了。

「我們所熟悉的預訓練無疑會結束,」Sutskever 在台上說。

在人工智能領域里,BERT 、GPT 等大規模預訓練模型(Pre-Training Model)近年來取得了巨大成功,已經成為技術進步道路上的一個裡程碑。

由於複雜的預訓練目標和巨大的模型參數,大規模預訓練可以有效地從大量標記和未標記的數據中獲取知識。通過將知識存儲到巨大的參數中並對特定任務進行微調,巨大參數中隱式編碼的豐富知識可以使各種下遊任務受益。現在 AI 社區的共識是採用預訓練作為下遊任務的主幹,而不是從頭開始學習模型。

然而,在他的 NeurIPS 演講中,Ilya Sutskever 表示,儘管現有數據仍能推動人工智能的發展,但這個行業里稱得上可用的新數據上已經接近枯竭。他指出,這一趨勢最終將迫使行業改變當前的模型訓練方式。

Sutskever 將這一狀況比作化石燃料的消耗:正如石油是有限資源一樣,互聯網中由人類生成的內容也是有限的。

「我們已經達到了數據的峰值,未來不會再有更多數據,」Sutskever 說道。「我們必須利用現有的數據,因為互聯網只有一個。」

Sutskever 預測,下一代模型將會「以真正的方式表現出自主性」。另一方面,智能體(Agent)已成為 AI 領域的熱詞。

除了具有「自主性」,他還提到未來的系統將具備推理能力。與當今的 AI 主要依賴的模式匹配(基於模型以前見過的內容)不同,未來的 AI 系統將能夠以類似於「思考」的方式逐步解決問題。

Sutskever 表示,系統的推理能力越強,其行為就越「不可預測」。他將「真正具備推理能力的系統」的不可預測性與高級 AI 在國際象棋中的表現進行了比較 ——「即使是最優秀的人類棋手也無法預測它們的動作。」

他說:「這些系統將能夠從有限的數據中理解事物,並且不會感到困惑。」

在演講中,他將 AI 系統的 Scaling 與進化生物學進行了比較,並引用了研究中不同物種之間的大腦與體重的比例關係。他指出,大多數哺乳動物遵循一種特定的 Scaling 模式,而人類科(人類祖先)的腦體比在對數尺度上展現出截然不同的增長趨勢。

Sutskever 提議,就像進化為人類科大腦找到了一種新的 Scaling 模式一樣,AI 可能也會超越現有的預訓練方法,發現全新的擴展路徑。

以下是 Ilya Sutskever 的演講全文:

我要感謝大會組織者為這個獎項選擇了一篇論文(Ilya Sutskever 等人的 Seq2Seq 論文入選了 NeurIPS 2024 時間檢驗獎)。太好了。我也想感謝我不可思議的合著者 Oriol Vinyals 和 Quoc V. Le,他們剛才就站在你們面前。

你這裏有一張圖片,一張截圖。10 年前在蒙特利爾的 NIPS 2014 也有類似的演講。那是一個更加純真的時代。在這裏,我們出現在照片中。順便說一下,那是上次,下面這張是這次。

現在我們有了更多的經驗,希望現在更聰明一點了。但是在這裏,我想談一下這項工作本身,也許還想做一個 10 年的回顧,因為這項工作中的很多事情是正確的,但有些則不太正確。我們可以回顧它們,看看發生了什麼,以及它是如何把我們引向今天的。

所以讓我們開始談談我們所做的事情。我們要做的第一件事就是展示 10 年前同一個演講的幻燈片。總結起來就是三個要點。一個基於文本訓練的自回歸模型,它是一個大型神經網絡,它是一個大型數據集,就是這樣。

現在讓我們再深入一些細節。

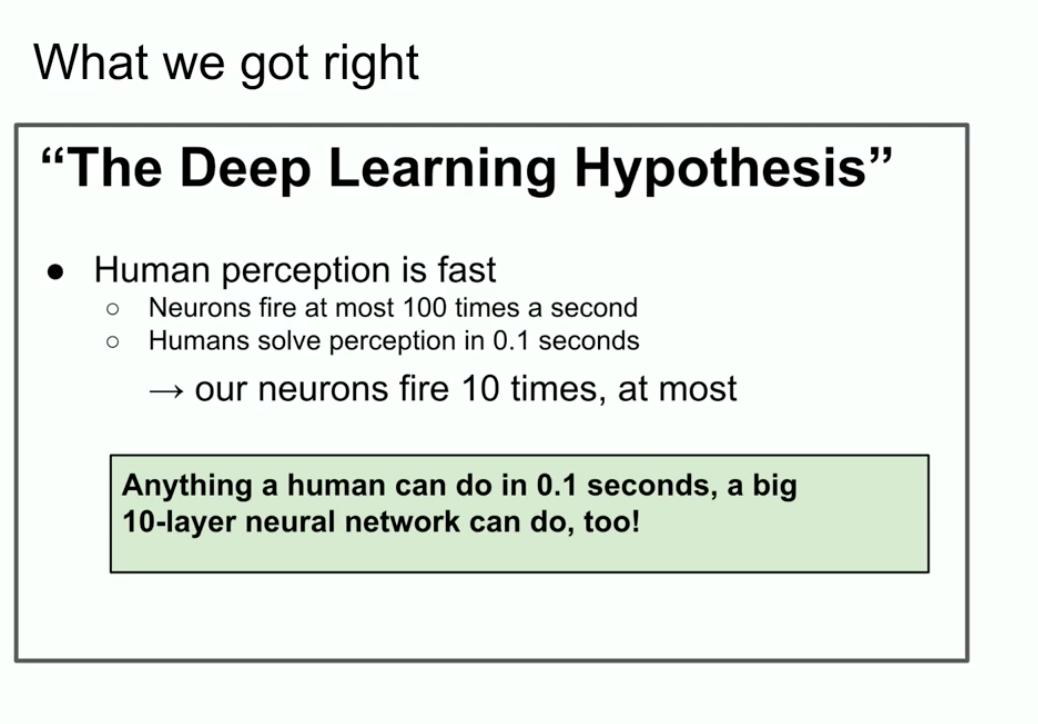

這是 10 年前的一張幻燈片,看起來不錯,「深度學習假說」。我們在這裏說的是,如果你有一個具有 10 層的大型神經網絡,但它可以在幾分之一秒內完成人類可以做的任何事情。

為什麼我們要強調「人類可以在幾分之一秒內完成的事情」?為什麼是這件事?

好吧,如果你相信深度學習的教條,人工神經元和生物神經元是相似的,或者至少不是太不同,並且你相信三個真正的神經元是緩慢的,那麼人類可以快速處理任何事情。我甚至指的是假如全世界只有一個人。如果全世界有一個人可以在幾分之一秒內完成某些任務,那麼 10 層神經網絡也可以做到,對吧?

接下來,你只需將它們的連接嵌入到一個人工神經網絡中。

這就是動機。任何人類可以在幾分之一秒內完成的事情,那麼 10 層神經網絡也可以做到。

我們專注於 10 層神經網絡,因為這是當年我們所知道的訓練方式,如果你能以某種方式超越這個層數,那麼你可以做更多的事情。但在那時,我們只能做 10 層,這就是為什麼我們強調人類可以在幾分之一秒內做的任何事情。

當年的另一張幻燈片說明了我們的主要思想,你可能能夠識別兩件事情,或者至少一件事情,你可能能夠識別出這裏正在發生自回歸的事情。

它到底在說什麼?這張幻燈片到底說了什麼?這張幻燈片說,如果你有一個自回歸模型,並且它預測下一個 token 足夠好,那麼它實際上會抓取、捕捉並掌握接下來出現的任何序列的正確分佈。

這是一個相對較新的東西,它並不是第一個自回歸網絡,但我認為這是第一個自動回歸神經網絡。我們真正相信,如果你訓練得很好,那麼你就會得到你想要的任何東西。在我們的案例中,是現在看來很保守,當時看來非常大膽的機器翻譯任務。現在我將向你們展示一些你們中許多人可能從未見過的古老歷史,它被稱為 LSTM。

對於那些不熟悉的人來說,LSTM 是可憐的深度學習研究者們在 Transformer 之前所做的事情。

它基本上是 ResNet,但旋轉 90 度。所以這是一個 LSTM。LSTM 就像是一個稍微複雜的 ResNet。你可以看到 integrator,它現在被稱為 residual stream。但是你有一些乘法正在進行中。這有點複雜,但這就是我們所做的。這是一個旋轉 90 度的 ResNet。

那個老演講中我想強調的另一個重點是我們使用了並行化,但不僅僅是並行化。

我們使用了流水線,每層神經網絡分配一塊 GPU。正如我們現在所知,流水線策略並不明智,但我們當時並不聰明。所以我們使用它,使用 8 塊 GPU 獲得了 3.5 倍的速度。

最後的結論,那是最重要的一張幻燈片。它闡明了可能是 Scaling Laws 的開始。如果你有一個非常大的數據集並且你訓練了一個非常大的神經網絡,那麼成功就是有保證的。人們可以爭辯說,如果一個人是慷慨的,這確實是正在發生的事情。

現在,我想提另一個想法,我認為這個想法真正經得起時間的考驗。這是深度學習本身的核心思想。這就是聯結主義的思想。這個想法是,如果你相信人工神經元有點像生物神經元。如果你相信其中一個有點像另一個,然後它讓你有信心相信超大規模神經網絡。它們不需要真的是人類大腦規模,它們可能會小一點,但你可以配置它們來完成我們所做的幾乎所有事情。

但這與人類仍然存在差異,因為人類大腦會弄清楚如何重新配置自己,我們正在使用我們擁有的最好的學習算法,這需要與參數一樣多的數據點。人類在這方面做得更好。

所有這些都導向了,我可以說是,預訓練時代。

進而就是我們所說的 GPT-2 模型、GPT-3 模型,Scaling Laws。我想特別提到我的前合作者 Alec Radford,還有 Jared Kaplan 和 Dario Amodei,是他們的努力實現了這些工作。

這就是預訓練的時代,這就是所有進步的驅動力,我們今天看到的所有進步,超大神經網絡,在巨大的數據集上訓練的超大神經網絡。

但我們所知道的預訓練路線無疑會結束。為什麼會結束?因為計算機通過更好的硬件、更好的算法和邏輯集群不斷增長,所有這些事情都在不斷增加你的計算能力,而數據沒有增長,因為我們只有一個互聯網。

你甚至可以說數據是 AI 的化石燃料。它就像是以某種方式創建的,現在我們使用它,我們已經實現了數據的最大化利用,不能再更好了。我們想辦法必須處理現在擁有的數據。我仍然會努力,這仍然讓我們走得很遠,但問題在於,只有一個互聯網。

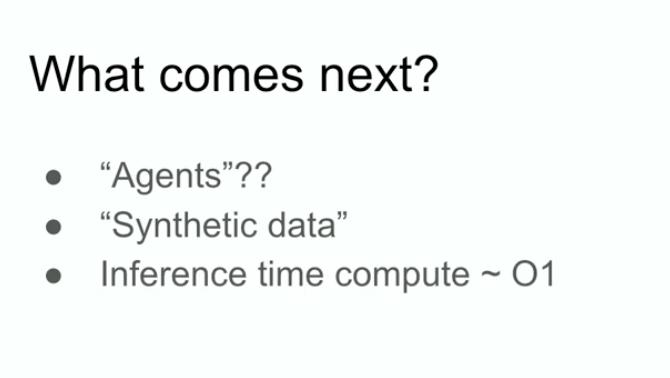

所以在這裏,我會大膽第推測一下接下來會發生什麼。

實際上,我都不需要推測,因為許多人也在猜測,我會提到他們的猜測。

- 你可能聽過「智能體 Agent」這個短語,這很常見,我相信最終會發生一些事情,人們覺得智能體是未來。

- 更具體地說,但也有些模糊的合成數據。但合成數據是什麼意思?弄清楚這一點是一個巨大的挑戰,我相信不同的人在那裡有各種有趣的進展。

- 還有推理時間計算,或者可能是最近(OpenAI 的)o1,o1 模型最生動地展示了人們在預訓練後試圖弄清楚該做什麼事情。

這些都是非常好的事情。

我想提到生物學中的另一個例子,我認為這真的很酷。很多年前在這個會議上我也看到了一個演講,有人展示了這張圖,其中顯示了哺乳動物身體大小和大腦大小之間的關係。在這種情況下,它是大規模的。那個演講,我清楚地記得,他們說,在生物學中,一切都很混亂,但在這裏,你有一個罕見的例子,動物身體的大小與它們的大腦之間存在非常緊密的關係。

出於偶然,我對這張圖產生了好奇。

所以我去Google以圖搜圖了一下。

這張圖片里,列出了多種哺乳動物,也有非靈長類動物,但大體一樣,還有原始人。據我所知,原始人在進化過程中,像尼安德特人一樣是人類的近親。比如「能人」。有趣的是,他們的大腦與身體比例指數的斜率不同。很有意思。

這意味著有一個案例,有一個生物學找出某種不同尺度的例子。顯然,有些事情是不同的。順便說一下,我想強調一下這個 x 軸是對數刻度。這是 100、1000、10000、100000,同樣以克為單位,1 克、10 克、100 克、一千克。所以事情有可能不同。

我們正在做的事情,到目前為止我們一直在做擴展的事,實際上我們發現如何擴展成了第一要務。毫無疑問在這個領域,每個在這裏工作的人都會想出該做什麼。但我想在這裏談談。我想花幾分鐘的時間來對長期進行預測,我們所有人都要面臨這樣的事,對不對?

我們正在取得的所有進展,是驚人的進步。我的意思是,10 年前在這個領域工作的人,你們還記得一切都是多麼無能為力。如果你是在過去兩年里加入了深度學習這個領域,你或許都無法感同身受。

我想稍微談談「超級智能」,因為這顯然是這個領域的發展方向,是這個領域努力構建的東西。

儘管語言模型現在擁有令人難以置信的能力,但它們也有點不可靠。目前還不清楚如何調和這一點,但最終,遲早會實現目標:這些系統將以真正的方式成為智能體。現在,這些系統並不是強大的有意義的感知智能體,實際上它們剛剛開始會推理。順便說一句,一個系統推理的越多,它就變得越不可預測。

我們已經習慣所有深度學習都是非常可預測的。因為如果你一直在研究複製人類直覺,回到 0.1 秒的反應時間,我們的大腦會進行什麼樣的處理?這就是直覺,我們賦予了 AIS 一些這種直覺。

但是推理,你看到了一些早期的跡象:推理是不可預測的。例如,國際象棋對於最好的人類棋手來說都是不可預測的。因此,我們將不得不處理非常不可預測的 AI 系統。它們將從有限的數據中理解事物,並且不會感到困惑。

所有這些都是非常大的限制。順便說一句,我沒有說怎麼做,也沒有說什麼時候會以及什麼時候所有這些事情都會與「自我意識」一起發生,因為為什麼「自我意識」不能是有用的呢?我們自己也是我們自己世界模型的一部分。

當所有這些東西結合在一起時,我們將擁有與今天存在的質量和屬性完全不同的系統。當然,它們將擁有令人難以置信和驚人的能力。但是像這樣的系統所帶來的問題,我猜想它將非常與眾不同。

我會說,預測未來肯定也是不可能的。真的,各種各樣的事情都是可能發生的。謝謝大家。

Neurlps 大會上一陣掌聲過後,Ilya 回答了幾位提問者簡短的問題。

提問:在 2024 年,請問您認為是否還有其他與人類認知相關的生物結構值得以類似的方式進行探索,或者還有您感興趣的領域嗎?

Ilya:我會這樣回答這個問題:如果你或者某個人對某個具體問題有獨到的見解,比如 「嘿,我們明顯忽略了大腦在做某些事情,而我們並沒有做到」,並且這是可以實現的,那麼他們就應該去深入研究這個方向。我個人沒有這樣的見解。當然,這也取決於你關注的研究抽像層級。

很多人都渴望開發受生物啟發的人工智能。從某種程度上來說,可以認為由生物啟發的 AI 已經取得了巨大的成功,畢竟整個深度學習的基礎就是由生物啟發的 AI。但另一方面,這種生物啟發其實非常、非常有限。基本上只是 「讓我們使用神經元」—— 這就是生物啟發的全部內涵。更詳細、更深層次的生物啟發卻很難實現,但我不會排除這種可能性。我認為,如果有人擁有特別的洞察力,能夠發現某些新的角度,這或許會非常有價值。

提問:我想提問一個關於自動更正的問題。

您提到推理可能是未來模型的核心發展方向之一,也可能是一個差異化的特點。在一些海報展示環節中,我們看到當前模型存在 「幻覺」 現象。我們目前分析模型是否出現幻覺的方法(如果我理解有誤請您糾正,您才是這方面的專家)主要是基於統計分析,例如通過某些標準差的偏離來判斷是否偏離均值。未來,您是否認為如果模型具備了推理能力,它能夠像 「自動更正」(autocorrect)一樣自我糾正,從而成為未來模型的一個核心功能?這樣模型就不會出現那麼多的幻覺,因為它能識別出自己生成幻覺內容的情況。這可能是一個比較複雜的問題,但您認為未來的模型是否能夠通過推理理解併發現幻覺的發生?

Ilya:答案:是的。

我認為你描述的這種情況是非常有可能的。儘管我不確定,但我建議你去查證一下,這種情況可能已經在一些早期的推理模型中出現了。但從長期來看,為什麼不可能呢?

提問:我的意思是,這就像微軟 Word 里的自動更正(autocorrect)功能一樣,它是一個核心功能。

Ilya:是的,我只是覺得稱之為 「自動更正」 其實有點低估了它的意義。當你提到 「自動更正」 時,會讓人聯想到一些相對簡單的功能,但這個概念遠遠超越了自動更正。不過,總的來說,答案是肯定的。

提問:謝謝。

接下來是第二位提問者。

提問:嗨,Ilya。我很喜歡那個神秘留白的結局。人工智能們是否會取代我們,還是說它們比我們更優越?它們是否需要權利?這是一個全新的物種。智人(Homo sapiens)孕育了這種智能,我覺得強化學習那邊的人可能認為我們需要為這些存在爭取權利。

我有一個與此無關的問題:我們如何創造正確的激勵機制,讓人類以一種方式來創造它們,使它們能享有與我們智人相同的自由?

Ilya:我覺得這些問題在某種意義上是人們應該更多思考和反思的。但對於你提到的關於我們應該創造什麼樣的激勵機制的問題,我覺得我無法自信地回答這樣的問題。這聽起來像是在討論創建某種自上而下的結構或治理模式,但對此我確實不太確定。

接下來是最後一位提問者。

提問:嗨,Ilya,謝謝你的精彩演講。我來自多倫多大學。感謝你所做的一切工作。我想請教一下,你認為 LLMs 是否能夠在分佈外進行多跳推理的泛化?

Ilya:好的,這個問題假設答案是 「是」 或 「否」,但實際上不應該這樣回答。因為我們需要先弄清楚:分佈外泛化到底是什麼意思?什麼是分佈內?什麼是分佈外?

因為這是一次關於 「時間檢驗」 的演講。我想說,在很久很久以前,人們在還未使用深度學習時,是用字符串匹配和 n-grams 來做機器翻譯的。當時人們依靠的是統計短語表。你能想像嗎?這些方法的代碼複雜度達到了數萬行,真的是難以想像的複雜。而在那個時候,泛化的定義是:翻譯結果是否和數據集中的短語表述字面上不完全相同。

現在我們可能會說:「我的模型在數學競賽中取得了很高的分數,但也許這些數學題的某些想法曾經在互聯網上的某個論壇中被討論過,因此模型可能只是記住了這些內容。」 好吧,你可以說這可能是分佈內的,或者可能是記憶化的結果。但我認為,我們對泛化的標準確實已經大幅提高 —— 甚至可以說是顯著地、不可想像地提高了。

所以,我的答案是:在某種程度上,模型的泛化能力可能還遠不及人類。我確實認為人類在泛化方面要優秀得多。但與此同時,AI 模型也確實在某種程度上能夠進行分佈外泛化。我希望這個答案對你來說算是有用的,儘管它聽起來有些贅述了。

提問:謝謝。

參考內容:

https://www.theverge.com/2024/12/13/24320811/what-ilya-sutskever-sees-openai-model-data-training

本文來自微信公眾號「機器之心」(ID:almosthuman2014),作者:關注大模型的,36氪經授權發佈。