上交團隊為參數微調打造統一框架,即便資源受限也能提升大模型能力

隨著 GPT-3 的推出,大模型逐漸成為人們關注的焦點。研究者們紛紛投入到各類大模型的研發中,這些模型通常具有出色的泛化能力,並在眾多任務中展現出強勁的潛力。

為了進一步發揮大模型的優勢,將其應用於各類下遊任務已經成為一種趨勢。

然而,實踐中人們常常面臨一個重大挑戰:對整個大模型進行完整訓練(即全量微調)需要極高的成本,如需要大量的圖形處理器(GPU,Graphics Processing Unit)資源等。

考慮到下遊任務的多樣性,為每個任務訓練一個專門的大模型並不現實。因此,一個自然的問題出現了:在資源有限的情況下,如何更高效地訓練大模型,以便在多樣的下遊場景中充分發揮其潛力?

正是在這個背景下,參數高效微調(PEFT,Parameter-Efficient Fine-Tuning)這一研究領域應運而生。

PEFT 旨在通過微調極少量的參數,使模型在不同任務中實現接近全量微調,甚至超過全量微調的效果。隨著 2022 年以來大模型的迅猛發展,PEFT 算法層出不窮,種類繁多。

與此同時,許多綜述性論文試圖對這些方法進行分類,雖然各自的分類結果有所重疊,但始終難以形成統一的共識。

此外,由於許多方法的原理偏向直覺性而非理論性,其性能表現往往難以系統地解釋。不同方法之間的性能差異顯著,如何解釋這種差異性也成為值得深入探討的問題。

基於這一背景,來自上海交通大學的研究人員開展了一項研究。研究目標有兩個:首先,從統一視角出發歸納不同的 PEFT 方法,將它們整合在一個統一的框架之下。

其次,探索這些方法的底層邏輯,並分析不同方法之間的性能差異。

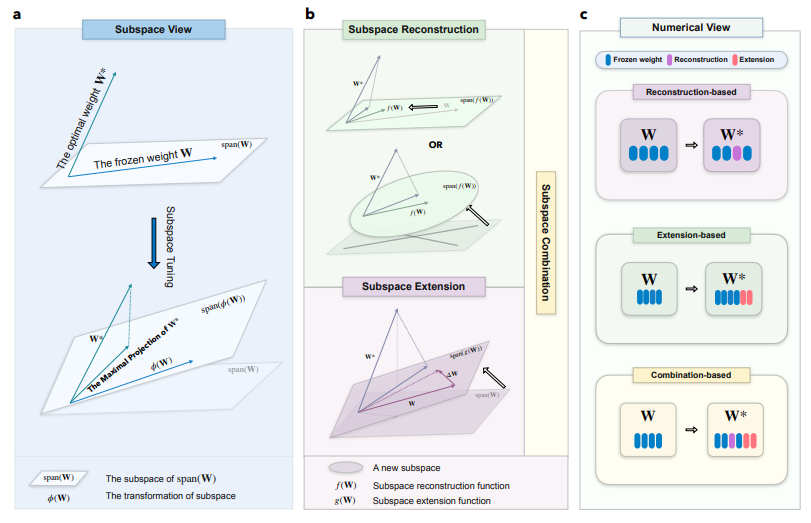

研究中,該團隊從子空間微調的角度在數學上為參數微調提供了一個統一框架。

通過這個框架,課題組將各種不同的參數微調方法歸納在同一個數學背景下,使得整個微調過程更加簡潔和系統。

(來源:arXiv)

(來源:arXiv)預計參數高效微調技術具有廣泛的應用前景。它能夠在邊緣計算、自動駕駛、醫療影像分析、個性化推薦系統等領域,通過優化模型性能和壓縮模型參數,實現高效的部署與運行。

此外,PEFT 技術在半監督與無監督學習、模型壓縮與蒸餾以及自然語言處理等方面,也展現出極大的潛力,特別是在資源受限的環境中,能夠顯著提升模型的實際應用能力。

同時,子空間微調技術能為參數高效微調的發展提供了新的視角和重要啟發。通過深入分析模型參數在子空間中的行為,利用子空間微調技術還可以揭示模型底層邏輯的運作機制。

這種分析不僅有助於理解模型參數的相互作用和優化路徑,還能夠指導 PEFT 技術的設計,使其在更具理論支撐的框架下實現更高效的性能調優。

圖 | 相關論文(來源:arXiv)

該團隊表示這項研究的框架相對龐大,還有很多未解決的問題。因此,他們打算進一步優化現有的理論和方法。目前,他們正在研究如何更好地優化子空間擴展中的低秩特性,以提高模型的效率和性能。

此外,他們發現低秩自適應(LoRA,Low-Rank Adaptation)方法具有巨大的潛力,但這一潛力在現有的實現中並未被完全釋放。基於 LoRA 的特性,他們進一步探索如何在下遊任務中充分挖掘和利用這一潛力。

眼下,課題組已取得不錯的實驗結果,這可能會為從另一個角度理解 PEFT 的本質提供新的視角。

參考資料:

1.https://arxiv.org/pdf/2407.05417

運營/排版:何晨龍