OpenAI 年底「百億補貼」來了,滿血 o1 API 開放,成本暴跌,定製升級

事先張揚的 mini 版 DevDay 終於來了。

GPT-4.5 和 DALL·E 4 依舊沒有露臉,今天 OpenAI 發佈會的焦點主要放在 API 和開發者服務的全新升級上,真·開發者大會。

省流不看版如下:

OpenAI o1 API:支持函數調用、開發者指令、結構化輸出和視覺能力。

Realtime API:包括簡單的 WebRTC 集成,GPT-4o 音頻的價格大幅降低了 60%,同時新增對 GPT-4o mini 的支持,其音頻速率僅為原來的十分之一。

偏好微調(Preference Fine-Tuning),這是一種新的模型定製技術,簡化了根據用戶和開發者偏好進行模型定製的過程。

新的 Go 和 Java SDK,現已進入 beta 階段。

本次發佈會由 OpenAI 技術人員 Sean DuBois、Andrew Peng、Michelle Pokrass 和 Brian Zhang 等人共同主持。

直播活動結束後,OpenAI 也在 Reddit 論壇上舉辦了 AMA(Ask Me Anything)活動。我們精選一些亮點問答放在文末,建議不要錯過。

而在召開發佈會前,OpenAI 也上架了 DevDay 2024 的路演影片。

附上傳送地址:

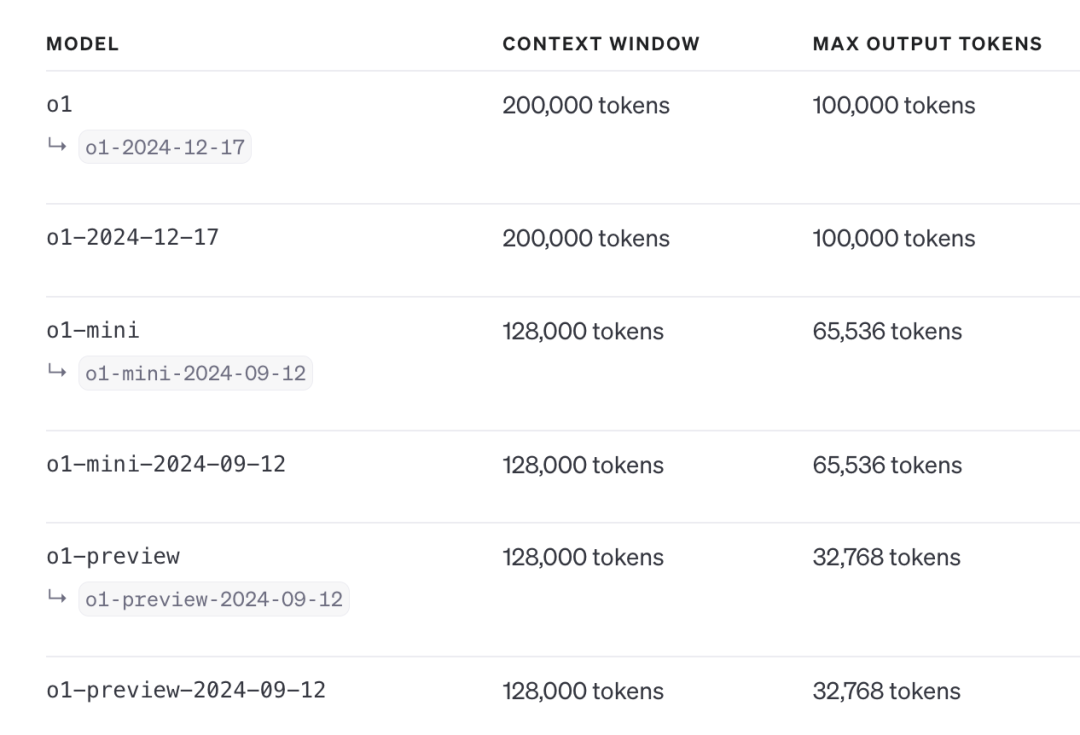

在 OpenAI o1 模型發佈之後,應廣大開發者的呼聲,期待已久的 o1 API 正式發佈。即日起,OpenAI 向 API 使用等級 5 級的開發者開放訪問權限。

據官方介紹,現已正式上線的 o1 具備多項關鍵功能,可支持實際應用場景如下:

函數調用:無縫連接 o1 與外部數據和 API。

結構化輸出:生成可靠地遵循自定義 JSON 模式的響應。

開發者指令:為模型指定指令或上下文,例如定義語氣、風格以及其他行為指導。

視覺能力:推理圖像,開啟更多科學、製造或編程領域的應用,特別是在視覺輸入至關重要的場景中。

更低延遲:與 o1-preview 相比,o1 在處理相同請求時,推理 token 使用量平均減少 60%。

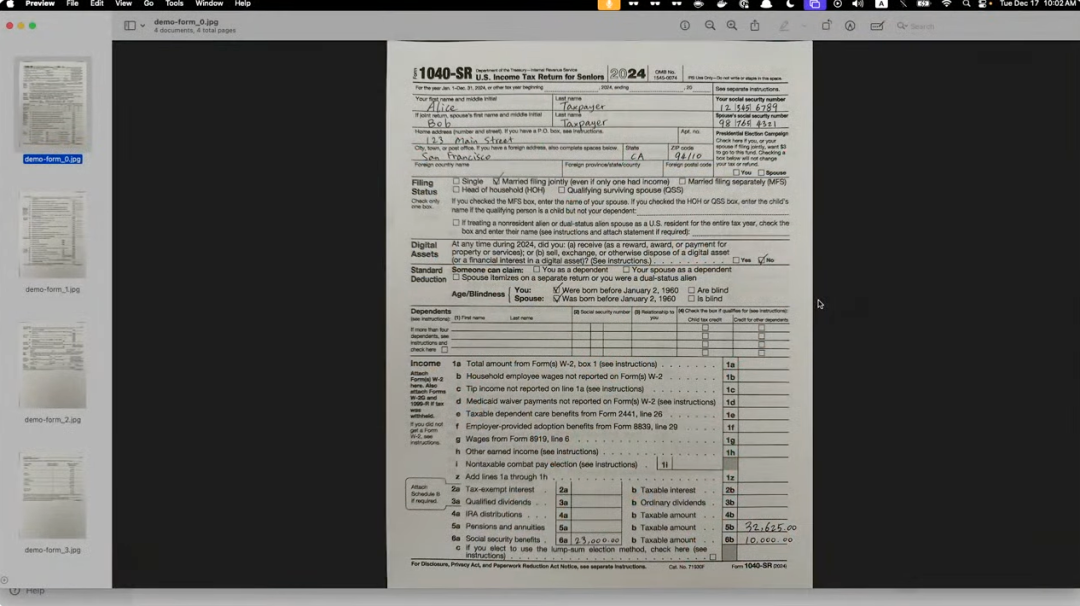

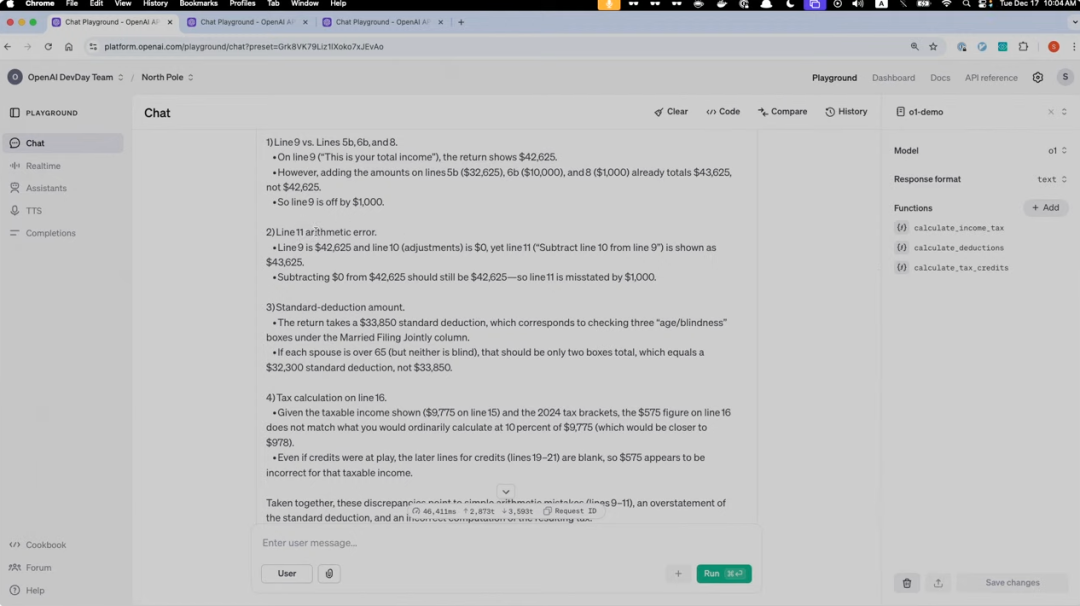

在發佈會上,OpenAI 演示人員也向我們展示了 o1 API 具體的應用案例。

比如說,借助 o1 API 的視覺能力,它能夠檢測上傳表格中的錯誤並給出修訂建議,還能在獲取正確數據後完成所得稅計算等複雜任務。

比較值得關注的是其結構化輸出功能。

通過預先定義 JSON 架構,模型能夠嚴格按照指定格式輸出結果。並且,其還能基於這些結構化數據,在 PDF 界面中精確高亮顯示需要修改的內容,以及支持函數調用與結構化輸出的協同使用。

至於廣受關注的 o1 Pro API,OpenAI 表示正在加緊開發中,有望在近期推出。

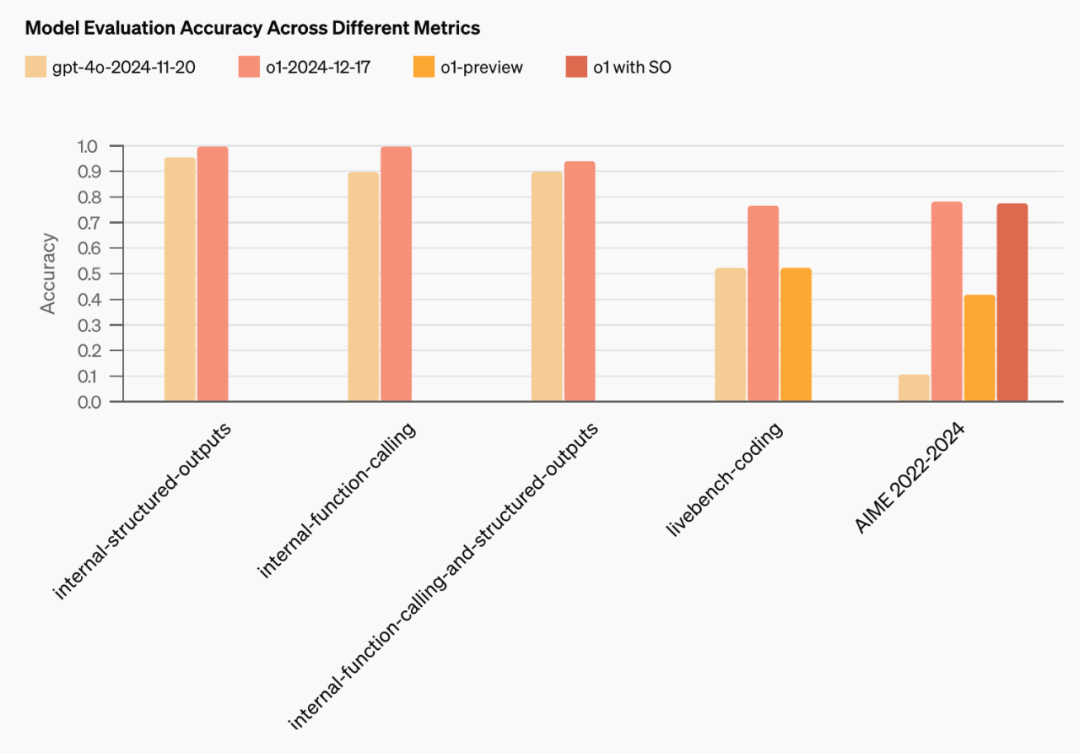

本次發佈的 o1-2024-12-17 版本是對兩週前 ChatGPT 版本的全新後訓練優化, 在函數調用(function calling)和結構化輸出測試(Structured Outputs testing)中的表現都要明顯優於之前的 o1-preview。

目前,OpenAI 正在逐步推出訪問權限,同時努力擴大對更多使用等級的訪問,並提升速率限制。

文檔指路:https://platform.openai.com/docs/models#o1

為打造更自然、低延遲的對話體驗,OpenAI 對 Realtime API 也進行了全面升級。新版賓特別適合開發語音助手、實時翻譯工具、虛擬輔導員和互動客服系統等應用場景。

演示環節,OpenAI 展示了一個融入 Realtime API 的互動馴鹿玩偶,能夠與人進行自然的對話,比如發佈會就今年收到的聖誕禮物等話題聊了起來。

而更重要的是,Realtime API 能夠集成到智能眼鏡等可穿戴設備中,或者輕鬆接入各類攝像頭和馬克風系統,為人機交互開啟更廣闊的可能性。

應開發者需求,Realtime API 此次更新重點包括 WebRTC 直接集成、價格調整以及更精細的響應控制。

WebRTC 能夠極大簡化跨平台實時語音產品的開發流程。無論是瀏覽器應用、移動客戶端、物聯網設備還是服務器間通信,都能實現平滑接入。

據悉,該技術可自動處理音頻編碼、流媒體傳輸、降噪和擁塞控制等關鍵功能,即使在網絡條件不穩定的情況下也能保證流暢的用戶體驗。

WebRTC 集成旨在確保在實際環境中,即使網絡質量波動,仍能提供平滑且響應迅速的交互。它負責處理音頻編碼、流媒體傳輸、降噪以及擁塞控制等功能。

在定價方面,OpenAI 大幅下調了相關服務費用。

gpt-4o-realtime-preview-2024-12-17 音頻 token 價格下調 60%,降至每百萬輸入 token 40 美元,每百萬輸出 token 80 美元。

音頻輸入緩存費用僅需每百萬 token 2.50 美元,大幅下降 87.5%,怎麼有種 OpenAI 年底「百億補貼」的既視感。

同時推出的 GPT-4o mini 為開發者提供了更具性價比的選擇,在保持體驗的同時,將音頻價格設定為每百萬輸入 token 10 美元,每百萬輸出 token 20 美元,文本 token 則分別為 0.60 美元和 2.40 美元。

為進一步提升語音交互體驗,Realtime API 還新增了多項實用功能:

後台任務,如內容審核或分類,可以在不幹擾用戶語音互動的情況下進行。

允許自定義輸入上下文,指定哪些對話內容作為模型的輸入。例如,可以選擇僅對用戶最後一句發言進行審核,或在不變更會話狀態的前提下,重新利用之前的回應。

控制響應時機,利用服務器端語音活動檢測(VAD),但不自動觸發回應。例如,可以先收集必要信息(如賬戶詳情),加入模型上下文,然後手動啟動語音回覆,以提供更多對時機和準確性的控制。

延長最大會話時長,將原本 15 分鐘的會話時長增加到 30 分鐘。

另外,此次更新還為微調 API 帶來了偏好微調(Preference Fine-Tuning)技術。

Preference Fine-Tuning 採用直接偏好優化(DPO)技術,通過比較模型響應來訓練 AI 區分用戶偏好,在處理涉及語氣、風格和創造力等主觀因素的任務時尤其有效。

以 Rogo AI 為例,其金融分析師 AI 助手在採用該技術後,準確率從 75% 提升至 80% 以上。偏好微調今天將推出,適用於 gpt-4o-2024-08-06,並將在不久後為 gpt-4o-mini-2024-07-18 提供。

最後,OpenAI 還發佈了 Go 和 Java SDK 測試版,與現有的 Python、Node.js 和 .NET 庫一起,為開發者提供更全面的開發工具支持。

其中 Go SDK 主要適合構建高併發、可擴展的系統,而 Java SDK 則提供類型化的請求響應對象和 API 請求管理工具,能夠帶來更流暢的開發體驗。

今天更新功能的脈絡非常清晰,比如降價為規模化應用掃除成本障礙、簡化開發流程,降低技術門檻、提升定製化能力等。拋卻商業語境下的服務優化,這些改進都將有望進一步推動 AI 應用開發走向大眾化。

附上 AMA 問答

問:既然 o1 現在具備了視覺識別能力(我猜測這將在未來的 API 中提供),我們該如何考慮利用它來處理那些通常需要上下文學習才能應對的場景呢?是否應該通過給模型提供包含約 5 張圖片的多示例提示來提高其效果,還是說有其他更推薦的策略?答:今天,我們推出了具備視覺輸入功能的 o1!是的,我們已經觀察到,通過少量示例提示來指導模型如何響應新圖片是非常有效的。

問:我們是否可以期待即將在 Assistants 中支持 o1 API 呢?答:我們確實計劃在 Assistants 中支持 o1。我們之前一直在等待實現對工具的支持,然後才在 Assistants 中引入o1。現在 o1 的函數調用功能已經啟動,因此 o1 將很快集成到 Assistants 中!

問:Assistants API 是否有任何最新消息,特別是關於文件搜索功能的更新(如元數據支持、圖像解析等)?同時,確切的文本引用功能似乎也尚未實現。答:我們正在努力開發所有這些功能。

問:Assistants API 已經處於測試階段超過一年,並且存在相關的速率限制。作為開發者,我們為什麼要繼續浪費時間用 OpenAI 進行解決方案的原型設計,尤其是當我們實際上無法發佈任何產品時?缺乏明確的路線圖和溝通。要麼徹底取消這個項目,要麼正式發佈它。長期處於測試階段只會產生負面影響。答:我明白這個項目的進度比預期的要慢,但我們計劃在明年對 Assistants API 進行迭代和改進。在此期間,我們致力於確保你在 Assistants API 上開發的應用程序能夠穩定高效地運行。