見證歷史!AI想的科研idea,真被人類寫成論文發表了

一水 發自 凹非寺

量子位 | 公眾號 QbitAI

天啦擼!!AI想出來的idea,還真有人寫成論文了。

甚至預印本arXiv、博客、代碼全都有了。

今年8月,Sakana AI(由Transformer論文8位作者的最後一位Llion Jones創業成立)這家公司推出了史上首位「AI科學家」,且一登場就一口氣生成了十篇完整學術論文。

而現在,受其中一篇論文想法的啟發,人類研究員真的寫出相關論文並在arXiv上公開了。

OpenAI前研究團隊負責人Jeff Clune激動直言:

簡直不敢相信!這是它產生的我最喜歡的想法之一。看到與人類達成一致真是太酷了,人類確實執行得更好。

話不多說,讓我們來康康論文具體內容。

Claude提的idea,被人類寫成論文了

翻開「AI科學家」之前撰寫的論文,我們找到了Jeff Clune提到的這一篇。

《Grokking Through Compression: Unveiling Sudden Generalization via Minimal Description Length》

通過壓縮實現Grokking:借助最小描述長度(MDL)揭示突然泛化現象

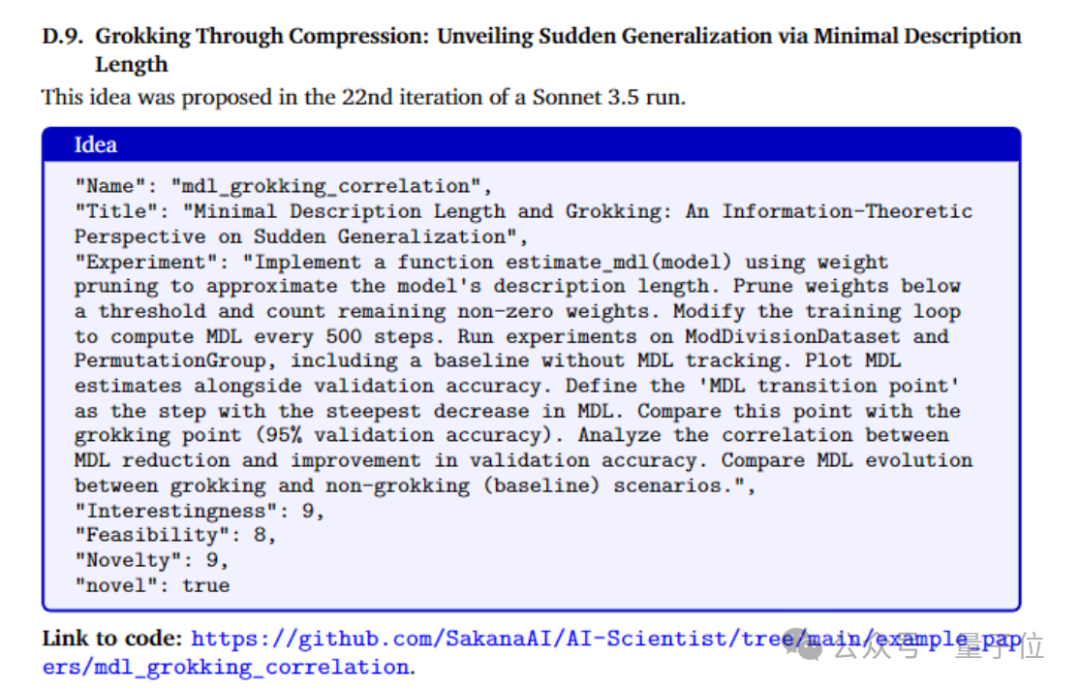

根據描述,這篇論文的想法由Claude 3.5 Sonnet在第22次迭代時提出。

它主要探討了神經網絡中最小描述長度(MDL)與 「grokking」 現象(模型經長時間訓練後突然泛化)的關係,從信息論視角研究突然泛化的機制。

其中,MDL可以被看成一種衡量模型複雜度和可壓縮性的方法,即模型既要能夠很好地擬合數據,又不能過於複雜(避免過擬合)。

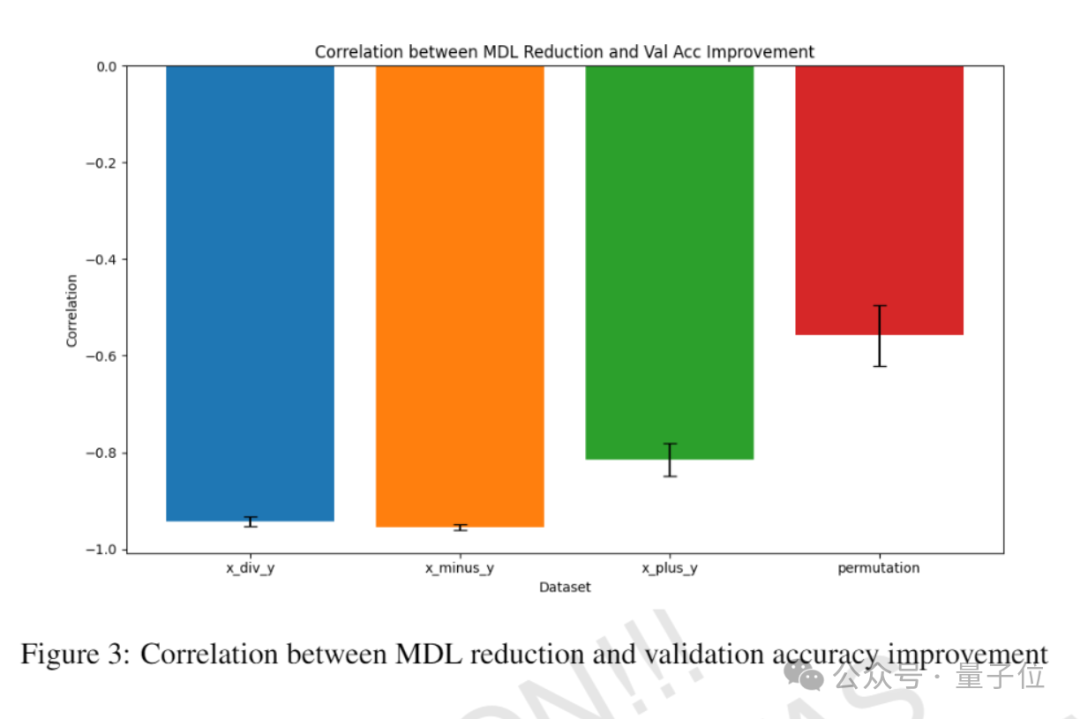

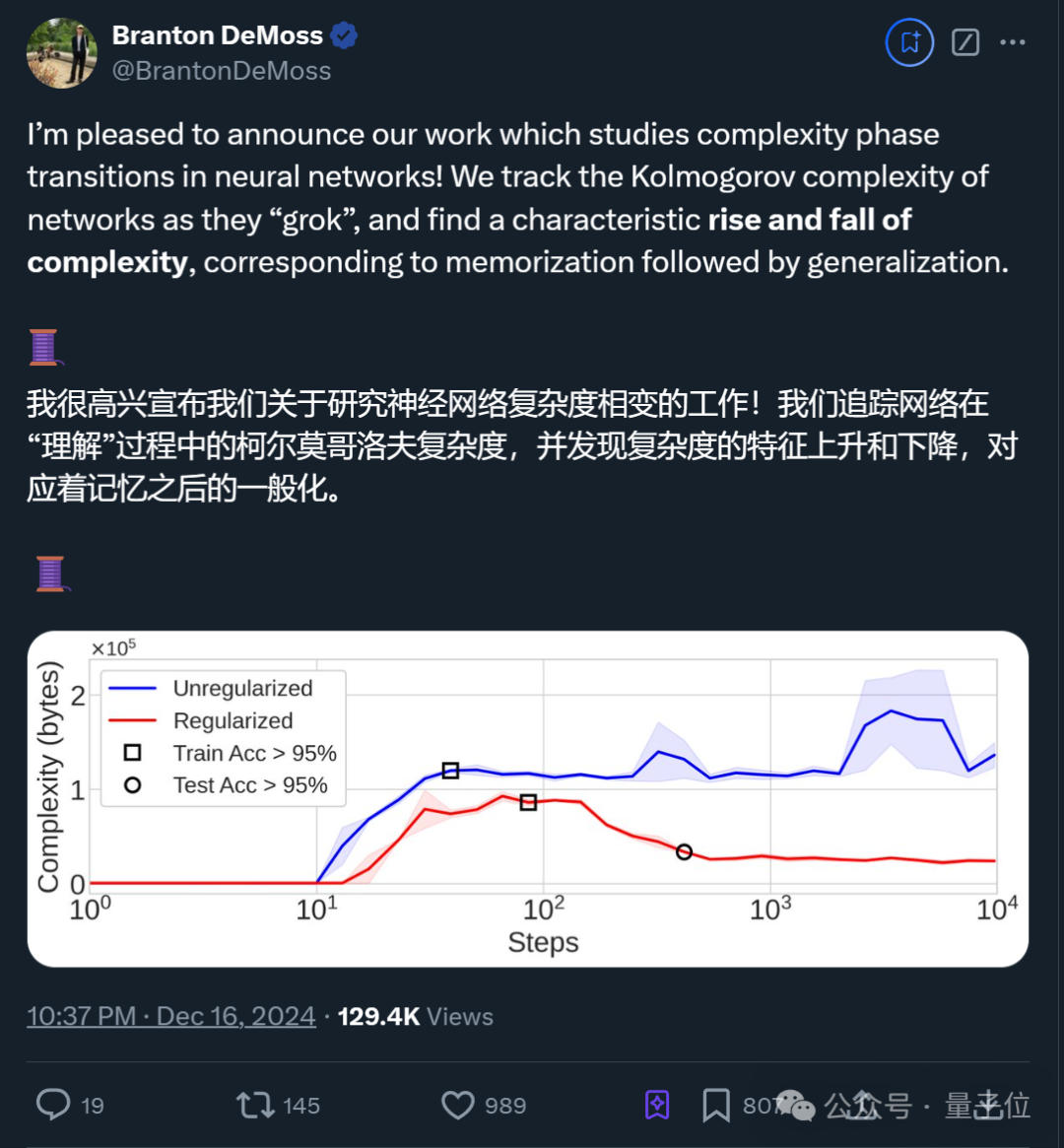

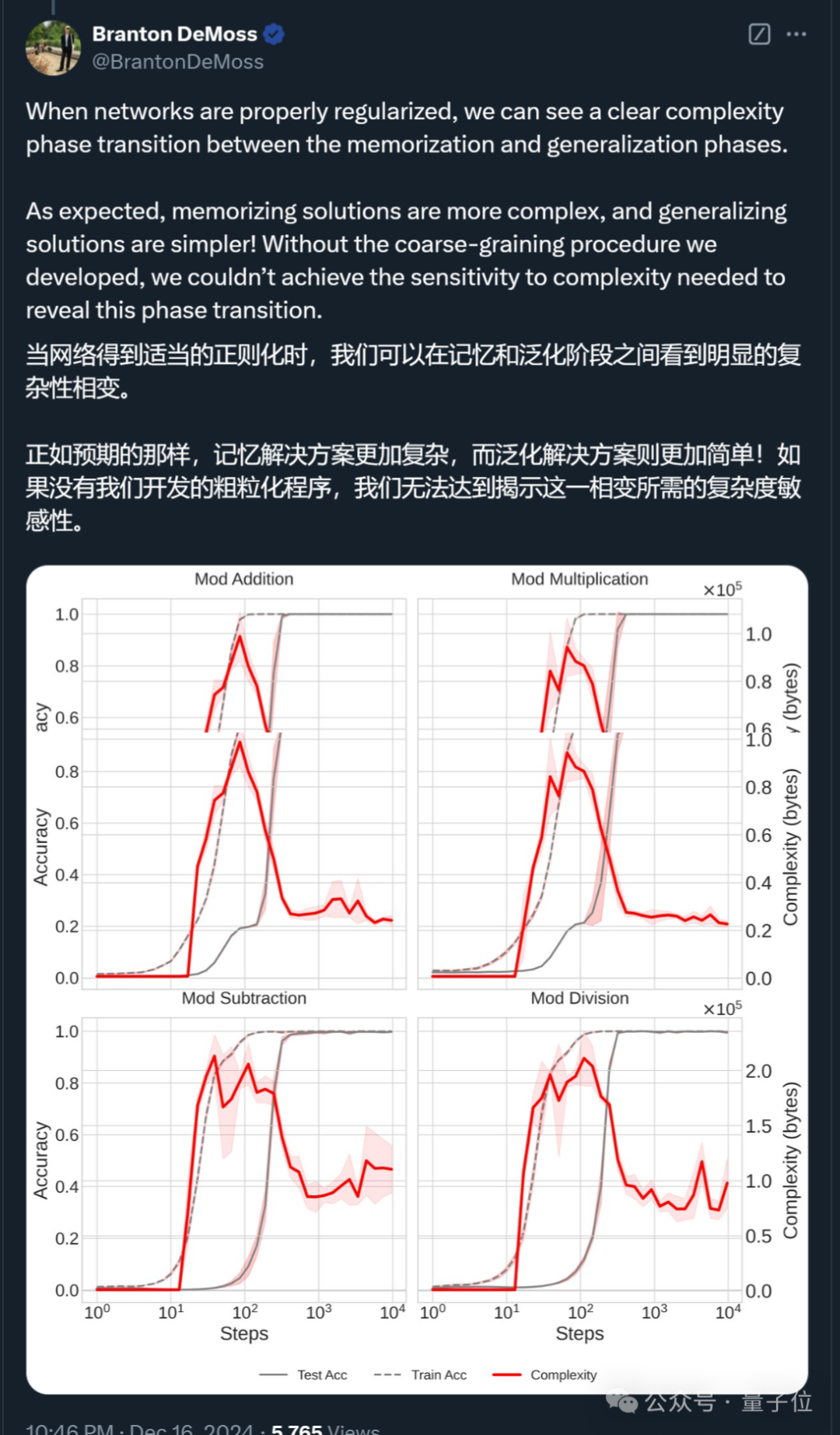

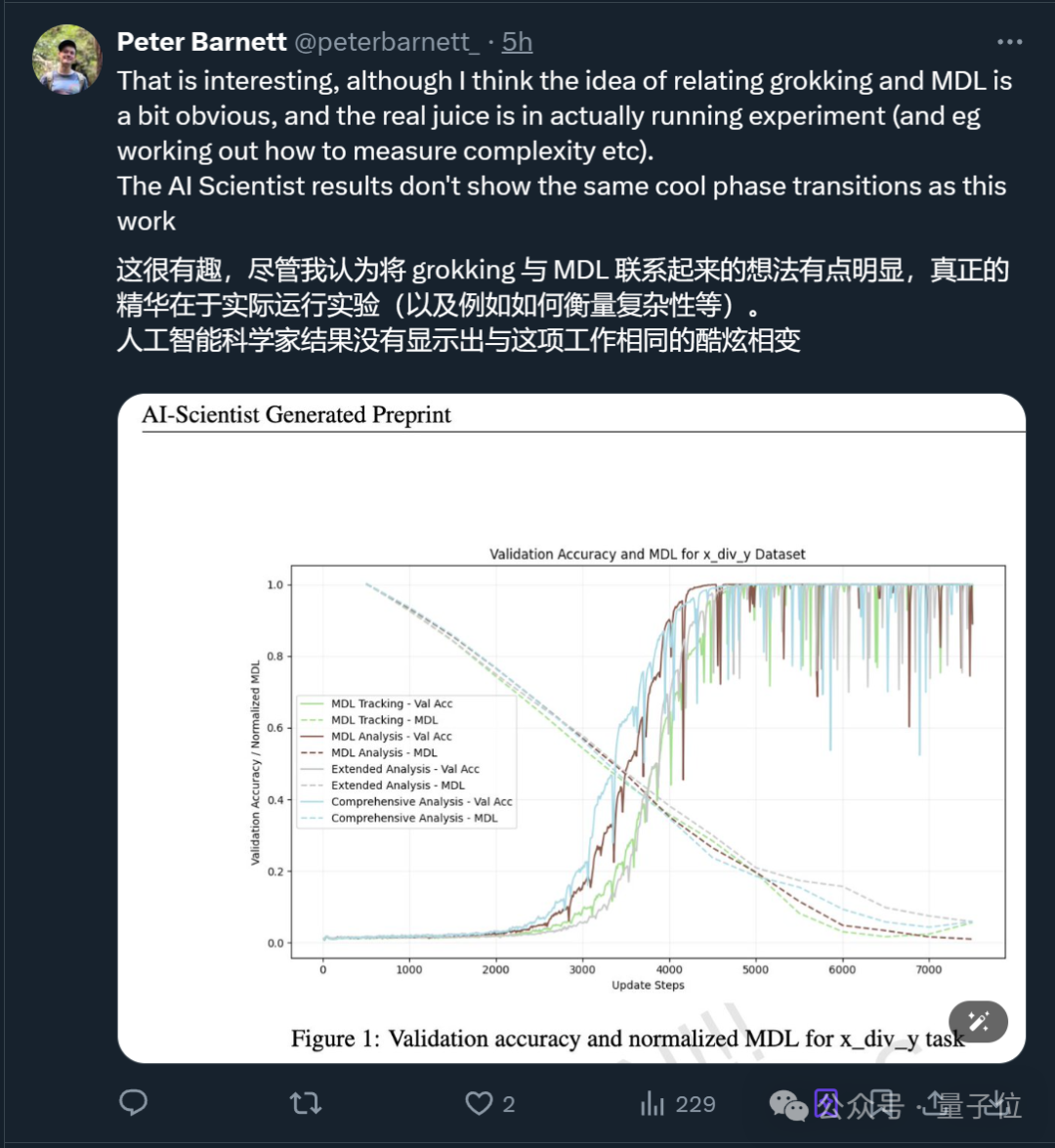

具體而言,研究引入了一種基於權重剪枝的新型MDL估計技術,並將其應用於多種數據集,包括模塊化算術和排列任務。相關實驗揭示了MDL減少與泛化能力提高之間存在強烈的相關性(下圖),MDL的轉變點通常在「grokking」事件發生之前或與之同時出現。

此外,研究觀察到在「grokking」與非「grokking」情境下MDL演變模式的差異,前者以快速的MDL減少後持續泛化為特徵。這些發現為理解「grokking」的信息論基礎提供了見解,並表明在訓練期間監控MDL可以預測即將發生的泛化。

Okk,瞭解了原論文,我們再來看人類選手最新發表的內容。

概括而言,他們研究了神經網絡在 「grokking」 現象中的複雜性動態,即網絡從記憶訓練數據到實現完美泛化的過渡過程,並提出了一種基於失真壓縮理論的新方法來衡量神經網絡的複雜性。

首先,作者之一Branton DeMoss自述,他們受到了Sean Carroll和Scott Aaronson之前研究的啟發。

通過觀察咖啡與奶油混合的現象,Scott等人發現複雜性隨著時間的推移首先上升,然後下降,這一過程與熵單調增加的趨勢相似。

而DeMoss團隊形式化了這一直覺,並將其應用於神經網絡,以跟蹤這些網絡學習的抽像複雜度。

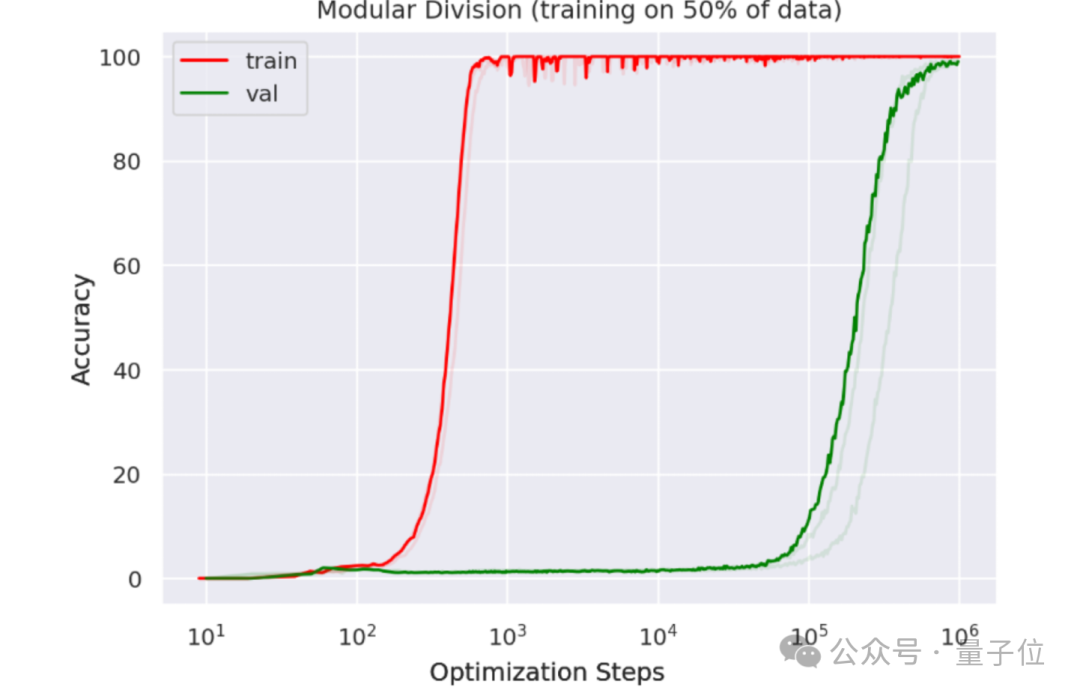

展開來說,作者們同樣先介紹了grokking現象,即神經網絡在長時間過度擬合訓練數據後突然能夠泛化的能力。

其中x軸表示優化步數,y軸表示準確率;紅線代表訓練集的準確率,綠線代表驗證集的準確率。

可以看到,如果訓練一個小型Transformer來進行模擬,在幾百個訓練步驟之後,模型已經完美地擬合了訓練數據;然而,它直到大約10^5個訓練步驟才能實現泛化。

為瞭解釋這一現象,團隊引入了一種基於失真壓縮和Kolmogorov複雜性的新方法來衡量神經網絡的複雜性,並通過這一框架追蹤了grokking過程中網絡複雜性的動態變化。

按照作者的比喻,這就像「神經網絡的JPEG」。

研究結果表明,網絡在從記憶到泛化的過渡中,其複雜性首先上升,隨後在泛化發生時下降。

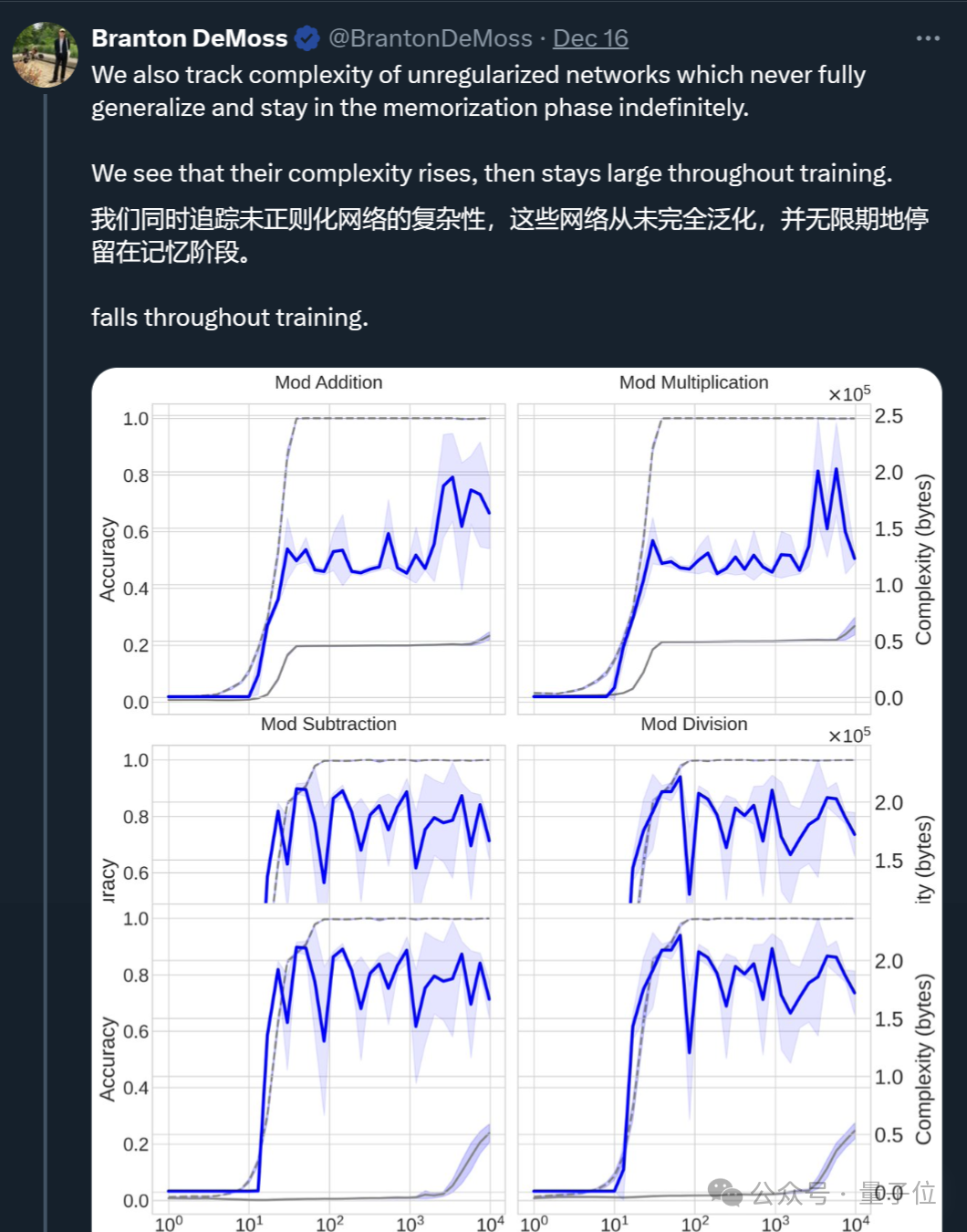

進一步地,研究發現如果神經網絡沒有任何形式的正則化(一種防止過擬合的技術),它將無法從記憶階段過渡到泛化階段,而是會無限期地保持記憶模式。

沒有正則化的反應:

有正則化的反應:

此外,作者指出傳統的複雜性評判標準(如參數數量和權重範數)並不能準確描述模型的複雜性,因為它們忽略了訓練過程中的變化。

對此,他們採用了最小描述長度(MDL)原則和Kolmogorov複雜度來定義和近似複雜性,並通過實驗驗證了這種方法,並強調了簡單模型在數據壓縮中的優勢。

最終,研究表明理解複雜性對預測模型泛化能力至關重要。

更多細節感興趣可以查閱原論文(地址文末)。

可以看出,一個由AI最初提出的想法,最終由人類來完成了更細緻的論證。

有網民就分析指出AI寫的那篇實驗結果不及人類研究員:

而之前撰寫過「AI科學家」總論文的共同一作Cong Lu也表示:

誰知道未來AI還會激發出哪些其他想法……

BTW,就在Sakana AI公佈「AI科學家獨立生成10篇學術論文」的消息後,公司在9月份還拿到了一筆2億美元的A輪融資,裡面還有英偉達的參與。

總之,AI以後不僅能自己寫論文,還能和人類搭配幹活了。

論文:

https://arxiv.org/abs/2412.09810

GitHub:

https://github.com/brantondemoss/GrokkingComplexity

博客:

https://brantondemoss.com/research/grokking/

參考鏈接:

[1]https://x.com/cong_ml/status/1869135740275450197

[2]https://x.com/BrantonDeMoss/status/1868666711890706675