剛剛,OpenAI 放出最後大驚喜 o3,AGI今夜降臨?血洗 o1

【導讀】OpenAI下一代模型——o3,重磅誕生了!陶哲軒預言難住AI好幾年的數學測試,它瞬間破解,編程水平位於全球前200,在ARC-AGI基準中更是驚人,打破所有AI紀錄接近人類水平,離AGI更近一步。

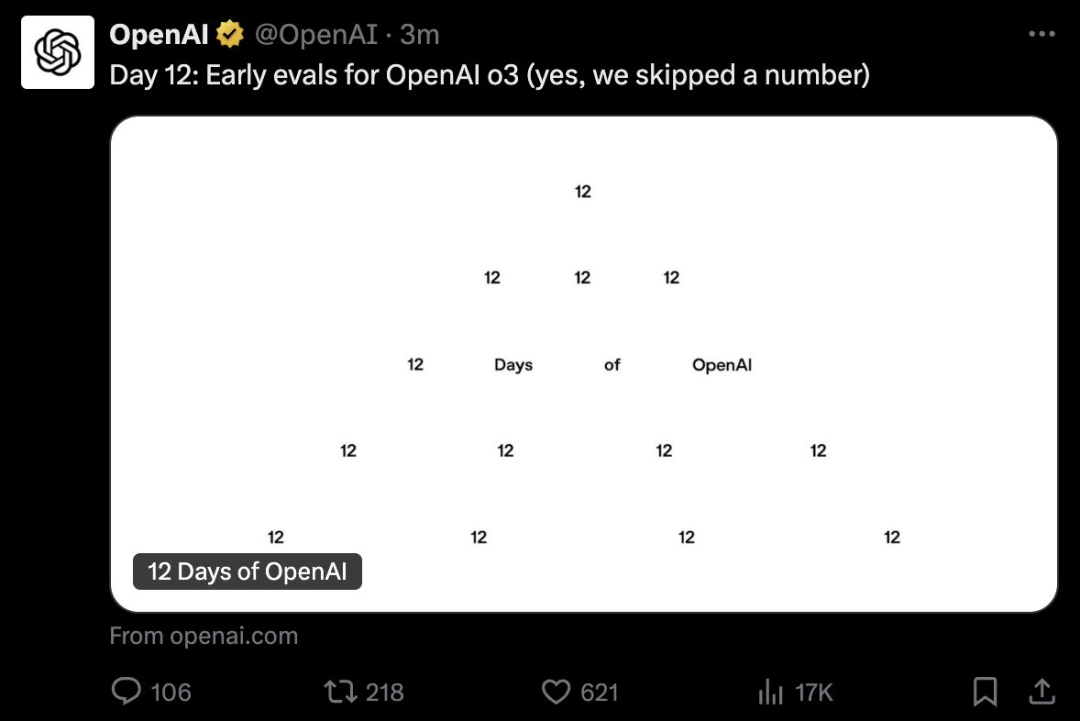

12天最後一天,OpenAI下一代推理模型o3真的出世了!

奧特曼、Mark Chen、任泓宇和ARC Prize基金會主席Greg Kamradt為我們做了介紹

奧特曼、Mark Chen、任泓宇和ARC Prize基金會主席Greg Kamradt為我們做了介紹正如所爆料那樣,突如其來的o3成為整場直播的「壓軸菜」。

奧特曼表示,之所以跳過o2,是因為對夥伴的尊重,以及延續OpenAI一貫「起名特別差」的傳統。

要知道,距離9月o1的出世,才過去了整整3個月的時間。o3的迭代速度,證明了Scaling Law似乎並未終結。

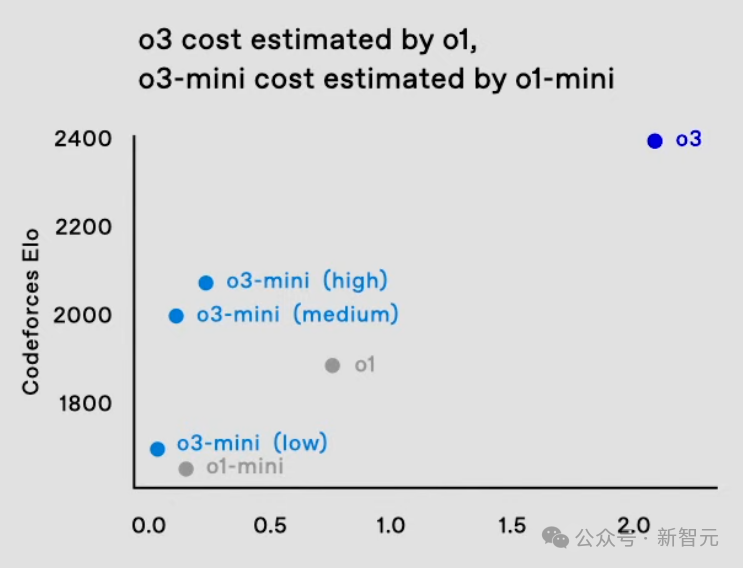

根據Keras之父發佈的報告稱,o3在低計算量模式下,每個任務需要花費高達20美金,而在高計算量模式中每個任務則需要數千美元。

o3數學代碼封神,粉碎o1

在多項基準測試中,o3再次刷新SOTA,就數學、代碼、軟件工程等領域,完全粉碎了滿血版o1!

在AIME 2024數學競賽評測中,o3取得了96.7%的準確率,性能直接飆升13.4%;在博士級科學問答基準GPQA Diamond上,o3準確率為87.7%,相較於上一代o1提升9.7%。

在今年11月Epoch AI發佈的數學基準Frontier Math上,o3準確率高達25.2%。

這個基準中,今天所有模型的準確率都低於2%,但是在激進的測試時間設置下,o3已經能夠達到25%的準確率。

如今,這一說法又被OpenAI o3推翻了。

在軟件工程SWE-bench Verified基準上,o3的代碼性能從o1的48.9%狂飆22.8%,達到了71.7%。

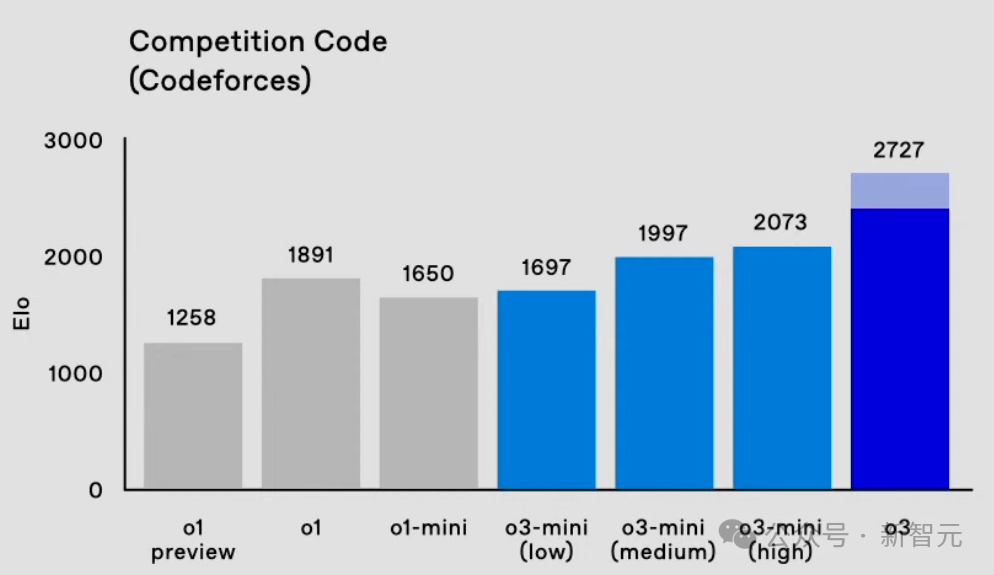

在Codeforces中,o3的Elo得分為2727,相較o1提升了800多分。

這個表現,已經達到了International Grandmaster的水平,相當於位列175名的人類選手。

甚至,超過了OpenAI的研究高級副總裁。

除o3之外,o3-mini同樣在數學、編碼、博士級科學問答、函數調用等基準上,取得了新的突破。

它真正定義了一種新的成本效益推理前沿。

奧特曼表示,這兩款新模型將面向研究人員測試,並期待未來盡快推出上線。

OpenAI研究科學家Sebastien Bubeck稱,o3在Frontier Maths取得25%準確率,在費爾茲獎得主Tim Gowers看來極其驚人。這暗示了AI發展火花加速迸發。

網民紛紛表示,就在今天,我們已經實現了AGI!

o3-mini:三種「思考模式」,計算越多能力越強

o3-mini作為o3系列的新成員,與o1-mini一樣,將為開發者帶來高性價比的AI體驗。

在編程能力評測中,o3-mini展現出驚人的實力。

通過「自適應思考時間」(adaptive thinking time)機制,o3能夠根據任務難度自動調整推理深度。

由此,它才實現了在代碼生成方面超越了前代o1。更令人驚歎的是,其運行速度和成本僅為o1的1/10。

o3-mini引入了三檔思考級別——低強度推理、中等強度推理、高強度推理,可以根據具體需求去調整模型的推理深度。

簡言之,簡單任務能夠得到快速響應。而複雜的問題,模型則可開啟更深度的思考模式。

任泓宇(左)本科畢業於北大,後在史丹福獲得博士學位,負責o3-mini的訓練

任泓宇(左)本科畢業於北大,後在史丹福獲得博士學位,負責o3-mini的訓練具體來說,在Codeforces測試中,o3-mini的Elo評分隨著思考時間的增加,性能逐步的到提升。

甚至,在中等強度思下,o3-mini(medium)已經超了滿血版o1的表現。

雖然o3-mini(high)在高強度思考下,仍落後於o3,但幾乎差別不大。

而且,在成本和思考速度方面,o3-mini取得了超越o1-mini更好的性能。

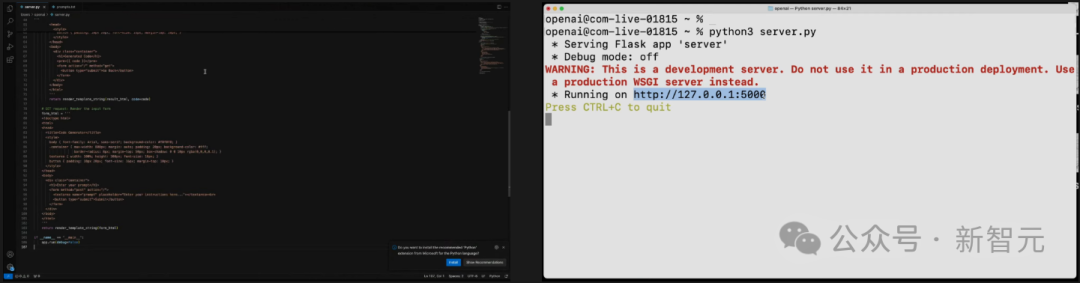

在演示中,研究者要求模型使用Python實現代碼生成器和執行器。

啟動之後,就像運行Python腳本一樣,模型將在本地啟動一個服務器,帶有一個包含文本框的UI。

然後我們就可以在其中發出編碼請求了,它會請求調用o3-mini API,它將解決任務,返回一段代碼。

代碼會保存在本地桌面上,然後打開終端自動執行代碼。

以下,就是模型生成的代碼,用時僅38秒。

把代碼複製黏貼到服務器上,並運行。

然後,便可獲得對應的UI界面——一個文本框。

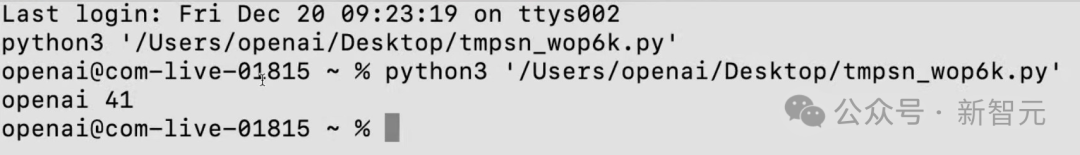

我們可以在其中輸入代碼,比如打出OpenAI和一個隨機數,它就會將請求發送到o3-mini(medium)。

模型果然按要求輸出OpenAI,以及41這個數字。

在下面這個任務中,研究者要求模型用較低的推理能力,來評估o3-mini在難度很高的GPQA數據集上的表現。

模型首先需要從該URL下載原始文件,然後需要識別哪些部分是問題,哪些是答案,哪些是選項。最後,模型需要整理出所有的問題,並嘗試作答,解析結果,最後進行評分。

模型的運行速度極快,因為它調用的是o3-mini,並使用了較低的推理計算。

可以看到,結果為61.62%,和正式評估幾乎一模一樣。

而且這個運行極快的低推理能力模型,整個評估過程只用了一分鐘。

除了代碼成績亮眼,o3-mini也展現出了卓越的數學能力。

在AIME 2024數學競賽測試中,o3-mini(low)已經接近o1 mini的水平。

o3-mini(medium)以78.2%的準確率超越了o1(圖中實心部分),而o3-mini(high)進一步提升了性能。

在延遲方面表現,o3-mini(low)大幅降低了延遲,降低至1秒內,媲美GPT-4的即時響應。

o3-mini(medium)的延遲比o1-mini快一半。

當然,OpenAI為了滿足開發者的需求,o3-mini提供了全套API功能,包括函數調用、結構化輸出、開發者消息。

更難能可貴的是,在這些功能上,o3-mini的性能不僅完全對標o1,並在多數評測中取得了更好的表現。

另外,在具有挑戰性的GPQA數據集測試中,o3-mini展現出穩定的性能,即便是在低強度思考模式下,o3-mini(low)也達到了62%的準確率。

o3-mini暫時只向安全研究院開放測試,可以直接在OpenAI網站中進行申請。

ARC-AGI基準

ARC Prize Foundation是一家非營利組織,使命是在基準測試期間成為AGI的北極星。

他們的第一個基準ARC-AGI,是由Keras之父François Chollet於2019年在關於智力測量的論文中發表的,它在AI領域已經保持5年不敗。

擊敗ARC-AGI的系統,將成為邁向AGI的重要里程碑。

它的全部內容,都是輸入示例和輸出示例,目標是瞭解變換的規則,猜出輸出的示例。

而它的每項任務,都需要不同的技能。

比如下面這個任務,憑人類直覺,很容易猜出最後一張圖應該是什麼,但AI很難理解。

在這個任務中,則是需要在黃色方塊中,數一下共有多少種顏色的方塊,然後用它創建一個邊框。

研究者使用了兩個ARC-AGI 數據集對 o3 進行了測試:

-

半私有評估:100個私有任務,用於評估過擬合

-

公共評估:400個公共任務

他們在兩種計算水平下進行了測試,樣本規模分別為6(高效模式)和1024(低效模式,計算量是高效模式的172倍)。

厲害的是,在這個基準測試中,o3在低計算模式下,在半私有評估中的得分為75.7%;在高計算模式下,得分為87.5%。

具體來說,高計算模式下的得分為 75.7%,符合 RC-AGI-Pub的預算限制(成本低於1萬美元),因此在公共排行榜上排名第一。

低計算模式下的得分為 87.5%,雖然成本較高,但仍然表明在新任務上的性能隨著計算量的增加而提升。

這點尤為重要,因為人類在該任務上的表現通常在85%的水平。

超過這一數字,就意味著達到了一個重要的里程碑,因為此前從未有任何AI系統實現過這一成就。這標誌著ARC-AGI領域的一個全新突破。

ARC Prize Foundation的主席表示,看到這些分數時,他意識到需要稍微改變一下自己的世界觀,修正對AI究竟能做哪些事情的直覺。

而且要知道,目前還僅是AI的早期階段,所以我們就更需要ARC-AGI這樣的持久性基準測試,來對進展進行評估和引導了。

OpenAI o3,還不是AGI

總之,這是AI能力的一次令人驚訝且意義重大的躍升,展現了GPT系列模型前所未有的新任務適應能力。

要知道,ARC-AGI-1從2020年GPT-3的0%提升到2024年GPT-4o的5%,曆時4年。

儘管成本較高,但o3的這些成績並不僅僅是通過在基準測試上應用暴力計算得來的。

可以說,o3的性能不是一次漸進式的改進,而是一次真正的突破,標誌著AI能力相比此前的LLM局限性,實現了質的飛躍。

能夠適應從未遇到過的任務,意味著o3在ARC-AGI領域的表現已接近人類水平。

當然,這種通用性伴隨著高昂的成本,目前還不算經濟:我們可以花大約5美元,讓人類解決一個ARC-AGI任務,僅消耗幾美分的能源。

而o3在低計算模式下每個任務需要17-20美元。但成本效益可能會在未來顯著提升,所以,AI在較短的時間內,將代替人類的動作。

o3 相較於GPT系列的改進,證明了架構的重要性。

要知道,我們無法通過給GPT-4增加更多計算量,來獲得這樣的結果。

簡單地擴大我們從2019年到2023年所做的事情(採用相同的架構,在更多數據上訓練一個更大的版本)是不夠的。

而這一次,OpenAI找到了全新的思路!

實現AGI了嗎?

ARC-AGI以一種飽和或低要求基準測試無法實現的方式,展現了泛化能力。

然而,需要注意的是,ARC-AGI並不是AGI的試金石——它只是一種研究工具,旨在聚焦於AI領域中最具挑戰性的未解決問題。

通過ARC-AGI,並不意味著實現AGI。

我們無法認為o3是AGI,它在簡單任務上仍然表現不佳,這表明它與人類智能之間存在根本性的差異。

此外,數據表明,即將推出的ARC-AGI-2基準測試對o3來說,仍將是一個重大挑戰,

即使在高計算模式下,其得分可能會低於30%(而一個聰明的人類無需訓練仍能超過95%)。

這表明,人類仍然有可能創建具有挑戰性且未飽和的基準測試,而無需依賴專業領域知識。

當創建那些對普通人來說很簡單,但對AI來說很睏難的任務變得完全不可能時,就是AGI真正到來的時候。

和舊模型的區別

為什麼o3得分比o1高出這麼多?又為什麼o1得分比GPT-4o高出這麼多?

這一系列結果為通用人工智能(AGI)的持續探索提供了寶貴的數據點。

大模型本質上是向量程序的存儲庫。當給出提示詞時,LLM會提取提示詞對應的程序,並在當前輸入上「執行」。

也就是說,它們是通過被動接觸人類生成內容來存儲和操作化數百萬個有用的小程序的一種方式。

這種「記憶、提取、應用」的模式可以在適當的訓練數據下,實現對任意任務的任意技能水平,但它無法適應新任務或即時掌握新技能(也就是說,這裏沒有流體智力的作用)。

這一局限性在ARC-AGI測試中,表現得尤為明顯——GPT-3得分為0,GPT-4得分接近0,而GPT-4o達到了 5%。

將這些模型擴展到可能的極限,也未能讓 ARC-AGI 的得分接近多年前基本的暴力枚舉方法所能達到的水平(高達50%)。

而要適應新任務,需要兩樣東西。

第一,需要知識——一組可重用的函數或程序供調用。LLM在這方面已經綽綽有餘。

第二,需要在面對新任務時將這些函數重新組合成一個全新的程序的能力——一個能夠建模當前任務的程序,也就是程序合成。

而LLM長期以來缺乏這一特性,O系列模型卻帶了新的突破。

o3模型的核心創新在於,實現了token空間內自研語言程序搜索和執行。

它在測試時會搜索可能的CoT空間,尋找描述解決任務所需的步驟,由評估模型引導搜索過程。

這種方式可能與AlphaZero的蒙地卡羅樹搜索並無太大差異。

值得注意的是,Demis Hassabis在去年6月的一次採訪中暗示,DeepMind一直在研究這一想法——這項研究已經醞釀許久。

因此,儘管單次生成(single-generation)的LLM在應對新任務方面表現不佳,但o3通過生成並執行自己的程序克服了這一問題,其中程序本身(即CoT)成為知識重組的產物。

儘管這並不是測試時,知識重組的唯一可行方法(也可以進行測試時訓練,或在潛在空間中搜索),但根據這些最新的ARC-AGI數據,它代表了當前的最先進水平。

實質上,o3本質上是一種深度學習引導的程序搜索形式。

在測試時搜索「程序」空間,探索自然語言程序,描述解決當前任務步驟的CoT空間,並由一個基礎LLM提供引導。

這一過程,可能需要處理千萬個token,消耗大量的計算資源,花費數千美元,因為需要探索眾多路徑並進行回溯。

o3雖然取得了突破,但仍有兩個主要的限制。

首先,其生成了自然語言指令,而非可執行程序,缺乏直接執行和評估能力。

其次,依賴專家標註的、人工生成的CoT數據,無法自主獲得程序生成和評估能力。

儘管如此,o3的表現仍證實了直覺引導的測試時搜索的巨大潛力。

可以說,o3是具有里程碑意義的成就,為未來AGI下一步探索指明了方向。

參考資料:

https://x.com/OpenAI/status/1870164871289155937

https://arcprize.org/blog/oai-o3-pub-breakthrough