2025 AI Agent劍指何方?兩份前沿報告描繪全景地圖

文 | 適道

如果說LLMs是「人類智慧」,那麼AI Agent就是「使用火燧」,引領人類文明進入下一個時代。

2024年,AI Agent稱得上最火熱的概念。一方面,大模型賽道降溫,並呈現出贏家通吃的局面;另一方面,AI Agent則是大模型應用落地的最佳形式,其能夠解決LLMs在具體應用場景中的局限性。

那麼,當前AI Agent採用現狀如何?哪些領域會率先衝出來?

我們結合兩份重量級報告——LangChain發佈的State of AI Agents,以及Langbase發佈的2024 State of AI Agents進行梳理,試著尋找AI Agent在開發、採用過程中的關鍵問題。

LangChain調查了1300多位專業人士,職業包括工程師、產品經理、業務領導和高管;行業分佈:科技(60%)、金融服務(11%)、醫療保健(6%)、教育(5%)、消費品(4%)。報告鏈接https://www.langchain.com/stateofaiagents

Langbase調查了3400多位專業人士(100多個國家),職業包括C級高管(46%)、工程師(26%)、客戶支持(17%)、MKT(8%)。報告鏈接https://langbase.com/state-of-ai-agents

具體內容如下:

1、誰在採用AI Agent?

LangChain調查顯示:約有51%的受訪者已經在生產環境中採用了AI Agent;78%的受訪者計劃在近期將AI Agent引入生產應用。

按規模看,員工人數為100-2000的中型企業最為積極,採用率達到63%;按行業看,90%的非科技公司已經部署或計劃部署AI Agent,這與科技公司(89%)旗鼓相當。

Langbase調查顯示:目前,AI(非AI Agent)的實驗用途比例遠遠大於生產用途,雖然後者在穩步增加中。

2、AI Agent基座大模型哪家強?

Langbase調查顯示:OpenAI(76%)佔據主導地位;Google(59%)正迅速崛起,成為其強勁的競爭對手;Anthropic(47%)緊隨其後。Meta的Llama、Mistral和Cohere影響力不高,但增長形勢不容忽視。

各家大模型的採用情況如下:

OpenAI在技術和營銷應用處於領先地位,同時也是翻譯能手;

Google在健康和翻譯領域表現相當出色,展示其在語言和醫學領域的強大實力;

Anthropic是處理技術任務的高手,但在營銷和翻譯方面的使用率較低;

Mistral在技術和科學領域表現不錯,不過是個偏科生;

Meta被廣泛應用於技術和科學領域;

Cohere在多個領域的齊頭並進。

3、選擇AI Agent基座大模型受哪些因素影響?

Langbase調查顯示,準確性(45%)是最重要的因素,其次是安全性(24%)和可定製性(21%),成本(10%)影響相對較小。(註:與「企業採用AI Agent有何顧慮」基本一致)

4、企業在哪些場景採用AI Agent?

LangChain調查顯示:研究與總結(58%)、個人生產力工具(53.5%)、客戶服務(45.8%)。

該結果顯示——人們希望將耗時任務交給AI Agent。

知識過濾器:AI Agent能夠快速提煉關鍵信息。在文獻綜述或研究分析中,人們無需自己手動篩選海量數據;

生產力加速器:AI Agent可以協助安排日程、管理任務,提升個人效率,讓人們專注於更重要的工作;

客服神助攻:AI Agent幫助企業更快地處理客戶諮詢、解決問題,大幅提升團隊的響應速度。

Langbase調查顯示:自動化、簡化是企業採用AI的首要目標,其在效率和流程簡化方面受益;定製化解決方案、提升協作能力則反映了大模型日益增長的靈活性,以及消費者對系統共享訪問的興趣。

在具體場景上,Langbase調查顯示:

AI大模型在軟件開發(87%)應用最廣泛;

其次是文本摘要(59%)、市場營銷(50%)、IT運營(48%)、客服(43%);

最後是人力資源(26%)、法律合規(15%)等領域。

值得注意的是,該結果與上述LangChain的調查有些出入。主要原因是——Langbase的提問方式是AI大模型,而非AI Agent。

5、在生產中採用AI Agent存在哪些顧慮?

LangChain調查顯示,性能質量(41%)是首要關注點,其重要性遠超成本(18.4%)和安全(18.4%)等因素。

AI Agent依賴LLM「黑盒」控制工作流程,這會帶來不可預測性,增加出錯風險。因此,團隊難以確保其Agent 能否始終提供準確、符合上下文的響應。

對於小企業而言,性能質量尤其重要——45.8%的小企業將性能質量列為主要關注點,而成本因素僅為 22.4%。

對於必須遵守法規,要敏感地處理客戶端數據的中大型企業來說,安全問題也很普遍,超過了成本因素。

除了上述因素,LangChain在書面回覆中發現,團隊還面臨知識、時間難題。

知識不足:許多團隊缺乏構建和部署 AI Agent的專業技能,特別是在特定應用場景下的實現。員工們還要苦練專業技能,以高效利用AI Agent。

時間有限:構建可靠的AI Agent需要投入大量時間成本,包括調試、評估和模型微調等環節。

Langbase調查顯示:複雜的擴展和部署過程是阻礙採用的首要問題;其次是數據隱私和安全合規性;缺乏監控工具、高昂的基礎設施成本也阻礙了技術的落地應用。

6、AI Agent開發相關問題有哪些?

Langbase調查顯示:在生產環境中部署LLM和AI Agent面臨關鍵挑戰,包括定製化難度高、缺乏用於質量保證的評估方法,可重覆使用的基礎設施不足。碎片化工具、集成問題以及可擴展性限制進一步加劇困難,突顯出構建簡化流程和強大支持工具的必要性。

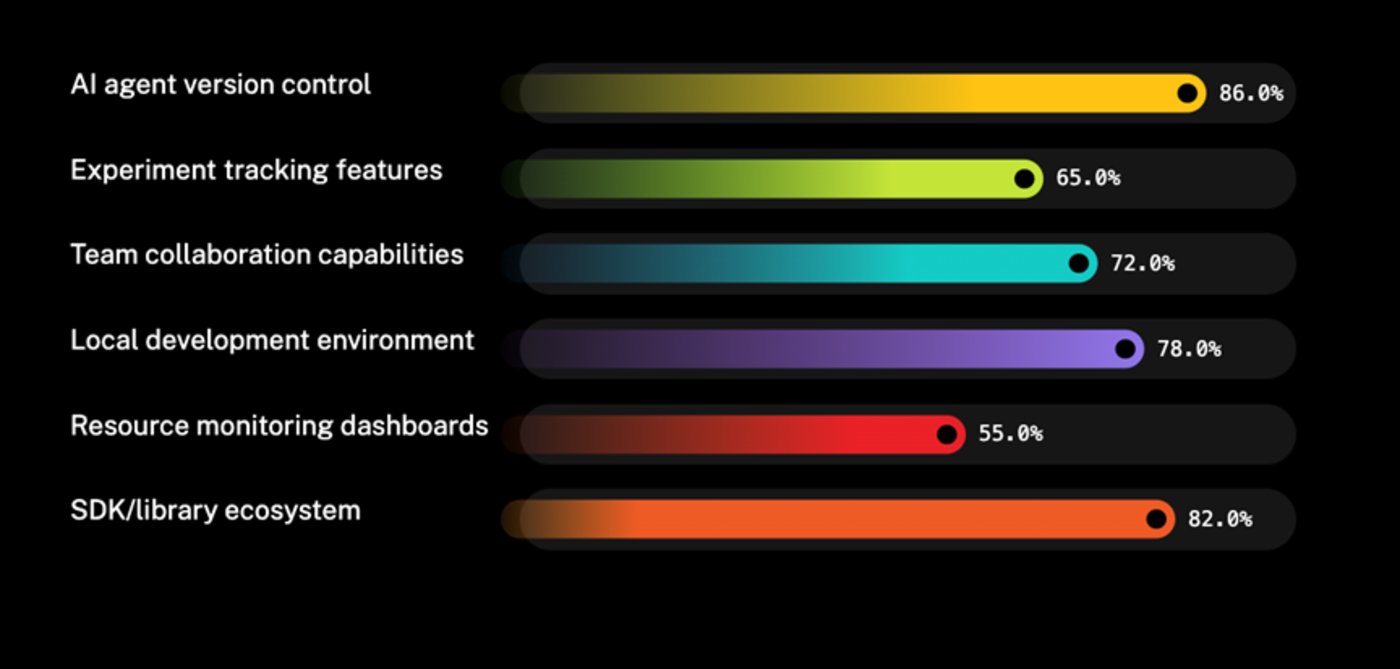

開發者將AI Agent的版本控制視為開發平台最重要的功能。強大的SDK、庫生態系統、本地開發環境也受到關注。

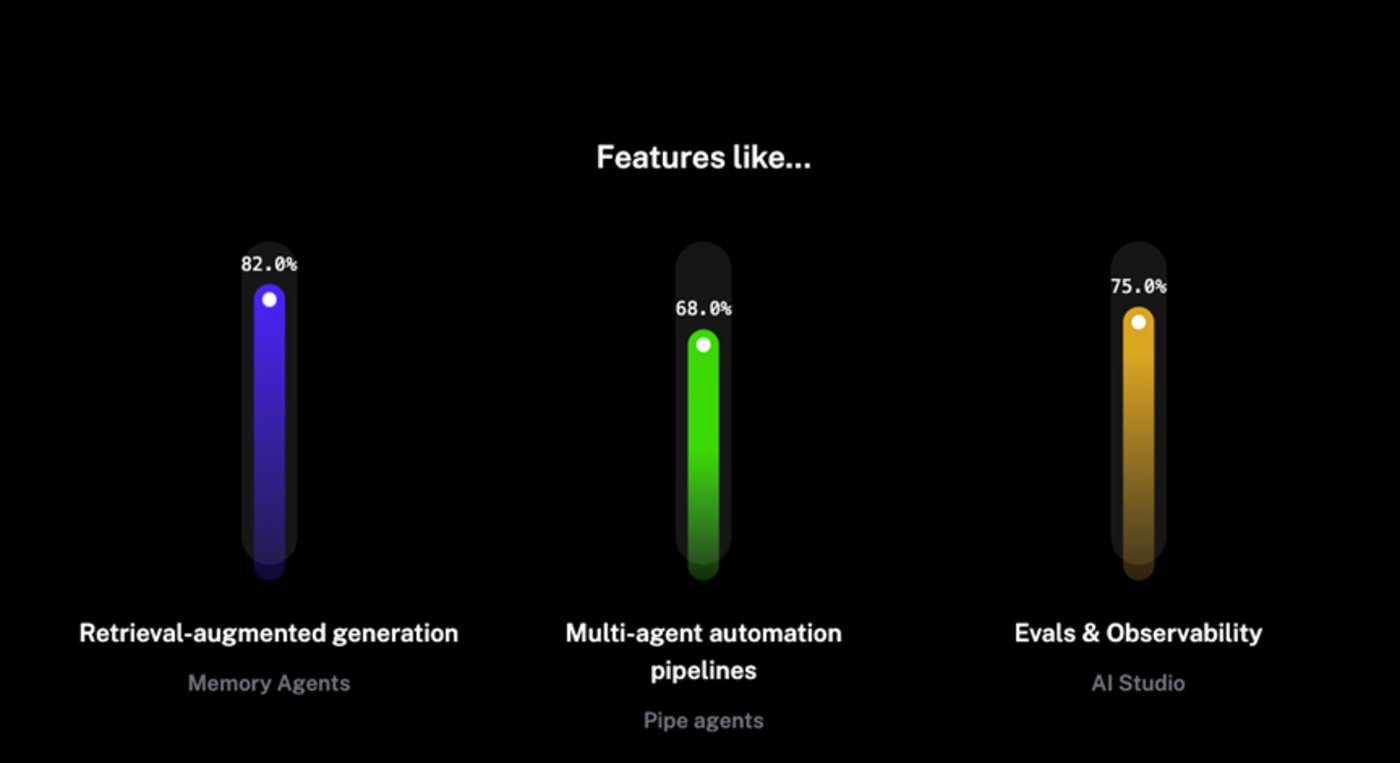

大多數受訪者需要多代理RAG能力以提高上下文信息處理;評估工具對於確保AI系統按預期工作同樣很重要;多代理流水線也是在生產中實現複雜任務的關鍵技術。

7、對AI Agent有哪些展望?

LangChain調查顯示:企業在採用AI Agent,既有新的期待,也會面臨持續的挑戰。

新的期待:

處理多步驟任務:AI Agent具備更深入的推理和上下文理解能力,能夠應對複雜任務。

自動化重覆性任務:AI Agent被視為自動化日常任務的關鍵工具,釋放人力投入更具創造性的工作。

任務分配與協作:優化任務分配,確保合適的Agent在正確的時間處理特定問題,尤其在多Agent系統中。

類人推理能力:不同於LLMs,AI Agent能追溯並優化自己的決策,根據新信息調整策略,類似人類的思考過程。

主要挑戰:

Agent的黑盒機制:工程師發現,他們很難向團隊和利益相關者解釋 AI Agent 的功能和行為。儘管可視化步驟有助於理解到底發生了什麼,但 LLM 的內部機制仍然是個黑盒,增加瞭解釋的難度。

重點關註:

對開源AI Agent的興奮:許多人對開源AI Agent 表現出濃厚興趣,認為集體智慧能加速創新。

期待更強大的模型:大家期待更高級的 AI Agent,由更強大的模型驅動,以更高的效率和自主性處理複雜任務。

結語

從企業的採用意願來看,2025年或將成為AI Agent的爆發元年。

從爆發領域來看,軟件開發、客戶服務、市場營銷等領域將率先跑出種子選手。目前已知的就包括編程神器Cursor、AI Coding「鼻祖」Replit等等。

值得關注的是,這兩份報告均揭示出當前AI Agent落地的最大難點——準確性,甚至連成本因素都名列二、三位。

一個辦法是等待「至尊」大模型出現,但這取決於巨頭們的能力邊界。而在某種程度上,AI Agent的出現本身就是為瞭解決LLM在具體應用場景中的局限性。因此,開發者需要儘可能地在記憶、規劃、工具使用等其他技術棧下功夫。

如果不能迅速實現,我們也可以換個思路:短期內商業化成功的AI Agent,不一定是看起來「代理化」程度最高的產品;而是能夠平衡性能、可靠性,以及用戶信任的產品。

換句話說,如果做不到完全自主,開發者需要從一開始考慮如何將人類員工融入其中,做到準確性萬無一失。

正如吳恩達的觀點,形容詞「Agentic」比名詞「Agent」能更好地幫助我們理解這類智能體的本質。如同自動駕駛汽車L1-L4,Agent的進化也是一個過程。或許,一個確定的趨勢是先擁有AI Copilot,再擁有AI Agent。只不過,Copilot這個詞的存在感可能會降低,轉而被「少量Agentic能力」代替。