阿里雲通義開源首個多模態推理模型 QVQ,視覺推理比肩 OpenAI o1

12 月 25 日,阿里雲通義千問發佈業界首個開源多模態推理模型 QVQ-72B-Preview。QVQ 展現出超預期的視覺理解和推理能力,在解決數學、物理、科學等領域的複雜推理問題上表現尤為突出。多項評測數據顯示,QVQ 超越了此前的視覺理解模型「開源王者」Qwen2-VL,整體表現與「滿血版」OpenAI o1、Claude3.5 Sonnet 等推理模型相當。目前,開發者可在魔搭社區和 HuggingFace 平台上直接體驗。

人類的推理能力植根於語言思維和視覺記憶中,正因此,利用視覺理解增強大模型推理能力,成為 AI 技術的前沿探索之一。一個月前,通義發佈 AI 推理模型 QwQ-32B-Preview,即斬獲 SuperCLUE 的 AI 推理模型榜單「全球開源冠軍」;如今,通義團隊在 Qwen2-VL-72B 開源模型基礎上,研發出多模態推理模型 QVQ-72B-Preview,可實現更仔細的逐步推理,視覺推理能力也顯著進步,在解決複雜問題時表現驚豔。

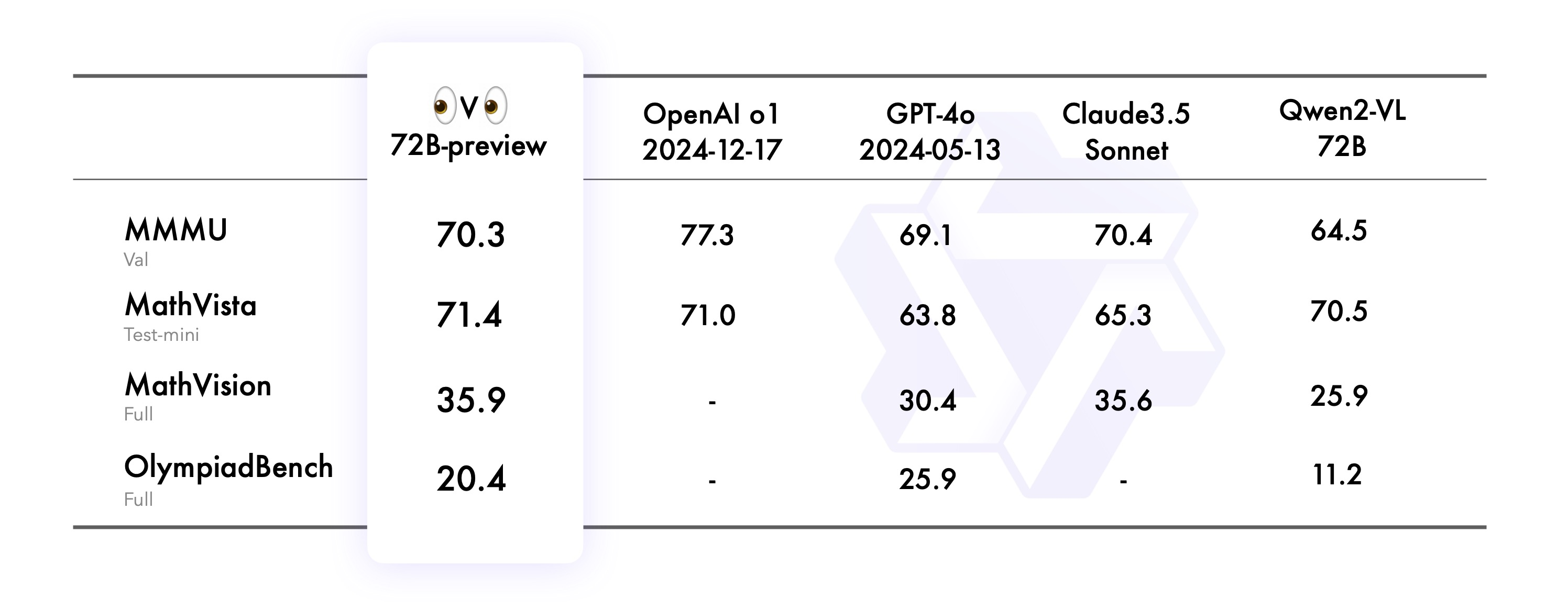

在考察模型視覺理解及推理的 MMMU 評測中,QVQ 取得了 70.3 分,水平已達大學級別;在聚焦數學的視覺推理測試 MathVista 中,QVQ 得分超過 OpenAI o1,印證了其強大的圖形推理能力;在更具多樣性和學科廣度的 MathVison 評測中,QVQ 表現超越 Claude3.5 及 GPT4o,說明 QVQ 更擅長解決真實數學問題;在奧賽級別的 OlympiadBench 基準測試中,QVQ 也展現了出色的視覺推理能力。

QVQ 是一個會基於視覺進行深度思考推理的大模型。QVQ 不但能感知更準確的視覺內容,並據此作出更細緻的分析推理,還會質疑自身假設,仔細審視其推理過程的每一步,經過深思熟慮後給出最後結論。QVQ 可以輕鬆識別「梗圖」內涵;看真實照片可合理推斷出物體個數及高度等信息;在面對數學、物理、化學等各科學領域難題,QVQ 能像人甚至科學家一樣,給出思考過程和準確答案。

目前,QVQ-72B-Preview 已在魔搭社區和 HuggingFace 等平台上開源,開發者可上手體驗。據瞭解,一個月前開源的推理模型 QwQ 受到全球開發者熱捧,一發佈就登上 HuggingFace 模型趨勢榜榜首。截至目前,通義千問 Qwen 的衍生模型數突破 7.8 萬個,已超越 Llama 成為全球規模最大的 AI 模型群。