Anthropic聯創:Scaling Law沒崩,但推理成天價,有了湯臣T,25年AI更加速

【導讀】Anthropic聯創發文表示,誰要是說Scaling Law撞牆了,那他絕對錯了!在25年,AI靠測試時計算還會繼續加速。不過,隨之而來的推理成本也是天價,o3的每個任務成本高達20美元,怎麼辦?

Scaling Law要撞牆了?

Anthropic聯創Jack Clark反駁了這一說法:絕非如此!

在他看來,目前的AI發展還遠遠沒到極限,「所有告訴你AI進展正在放緩,或者Scaling Law正在撞牆的人,都是錯誤的。」

o3仍有很大的增長空間,但採用了不同的方法。

OpenAI的技術秘訣並不是讓模型變得更大,而是讓它們在運行時,使用強化學習和額外的計算能力。

這種「大聲思考」的能力,為Scaling開闢了全新的可能性。

而Jack Clark預計,這一趨勢在2025年還會加速,屆時,科技公司都會開始將大模型的傳統方法跟在訓練和推理時使用計算的新方法相結合。

這個論斷,跟OpenAI首次推出o系列模型時的說法完全吻合了。

在同一時間,MIT的研究者也發現,採用測試時訓練(湯臣T)技術,能顯著提高LLM進行邏輯推理和解決問題的能力。

論文地址:https://ekinakyurek.github.io/papers/ttt.pdf

Scaling Law撞牆,絕對錯了

在他的新聞通訊《Import AI》中,Clark對關於AI發展已到達瓶頸的觀點進行了反駁。

博文地址:https://jack-clark.net/

比如OpenAI的o3模型,就證明了AI極大的發展空間。

在現有強大基礎模型之上,採用一種新方法——讓大語言模型在推理時「邊思考邊執行」,即測試時計算(test-time compute)。這種方式能帶來巨大的回報。

因此Clark預計,下一個合理的發展方向將是同時擴展強化學習(RL)和底層基礎模型,這將帶來更為顯著的性能提升。

這意味著,隨著現有方法(大模型scaling)與新方法(強化學習驅動的測試時計算等)的結合,2025年的AI進展相對2024年會進一步加速。

OpenAI著名研究員Jason Wei也表示,更加關鍵的是,從o1到o3的進步也僅僅只用了3個月,這說明了在推動人工智能領域發展方面來講,強化學習驅動的推理擴展計算範式,會比預訓練基礎模型的傳統擴展範式快得多。

這並非空談,Clark列舉了不少o3的亮眼成績來證明他的觀點。

首先,o3有效突破了「GPQA」科學理解基準(88%),這彰顯了它在科學領域進行常識推理和解答的能力。

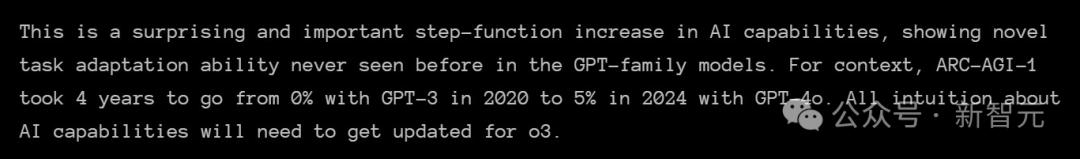

它在「ARC-AGI」這一任務上的表現優於亞馬遜眾包平台(MTurk)僱傭的人類工作者。

甚至,o3在FrontierMath上達到了25%的成績——這是一個由費爾茲獎得主設計的數學測試,就在幾個月前,SOTA的成績僅為2%。

並且,在Codeforces上,o3獲得了2727分,排名第175。這讓它成為這一極其困難基準上的最佳競技程序員之一。

模型成本將更難預測

Clark認為,大多數人還沒有意識到未來進展的速度將會有多快。

「我認為,基本上沒有人預見到——從現在開始,AI進展將會有多麼急劇。」

同時,他也指出,算力成本是急速進展中的一個主要挑戰。

o3之所以如此優秀,其中的一個原因是,它在推理時的運行成本更高。

o3的最先進版本需要的算力比基礎版多170倍,而基礎版的算力需求已經超出了o1的需求,而o1本身所需的算力又超過了GPT-4。

o系列模型的性能與成本

o系列模型的性能與成本 Clark解釋說,這些基於推理擴展範式的新模型使得成本預測變得更加困難。

過去,模型的成本費用是很直觀的,主要取決於模型的大小和輸出長度。

但在o3這類模型中,由於其資源需求會根據具體任務的不同而變化,所以也更難直觀地給出模型執行任務時的花費。

o3推理成本達新高

除了FrontierMath和Codeforces上的成績,o3在GPT Diamond Benchmar上,對於博士級的科學問題也拿到了87.7%,遠高於各自領域博士專家70%的平均分。

ARC-AGI基準測試開發者、Keras之父François Chollet,將o3的性能稱為「AI能力中令人驚訝且重要的階躍函數增長」

而這背後付出的代價,就是運行o3極高的成本。

之所以會造成如此高的成本,就是源於o3和其他模型處理問題方式的不同。

傳統的LLM主要依靠的是檢索存儲模式,但o3處理問題時,卻是靠實時創建新程序,來解決不熟悉的挑戰。

Chollet表示,o3系統的工作原理,似乎和GoogleDeepMind的AlphaZero國際象棋程序類似。後者會有條不紊地搜索可能的解決方案,直到找到正確方法。

這個過程也就解釋了,為什麼o3需要如此多的算力——只為單個任務,模型就需要處理多達3300萬個token。

跟當前的AI系統相比,這種密集的token處理成本,簡直是天價!

高強度推理版本的每個任務,運行費用約為20美元。

也就是說,100個測試任務的成本為2012美元,全套400個公共任務的成本則達到了6677美元(按平均每個任務花費17美元計算)。

而對於低強度推理版本,OpenAI尚未透露確切的成本,但測試顯示,此模型可以處理33至1.11億個token,每個任務需要約1.3分鐘的計算時間。

o3在ARC-AGI基準測試中必須解決的視覺邏輯問題示例

o3在ARC-AGI基準測試中必須解決的視覺邏輯問題示例 等待Anthropic的下一步

所以,Anthropic下一步會給我們帶來什麼呢?

目前,由於Anthropic尚未發佈推理模型(reasoning model)或測試時模型(test-time model),來與OpenAI的o系列或Google的Gemini Flash Thinking競爭,Clark的這一番預測,不禁讓人好奇Anthropic的計劃。

他們之前宣佈的Opus 3.5旗艦模型至今仍沒有確切消息。

開發週期長達一個月,過程充滿不確定性

在11月,Anthropic CEO Dario Amodei曾證實,公司正在開發Claude Opus的新版本。

起初,Opus 3.5定於今年發佈,但後來Amodei再提到它時,只是說它會在「某個時刻」到來。

不過Amodei倒是透露,公司最近更新和發佈的Haiku 3.5,性能已經跟原始的Opus 3相匹敵,同時運行速度還更快,成本也更低。

其實,這也不僅僅是Anthropic面臨的問題。

自GPT-4亮相以來,LLM的功能並沒有取得重大飛躍,這種停滯已經成為AI行業內一種普遍的廣泛趨勢。

更多時候,新發佈的模型只是微小的進步,跟之前有一些細微的差別。

開發更先進的LLM,為何如此複雜

在Lex Fridman的播客訪問中,Amodei詳細講述了開發這些AI模型的複雜性。

他表示,僅訓練階段,就有可能會拖延數個月,還會需要大量的計算能力,用上數以萬計的專用芯片,如GPU或TPU。

預訓練過後,模型將經歷複雜的微調的過程,一個關鍵部分就是RLHF。

人類專家會煞費苦心地審查模型的輸出,根據不同標準對其進行評分,幫助模型學習和改進。

接下來,就是一系列內部測試和外部審計,來檢查模型的安全問題,通常是與美國和英國的AI安全組織合作。

總之,Amodei總結道:雖然AI的突破在圈外人士看來,像一個巨大的科學飛躍,但其實很多進步都可以歸結為枯燥和無聊的技術細節。

在此過程中,最困難的部分通常是軟件開發、讓模型運行得更快,而不是重大的概念進步。

而且,每個新版本模型的「智能」和「個性」,也都會發生不可預測的變化。在他看來,正確訓練模型與其說是一門科學,不如說是一門藝術。

即使真正發佈的Opus 3.5的性能有了提升,卻也不足以證明其高昂的運營成本是合理的。

不過,雖然有人認為Anthropic沒有緊跟推理模型的步伐,已經足以反映LLM擴展的巨大挑戰;但不得不說,Opus 3.5也並非毫無意義。

顯然,它幫助訓練了全新的Sonnet 3.5,它已經成為了當今市場上最受歡迎的LLM。

參考資料:

https://the-decoder.com/ai-progress-in-2025-will-be-even-more-dramatic-says-anthropic-co-founder/

https://jack-clark.net/2024/12/23/import-ai-395-ai-and-energy-demand-distributed-training-via-demo-and-phi-4/

本文來自微信公眾號「新智元」,編輯:編輯部 Zjh ,36氪經授權發佈。