DeepSeek V3刷屏,550萬元2000張卡做出的開源模型,和OpenAI幾億燒出來的一樣好

作者|王兆洋郵箱|wangzhaoyang@pingwest.com

像是迷霧中走出的一頭怪獸,DeepSeek V3在先行「泄露」並引發一陣驚歎後,開發方深度求索正式發佈了技術報告。

在這個報告中,Deepseek透露了訓練的關鍵數據,其中最引人注目的,是它的高效和對算力資源依賴之小,同時效果又異常的好——

「在預訓練階段,在每個萬億標記上訓練 DeepSeek-V3 只需要 180K H800 GPU 小時,也就是說,在我們的具有 2048 個 H800 GPU 的集群上需要 3.7 天。因此,我們的預訓練階段在不到兩個月的時間內完成,成本為 2664K GPU 小時。結合 119K GPU 小時的上下文長度擴展和 5K GPU 小時的後訓練,DeepSeek-V3 的完整訓練成本僅為 2.788M GPU 小時。假設 H800 GPU 的租金為每 GPU 小時 2 美元,我們的總訓練成本僅為 557萬美元。請注意,上述成本僅包括 DeepSeek-V3 的正式訓練,不包括與架構、算法或數據相關的先前的研究或精簡實驗的成本。」

「我們對DeepSeek-V3 進行了全面的基準測試。儘管 DeepSeek-V3-Base 的訓練成本較低,但綜合評估表明,DeepSeek-V3-Base 已經成為目前可用的最強大的開源基礎模型,特別是在代碼和數學方面。它的聊天版本在其他開源模型上的表現也優於其他開源模型,並在一系列標準和開放式基準測試中實現了與 GPT-4o 和 Claude-3.5-Sonnet 等領先閉源模型的性能相當。」

而不久前,Anthropic的CEO達里奧·阿莫迪曾透露,GPT-4o這樣的模型訓練成本約為1億美元,而目前正在開發的AI大模型訓練成本可能高達10億美元。未來三年內,AI大模型的訓練成本將上升至100億美元甚至1000億美元。

也就是,現在DeepSeek用550萬美金2000張卡訓出的開源模型,和OpenAI幾億燒出的模型一樣好了。

它旋即被再次稱為「國貨之光」,在預訓練撞牆,一切都要扭轉到推理階段的變換節點,deepseek v3的一系列技術方法,數據指標和測試性能,以及口碑,都讓它成了一件事的最好代表:

在「o1」時代,當算力不再是唯一因素,中國模型開發者的機會更多了。

「性能對標GPT-4o 以及 Claude-3.5-Sonnet」,而且是用開發者的嘴講出

DeepSeek-V3 為幻方旗下的深度求索公司自研 的MoE 模型,671B 參數,激活 37B,在 14.8T token 上進行了預訓練。在Deepseek V3 技術報告公佈的性能指標上來看,這個開源MoE模型,已經在性能上「對齊海外領軍閉源模型」。

根據它的官方公告,它在多項評測成績上,超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他開源模型,並在性能上和世界頂尖的閉源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

Deepseek羅列了幾個關鍵的表現領域:

-

百科知識:DeepSeek-V3 在知識類任務(MMLU, MMLU-Pro, GPQA, SimpleQA)上的水平相比前代 DeepSeek-V2.5 顯著提升,接近當前表現最好的模型 Claude-3.5-Sonnet-1022。

-

長文本: 在長文本測評中,DROP、FRAMES 和 LongBench v2 上,DeepSeek-V3 平均表現超越其他模型。

-

代碼:DeepSeek-V3 在算法類代碼場景(Codeforces),遠遠領先於市面上已有的全部非 o1 類模型;並在工程類代碼場景(SWE-Bench Verified)逼近 Claude-3.5-Sonnet-1022。

-

數學: 在美國數學競賽(AIME 2024, MATH)和全國高中數學聯賽(CNMO 2024)上,DeepSeek-V3 大幅超過了所有開源閉源模型。

-

中文能力:DeepSeek-V3 與 Qwen2.5-72B 在教育類測評 C-Eval 和代詞消歧等評測集上表現相近,但在事實知識 C-SimpleQA 上更為領先。

這些打榜的行為已經是所有新模型的慣例操作,而因為這些官方數據是在模型悄悄在社區以及一些AI Infra平台上線後才跟著發佈,反而讓它「口碑先行」,在人們紛紛體驗了它的媲美頭部模型的能力後,這些數據讓開發者社區印象更為深刻。

但V3真正重要的意義不止在於開源再次逼近閉源,還在於它通過各種新的方法,不止在模型層卷,而是把整個模型的訓練和推理當做一個系統來優化到了極致,並給出了諸多新的技術思路。

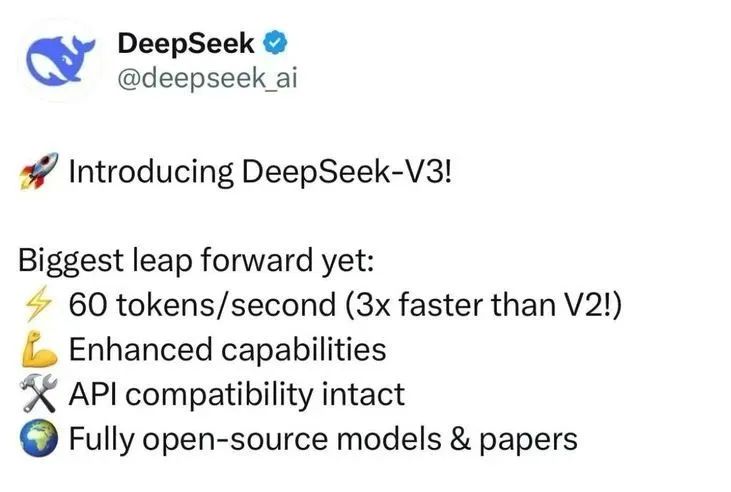

這一方面也體現在他的生成速度提升上,根據Deepseek官方,它的生成速度提升至 3 倍。

通過算法和工程上的創新,DeepSeek-V3 的生成吐字速度從 20 TPS 大幅提高至 60 TPS,相比 V2.5 模型實現了 3 倍的提升,為用戶帶來更加迅速流暢的使用體驗。

想體驗的可以登陸官網 chat.deepseek.com,它也支持 API 訪問。而且,新版本將提供 45 天優惠價格體驗期,直至 2025 年2 月8 日。

在技術報告和官方正式發佈前,全球開發者就已經對這個來自東方的「聖誕禮物」歡呼了一陣。

能夠做到「提前泄露」並引起一群自來水測試和把玩的國產模型並不多,無論它是否是Deepseek的某種策略,它確實證明了自己受關注和在開發者社區里的真實使用的程度。

根據Reddit上最早的「泄露」,它在基準測試LiveBench上評分都擠進了前列。整體性能超過了gemini 2 flash,以及Claude 3.5 Sonnet。

而隨後,技術報告正式發佈,開發者開始深挖它究竟做對了什麼。

讚譽一片,「想快進到英偉達泡沫破裂」

簡單來說,DeepSeek-V3針對分佈式推理做了創新的優化,進而顯著提升了分佈式MoE模型的負載分配效率,這不再只是從算法上,而是從整個系統上為未來更大規模的模型提供了新的可擴展性框架的可能。尤其在硬件資源有限的情況下,它最大化了效率。

在模型架構上,它和此前的V2一樣繼續使用Deepseek自己一直相信和沿用的MLA+細顆粒度的MoE。簡單說就是在注意力機制上做創新,對內存進行壓縮,對MoE的運行機制進行創新的設計。

此外,幾個亮點包括:

Deepseek V3使用了輔助損失自由負載均衡策略(Auxiliary-Loss-Free Load Balancing)。

在混合專家模型(MoE)中,每個輸入Token會分配給不同的「專家」進行計算。如果分配不均衡(某些專家負載過高),會導致效率降低和模型性能下降。傳統方法通過增加一個額外的「輔助損失」來強製均衡負載,但這會對模型性能造成負面影響。DeepSeek通過動態調整專家的偏置值,使輸入Token更均勻地分配給不同的專家,而無需引入額外損失。

這個方法有趣的地方是,通過監控每個專家的負載情況,在訓練中動態調整每個專家的偏置,使得分配更公平。它避免了引入額外的優化目標,直接在負載均衡和模型性能之間找到了更優解。

另外,在MoE方面的冗餘專家機制(Redundant Experts)也是這種追求平衡的思路。

在推理階段,某些專家可能會因任務量過多而成為瓶頸。冗餘專家機制通過為高負載專家創建「副本」,讓這些任務分配到不同的副本上,緩解了計算壓力並提升了整體推理速度。這種方法可以顯著提升分佈式推理的吞吐量,尤其是在高併發場景下,實現了資源的彈性擴展和更穩定的服務性能。

這些動作相當於是告訴那些調不好參數和平衡的人們:

我比你們更聰明。那些所謂的負載矛盾,我可以解決,並同時保持高水平的推理精度。

多Token預測目標(Multi-Token Prediction Objective, MTP)

傳統語言模型一次只預測一個Token,訓練信號較為稀疏,數據效率低。MTP讓模型在每個輸入Token的基礎上同時預測多個未來Token,這樣每次訓練能提供更多的反饋信號,加速模型的學習。也就是,不是簡單地並行預測多個Token,而是通過順序預測保持每個Token間的因果鏈條。這樣既提升了訓練效率,也讓模型在推理時能夠更好地「規劃」其輸出。

對FP8低精度訓練的優化。

FP8是一種極低精度的數據表示形式,比FP16和BF16的精度更低,但佔用的內存和計算資源也更少。問題是FP8的動態範圍有限,容易出現數值溢出或不足。DeepSeek通過分塊量化,將數據分成更小的組進行獨立縮放,這樣可以讓模型更靈活地適應輸入數據的變化範圍,避免低精度帶來的精度損失。

這種「分塊量化+高精度累加」的策略就是先將數據分組,每組單獨計算縮放因子,再通過高精度累加器進行累加計算。這種方法結合FP8的低資源消耗和高精度運算,解決了傳統低精度訓練中的不穩定性問題。它大幅減少了訓練所需的內存和計算成本,同時保持了與高精度訓練相當的穩定性和性能。

除了模型方面,在訓練設施上的創新也很關鍵,比如DualPipe流水線並行策略。

在分佈式訓練中,多個GPU需要同時處理大量數據,其中的通信開銷是一個瓶頸。傳統流水線方法很難做到完全的計算與通信重疊,造成資源浪費。DualPipe通過更精細的任務分解和調度,將計算和通信時間完全重疊,從而最大限度地利用了每一塊GPU的性能。這個設計的核心是將數據分成小塊,交替執行「計算」和「通信」任務。通過精確調整各任務的優先級和資源分配,讓GPU在計算時也能同時處理通信操作,幾乎完全消除了流水線中的「空閑時間」。除了提升效率,它值得玩味的地方更在於:

它顯著降低了對硬件資源的需求。

技術報告發佈後,Deepseek V3更是受到了猶如暢銷書發佈的待遇——大佬們紛紛為他撰寫推薦「腰封」,體驗了它的效果然後又讀了它的技術報告的,都在叫好:

Twitter上各個大佬紛紛點讚。

Meta的田淵棟也直接表示:

「DeepSeek這真是把H800 hack了底朝天[捂臉]太誇張了😂」

Andrej Kaparthy也再次讚揚Deepseek的技術報告值得一讀。

另外一個有意思的地方是,今天最重要的一些AI Infra創業公司的創始人們也對Deepseek V3充滿好感。一個在推理側再次推動著創新並由此可以刺激市場需求的模型,自然是推理側的創業公司們需要和希望客戶們看到的。

矽基流動的袁進輝在朋友圈點評:

「DeepSeek V3 訓練僅用了2000張H800,算力成本6百萬美元,給海外同行蠻大思想衝擊,很多業內專家都點讚了,算力不是唯一決定因素,聰明的人加創新更讓人敬佩。」

Lepton的創始人賈揚清則在朋友圈和X同時點評了V3給他帶來的思考。

• 首先,現在我們正式進入了分佈式推理的時代。一台單GPU機器(80*8=640G)的顯存已經裝不下參數了。新的大顯存機器確實能容納模型,但不管怎樣,為了性能和未來擴展,分佈式推理是不可避免的選擇。

• 即使在單個模型中,也需要關注 MoE 的負載均衡,因為每次推理只有大約5%的參數激活。目前還沒仔細研究這部分的工作負載細節,但應該會很有趣。

• 論文中特別提到引入「redundant expert」的概念,正是為瞭解決這個問題。這已經不是「一個模型多個副本」的問題,而是「每個模型子模塊都有多個副本」,然後獨立擴縮容。

• 輸入token的盈利模式已經很明確了。我個人推測,想讓輸出token變得盈利或至少收支平衡需要更多優化。不過如果我們相信「軟件摩亞定律」(每18個月單token成本減半),這就不是問題。

• Tile或block級別的量化是必需的。這也和我們在 Lepton 的觀察一致。我們還支持基於輸入數據的動態量化(ahead-of-time dynamic quantization)。另外等硬件支持FP4以後肯定還有不少可以玩的花樣。

• 冷知識:FP4乘法實際上就是個16*16的table lookup…

• 論文提到,在很多情況下,內存帶寬是瓶頸。很期待看看即將推出的NVIDIA新硬件形態(比如NVL72)能如何提升分佈式推理的性能和便捷性。

「Exciting years.」 他說。

在V3發佈之前,Deepseek曾經被海外知名的「爆料+深度分析」的技術博客又一次提到Deepseek,這個以芯片領域的一手信息著稱的博客已經是對Deepseek最關注的海外分析師,但它似乎依然沒想到Deepseek的重要性並不在於與OpenAI們用比拚資源的方式比拚創新,在這篇文章中,Semianalysis「爆料」稱Deepseek已經有很多很多的卡。但在V3 發佈後,它所指向的方向看來並不如此。

你依然需要萬卡集群,但不是誰的卡多誰燒的錢多誰就理所應當會贏得一切了。

有網民甚至戲稱:「想快進到Nvidia泡沫破裂的時刻」。

一切都在快速的展開。神話OpenAI們,尤其是以「卡」的名義神話然後看低中國開發者們自己的模型和Infra創新能力的階段看起來要結束了。當然,前提是你不是只想「跟著喊幾句」的創新,而是你真的做著能在全球都急需模型往前走的創新技術的時候,被大家能看到的真正的工作。