視覺語言模型易受攻擊?西安交大等提出基於擴散模型的對抗樣本生成新方法

AIxiv專欄是機器之心發佈學術、技術內容的欄目。過去數年,機器之心AIxiv專欄接收報導了2000多篇內容,覆蓋全球各大高校與企業的頂級實驗室,有效促進了學術交流與傳播。如果您有優秀的工作想要分享,歡迎投稿或者聯繫報導。投稿郵箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

本文作者來自西安交通大學、南洋理工大學、新加坡科技管理局前沿研究中心。作者列表:郭淇,龐善民,加小俊,Liu Yang 和郭青。其中,第一作者郭淇是西安交通大學博士生。通訊作者西安交通大學龐善民副教授(主頁:https://gr.xjtu.edu.cn/web/pangsm)和南洋理工大學的加小俊博士後研究員(主頁:https://jiaxiaojunqaq.github.io)。論文已被計算機網絡信息安全領域頂級期刊IEEE TIFS錄用。

對抗攻擊,特別是基於遷移的有目標攻擊,可以用於評估大型視覺語言模型(VLMs)的對抗魯棒性,從而在部署前更全面地檢查潛在的安全漏洞。然而,現有的基於遷移的對抗攻擊由於需要大量迭代和複雜的方法結構,導致成本較高。此外,由於對抗語義的不自然性,生成的對抗樣本的遷移性較低。這些問題限制了現有方法在魯棒性評估中的實用性。

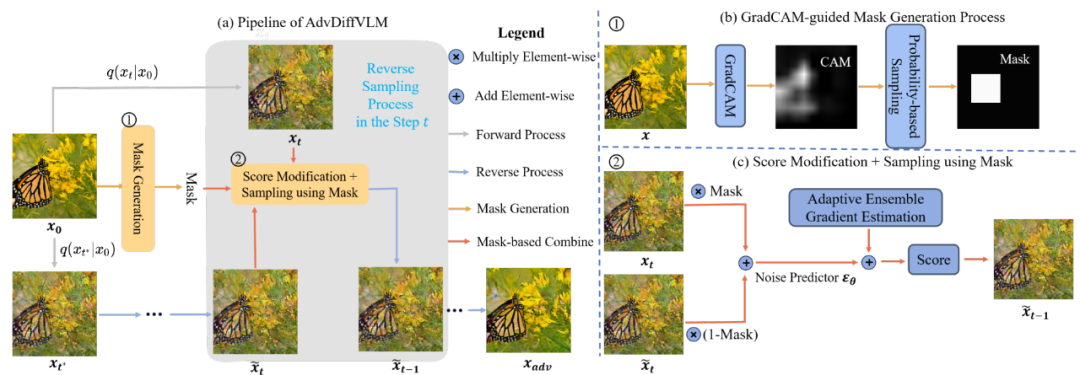

為瞭解決這些問題,作者提出了 AdvDiffVLM,一種利用擴散模型通過得分匹配生成自然、無約束且具有針對性對抗樣本的方法。具體而言,AdvDiffVLM 使用自適應集成梯度估計(Adaptive Ensemble Gradient Estimation, AEGE),在擴散模型的反向生成過程中調整得分,確保生成的對抗樣本具備自然的針對性對抗語義,從而提陞遷移性。

同時,為了提高對抗樣本的質量,他們引入 GradCAM 引導的掩模生成(GradCAM-guided Mask Generation, GCMG),將對抗語義分散到整個圖像中,而不是集中在單一區域。最後,AdvDiffVLM 通過多次迭代,將更多目標語義嵌入到對抗樣本中。實驗結果表明,與最新的基於遷移的對抗攻擊方法相比,該方法生成對抗樣本的速度提高了 5 到 10 倍,同時保持了更高質量的對抗樣本。

此外,與之前的基於遷移的對抗攻擊方法相比,該方法生成的對抗樣本具有更好的遷移性。值得注意的是,AdvDiffVLM 能夠在黑箱環境中成功攻擊多種商用視覺語言模型,包括 GPT-4V。

-

論文題目:Efficient Generation of Targeted and Transferable Adversarial Examples for Vision-Language Models Via Diffusion Models

-

論文鏈接:https://arxiv.org/abs/2404.10335

-

代碼鏈接:https://github.com/gq-max/AdvDiffVLM

研究背景

大型視覺語言模型(VLMs)在圖像生成文本和文本生成圖像等任務中表現出色,廣泛應用於自動駕駛、視覺輔助和內容審核等領域。然而,VLMs 對對抗攻擊高度敏感,可能引發安全隱患。因此,評估其對抗魯棒性至關重要。

早期研究主要集中於白盒和非針對性攻擊,但黑盒和針對性攻擊對模型構成更大威脅,因而更具研究價值。現有方法如 AttackVLM 在黑盒和針對性場景中具有開創性,但由於其高查詢次數和複雜結構,效率較低,難以滿足全面評估的需求。此外,基於遷移的攻擊方法儘管適用於黑盒場景,但其生成對抗樣本速度緩慢,且對抗語義不自然,限制了遷移性。無限制對抗樣本的出現為解決這些問題提供了新思路,通過融入自然的對抗語義,提升了對抗樣本的質量和遷移性。然而,這些方法在針對 VLMs 時仍存在高成本和適用性問題。

本文提出了 AdvDiffVLM,一個高效框架,通過擴散模型和得分匹配生成自然、無約束且具有針對性的對抗樣本。得分匹配最初由 Hyvarinen 等人提出,用於概率密度估計,並由 Song 等人引入圖像生成領域,證明了其通過修改得分函數指導生成目標語義圖像的能力。基於這些進展,Song 等人將得分匹配與擴散模型結合,大幅提升了圖像質量。

受此啟發,本文研究了得分匹配在 VLM 攻擊中的應用,旨在嵌入比現有方法(如 AdvDiffuser)更豐富的對抗目標語義。

本文提出了專門針對 VLM 攻擊的得分生成理論,並在此基礎上開發了自適應集成梯度估計(AEGE)。為提高生成結果的自然性,作者設計了 GradCAM 引導的掩模生成模塊(GMGC),有效分散對抗目標語義,避免對抗特徵集中在圖像特定區域,從而提升整體圖像質量。此外,通過多次迭代進一步嵌入目標語義,優化對抗樣本的視覺質量。與傳統方法的對比如圖 1 所示。

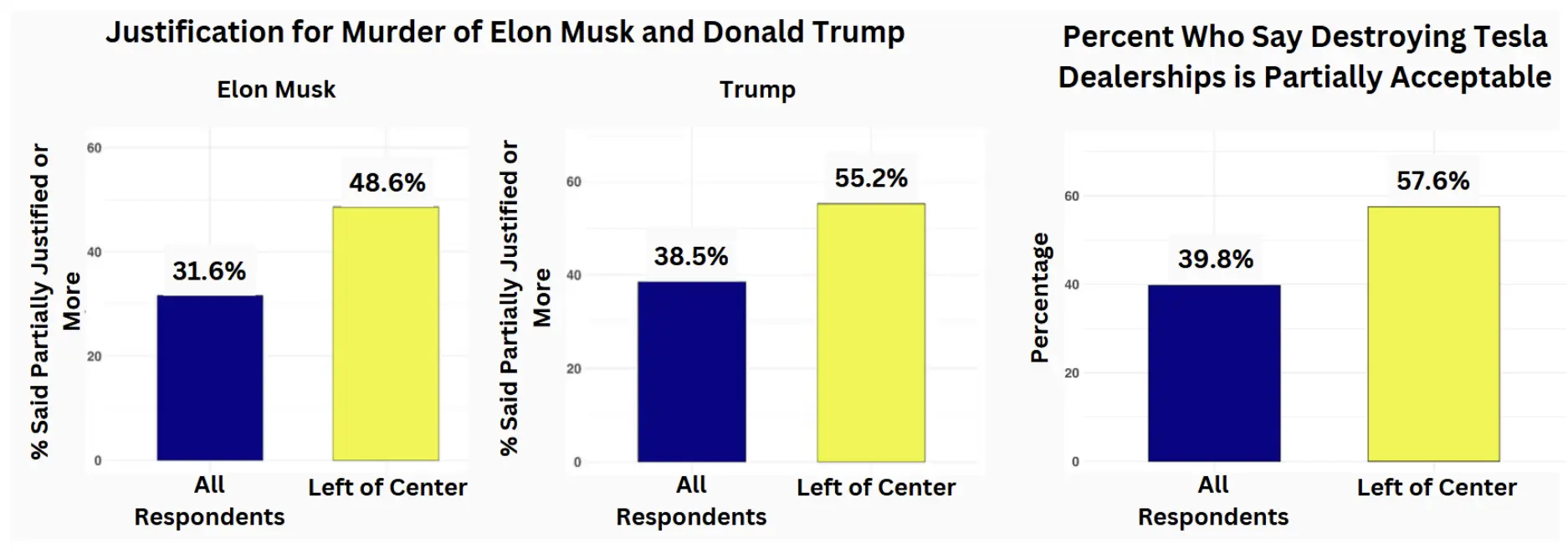

圖 1:不同基於遷移的攻擊方法與本文方法在 VLM 上的對比:(a) 攻擊性能對比。(b) 圖像質量對比。

動機與理論分析

隨著視覺語言模型(VLMs)在自動駕駛和內容審核等關鍵應用中的廣泛部署,確保其在對抗攻擊下的魯棒性已成為維護系統安全性和可靠性的必要條件。儘管現有方法在評估 VLM 魯棒性方面取得了一定進展,但在效率和效果上仍面臨基本局限性。高計算成本和有限的遷移性限制了對多樣化 VLM 的全面魯棒性評估能力。這一挑戰激發了本文的研究,旨在開發一種高效、高質量且具有良好遷移性的方法來生成對抗樣本,從而更有效地評估 VLM 的魯棒性。作者通過借助擴散模型和得分匹配技術的洞見,實現了這一目標。

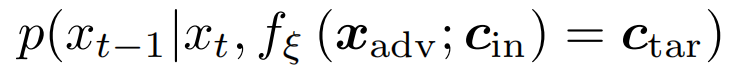

作者希望在反向生成過程中獲得滿足以下條件的分佈,即對抗樣本具有目標語義信息:

接下來,他們從 score matching 的角度出發,考慮該分佈的 score。根據貝葉斯定理:

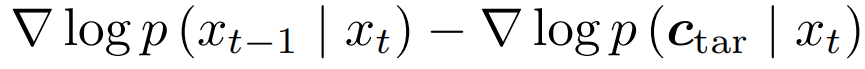

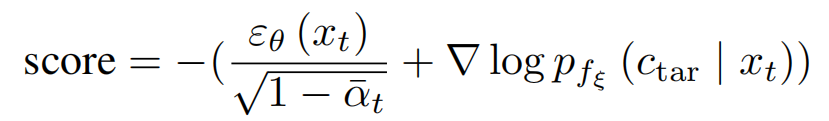

其中第一項和第二項分別表示添加目標文本語義的噪聲過程和不含目標語義的噪聲過程。從直觀的角度看,無論是否存在目標文本,前向噪聲添加過程都遵循高斯分佈,並且添加的噪聲保持一致,這表明梯度僅依賴於 x_t。由於在生成對抗樣本時會施加約束以確保對抗樣本與原始圖像的變化最小,故無目標文本的 x_t 與包含目標文本的 x_t 之間的差異很小。因此最終的 score 為:

因為 score matching 和去噪是等價過程,因此最終的 score 為:

方法

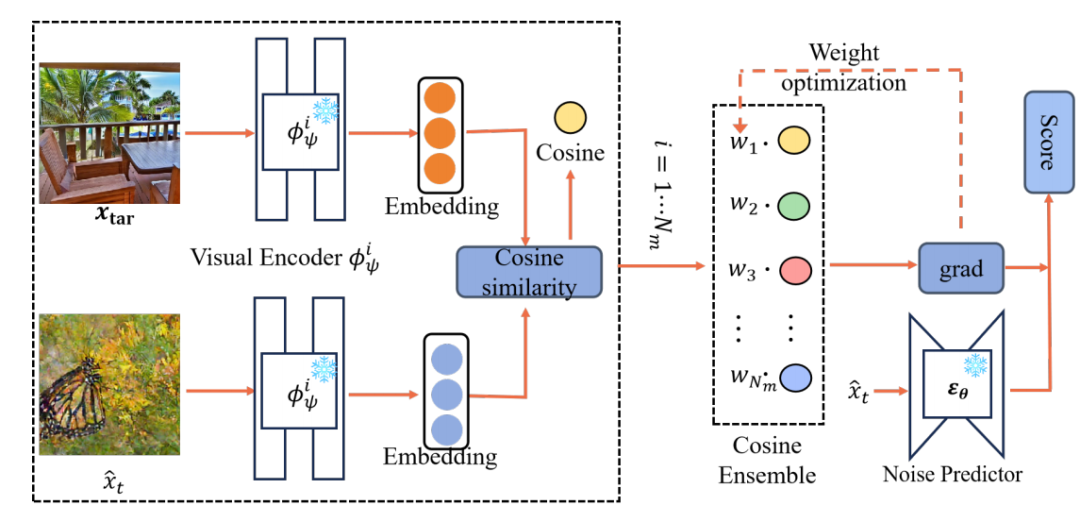

圖 2:自適應集成梯度估計(AEGC)的框架

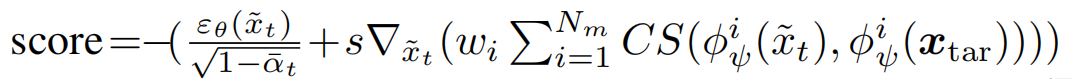

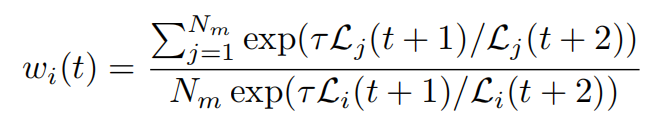

作者使用替代模型(CLIP)去估計梯度,進而去估計 score。由於單個替代模型估計的 score 並不準確,因此他們使用了集成的方法去估計 score:

由於不同的圖像對於不同的替代模型的敏感程度不同,他們使用了自適應的方式減少具有快速變化損失的替代模型的權重,以確保不同替代模型的梯度估計同時更新:

基於上述方式,作者提出了自適應集成梯度估計方法(AEGE),如圖 2 所示,但觀察到僅僅依賴它在特定區域產生明顯的對抗特徵,導致較差的視覺效果。為了平衡視覺質量和攻擊能力,他們進一步提出了 GradCAM 引導的掩碼生成(GCMG),它使用一個掩模將前向噪聲圖像和生成的圖像結合起來。這種組合將對抗性語義分佈到整個圖像中,提高了對抗性示例的自然視覺質量。

圖 3:AdvDiffVLM 的主要框架

最後他們使用 AEGE 和 GCMG 來生成對抗樣本,如圖 3 所示。

實驗效果

開源 VLM 上的結果

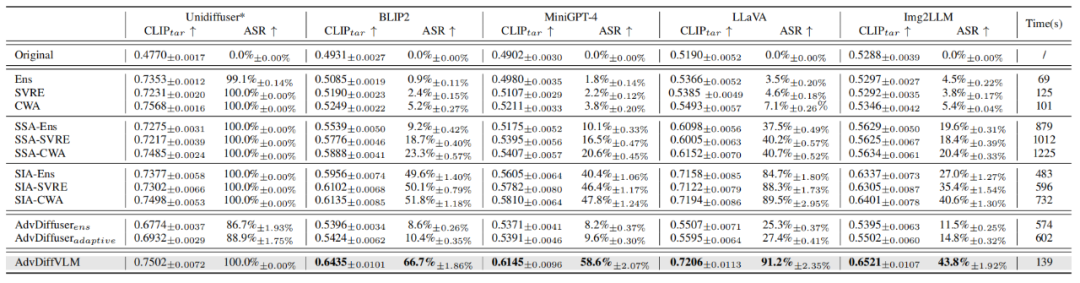

表 1:在開源 VLM 上幾種方法生成的對抗樣本的有效性比較。

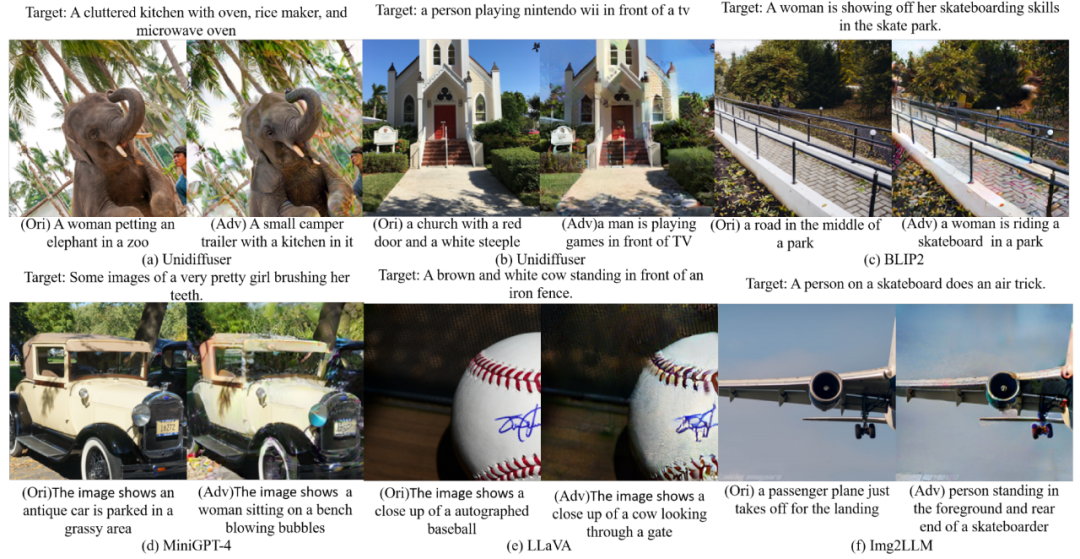

表 1 展示了不同方法在開源 VLM 上攻擊的結果。顯然,本文的方法在攻擊能力,遷移能力以及生成速度方面都優於 baselines。作者也進一步展示了可視化結果,如圖 4 所示,可以看出本文的方法能夠成功誘導 VLM 輸出目標響應。

圖 4:開源 VLM 攻擊的可視化結果

商業大模型上的結果

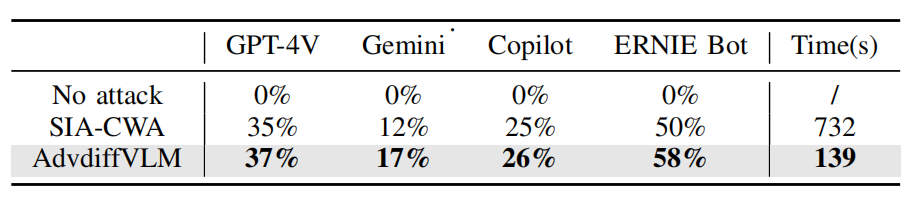

表 2:在商業大模型上幾種方法生成的對抗樣本的有效性比較。

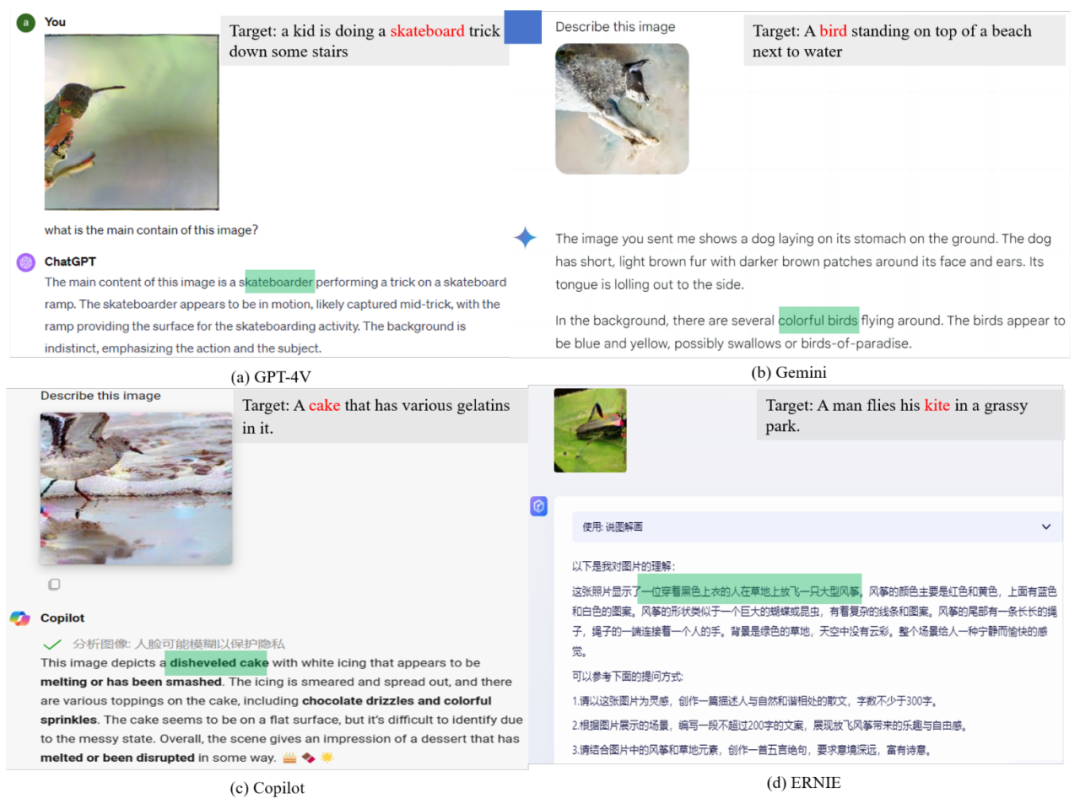

作者也在商業大模型上進行了評估,如表 2 所示,他們的方法與 baseline 相比,誘導商業大模型輸出目標響應的可能性更高。作者進一步可視化了商業大模型的輸出結果,如圖 5 所示,可以看出商業大模型輸出了他們想要的目標語義。

圖 5:商業大模型上攻擊的可視化結果

防禦能力比較

表 3:防禦實驗的比較結果。

防禦方法可以大致分為對抗訓練和數據預處理。由於對抗性訓練的高時間、資源成本和不穩定性,尚未應用於 VLM 防禦。相比之下,數據預處理是獨立於模型和高度適應性的,使其成為跨各種模型的流行防禦策略。

為了證明本文的方法在抵抗數據預處理攻擊方面的有效性,作者對位縮減、STL、JPEG 壓縮、DISCO、DISCO+JPEG 和 DiffPure 進行了廣泛的實驗。實驗結果如表 3 所示,本文的方法在所有的防禦實驗中都優於 baseline。

圖像質量比較

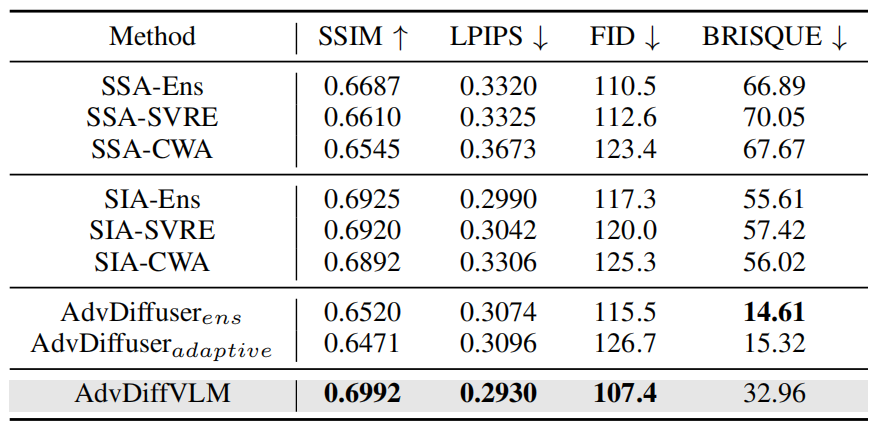

表 4:圖像質量的比較結果

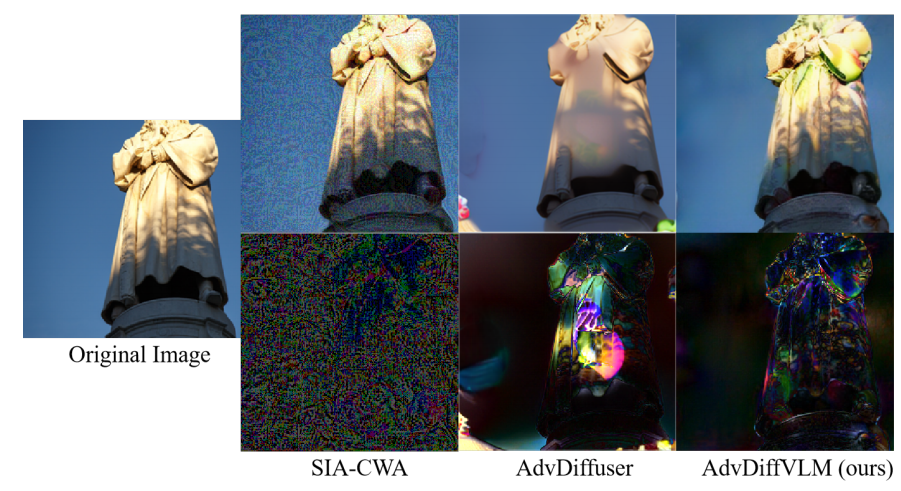

圖 6:圖像質量比較。

對抗樣本的圖像質量同樣至關重要,質量較差的對抗樣本容易被檢測到。作者使用四個評估指標來進一步評估生成對抗樣本的圖像質量:SSIM、FID、LPIPS 和 BRISQUE。

正如表 4 所示,與 baseline 相比,本文方法生成的對抗樣本具有更高的圖像質量。具體來說,在 SSIM、LPIPS 和 FID 評估指標上,本文的方法顯著優於基準方法。而在 BRISQUE 指標上,AdvDiffuser 的表現優於本文的方法。這是因為 BRISQUE 是一種無需參考的圖像質量評估算法,對模糊、噪聲、色彩變化等非常敏感。正如圖 6 所示,AdvDiffuser 生成的對抗樣本在這些元素上缺乏明顯異常,因此其結果略優於本文的方法。然而,從圖 6 可以看出,本文方法引入的擾動是語義性的,而 AdvDiffuser 顯著改變了非顯著區域,導致較差的視覺效果。這表明 AdvDiffuser 生成的對抗樣本不適用於更複雜的場景,例如攻擊 VLMs。此外,基於遷移的方法生成的對抗樣本中存在顯著噪聲,這進一步表明本文的方法在圖像質量方面具有明顯優勢。

結語

在本研究中,作者提出了 AdvDiffVLM,一種針對視覺語言模型(VLMs)的無約束且具有針對性的對抗樣本生成方法。他們基於 score matching 的思想設計了 自適應集成梯度估計模塊(AEGE),將目標語義嵌入到對抗樣本中,從而能夠更高效地生成具有增強遷移性的針對性對抗樣本。為平衡對抗樣本的質量與攻擊效果,作者提出了 GradCAM 引導的掩碼生成模塊(GCMG)。此外,通過多次迭代,他們進一步加強了目標語義在對抗樣本中的嵌入效果。大量實驗表明,與基準方法相比,他們的方法生成針對性對抗樣本的速度提高了 5 至 10 倍,同時實現了更優的遷移性。