大模型圈最新現狀:一半在用DeepSeek,另一半在玩「顏文字」?

作者|週一笑郵箱|zhouyixiao@pingwest.com

這兩天的大模型圈子,可謂是熱鬧非凡。一邊,DeepSeek憑藉其低成本、高性能的亮眼表現,吸引著無數目光,各路技術大牛紛紛點讚。

而另一邊,社交媒體和技術論壇上卻開始流行起各種奇特的「顏文字」,比如「QwQ」、「QVQ」,不明所以的人可能一臉懵,但懂行的人都知道,這指的正是阿裡通義千問開源的系列模型。

今年9月,阿里發佈通義千問新一代開源模型Qwen2.5系列,一口氣推出了從0.5B到72B參數的不同規模版本,覆蓋了各種應用需求,成功躋身全球頂尖開源模型行列,多模態、多語言能力樣樣不落,成了不少企業和開發者的心頭好。不僅如此,Qwen團隊最近也動作頻頻,接連開源了幾款頗具亮點的 AI 模型,持續引發關注。

Qwen團隊的命名風格也是相當「抽像」:QVQ,「兩眼瞪」;QwQ,像是鍵盤上不小心蹭了一下。這是什麼代碼世界的顏文字?似乎技術大牛們在嚴肅的科研之餘,偷偷藏了一點「皮」。也許,Qwen的命名哲學就是:名字隨意,能打才是硬道理?

提起生成式 AI,大家的目光似乎總離不開大洋彼岸的科技巨頭:OpenAI、Google、Meta。但最近,AI圈子裡卻頻頻閃現一些來自東方的身影,比如DeepSeek和阿里的通義千問Qwen,它們正在各大AI模型性能榜單上攻城略地,成為焦點。

要知道,過去我們聊到國產大模型,總感覺帶著點「追趕者」的陰影。但現在這樣的中國開源力量,正在用實力證明自己不再是看客,而是足以和OpenAI、Meta這些巨頭勁旅掰手腕的角色。

Hugging Face 2024 年年度盤點數據就很有意思:Qwen2.5-1.5B-Instruct 的下載量佔比高達 26.6%,碾壓了Llama 3 和 Gemma這些明星開源模型。下載量這東西,雖然不能完全等同於「最強實力」,但絕對是人氣的硬指標。

Qwen2.5-1.5B-Instruct的超高下載量,證明了其在當前時間節點上的廣泛應用和高人氣,也反映出中國公司開發的開源大模型正在國際舞台上展現出越來越強的影響力,實際上,Hugging Face平台上 2023年下載量最高的開源模型,同樣來自中國社區,是智源研究院BGE-base。

對於Qwen的亮眼表現,國外網民也是喜聞樂見,甚至已經開始玩梗了:朱克伯格可能正偷偷瞅著你用Qwen而不是 Llama。」

聖誕大禮包QvQ,首個開源多模態推理模型

網民們開始用上的包括Qwen團隊送上的聖誕禮物:QVQ-72B-Preview。這是一款能夠分析圖像並進行推理的全新開源模型。雖然還處於實驗階段,但初步測試表明,它在視覺推理任務中表現相當出色。

QVQ通過逐步思考來解決問題,類似於OpenAI的o1或Google的Flash Thinking等能夠「逐步思考」的模型。用戶扔給它一張圖和一些指令,系統會分析信息,在必要時花時間進行反思,並以每個預測的置信度分數提供答案。

在底層架構上,QVQ-72B-Preview 基於 Qwen 現有的視覺語言模型 Qwen2-VL-72B 構建,並增添了思考與推理的能力,這使它成為首個此類開源模型。

開發者在Macbook Pro上運行QVQ

在基準測試中,開源的QVQ全面超越了其前身Qwen2-VL-72B-Instruct,達到了與閉源模型如 OpenAI 的 o1 和 Claude 3.5 Sonnet 相近的準確水平。

QVQ-72B-Preview 的基準測試結果

在實際測試中,一位網民拍了一張紐約地鐵照片考驗QVQ,並提問「如果我要去唐人街,我該在這站下車嗎?」用戶最終表示模型做出了正確的判斷,結合問題進行了有效的推理。

獲陶哲軒點讚的開源推理模型QwQ

時間再往前推,2024年11月28日,Qwen團隊還開源了一款專注於推理能力的AI模型 QwQ-32B-Preview。

這是Qwen團隊發佈的首個開源推理模型,旨在增強AI推理能力。儘管參數量僅為32B,但在 GPQA、AIME、MATH-500 和 LiveCodeBench 等多個評測中,QwQ 都取得了不俗的成績,甚至在部分測試中超越了超越了o1。QwQ具備深度自省能力,能夠質疑自身假設並進行深思熟慮的自我對話,從而解決複雜問題。

雖然QwQ目前還處於實驗階段,但它展現出的強大分析能力和獨特的推理方式,已經吸引了不少目光,甚至連數學界的大牛陶哲軒都公開點讚,說它的表現超越了以往的所有開源模型。

在 AIMO(AI 數學奧林匹克)挑戰賽中,Qwen 系列模型也成為了參賽者們最常用的模型之一,位列前三。

AIMO使用最多的模型排名前三均為Qwen

「開放權重、價格低、基礎能力突出,這樣的推理模型誰不喜歡呢」。

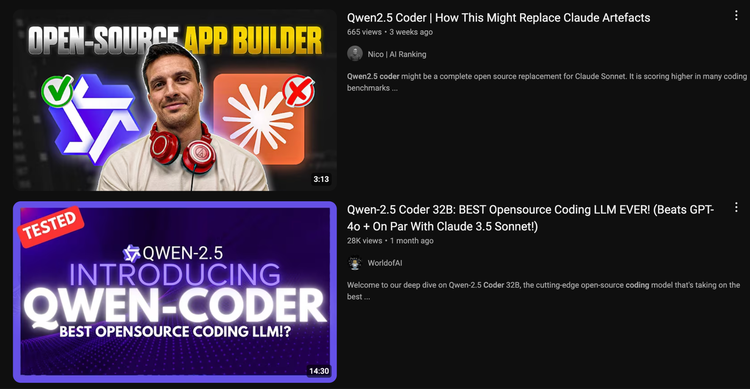

Qwen2.5-Coder:開源界的「代碼扛把子」?

Qwen2.5 系列的發佈,尤其是 Qwen2.5-Coder 的亮相,在AI圈內引發了一波討論。儘管模型體積相對較小,但Qwen 2.5 Coder32B在HumanEval 等編程基準測試中仍能與前沿模型相媲美。

有海外技術博主就「抽水」,現在大家好像都盯著 OpenAI、Google、Anthropic 這些巨頭的動態,卻忽略了Qwen這個「狠角色」。人家可是第一個能跟Claude Sonnet和GPT-4o正面硬剛,還能在你電腦上本地運行的開放權重模型。這可不僅僅是跑分好看而已,很多體驗過的人都說「真香」。相比之下,DeepSeek的模型雖然也很牛,但體積太大,本地跑起來有點費勁(彼時deepseek v3還未發佈)。Qwen2.5-Coder 的出現,對於開源社區來說絕對是個大新聞。更良心的是,阿里還把技術報告完完整整地公開了,沒有藏著掖著,與社區共享這份成果。

還有開發者基於Qwen2.5-Coder做了AI 的影片編輯器Video Composer,用戶可以通過拖放素材(如圖片、影片和音頻),並使用自然語言,讓Qwen2.5-Coder生成新影片(基於 FFMPEG 技術)。

滿足多樣化需求,全球化的Qwen

Qwen的另一大優勢在於它的「平易近人」。Qwen2.5 系列不僅面向技術專家或大型企業,它的設計初衷是讓廣大用戶都能輕鬆使用。從資源受限設備適用的 0.5 億參數版本,到企業級應用所需的 720 億參數版本,提供了豐富的選擇,滿足不同需求。

在日本,阿里雲與東京大學初創企業 Lightblue 合作,旨在提升其日語大型語言模型(LLMs)。Lightblue 借助阿里雲的架構及 Qwen LLM技術,對模型進行了優化,從而提高了東亞語言的準確性。

知名投資人Coinbase前CTOBalaji Srinivasan也公開認可了 Qwen 的多模態和多語言能力。

現在,全球各地的工程師幾乎都可以輕鬆訪問Qwen的各類模型。更難得的是,Qwen在處理多種語言方面表現出色,即使是一些全球AI訓練數據比較少的「小語種」,比如緬甸語、孟加拉語和烏爾都語,它也能應對。相比之下,Meta的開源AI模型Llama主要還是針對英語應用為主。

不少日本開發者在認真研究 Qwen2.5 的技術報告

中國AI開源勢力崛起

Qwen等中國AI模型的崛起,為國內企業提供了更多選擇和可能性。在當前國際環境,意義更加凸顯。更關鍵的是,它們不僅僅是一個「備胎」選項,而是正在證明自己有實力與美國頂尖技術掰手腕。

Qwen的意義,也不僅僅體現在技術上,其背後代表的開放、協作,這說明中國在AI領域並沒有掉隊,反而通過開源展現出了強勁的競爭力。事實證明,所謂的GPU限制並沒有阻礙中國 AI 的發展。如果這個形勢保持下去,中國很有可能在LLM市場佔據更重要的地位。當開源模型比 Meta(發佈帶有特殊 Llama 研究許可的模型)還要開放,當大家都能用上性能不輸甚至更強的開源模型時,誰會不樂於使用呢?

CNBC 近期也發文指出,中國在LLM方面取得了顯著進展,Qwen、DeepSeek等模型在某些方面已經超越了美國的競爭對手。中國公司正積極擁抱開源模式,推動AI技術的發展和應用,以促進創新並擴大全球影響力。文章認為,中國正在AI領域快速崛起,其AI模型已經具備相當的國際競爭力,並且正在努力構建自主可控的AI生態。

Hugging Face的 CEO Clem在其2025年AI預測中甚至提到,中國將開始引領人工智能競賽,這主要得益於其在開源人工智能競賽中的領先地位。

Sam Altman最近在「感歎」:複製相對容易,而做全新且有風險的事情極其困難。不過他也表示,成功的個體研究人員理應獲得讚譽,因為這「是世界上最酷的事」。評論區里,Vaibhav Srivastav回應到,公開的共享不應被忽視,並點名Qwen和DeepSeek團隊,他們同樣值得喝彩。

開放的心態,加上對工程實踐的重視,正在加速中國AI行業的發展。曾經被認為會因半導體限制和計算能力受限而受阻的中國AI產業,正以開源模型為代表向世界證明,它有能力與全球頂尖水平同台競技,並在全球範圍內創造更大的價值。