JHU 陳傑能:世界模型+心智模型,讓具身智能體擁有「想像力」

具身智能的高層感知,可以從認知科學突破。

作者丨賴文昕

編輯丨陳彩嫻

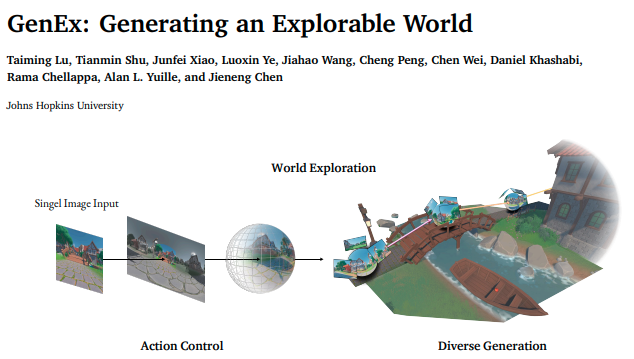

近日,馬爾獎得主、約翰霍普金斯大學教授 Alan Yuille 的團隊發佈了一項世界模型方向的重磅工作——GenEx,引起了具身智能領域的廣泛討論與關注。

作為李飛飛初創公司 World Labs 發佈的同期工作,生成模型 GenEx 的特別之處在於它能讓 AI 具有”想像力”,使智能體通過想像出來的觀測探索生成式世界。

受到心智模型的啟發,GenEx 希望在一定程度上試圖模擬人類大腦中對世界的認知方式和理解機制,以實現更智能、更靈活的人工智能系統。

具體而言,GenEx 系統有兩個相互關聯的組件:一個是想像世界,它能動態地生成可供探索的三維環境;另一個是具身智能體,它與這個環境相互作用,以完善自身的理解和決策能力——兩個組件構成了一個共生系統,使得人工智能能夠以類似於人類認知過程的方式進行模擬、探索和學習。

項目鏈接:https://www.genex.world/

項目鏈接:https://www.genex.world/GenEx 僅依據單張 RGB 圖像就能生成整個三維連貫的想像環境,還能通過 360 度的全景影片使其變得栩栩如生。

在 GenEx 生成式想像力的驅動下,智能體能執行複雜的具身任務,包括與目標無關的探索和目標驅動的導航。這些智能體利用對物理世界中未被觀測部分的預測性預期來完善自身認知,基於潛在決策模擬不同結果,並做出更明智的選擇。

而且,GenEx 還可以擴展到多智能體場景,當某個智能體導航到其他智能體的位置時,還能根據其他智能體想像的認知更新自己的認知。

這個工作的核心作者,是約翰霍普金斯大學即將畢業的中國博士生陳傑能。

在轉向世界模型、空間智能前,陳傑能的研究重點為醫學圖像,本科畢業於同濟大學計算機系,2020 年到約翰霍普金斯大學讀博,師從 Alan Yuile。

此前,他發表了首次將 Transformers 與 U-Net 融合的網絡模型 TransUNet,至今引用量已超 5000。

自今年起,陳傑能把研究重心轉向世界模型與空間智能領域。其研究內容主要包括基於單張圖像生成具備交互功能的 3D 世界,並且將這個生成的世界構建為具身智能體的心智模型(mental models),從而助力智能體做出更優決策。

從醫療圖像到具身智能,陳傑能認為自己已較好地完成了上一個使命,「接下來希望研究新的黃金問題,參與到前期探索中。」

以下是 AI 科技評論與陳傑能的對話。

1

當癌症遇上AI

AI 科技評論:您正式讀博前發佈的 TransUNet 至今引用量已超5000,當時是如何想到這個 idea 的?

陳傑能:當時我正在進行另一個項目,目標是對物體邊緣的語義進行建模,就有了序列建模的idea,即序列學習(Sequential Learning),Transformer 雖然全局學習比較好,但難以捕捉物體邊緣的局部細節。

在2020年底,Transformer 已經證明了在分類任務中表現較好,但對於它能否做密集預測,大家都還在探索中。為瞭解決這一問題,我就想結合 Transformer 和 UNet 的優勢,從實際效果來看,UNet 更擅長處理局部信息,Transformer 則擅長處理全局和預期信息,它們是一個實現局部細節還原並兼顧長距離建模的最佳組合,能夠很好地支持多種任務。

後來,我繼續把 TransUNet 擴展到 3D 層面,也進一步將其應用於多癌篩查。TransUNet在今天仍是一個經典的架構,廣泛應用於分割模型和擴散模型等任務中。

AI 科技評論:那您是如何接觸計算機視覺,並決定紮根醫學影像領域的?

陳傑能:2017 年下半年我在慕尼黑工業大學交換,3D 視覺學者 Daniel Cremers 是其中一位授課老師,巧的是他也是我現在的導師 Alan Yuille host過的博士後。當時的計算機視覺課程內容偏幾何和理論,我被前沿科研吸引,回來後便決定參與視覺的研究,便在同濟的陳廣老師課題組研究車輛檢測。

2019 年暑研,我機緣巧合聯繫到 Alan Yuille,他與約翰霍普金斯醫院合作癌症早篩項目,有抑癌因子 P53 發現者等知名醫生參與。他們雖不是 AI 研究者,但也意識到 AI 在醫療領域的潛力,這領域有規模化的機會,同時還能切實地幫助到每一個普通人,這便吸引我鑽研醫學影像領域。

AI 科技評論:所以您又加入達摩院醫療 AI 團隊實習了。可以分享一下做 CancerUniT 的故事嗎?

陳傑能:負責人呂樂是我在約翰霍普金斯計算機系的學長,他的導師Gregory D. Hager和我的導師本身就有合作,我們認識的比較早。

當時在醫療AI領域,大家都在做單一病種的研究,達摩院希望我能加入去做多癌篩查。具體而言,我們希望開發了一個 AI 模型,能通過單次CT篩查找出八種癌症並診斷14種亞型,這八種癌症是國內最高發病率高致死率的癌症,涵蓋了接近80%的患癌病人。

醫療AI領域涉及眾多方向,其中疾病篩查無疑是優先級最高的,尤其是針對癌症、阿爾茨海默症和慢性病等主要疾病。癌症因其發病率和死亡率雙高,我認為更值得在我精力有限的情況下優先攻關,也被我認定為一個黃金問題。

對我來說解決這個黃金問題就像是攀登一個更高的山峰,如果它能早一些解決,就能幫助到更多的人、使許多家庭受益,我很有熱情,希望能貢獻我的微薄之力加速這個進程。我推進工作的過程中,我和我的合作者一起明確了問題的定義,也搭建了一個高敏感性高達異性的基礎模型,現在,達摩院正在進一步擴展我當時開發的多癌模型,我期待這系列模型能儘早在社會中發揮實際作用。

2

從視覺基礎模型到空間智能

AI 科技評論:後面您來到字節 Seed 團隊做視覺基礎模型,為什麼會選擇這個機會呢?

陳傑能:我的 mentor Liang-Chieh Chen 在Google時就曾邀請我去實習,不過我當時去了達摩院,就答應下一年再加入,後面字節成立了核心團隊Seed,他加入並帶領基礎研究組,我也跟著來到字節。

2023年業內研究的一大重點是多模態大模型,Liang-Chieh Chen 在深度學習架構設計方面有著很高的造詣而且經驗豐富,特別是在MobileNetv2和DeepLab的貢獻。,我希望能對大模型的視覺編碼器進行一次徹底設計,探索新的可能性、進一步打磨自己的技術能力,就此加入了。

AI 科技評論:第一次主導視覺編碼器架構的設計,成功發表了 ViTamin,感受如何?

陳傑能:其實在做ViTamin 的過程中和完成後的感受都很深刻。

我負責基礎架構設計,需要對多模態大模型里的視覺編碼器架構規劃並探索 scaling law。而由於耗費算力較大,常常僅有一次訓練模型機會,所以設計時得既謹慎又創新。

我們的視覺編碼器在imageNet零樣本準確率達到了83%的SOTA,也能有效的遷移到大模型里,我們探索了一條合理的scaling law。將模型性能優化至世界最佳的過程,是充滿挑戰且極具成就感的。

如果將多模態模型比作一個智能體,那麼視覺編碼器就是智能體的眼睛。隨著今年年初公司研究者們認識到了大模型中視覺編碼器的重要性,並進行針對性的設計,我再次感受到此工作的重要性。

此外,ViTamin 最高分模型僅有436M,不足 0.5B,在追求大模型、大規模參數量的2023年算是非常小的。而在我們所能獲取的最佳數據條件下,這個規模已經達到了 scaling law 的極限。有趣的是,從今年開始,小模型也變得非常熱門,現在多模態模型為了終端優化,也只會採用幾百兆量級的視覺編碼器。不難看出,scaling law 最終會逐步收斂到一個最佳的設置。

AI 科技評論:為什麼今年會從醫學影像轉向空間智能?空間智能的核心是什麼?

陳傑能:我相信工業界和醫院的聯合下,癌症篩查這一關鍵問題將在未來幾年得以解決,而我以前的工作有助於其規模化推廣,算是完成了自己的使命。如今我想探索新領域,而空間智能、具身智能等定義尚新,能參與前期探索頗具意義。

導師Alan在1990年就有研究三維物體的表面曲率,近年實驗室也一直關注3D 視覺,我常受到熏陶而感興趣。我今年開始著手解決一兩個黃金問題,希望能一起推進空間智能與具身智能。

今年空間智能備受關注,它涉及圖片 3D 建模或影片 4D 建模,本質上是逆向圖形學單張圖重建三維結構並提取物體類別、位置和幾何等信息。

舉個例子,在虛擬遊戲引擎或物理引擎中,通常會通過預設的場景配置文件給定3D模型,並渲染為2D圖像,這是一個從場景到圖像的正向渲染過程;而計算機視覺則是這一過程的逆向推理,即從2D圖像中重建或推演出三維場景。如果能徹底解決這一挑戰,計算機視覺可能會有較大的突破,比如在 GPT 的空間推理,以及影片生成是否表現視覺場景的物理性,因此,從圖片中推演 3D 場景,是空間智能的一個核心。

我目前的工作聚焦了空間推演。不久前發佈的 Gemini 2 也特別強調了空間推演能力,然而,我們最近開發的空間推理基準3DSRBench的結果顯示,其準確率僅為 50%,遠低於人類的 95%。結果發佈後,DeepMind的相關人員也提供代碼庫,共同推動大模型在空間推理的進展。這表明在空間智能領域,尤其空間推理,機器與人類的能力還存在較大差距。

AI 科技評論:那空間智能與醫療圖像之間有何關聯與差異呢?

陳傑能:空間智能與醫療圖像皆涉圖像處理及複雜場景建模,醫療圖像的 三維理解與空間智能的 三維理解目標相近,都要將像素數據轉化為對三維結構和語義關係的預測,並提取關鍵的信息如物體位置和形態。在醫療影像中,這具體表現為對器官和病灶的位置、形態及其空間關係的精準解析。

二者也有不同:從數據上,醫療圖像是規則的三維數據,通常處於有限範圍內(例如人體高度有限、器官形態相對規則),數據複雜度較低;而空間智能的數據更加複雜,包含大量不規則、有形變和帶有關節活動的物體,數據的複雜度明顯更高。從優化目標上,空間智能和具身智能重實時性與泛化性,期望模型在不同環境泛化良好,達類似小孩智商與感知力;醫療人工智能則強調專家性,欲在專項達醫生專家水平,所以二者優化目標迥異。

3

心智模型之於具身智能

AI 科技評論:您是從什麼時候開始聚焦世界模型的?

陳傑能:我對世界模型的研究,是與空間智能和具身智能同期進行的。空間推理是具身智能體感知物理世界的起點,但僅依靠空間感知無法全面支持智能體對物理世界的交互理解。構建一個可預測、可交互的世界模型,將更好地幫助智能體在真實世界中進行有效決策。

雖然世界模型的定義本身仍百家爭鳴,但在二三十年前就已應用於控制論了。它的一個本質定義是:給定當前的狀態分佈和動作輸入,能否預測出未來下一個狀態的分佈。這在早年的控制論等領域中有一些實踐,但早年狀態的定義較為簡單。

我認為世界模型本質是提供對世界變化的預測性分佈,但世界變化不應是最初的低維狀態,而可以是一個四維世界的狀態,包括目標物體的語義信息、紋理信息、三維幾何結構、形態、形變、運動特性,以及物體之間的空間關係的建模。

我關注的一個難點是,能否從圖像觀測中提取上述的三維空間表徵,作為世界模型的狀態。此外,我也關注世界模型在具身智能的應用。

AI 科技評論:您不久前發佈了「生成式世界探索者」,從單張圖生成可交互 3D 世界,可以聊聊這個 idea 是怎麼誕生的嗎?

陳傑能:人類在現實生活中探索看不到的地方,能通過發揮想像力在大腦里構建出一個世界,然後在其中進行想像性的探索。這種能力使得我們人類無需物理移動就能探索到這個世界未知的地方,還能幫助更好地做出決策——讓AI智能體具備此能力,就是我的初衷。

從實踐的角度來看,當下看到的事物,無論是單張圖還是單個觀察,首先是要從單張圖中生成一個可交互的 3D 世界,下一步才能在這個 3D 世界中探索。

AI 科技評論:那具身智能的心智模型和世界模型又有何關聯呢?

陳傑能:心智模型最早在心理學和認知科學領域被提出,心智模型是指存在於我們腦中的一種認知框架,用於表示對世界的理解。它相當於一種內部的現實模擬,幫助人類解讀信息、做出決策,並根據以往的經驗和知識預測結果。當然世界模型也是根據過往的經驗和知識,去對未來的狀態分佈做出預測。因此這兩個模型的本質是相關聯的。

心智模型的表徵最早主要是關於語言語義學特徵,如今生成技術的發展使視覺表徵成為可能。我的工作實際上是將心智模型提升到了一個表徵上的新高度,即構造出具備空間想像力的心智模型,能想像三維世界中看不到的地方,比如只看到輪子能想像到一輛救護車,亦或者通過動作交互,探索到更遠的看不到的場景。

具身智能體基於此核心能力,無論走到哪裡,都能通過對周圍環境的觀察來構造出一個可探索的三維世界,即生成式的三維世界。在對生成的世界里,智能體通過探索發現未曾見過的觀測,並將這些想像出來的觀測加入到決策過程中——因此稱之為「生成式世界探索者」。

將生成世界的觀測融入決策的過程,可以看做通過世界模型開發的一種全新策略(policy)。應用於具身智能時,其實是用在生成式世界收集到觀測來補充物理世界中的缺失觀測,形成更完整的觀測集,從而構建一個想像力增強的policy。

AI 科技評論:心智模型屬於對常識的理解嗎,比如知道橫著拿紙杯水會灑出來?

陳傑能:心智模型作為一種認知框架,有基於常識的理解。然而,「知道橫著拿紙杯水會灑出來」,這仍基於對紙杯和紙杯里的水的完全觀測,心智模型可以解決更有挑戰性的部分觀測和缺失觀測的場景。心智模型是通過已有環境信息,去推演和想像那些未觀測到的環境部分,比如一陣大風是缺失觀測的,但人類的心智模型或許能推演出風吹後紙杯會倒下。

模擬這些未觀測到的環境因素,有助於做出更精確的決策,從而提高決策模型的泛化能力。這一方向在未來會獲得更多的關注。

AI 科技評論:這個方向在具身智能領域並不熱門。

陳傑能:是的,領域內很多研究者聚焦於提升低層次(low level)策略的魯棒性,而我目前的研究更側重於高層次(high level)問題,旨在為具身智能體構建可交互的三維世界模型,以輔助其決策過程。

在高層次領域,除了心智模型,具身智能體的物理世界的空間理解仍有挑戰,如果把上遊的空間理解處理好加上三維心智模型,低層次問題會解決得更輕鬆,能讓智能體走入真實世界而非僅限在機械臂的環境里。當然這兩者最終可以結合起來形成多層次模型。

最後,我們開發的生成式世界探索者,不僅是具身智能體的重要組成部分,也已經初步證明能夠輔助人類的認知決策。我希望在這個多學科交叉的領域貢獻點力量。