4o-mini 只有 8B、o1 也才 300B,微軟論文意外曝光 GPT 核心機密

微軟又把 OpenAI 的機密泄露了??在論文中明晃晃寫著:

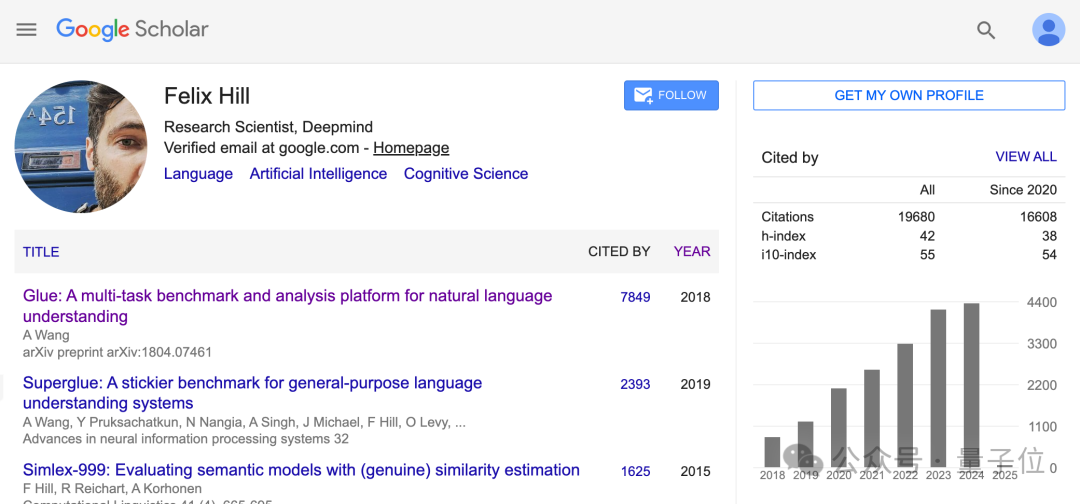

o1-preview 約 300B 參數,GPT-4o 約 200B,GPT-4o-mini 約 8B……

英偉達 2024 年初發佈 B200 時,就攤牌了 GPT-4 是 1.8T MoE 也就是 1800B,這裏微軟的數字更精確,為 1.76T。

除此之外,論文中給 OpenAI 的 mini 系列,Claude3.5 Sonnet 也都附上了參數,總結如下:

-

o1-preview 約 300B;o1-mini 約 100B

-

GPT-4o 約 200B;GPT-4o-mini 約 8B

-

Claude 3.5 Sonnet 2024-10-22 版本約 175B

-

微軟自己的 Phi-3-7B,這個不用約了就是 7B

雖然論文中後面也有免責聲明:

確切數據尚未公開,這裏大部分數字是估計的。

但還是有不少人覺得事情沒這麼簡單。

比如為什麼唯獨沒有放Google Gemini 模型的參數估計?或許他們對放出來的數字還是有信心的。

也有人認為,大多數模型都是在英偉達 GPU 上運行的,所以可以通過 token 生成速度來估計。

只有Google模型是在 TPU 上運行的,所以不好估計。

而且微軟也不是第一次幹這事了。

2023 年 10 月,微軟就在一篇論文里「意外」曝出 GPT-3.5-Turbo 模型的 20B 參數,在後續論文版本中又刪除了這一信息。

就說你是故意的還是不小心的?

微軟這篇論文說了什麼

實際上,原論文介紹了一項與醫學相關的 benchmark——MEDEC。

12 月 26 日就已經發佈,不過是比較垂直領域的論文,可能非相關方向的人都不會看,年後才被利雲虎克網民們發現。

研究起因是,據美國醫療機構調查顯示,有 1/5 的患者在閱讀臨床筆記時報告發現了錯誤,而 40% 的患者認為這些錯誤可能影響他們的治療。

而且另一方面,LLMs (大語言模型)被越來越多的用於醫學文檔任務(如生成診療方法)。

因此,MEDEC 此番有兩個任務。一是識別併發現臨床筆記中的錯誤;二是還能予以改正。

為了進行研究,MEDEC 數據集包含 3848 份臨床文本,其中包括來自三個美國醫院系統的 488 份臨床筆記,這些筆記之前未被任何 LLM 見過。

它涵蓋五種類型的錯誤(診斷、管理、治療、藥物治療和致病因子),這些錯誤類型是通過分析醫學委員會考試中最常見的問題類型選擇的,並由 8 位醫療人員參與錯誤標註。

而參數泄露即發生在實驗環節。

按照實驗設計,研究者將選取近期主流的大模型和小模型來參與筆記識別和糾錯。

而就在介紹最終選定的模型時,模型參數、發佈時間一下子都被公開了。

對了,省去中間過程,這項研究得出的結論是:Claude 3.5 Sonnet 在錯誤標誌檢測方面優於其他 LLM 方法,得分為 70.16,第二名是 o1-mini。

網民:按價格算合理

每一次,ChatGPT 相關模型架構和參數泄露,都會引起軒然大波,這次也不例外。

2023 年 10 月,微軟論文聲稱 GPT-3.5-Turbo 只有 20B 參數的時候,就有人感歎:難怪 OpenAI 對開源模型這麼緊張。

2024 年 3 月,英偉達確認 GPT-4 是 1.8T MoE,而 2000 張 B200 可以在 90 天內完成訓練的時候,大家覺得 MoE 已經且仍將是大模型架構趨勢。

這一次,基於微軟估計的數據,網民們主要有幾個關注點:

如果 Claude 3.5 Sonnet 真的比 GPT-4o 還小,那 Anthropic 團隊就擁有技術優勢。

以及不相信 GPT-4o-mini 只有 8B 這麼小。

不過此前也有人根據推理成本來算,4o-mini 的價格是 3.5-turbo 的 40%,如果 3.5-turbo 的 20B 數字準確,那麼 4o-mini 剛好是 8B 左右。

不過這裏的 8B 也是指 MoE 模型的激活參數。

總之,OpenAI 大概是不會公佈確切數字了。

此前阿爾特曼徵集 2024 年新年願望,最後公佈的清單中還有「開源」。2025 年的最新版本里,開源已經被去掉了。

論文地址:

https://arxiv.org/pdf/2412.19260

本文來自微信公眾號:量子位(ID:QbitAI),作者:夢晨、一水,原標題《4o-mini 只有 8B,o1 也才 300B!微軟論文意外曝光 GPT 核心機密》

廣告聲明:文內含有的對外跳轉鏈接(包括不限於超鏈接、二維碼、口令等形式),用於傳遞更多信息,節省甄選時間,結果僅供參考,IT之家所有文章均包含本聲明。