純視覺方案,精準操控電腦和手機!港大Aria-UI登頂,超越Claude 3.5

新智元報導

編輯:LRST

【新智元導讀】Aria-UI通過純視覺理解,實現了GUI指令的精準定位,無需依賴後台數據,簡化了部署流程;在AndroidWorld和OSWorld等權威基準測試中表現出色,分別獲得第一名和第三名,展示了強大的跨平台自動化能力。

在當今數字時代,智能助手已成為處理跨平台任務的不可或缺工具。

然而,如何將用戶的自然語言指令精準映射(grounding)到界面元素一直是該領域的核心挑戰。

傳統解決方案主要依賴調用無障礙API、解析HTML源碼或提取後台數據,這些方法普遍存在效率低下、信息不完整、兼容性差等顯著痛點,嚴重製約了自動化技術的廣泛應用。

港大聯合Rhymes AI推出的Aria-UI,通過開創性的「純視覺理解」方案徹底改變了這一現狀,無需任何後台數據支持,僅通過直接觀察用戶界面就能完成自然語言理解、界面元素定位、語義對齊和任務執行等全流程操作。這種新的設計不僅簡化了部署流程,更為跨平台自動化開闢了全新範式。

項目主頁:https://ariaui.github.io

Hugging Face在線demo:https://huggingface.co/spaces/Aria-UI/Aria-UI

GitHub倉庫:https://github.com/AriaUI/Aria-UI

論文鏈接:https://arxiv.org/abs/2412.1702

Aria-UI是一款專門面向GUI智能交互的創新型大規模多模態模型(LMM),顛覆性地實現了「看到即會操作」的自然交互範式 – 就像人類用戶一樣,AI只需「觀察」界面,即可理解並自主完成複雜的操作流程,從網頁瀏覽、文件處理到系統設置等任務都能輕鬆應對。

在評估AI自動化操作能力的權威基準測試中,Aria-UI配合GPT-4o展現出卓越表現:AndroidWorld榜單排名第一,OSWorld榜單排名第三!

這一成績不僅超越了業界領先的Claude 3.5 Sonnet computer-use接口,更展示了其在模擬人類操作電腦方面的強大能力。

Aria-UI採用創新的MoE (Mixture of Experts)架構,通過智能動態激活機制,將模型參數需求壓縮至僅3.9B,同時保持較好的性能。這一突破性的輕量級設計帶來多重優勢:

技術亮點:

-

極致壓縮:僅激活3.9B參數,大幅降低計算資源需求

-

高效推理:優化的MoE架構確保快速響應和穩定性能

-

廣泛適配:支持在資源受限場景下的靈活部署

-

開放生態:全面開源模型權重與訓練數據

-

部署便利:提供即用型vLLM推理腳本、支持主流huggingface transformers框架、完整的部署文檔與示例

這種開放共享的策略,配合便捷的部署方案,讓Aria-UI真正做到「開箱即用」。

Aria-UI的突破性創新

智能指令適配引擎:Aria-UI設計了數據生成pipeline,通過自動合成海量高質量訓練樣本,為模型注入強大的指令理解能力。這套智能指令適配引擎使模型獲得了卓越的泛化性能,能從容應對各類複雜任務場景,展現出非凡的環境適應能力,為實現真正的通用型AI助手奠定了堅實基礎。

動態上下文感知:為實現高精度的任務執行,Aria-UI創新性地融合了多模態上下文理解機制。通過整合文本記錄和圖文操作歷史,模型獲得了強大的場景理解能力,能準確把握動態變化的操作環境,將複雜指令精準轉化為具體行動。

全面性能測評:Aria-UI在嚴格的性能評測中展現出令人矚目的技術優勢,成功刷新了多個領域基準的記錄。在純視覺人機交互基準測試中,其表現遠超現有最佳視覺模型;在與需要調用AXTree等額外信息的傳統方案對比中,Aria-UI僅依靠視覺理解就取得了顯著的性能提升。實驗測評不僅驗證了純視覺方法的可行性,更展示了其在界面自動化領域(GUI Grounding)的應用潛力。

隨著圖形用戶界面(GUI)在各大平台的深度普及,它已然成為數字世界的核心交互方式。從日常生活場景到專業工作領域,GUI智能體正在重塑人機交互的方式,為任務自動化開闢新天地。如圖2所示,一個完整的GUI智能體運作可分為兩大核心階段:決策規劃(Planning)和視覺定位(Grounding)

在決策規劃階段,智能體通過分析當前界面狀態,製定執行任務的具體策略;而在視覺定位階段,則需要將規劃好的指令精準映射到實際界面元素上,確保操作的準確執行。

儘管大規模多模態模型(LMMs)在決策規劃方面取得顯著進展,特別是在鏈式推理(CoT)和模型擴展等技術的加持下,但如何實現語言指令到GUI元素的精準定位仍然面臨重大挑戰。這些挑戰主要體現在三個層面:

-

跨設備兼容性:不同設備間界面佈局存在巨大差異,要求模型具備強大的適應能力

-

指令多樣性:規劃指令在形式和內容上變化多端,考驗模型的理解能力

-

場景複雜性:任務執行過程充滿動態變化,對模型的實時響應能力提出更高要求

這些挑戰不僅推動著GUI智能體技術的持續創新,也為打造更智能、更實用的自動化解決方案指明了方向。

多樣化指令適配:從數據到模型的全方位提升

在開發Aria-UI的過程中,研究人員深入剖析了當前GUI Grounding領域的數據困境。傳統數據集普遍存在規模受限、封閉私有、平台單一等問題,尤其是缺乏對動態任務執行過程中關鍵上下文信息的採集。這些局限性嚴重製約了多模態大模型(LMM)在跨平台場景下的表現和通用性。

針對這些挑戰,Aria-UI開創性地提出了一套 數據驅動解決方案。通過構建高度自動化的數據生成pipeline,實現了對網頁、桌面和移動端三大核心平台的全面覆蓋。這套創新機制不僅顯著擴充了訓練數據的規模和多樣性,更為模型在複雜指令適配方面的能力提升開闢了新途徑。

多平台數據擴展:打造Web、PC與移動端全場景覆蓋

Aria-UI 設計的數據生成pipeline包含兩個關鍵階段:

第一階段:精確元素描述生成

採用頂尖多模態語言模型(如GPT-4o或Qwen2-VL-72B)進行元素描述生成。輸入數據包含:元素截圖、HTML文本信息、屏幕位置坐標。

為確保描述質量,研究人員優化了視覺輸入方式:

• 獨立截圖:捕捉目標元素局部畫面

• 放大視圖:用紅框標註目標元素在整體界面中的位置

這種方法能獲取元素特徵,包括視覺屬性、功能特性和位置關係等。例如,一個紅色的「訂閱」按鈕描述為:位於ChefMaria烹飪頻道頭部右上角的’訂閱’按鈕,鮮紅色背景,白色文字搭配鈴鐺圖標,下方顯示2.3M訂閱者

第二階段:多樣化指令生成

基於第一階段的精確描述,利用LLM生成自然、多樣的操作指令。以上述訂閱按鈕為例:「訂閱ChefMaria的頻道。」

為增強數據多樣性,每個元素均生成3種不同表達的指令。通過這套精心設計的pipeline,成功構建了覆蓋三大平台的海量高質量指令數據集,為模型訓練提供了堅實基礎。

網頁數據(Web)

網頁平台以其豐富的交互形式和動態特性,為構建GUI Grounding數據集提供了理想環境。基於最新的Common Crawl數據庫,設計了以下精細化處理流程:

• 網頁篩選:採用fastText技術進行內容質量評估,有效過濾低質量和不當網頁,重點保留交互元素豐富的高價值頁面;

• 元素提取:基於HTML屬性進行精準識別,提取按鈕、圖標等高交互性元素,優先採集複雜度高且貼近實際應用場景的界面內容;

• 跨設備數據採集:運用Playwright自動化工具,同步採集1920×1080(標準解像度)和2440×1600(高清解像度)兩種規格的界面數據,確保模型的廣泛適用性。

通過這套系統化的處理流程,成功從173K個網頁中提取了2M個高質量交互元素,並最終生成了 6M條標準化指令樣本。這些覆蓋多種解像度和界面複雜度的數據,不僅完整展現了現代網頁的特性,更為GUI任務提供了豐富而實用的訓練資源。

桌面數據(Desktop)

桌面環境數據的高質量採集一直是研究中的關鍵難點。現有數據集普遍存在規模受限、採集成本高等問題,如OmniACT數據集僅包含7.3K條人工標註樣本。

針對這一挑戰,研究人員創新開發了基於大語言模型(LLM)的自動化遍曆Agent,實現了桌面環境數據的高效採集:

• 智能遍曆策略: Agent通過實時解析操作系統的可訪問性樹(A11y),採用深度優先搜索算法,系統性地探索和選擇界面中的交互元素,確保採集的全面性;

• 狀態追蹤機制:集成輕量級記憶模塊,實時記錄已訪問元素的狀態信息,有效避免重覆採集,提升採集效率;

• 多模態數據捕獲:對每個交互元素進行多維度信息採集,包括高清截圖、精確坐標位置以及完整的A11y屬性描述,保證數據的完整性。

通過這套創新的採集系統,成功獲取了50K個高質量桌面交互元素,並借助數據處理流程最終生成了 150K條豐富多樣的指令樣本。這一成果顯著擴充了桌面環境GUI Grounding數據的規模,為相關研究提供了堅實的數據基礎。

移動數據(Mobile)

移動端是GUI自動化研究的重點領域,已積累了豐富的公開數據資源。儘管目前最大的AMEX數據集包含了104K張屏幕截圖和1.6M個交互元素,但其元素描述過於簡單,缺乏與實際任務相匹配的自然語言指令。針對這一問題,Aria-UI 對AMEX數據進行了系統性重構,通過高質量的描述和指令重生成,在保持原有規模的同時顯著提升了數據質量,為移動端任務提供了更有效的訓練基礎。

動態上下文感知機制

相比於靜態任務,動態任務的成功執行高度依賴於對上下文信息的準確理解。Aria-UI 創新性地引入了 文本-圖像混合的操作歷史記錄,顯著增強了模型的上下文感知能力。在處理多步驟任務時,模型不僅考慮當前元素的特徵,還綜合分析先前操作的完整記錄,從而生成更精準的操作指令。這種深度上下文感知機制使 Aria-UI 在複雜任務場景中展現出優異的準確性和穩定性。

跨平台統一解決方案

通過上述創新設計,Aria-UI 不僅有效克服了現有數據集的局限性,還在多樣化指令適配方面取得了突破性進展。無論是網頁、桌面應用還是移動端界面,Aria-UI 都表現出卓越的性能,為跨平台GUI自動化提供了一站式解決方案。這些進展為未來更廣泛的任務自動化應用奠定了堅實基礎。

模型框架:高效與精準的結合

Aria-UI 基於先進的MoE多模態大模型Aria構建,充分繼承和優化了其核心優勢,實現了效率與精確度的最佳平衡:

深度多模態理解:Aria的原生多模態架構專門設計用於處理複雜的跨模態信息,使GUI智能體能夠準確理解和響應多樣化的交互場景;

高效計算架構:得益於精巧的模型設計,Aria以僅3.9B的激活參數實現了超越7B規模密集模型的推理速度,確保了實際應用中的快速響應能力。

突破解像度限制, 精準適配複雜界面

面對顯示技術從1080p向2K及更高解像度演進的趨勢,高解像度圖像處理能力已成為GUI Grounding模型的核心需求。

研究人員對Aria的基礎架構進行了創新性改進:通過智能分塊策略,將原本980×980的處理能力提升至 3920×2940,實現了超高解像度支持。

為確保高解像度場景下的精確定位,採用了基於NaViT的優化方案,通過保持原始寬高比的智能填充技術,有效降低了圖像變形帶來的精度損失。這些技術創新使Aria-UI能夠在各種解像度環境下保持穩定的性能表現。

訓練與推理策略:構建動態環境適應能力

Aria-UI採用雙階段訓練方案,系統性地建立基礎能力並強化動態適應性:

基礎能力構建階段

在第一階段,研究人員專注於培養模型的核心GUI Grounding能力。模型接收標準格式的指令輸入(如「給定GUI圖像,定位以下描述對應元素的像素坐標」),通過大量單步指令-坐標對的訓練,學習準確輸出歸一化坐標值(0-1000範圍內)的基礎能力,為後續的動態任務處理奠定堅實基礎。

動態能力增強階段

第二階段著重增強模型的動態任務處理能力,引入了包含純文本歷史和文本-圖像混合歷史的上下文感知訓練。

為了維持模型的普適性並防止過度擬合,在訓練集中保留了20%的單步數據,確保模型在保持動態處理能力的同時不會丟失基礎定位準確度。

智能推理機制

在實際推理階段,Aria-UI將輸出統一的標準化坐標([0, 1000]範圍),並能夠將歷史操作記錄作為上下文輸入處理。這種設計使模型能夠像進行對話一樣處理連續的交互任務,將過往的元素定位與交互記錄納入決策考量,從而在複雜的動態環境中展現出優異的適應能力和穩定性。

憑藉這套創新的技術架構,Aria-UI在多個關鍵領域實現了突破:精準支持從1080p到4K的超高解像度界面、靈活適配多樣化佈局設計,同時在複雜動態環境中展現出較強的任務處理能力和環境適應性。

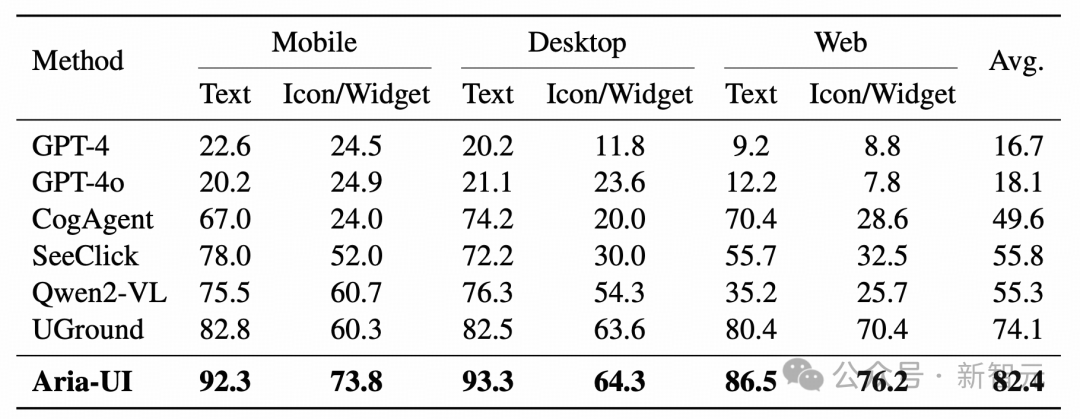

Agent任務表現

研究人員在ScreenSpot基準數據集上對Aria-UI的基礎GUI Grounding能力進行了系統評估。該測試集包含六個細分場景,覆蓋兩類界面元素和三大主流平台(移動端、網頁、桌面端)。

每個測試樣本由一張GUI截圖和對應的定位指令組成,其中移動端和網頁場景採用2K解像度,桌面端場景則使用540p解像度,全面驗證模型在不同應用環境下的定位準確性。

在綜合性能測試中,Aria-UI展現出卓越的定位能力,在全部測試子集上取得了82.4%的最優平均準確率。特別是在文本元素定位任務中,模型表現尤為突出,超越現有方案。這些結果充分證明了Aria-UI在跨平台場景和多元素類型中具備強大的適應性與泛化能力。

移動端離線Agent測試

研究人員對Aria-UI在移動端離線動態場景中的性能進行了深入評估,重點驗證其為代理任務軌跡提供精準定位坐標的能力。評估採用了三個專業測試集:AndroidControl-Low、GUI-Odyssey和AndroidControl-High。

其中,前兩個測試集包含了完整的逐步操作指令(人工標註或自動生成),而AndroidControl-High則僅提供任務目標,需要借助GPT-4o作為規劃器來分解和生成具體操作步驟。這種評估框架使我們能夠全面檢驗模型在任務精度和完成率兩個關鍵指標上的表現。

在實驗中,研究人員設計並評估了Aria-UI的兩個關鍵變體:

-

Aria-UI_TH(文本動作歷史):該變體在推理過程中集成了Agent的歷史動作文本描述,通過上下文信息增強來優化當前元素的定位準確性。這種設計在計算效率和性能表現間實現了理想平衡。

-

Aria-UI_IH(文本-圖像交替歷史):該變體在文本動作歷史的基礎上,額外引入了前序步驟的圖像信息作為輔助輸入。這種多模態融合策略為任務提供了更豐富的上下文感知,尤其適合需要精確視覺理解的複雜場景。

實驗結果顯示,兩個變體都在AndroidControl和GUI-Odyssey測試集上取得了突破性進展,顯著超越現有基準模型。歷史信息的引入(無論是純文本還是文本-圖像結合)都有效提升了元素定位精度和任務完成質量。其中,Aria-UI_TH憑藉其出色的性能與效率權衡,展現出特別優異的應用價值。

網頁端離線Agent測試

研究人員採用Multimodal-Mind2Web基準對Aria-UI在網頁代理任務中的性能進行了全面評估。該基準包含三個具有挑戰性的測試場景:跨任務、跨網站和跨領域,旨在系統驗證模型在零樣本環境下的泛化能力。

實驗結果令人矚目:Aria-UI系列模型在所有測試場景中均顯著領先於現有基準方案,整體平均準確率達到57.5%。

其中,融入歷史信息的變體表現更為出色,Aria-UI_TH和Aria-UI_IH的準確率進一步提升至58.9%。特別值得一提的是,Aria-UI_IH在跨網站和跨領域測試中展現出卓越表現,充分證明了其在處理複雜多模態上下文方面的優勢。

在線Agent評估

移動端與網頁端性能

採用AndroidWorld基準測試框架,在Android模擬器環境中對移動端代理進行了嚴格的在線評估。評估採用系統狀態檢測機制,通過監測虛擬設備的實時狀態來判定任務完成情況。

同時,還引入了AndroidWorld提供的MobileMiniWob++任務集,這是一個基於經典Web代理環境MiniWob++構建的專業測試集。

-

AndroidWorld測試:Aria-UI展現出突破性成果,其中Aria-UI_TH變體實現了44.8%的任務成功率,創造了新的性能基準。這一成績不僅超越了現有最優方案,還優於依賴AXTree輸入的非純視覺方法(如SoM和Choice)。這充分證明了Aria-UI作為純視覺GUI代理的卓越能力,展示了其在複雜真實場景中的穩定性和適應性。

-

MobileMiniWob++測試:在純視覺輸入條件下,Aria-UI的表現顯著優於其他視覺方法和基於選擇的方案。雖然在這個結構相對簡單的測試環境中,基於GPT-4-Turbo的SoM方法取得了最佳成績,但Aria-UI仍然在純視覺處理領域展現出領先優勢。

OSWorld評估:複雜操作系統環境測試

在最具挑戰性的操作系統模擬環境OSWorld中,研究人員對Aria-UI進行了深入評估。通過將Aria-UI作為核心定位模型,並與GPT-4o協同運作,我們完成了涵蓋369個實際應用場景的綜合測試。

實驗結果顯示,Aria-UI創造了15.15%的平均任務成功率,顯著領先於所有現有方案。特別值得關注的是,在多個高難度應用場景中,Aria-UI展現出卓越性能:

-

VLC播放器任務:30.06%

-

Chrome瀏覽器操作:23.80%

-

Impress演示製作:15.32%

這些證明了Aria-UI在處理複雜GUI交互時的優越能力。

綜合性能總結

通過一系列嚴格的在線評估,Aria-UI在多個關鍵場景中均展現出全面的技術優勢:

-

移動端環境:優異的定位精度

-

網頁端應用:出色的交互能力

-

操作系統環境:強大的任務完成能力

這些測試結果有力地證明了Aria-UI作為純視覺GUI代理的技術先進性,展示了其在複雜多變的實際應用環境中的卓越適應能力和操作精準度。

總結

Aria-UI通過一系列嚴格的在線測試,在移動端、網頁端及複雜的操作系統模擬環境中均展現出顯著的技術優勢,全面超越現有最先進解決方案。

這些測試成果不僅驗證了Aria-UI作為純視覺GUI代理的卓越性能,更凸顯了其超強的環境適應能力、精確的元素定位能力和可靠的任務完成能力。如此全方位的優異表現,有力地證實了Aria-UI在處理複雜人機交互任務時的技術成熟度和實用價值。

參考資料:

https://ariaui.github.io