AMD把o1煉成了實驗室助手,自動科研經費節省84%

一水 發自 凹非寺

量子位 | 公眾號 QbitAI

芯片強者AMD最新推出科研AI,o1-preview竟成天選打工人?!

注意看,只需將科研idea和相關筆記一股腦丟給AI,研究報告甚至是代碼就能立馬出爐了。

這個AI系統代號「Agent Laboratory」,全程由LLM(大語言模型)驅動完成文獻綜述、實驗,以及報告,一站式搞掂科學研究。

對了,在GPT-4o、o1-mini以及o1-preview這幾位科研助理當中,作者們發現o1-preview產出的研究成果最佳。

而且整體上,與現有方法相比,由AI生成的代碼能夠實現SOTA性能。

同時,如果人類在每個過程給予反饋,研究的整體質量也會大大提高。

總體而言,與之前的自主研究方法相比,Agent Laboratory將研究費用減少了84%。

Okk,這也再次印證了人們的預想,人類與AI協同將帶來更具性價比的方式加速科研。

最後,我們也扒了扒論文作者們,結果意外發現7/9為華人面孔——

從文獻到報告,AMD科研AI一站式搞掂

先來看Agent Laboratory是如何工作的。

如圖所示,主要有三個階段:文獻綜述→實驗→撰寫報告,每一階段都有不同的任務、工具和AI Agent角色(比如PhD、博士後Postdocto等)。

PhD Student負責文獻綜述

展開來說,在文獻綜述階段,PhD Student這一角色負責主要執行。它利用arXiv API來檢索相關論文,並進行三個動作:

-

一抓摘要:檢索出與初始查詢最相關的前20篇論文的摘要;

-

二抓單篇全文:對於某些具有重要參考價值的論文,提取其完整內容;

-

三添加論文:將經過篩選的論文摘要或全文納入到文獻綜述中;

需要注意的是,最後一個過程並非一次性完成,而是一個迭代的過程。

換句話說,只有當通過add paper(添加論文)命令達到指定數量(N = max)的相關文本時,文獻綜述才會最終確定。

接下來進入實驗環節。

如圖所示,主要有四個過程:計劃製定→數據準備→運行實驗→結果解釋。

PhD Student+Postdoc通過對話製定實驗計劃

簡單說,根據綜述結果和既定研究目標,PhD Student+Postdoc會通過對話來製定詳細、可執行的實驗計劃。

計劃一般包括具體實驗步驟、選用何種機器學習模型、篩選合適的數據集以及規劃實驗的高級流程框架等關鍵要素。

在達成一致意見後,Postdoc這一角色會使用plan命令提交計劃,此計劃將作為後續所有實驗相關子任務的重要行動指南。

ML Engineer用Python準備數據

然後ML Engineer會在下一階段用Python來處理和準備實驗所需的數據。

過程中,這一角色可以利用search HF命令在HuggingFace數據集中進行搜索,以獲取合適的數據資源。

寫完代碼後,ML Engineer會先將代碼通過Python編譯器進行檢查,確保沒有編譯錯誤。若存在問題,則會進行迭代修改,直至代碼能夠順利運行且無錯誤,最終使用submit code命令提交經過驗證的數據準備代碼,為後續實驗提供可靠的數據基礎。

ML Engineer借助專用模塊運行實驗

搓搓手,下面正式進入實驗運行環節。

概括而言,ML Engineer會借助mle-solver這一專門設計的模塊,來實施和執行先前製定的實驗計劃。

mle-solver的工作流程如下:

-

命令執行

圖(A)部分,從一組預先維護的高性能程序中采樣出一個初始程序,在後續的迭代過程中,通過EDIT和REPLACE兩種操作對程序進行不斷優化。

EDIT允許在指定的代碼行範圍內,用新生成的代碼替換原有代碼,從而實現對程序功能的局部調整;REPLACE則更為激進,它會生成一個全新的Python文件,用於在需要對程序結構或整體邏輯進行重大改變時使用。

-

代碼執行

圖(B)部分,執行代碼命令後,新程序會立即通過編譯器進行檢查,以識別和處理可能出現的運行時錯誤。

若程序成功編譯,將根據預先設定的評估標準對其進行評分,並與現有的程序進行比較。若新程序得分更高,則會更新最優程序列表。

若代碼未能通過編譯,ML Engineer會嘗試進行最多Nrep(在實驗中設定為3次)的修復操作,若仍無法解決問題,則會放棄當前程序,重新選擇或生成新的代碼進行替換。

-

程序評分

圖(C)部分,採用LLM獎勵模型對成功編譯的代碼進行評分。

該模型會綜合考慮研究計劃的目標、生成的代碼邏輯以及實際的實驗輸出結果等多方面因素,在0到1的範圍內對程序進行量化評估。得分越高,表示程序與初始研究目標的契合度越高,能夠更有效地實現預期功能。

-

自我反思

圖(D)部分,無論代碼執行結果是成功還是失敗,mle-solver都會基於實驗結果或遇到的錯誤信號進行自我反思。

如果程序編譯失敗,它會思考如何在後續的迭代中避免或解決類似的問題;若程序成功編譯並獲得評分,它會分析如何進一步提高程序的性能和得分,通過這種不斷學習和改進的機制,確保系統能夠持續提升生成代碼的質量和穩定性。

-

性能穩定化

圖(E)部分,為防止性能波動,mle-solver採用了兩種關鍵機制。

一是頂級程序采樣,通過維護一個高質量程序的集合,在執行命令前隨機從中采樣一個程序,這樣既保證了程序的多樣性,又能確保所選用的程序具有較高的質量基準;

二是批量並行化,在每個求解步驟中,同時進行多個代碼修改操作,並選擇其中性能最佳的修改結果來替換當前最優程序集合中得分最低的程序。

PhD Student+Postdoc共同討論分析實驗結果

執行結束後,PhD Student+Postdoc會深入探討mle-solver生成的實驗結果,結合自身的專業知識和前期的研究背景,對結果進行全面解讀。

一旦雙方認為結果合理且具備學術價值,Postdoc就會使用interpretation命令提交該解釋,為後續的報告撰寫階段提供關鍵的內容基礎。

PhD Student+Professor撰寫完整報告

進入最後的報告撰寫環節,PhD Student和Professor會通過一個名為 「論文求解器」(paper-solver)的專門模塊完成任務。

需要提醒,paper – solver並非用來完全取代學術論文撰寫流程,而是以一種人類可讀的格式總結已完成的研究,以便使用 「Agent Laboratory」 的研究人員瞭解已取得的成果。

通常來說,其工作流程包括以下步驟:

-

初始報告框架生成:生成符合學術標準結構且含佔位符、滿足LaTeX編譯和學術慣例的報告初始框架;

-

arXiv研究:可按文獻綜述接口訪問arXiv拓展文獻資料完善報告(非強製但很有幫助);

-

編輯報告:用EDIT命令按照多因素對論文LaTeX代碼行精確迭代編輯並編譯驗證,提升報告質量;

-

論文評審:用LLM Agent模擬NeurIPS流程多維度評估論文,測試準確性接近人類評審員;

-

完善論文:由三個評審Agent生成意見,PhD Student依此判斷是否修訂,必要時回溯前期環節修改至達標。

o1-preview科研能力最強

通過以上三個主要階段,Agent Laboratory就完成了整個科研流程。

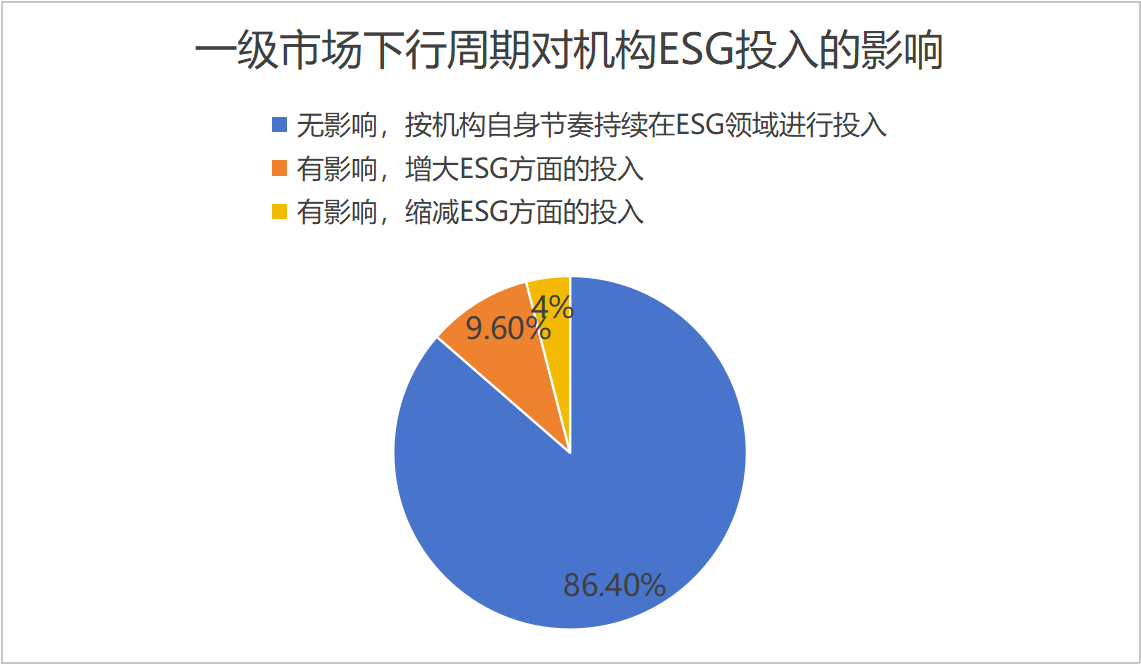

接下來,研究人員用GPT-4o、o1-mini以及o1-preview來評估實驗質量、報告質量和有用性,這3個AI在沒有人類任何參與的情況下完成了15篇論文。

然後普通人(人工審稿人)被要求根據以下五個問題對它們進行1—5評分,結果如圖所示。

綜合來看o1-preview對研究最有幫助, o1-mini的實驗質量得分最高, 而GPT-4o全面墊底。

1、語言模型是否表現出認知偏差,比如確認偏差或錨定偏差?

2、圖像Transformer相較於卷積網絡,對像素噪聲的敏感度是更高還是更低?

3、當被要求進行鑒別診斷時,語言模型在醫學問答(MedQA)上的準確性會提高嗎?

4、在多項選擇題基準測試中,語言模型對詞序敏感嗎?

5、性別角色是否會影響語言模型回答數學問題的準確性?

然後作者們還探討了人工審稿與自動審稿的區別有多大。

二者差異顯著,且自動審稿傾向於高估論文分數。

具體來說,與平均水平的NeurIPS論文得分相比,自動審稿平均為6.1/10,人工審稿為3.8/10。

而在GitHub,作者們也透露了讓研究效果更好的技巧。

-

撰寫詳細的筆記;

-

使用更強大的模型;

另外,如果用戶丟失進度、斷開互聯網或子任務失敗,可以使用「檢查點恢復工作進度」功能。

甚至也支持切換到中文模式。

背後團隊過半數是華人

最後介紹一下Agent Laboratory背後的作者們,他們幾乎全是在去年加入AMD。

Samuel Schmidgall,目前是霍普金斯大學電氣與計算機工程博士,也是DeepMind學生研究員。

從去年10月開始,他在AMD進行語言Agent方面的實習。

更早之前還在美國海軍研究實驗室探索機器人強化學習,以及在史丹福大學研究心血管外科方面的語言&視覺大模型。

Yusheng Su,去年8月加入AMD GenAI團隊的研究科學家,專注於模型數據、模型架構和訓練效率優化。

他2019年畢業於政治大學(base台北),後獲得清華大學CS博士學位(期間研究大模型預訓練)。

更早之前,他還在微軟雲計算部門有過一段實習經歷。

Ze Wang,去年5月加入AMD GenAI團隊的應用研究科學家。

他2017年本科畢業於北航電氣與電子工程專業,後分別於美國杜克大學和普渡大學讀了電子與計算機工程PhD。

更早之前,還在Facebook AI和微軟實習過。

Ximeng Sun,去年6月加入AMD的應用科學家。

她2018年畢業於密歇根大學拉克哈姆研究生院的計算機專業,後於波士頓大學取得CS博士學位。

加入AMD之前,她前後在IBM、Google和Meta進行了實習。

Jialian Wu (吳嘉濂),去年4月加入AMD GenAI團隊的研究科學家。

他在2019年本碩畢業於天津大學電子工程專業,後於紐約州立大學水牛城分校讀完CS博士。

加入AMD之前,他只在高通有過一段全職經歷。更早之前則在亞馬遜和微軟實習過。

Xiaodong Yu(於曉棟),去年8月加入AMD GenAI團隊的研究科學家,專注於知識檢索/忠實度、長文本理解、數學推理以及LLM/VLM訓練等。

他2015年畢業於上海交大電子與電氣工程專業,後赴美國伊利諾伊大學香檳分校和賓大攻讀碩博。

讀書期間,他也在亞馬遜、微軟等機構實習過。

Jiang Liu,去年4月加入AMD GenAI團隊的研究員,方向為開發通用AI模型。

他2019年本科畢業於清華大學自動化專業,同時也在五道口金融學院學習,後於約翰斯·霍普金斯大學讀完電子與計算機專業博士。

加入AMD之前,他在AWS和微軟進行了大語言模型方面的實習。

Zicheng Liu,去年年初入職AMD擔任高級工程總監,研究興趣為視覺語言學習、3D人體和手部重建、動態卷積和人類活動識別。

在這之前,他在微軟工作了27年,主要負責管理計算機視覺科學組。

他還是多個國際會議的技術委員會成員,而且是《視覺傳達與圖像表示》雜誌主編等。

Emad Barsoum,負責AMD生成式AI方面的副總裁,加入AMD 1年多。

曾在微軟擔任團隊工程經理/架構師,共同參與創建了ONNX標準。這是一個開放神經網絡格式交換計劃,在2017年由微軟和Facebook共同發起,它使得數據科學家和開發者可以將不同的深度神經網絡框架開發的模型,直接部署到上億的Windows設備中。

加入AMD之前,他也在芯片製造公司Cerebras負責領導AI團隊,主要是訓練大語言模型和視覺模型。

論文:

https://arxiv.org/pdf/2501.04227

代碼:

https://github.com/SamuelSchmidgall/AgentLaboratory